В настоящий момент на рынке существует огромное количество решений по виртуальным серверам, от совсем копеечных (в районе 70 рублей в месяц) до безумно дорогих.

Даже мы в

ИксФайвИкс почему-то соответствуем этой тенденции и предлагаем как копеечные решения (правда они стоят ~100 рублей в месяц), так и решения более дорогие и более профессиональные.

Сегодня давайте разберёмся с вопросом — почему же не стоит экономить на VPS и когда экономить можно?

Что представляют собой дешёвые VPS?

В большинстве своём, дешёвые VPS представляют собой решения трёх видов:

- Слабое либо устаревшее оборудование

- У провайдера мало клиентов и он пытается получить хоть каких-то

- Очень ограниченный набор возможностей в решении

Есть конечно же и ещё один вид — когда у провайдера много лишних денег и он может позволить себе ставить низкие цены, чтобы предложить новую услугу и набрать клиентов. Но это уже отдельная история.

Много старого оборудования, которое нужно куда-то пристроить...

Рассмотрим первый вид, это слабое или же устаревшее оборудование.

В этом случае, как правило, провайдер использует уже отжившее своё или же просто слабое оборудование. Такое оборудование не подойдёт для предоставления быстрых, мощных VPS, но подойдёт для предоставления слабых, дешёвых VPS. По такому пути пошли и мы, когда предложили рынку наш тариф VPS-MICRO. Мы, кстати, были одними из первых, кто такое решение предложил.

Здесь вопросов как бы быть и не должно. Все прекрасно в глубине души понимают, что супер дешёвое не может быть на мощном, крутом оборудовании.

Поэтому просто не ждите чего-то особенного от такого решения, размещайте не особо важные ресурсы и сайты, ну и всегда делайте резервные копии.

Провайдер хочет быстрых денег...

Второй вид — у провайдера мало клиентов и ему нужны хоть какие-то заказы.

Это нормальная практика для новых провайдеров, а также на старте предложения новой для провайдера услуги. Это ещё называют демпингом.

Суть в следующем: провайдеру нужно быстро набрать клиентов, быстро заполнить оборудование, поэтому он намеренно ставит на какое-то время низкую цену, чтобы клиенты «клюнули» и воспользовались этой услугой.

Причём это будет далеко не обязательно услуга плохого качества. Качество может быть хорошим, но стоит учитывать два момента. Первый момент состоит в том, что если провайдер выбрал такую тактику, значит у него не так уж много свободных средств (способных покрыть временный убыток пока оборудование заполняется). Второй момент состоит в том, что провайдер скорее всего повысит цену сразу после заполнения оборудования. Ведь кушать хочет даже сервер, а заполнив оборудование дешёвыми клиентами денег в итоге может и не хватить.

Поэтому вывод здесь простой: перед покупкой такого VPS дважды подумайте, проанализируйте кто и что Вам предлагает, ну и будьте готовы к тому, что экономия эта лишь временная.

VPS вроде и хороший, но возможностей почти нет...

Третья группа — очень ограниченный набор возможностей.

Многие провайдеры, предлагающие дешёвые VPS, имеют и деньги и клиентов. Зачем же тогда они предлагают дешёвые VPS? А предлагают они их затем, чтобы в итоге заработать больше.

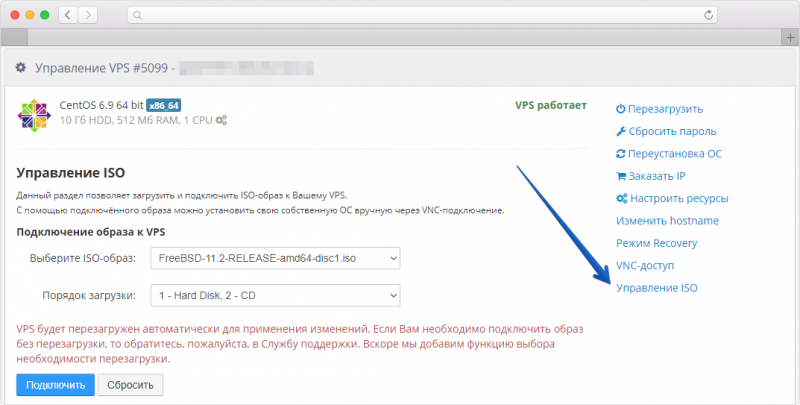

Как это работает: предлагается очень дешёвый VPS, но с большим количеством ограничений (нельзя добавить ресурсы, нельзя докупить IP-адрес, нельзя установить VPN, нельзя установить многие ОС и т.п.).

Вы покупаете такой VPS, обживаетесь на нём, Вас всё устраивает. И тут вдруг Вам становится мало ресурсов. Вы хотите докупить ту же RAM и узнаёте, что этого сделать нельзя. Вам предлагают перейти на другой тариф, который по деньгам выходит значительно более дорогим.

Что остаётся? Приходится брать, так как провайдер нравится, качество устраивает, тратить время, силы, нервы на переезд не хочется.

Делаем вывод: если Вы знаете, что Вам в будущем может понадобиться больше ресурсов, больше возможностей, то перед покупкой уточните, получится ли ресурсы докупить, а возможности подключить.

Ещё один минус дешёвых VPS

Когда VPS стоит дёшево, то есть прибыль от такого клиента для провайдера минимальная, провайдеру приходится размещать слишком много VPS на одном сервере, чтобы сервер окупить.

Соответственно, на сервере возникает сильный оверселлинг ресурсов (продано гораздо больше, чем есть физически).

Для Вас, как для пользователя это означает, что VPS может работать не очень быстро, а в пики вообще жутко тормозить, так как всем нужны ресурсы, которых на сервере нет.

Когда всё-таки можно купить дешёвый VPS?

Задачи у всех разные. Кому-то хочется разместить простенький DNS-сервер, кому-то VPN для посещения сайтов, которые запретило посещать правительство. Кто-то хочет найти дом для своего сайта. А кто-то просто поэкспериментировать, научиться настраивать сервер. Список можно продолжать ещё очень долго.

Ответ на этот вопрос, по нашему мнению, следующий.

- Если это крупный, важный сайт, то экономить однозначно нельзя. Есть множество решения среднего уровня (смотрите от 300 рублей за минимальную конфигурацию), которые на данный момент адекватны по соотношению цена-качество.

- Если Вы хотите разместить VPN, DNS, маленький сайт, который не особо жалко, научиться настраивать серверную ОС, то дешёвый VPS будет отличным выбором. Только делайте бэкапы, чтобы однажды не стало грустно и обидно.