Здравствуйте!

Создаем вам предновогоднее настроение скидками на выделенные серверы. Под щедрость Дедика Мороза (наш личный серверный сорт) попали более 300 серверов, скидки — до 20%. Так, конфиг с процессором Intel Xeon E3-1270 на 4 ядра (3.5 ГГц), с двумя SSD-дисками на 240 ГБ можно приобрести за 5 800 руб. в месяц (вместо 8 300 руб.). Мы уверены, что делаем вам самое выгодное предложение на российском рынке, поэтому дарим дополнительную скидку, если вы нас переубедите. Найдете цену лучше — снизим стоимость выбранной конфигурации на 10% от цены конкурента.

NVIDIA A100 под ёлкой

NVIDIA A100 под ёлкой

Для Selectel лучший подарок — довольные клиенты. Ну, и новый мощный GPU — NVIDIA A100, поставку которого мы ожидаем в конце года. Ускоритель предназначен для работы с ИИ и большими данными, для задач Machine Learning и высокопроизводительных вычислений. NVIDIA обещает десятикратное повышение производительности в сравнении с предыдущими решениями. Сделать предзаказ NVIDIA А100 и узнать его цену можно уже сейчас, написав на почту sales@selectel.ru.

www.nvidia.com/ru-ru/data-center/a100/

Не привязывайтесь к датам

Теперь вы можете изменить платежный день в панели управления. Сделали это для тех, кто пользуется несколькими услугами выделенных серверов Selectel и вынужден оплачивать их в разные дни. Понимаем, что это не всегда удобно, и предлагаем вам выставить единый платежный день. Поменять дату можно уже сейчас: зайдите во вкладку «Услуги сервера» и кликните на контекстное меню справа от цены.

Изменения вступят в силу по окончании вашего тарифного периода. Сумма следующего списания будет пересчитана исходя из количества дней между старым и новым платежным днем. Важно: обновление доступно для услуг, приобретенных после 30 ноября 2019 года, и серверов линейки Chipcore.

Tesla T4 в «Облачной платформе»

В начале декабря в петербургский дата-центр завезут графические ускорители NVIDIA Tesla T4. Если ваши задачи связаны с системами искусственного интеллекта и машинным обучением, советуем присмотреться к новичку. Видеокарта ускоряет тренировку и инференс алгоритмов глубокого обучения, анализ данных, высокопроизводительные вычисления.

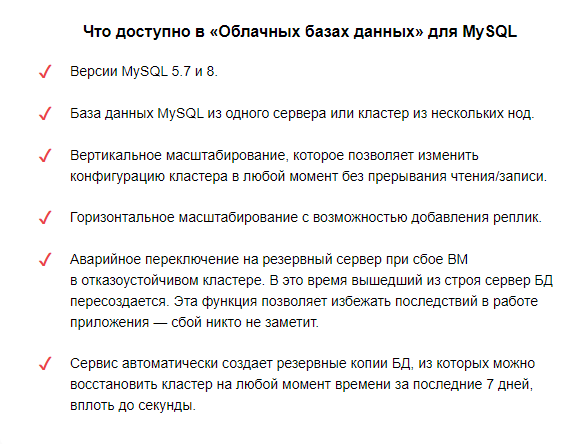

Облачные базы данных для MySQL

Облачные базы данных для MySQL

Подводя итоги 2020, хотим поставить галочку напротив еще одной цели — запуск MySQL в «Облачных базах данных». Присоединяйтесь к бета-тестированию и попробуйте все плюсы managed-решения бесплатно. Оцените легкость развертывания производительных и надежных кластеров баз данных и возможность не думать об администрировании баз данных. Где бы ни были ваши БД — на выделенном сервере, виртуальной машине или сторонней платформе, наши специалисты помогут перенести их в «Облачные базы данных» Selectel.

selectel.ru/services/cloud/managed-databases

Быстрое выполнение «Облачных функций»

Клиенты отмечают, что «Облачные функции» Selectel быстрее других решений, представленных на рынке. И вот почему.

selectel.ru/services/cloud/serverless/

Кроме времени выполнения, важным признаком качества вашего сервиса является отсутствие ошибок. Поэтому мы добавили вкладку со статистикой, на которой можно оценить количество успешных и неуспешных вызовов функции за разные отрезки времени и при необходимости заглянуть в логи для диагностики проблем.

my.selectel.ru/vpc/faas/statistics/

Оцените эффективность новогодних акций с Selectel VideoAnalytics

Оцените эффективность новогодних акций с Selectel VideoAnalytics

Мы с подарками для клиентов, развивающихся в сфере ритейл и гостинично-ресторанного бизнеса. Подключим вам до пяти модулей видеоаналитики на два месяца бесплатно. Сможете оценить не только Selectel VideoAnalytics, но и работу вашего бизнеса в праздники. Сколько людей вас посетили, как работали кассы, кто ваши клиенты — расскажет видеоаналитика. А благодаря мобильному приложению Selectel VideoAnalytics (доступно в GooglePlay и AppStore) вы сможете контролировать все онлайн. Даже если предпочли уехать на Новый год в Сочи без рабочего ноутбука.

promo.selectel.ru/videoanalytics/

promo.selectel.ru/webinars/video-analytics/101220/

Расчет стоимости 1С в «Облачной платформе»

promo.selectel.ru/webinars/video-analytics/101220/

Расчет стоимости 1С в «Облачной платформе»

Знаете ли вы, как изменится стоимость системы 1С в облаке Selectel, если вы добавите в нее несколько пользователей, а база станет тяжелее на 10 ГБ? А если подключить «Облачные базы данных» и перейти на Linux? Теперь будете! Добавили калькулятор стоимости сервера для 1С, потому что важен каждый пользователь и гигабайт.

selectel.ru/services/1c-leasing/1c-cloud/

selectel.ru/careers/all/vacancy/38308775/

selectel.ru/careers/all/vacancy/38308775/