Компания Ampere анонсировала 128-ядерный ARM-процессор Altra Max

Несколько месяцев назад калифорнийская компания Ampere представила первый в отрасли 80-ядерный ARM-процессор Ampere Altra.

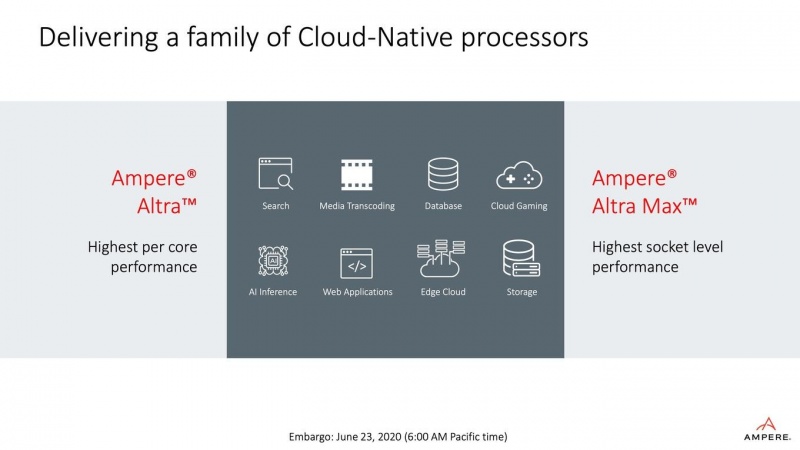

Этот чип на 64-битной архитектуре предназначен для установки в серверное оборудование, он не для потребительского рынка. Сейчас же компания расширила линейку процессоров, дополнив ее 128-ядерной моделью.

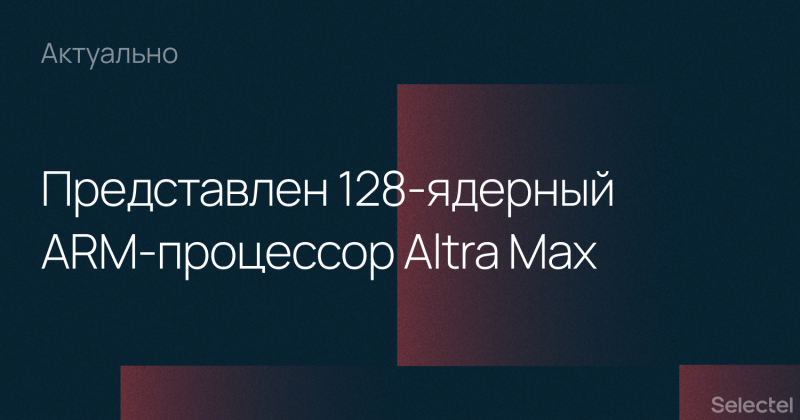

Altra Max совместимы с другими моделями Altra и могут устанавливаться в серверы, где уже стоят процессоры компании предыдущих поколений. Вся линейка базируется на дизайне ARM Neoverse N1, он же лежит в основе процессоров AWS Graviton2 от AWS. Компания Ampere заявила, что новые процессоры позволят повысить производительность оборудования, в чем заинтересованы поставщики облачных услуг.

Характеристики Altra Max

Новинка оснащена 128 физическими ядрами (без технологии многопоточности). Кэш L1 для инструкций и данных — 64 Кбайт, L2 — 1 МБ, L3 — 32 МБ для каждого из ядер. Тактовая частота ядер — 3.0 ГГц.

Поддерживается восьмиканальная оперативная память ECC DDR4-3200, максимальный объем ОЗУ — 4 ТБ. Также поддерживается 128-линейный интерфейс PCI Express 4. Если установить два процессора на одну материнскую плату, то количество поддерживаемых линий составит 192. Известно, что 32 линии в этом случае используются для обмена данными между сокетами. Весь модельный ряд Altra производится по 7-нм техпроцессу от TSMC.

В зависимости от модели энергопотребление чипов составляет от 45 до 250 Вт. У 80-ядерного Ampere Altra показатель TDP — 210 Вт.

Разработчики предлагают использовать процессор для серверных приложений, включая аналитику данных, нейросети, базы данных, пограничные вычисления и облачные приложения. Специально для нужд машинного обучения Ampere реализовала на аппаратном уровне поддержку форматов данных FP16 (числа половинной точности) и INT8 (однобайтное представление целого числа). Предусмотрено аппаратное ускорение хэширования AES и SHA-256.

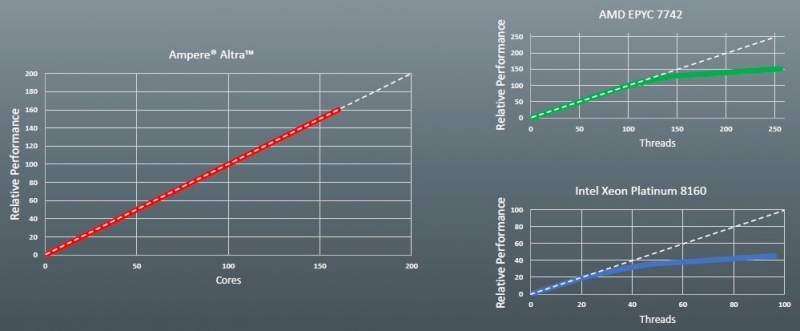

Бенчмарк для 80-ядерного ARM процессора Ampere Altra

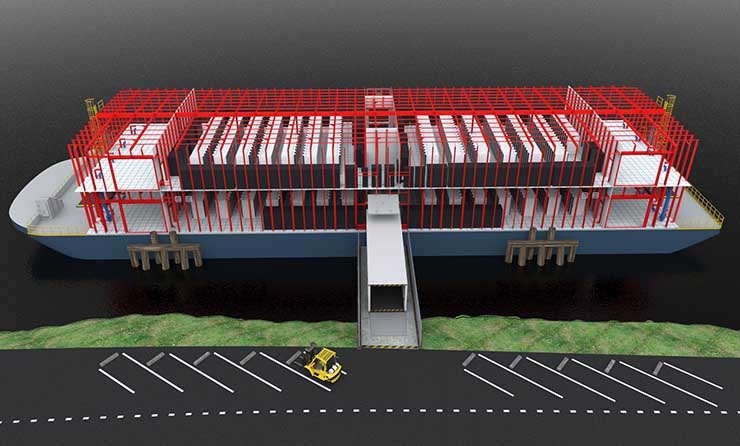

По словам производителей, серверные ARM-процессоры эффективнее X86, во многом благодаря пониженному энергопотреблению. Поэтому можно повысить плотность размещения оборудования c этими процессорами в ЦОД, одновременно улучшив показатели удельной производительности, энергопотребления и тепловыделения.

Сейчас в линейку Altra входит 12 процессоров, в продажу уже поступили процессоры с количеством ядер от 32 до 80, частотами от 1,7 до 3,3 ГГц и теплопакетами от 45 до 250 Ватт. Цены пока не озвучены.

Известно, что новинкой заинтересовалось несколько партнеров, включая Gigabyte, Wiwynn, Cloudflare, Genymobile, NVIDIA, Equinix и менее крупные компании. Массовое производство новых процессоров начнется в 2021 году, так что и начало продаж можно ожидать примерно в это же время.

«Компания Cloudflare крайне заинтересована в процессоре Ampere и его инновационной архитектуре. Мы приятно удивлены результатами предварительных тестов производительности. Рады возможности поработать с Ampere Altra Max со 128 ядрами и с нетерпением ждем процессор для тестов», — заявили в Cloudflare.

Что дальше

Одновременно Ampere начала освоение 5-нм техпроцесса, именно эта технология будет использоваться при создании серверных процессоров следующего поколения. Они уже получили название Siryn и будут представлены через пару лет, ориентировочно в 2022 году. Насколько известно, они будут поддерживать PCI Express 5.0 и DDR5.

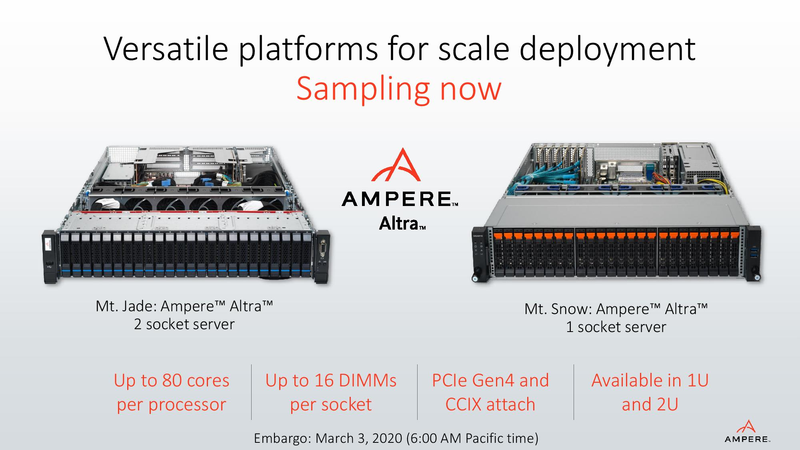

Кроме процессоров, компания поставляет и платформы для них. Платформы доступны двух типов: первая — однопроцессорная Mt. Snow, вторая — двухпроцессорная Mt. Jade.