Поскольку COVID-19 пандемия была объявлена 30 января, мы внимательно наблюдая, как ситуация сложилась по всему земному шару.

Сегодня, в зависимости от рекомендаций, выданных руководящих органов здравоохранения, наша компания управление локальными ситуациями во всех регионах, где у нас есть команды. Мы делаем это, чтобы гарантировать безопасность наших сотрудников, а также гарантировать непрерывность для ваших услуг.

Мы хотели бы поделиться с вами действия, которые мы поставили на место.

Гарантирование вам непрерывность обслуживания

Наши команды прилагают все усилия, чтобы поддержать вас в самых лучших условиях. Как следствие, мы развертывают планы обеспечения непрерывности бизнеса. Нашим приоритетом является обеспечение оперативного обслуживания высокого качества, которая имеет важное значение для вашей деятельности — как для вашего бизнеса, а также на более стратегический, национальный масштаб. Мы намерены применить эту всемирную, везде, где мы присутствуем.

Наша служба поддержки клиентов адаптировались на случае к случаю основе к мерам удержания насильственных в ряде стран. Итальянское правительство поставить эти меры на месте две недели назад, и мы находимся в процессе полной реорганизации нашей системы поддержки по всему миру, чтобы обеспечить наилучшее возможное качество.

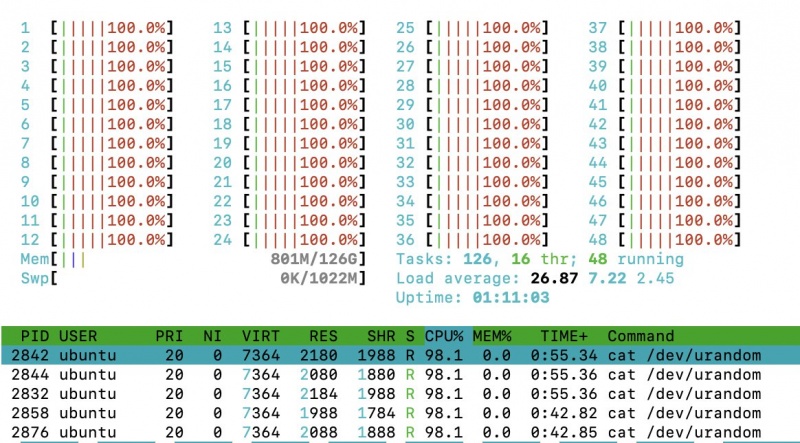

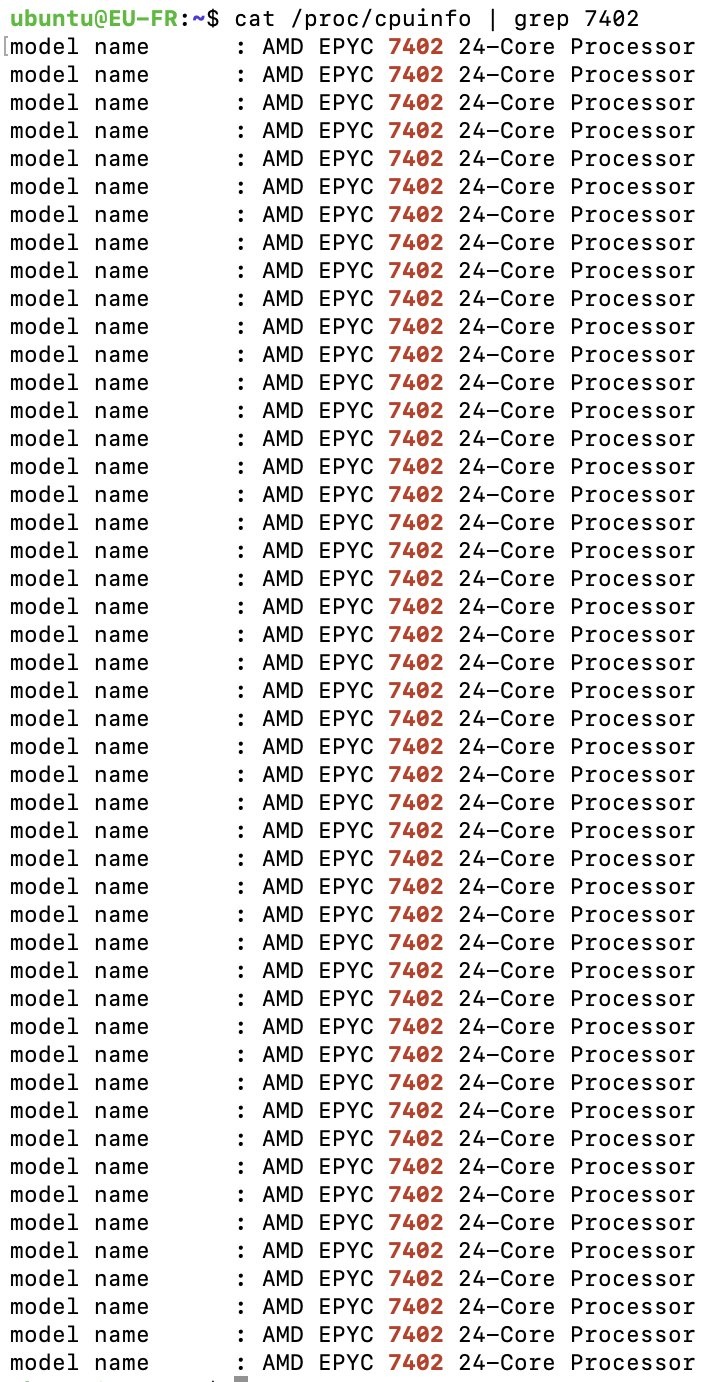

Мы также защиты работников в наших центрах обработки данных, с мерами профилактики армированных на месте. Сегодня все операции центров обработки данных и обслуживания серверов может осуществляться как обычно. Наша инфраструктура способна поглощать пропускную способность 20Tbps, и по этой причине, мы не считаем, что этот кризис будет влиять на качество обслуживания, мы предлагаем Вам. Мы работаем в тесном контакте с нашими поставщиками, и мы не ожидаем, что испытывать какие-либо серьезные проблемы, выделения ресурсов в краткосрочной перспективе для поставки необходимой для производства наших собственных серверов. Так как ситуация все еще продолжает меняться в быстром темпе, мы будем держать вас в курсе.

Гарантирование здоровья и безопасности для всех сотрудников — приоритет OVHcloud

Как только ВОЗ классифицирована COVID-19, как эпидемия, мы начали усиливающие меры профилактики. Мы подвешенный деловые поездки, а также повысить осведомленность о личной гигиены и техники безопасности в наших местах.

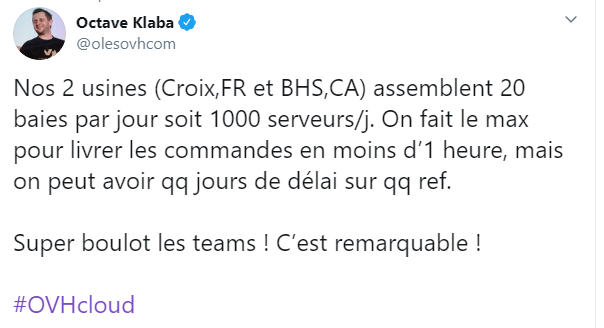

Поскольку COVID-19 вспышка была объявлена пандемией, мы приняли решение, чтобы заставить все работать из дома (за исключением информационного центра и работников завода), во всех сайтах OVHcloud по всему миру. Это позволяет защитить и себя и других граждан. Большинство наших сайтов уже закрыто, а офисы, которые все еще открыты будут закрыты к середине недели на этой неделе — за исключением нашего производственного участка (который мы изменили сдвиги для того, чтобы поддерживать взаимодействие персонала к минимуму), а также центров обработки данных.

Мы понимаем, что защита наших сотрудников, мы делаем нашу часть, чтобы предотвратить распространение вируса в более крупном масштабе.

Показаны солидарности и бдительности

Мы призываем всех следовать рекомендациям, изданным общественных организаций, а также национальных и международных органов. Простые действия предупреждения, такие как следующие меры личной гигиены, являются эффективным средством защиты и себя и других от заражения. Работая вместе, мы найдем путь преодоления ситуации. Для получения более подробной информации, пожалуйста, посетите страницу Всемирной организации здравоохранения.

www.who.int/emergencies/diseases/novel-coronavirus-2019

OVHcloud будет продолжать внимательно наблюдая за распространение пандемии, и будет принимать все меры, необходимых для поддержки услуг при защите наших сотрудников, на основе рекомендаций, выданных руководящие органы здравоохранения.

Спасибо за вашу поддержку, а также для выбора OVHcloud.

Команды OVHcloud