Инновации на всех уровнях — ключевая часть идентичности OVHcloud. Наша сила заключается в том, чтобы постоянно ставить перед собой задачу лучше отвечать на вызовы наших клиентов. Новые функции, которые ждут их в Premium Bare Metal Cloud, являются результатом нашего стремления к изменениям и внимательного отношения к потребностям наших клиентов. Но чтобы бросить вызов этому рынку, нам нужно было разработать прочную стратегию, включающую радикальные внутренние преобразования.

Начало революции

Начало революции

OVHcloud предлагает широкий портфель облачных продуктов и решений для четырех вселенных (веб-облако, Bare Metal Cloud, публичное облако и размещенное частное облако). Облако, которое мы предоставляем, всегда проектируется и разрабатывается с учетом потребностей наших клиентов, и мы всегда стараемся понять их бизнес, чтобы иметь лучшее представление об их проблемах.

Мы начали наши обсуждения рынка Premium Bare Metal Cloud еще в 2016 году.

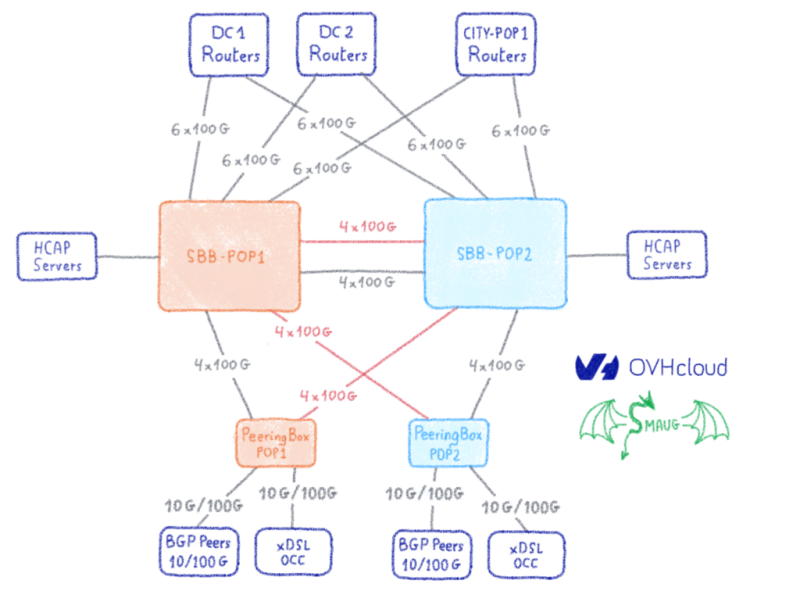

Мы начали наши обсуждения рынка Premium Bare Metal Cloud еще в 2016 году. В то время мы получили отзывы от нескольких клиентов относительно нашего ценового позиционирования на этот конкретный диапазон мощных серверов, которые соответствуют очень высоким требованиям к хранению. Наши изделия из чистого металла были слишком дорогими по сравнению с тем, за что они были готовы платить. Затем мы работали, в частности, с двумя клиентами. Поскольку они были готовы разделить с нами свои расходы, мы смогли спроецировать их экономическую модель на нашу бизнес-модель. Эти два клиента размещали свои собственные услуги через колокацию, без круглосуточной поддержки местной команды, и у них была небольшая интернет-сеть. Они инвестировали в свои собственные серверы, рассчитав свои цены за 5-летний период. Проведя этот анализ, мы поняли, что можем предложить им эти мощные серверы по более низкой, гораздо более конкурентоспособной цене. Но для решения этой задачи нам потребуется проделать серьезную работу, которая, вероятно, займет несколько лет.

Новая бизнес-модель

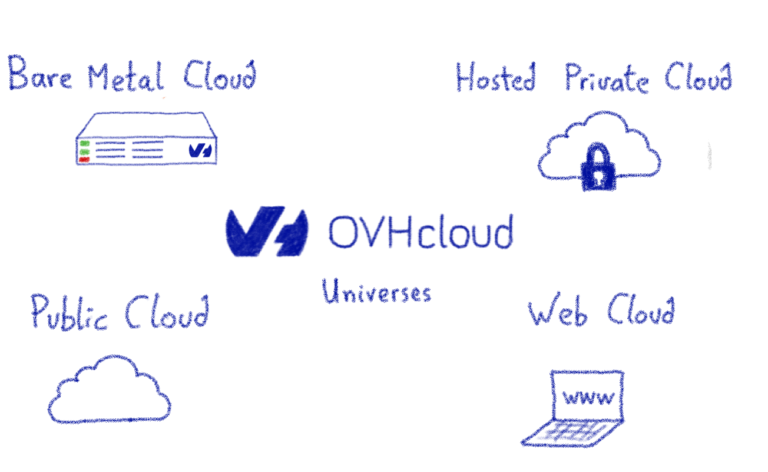

Наш первый проект включал полную реструктуризацию математической основы нашей бизнес-модели, которую мы использовали для расчета наших цен. Мы начали это в 2017 году, и это заняло три года.

В первый год мы реорганизовали компанию и создали Подразделения. Каждое из Подразделений — это своего рода малый бизнес в OVHcloud. Он способствует нашему коллективному успеху, управляя обязанностями, соответствующими его опыту, и вносит свой вклад в наш стратегический план. Его возглавляет руководитель подразделения, и у него есть план действий.

На второй год мы создали отчеты о прибылях и убытках для каждого подразделения, чтобы они могли моделировать проекты в своей дорожной карте с помощью реальных затрат по сравнению с ожидаемыми выгодами. Чтобы предоставить им эту аналитическую основу, нам пришлось реструктурировать наши финансы. Это включало разделение общих прибылей и убытков компании на несколько микро прибылей и убытков. Это означало, что мы могли распределить затраты по нужным единицам и создать внутренний рабочий процесс выставления счетов. Затем мы смогли рассчитать доход каждой единицы, сверяя доход, полученный от выставления счетов клиентам, с доходом, полученным от внутреннего возвратного платежа для других единиц, при интеграции связанных затрат (команды, лицензии и т. Д.). После этого каждое подразделение выпустило маржу.

На третий год мы связали все эти показатели с финансовой отчетностью и сделали их KPI доступными для подразделений в режиме реального времени. Целью развертывания этих финансовых панелей мониторинга было лучшее управление эффективностью компании, но, что более важно, расширение возможностей команд. Согласовав инструменты финансового мониторинга с новой организацией, подразделения смогли составить более надежные прогнозы, лучше прогнозировать риски и лучше прогнозировать свои инвестиции и расходы на заработную плату. Для компании это был также способ обеспечить, чтобы каждый проект создавал ценность для OVHcloud, а также продолжал обеспечивать, чтобы наше развитие оставалось прибыльным, сбалансированным и устойчивым для нашей конкурентоспособности и независимости. С точки зрения потребителя, такая культура сознательного отношения к ценам в основном приведет к еще большему снижению цен.

В цифровом мире экономика также полагается на два сдвига: сокращение постоянных затрат (за счет увеличения объема продаж) и сокращение переменных затрат (за счет автоматизации задач с помощью программного обеспечения, роботизированных систем и искусственного интеллекта). Массовые вложения в автоматизацию — серьезная проблема для такого поставщика облачных услуг, как мы. Благодаря огромным инвестициям мы повысили качество (меньше ошибок, упростили процедуры, ускорили предоставление услуг) и смогли выполнять больше операций в день без увеличения размера Подразделений. Это означало, что Подразделениям больше не приходилось выполнять повторяющиеся задачи, и вместо этого они могли сосредоточиться на добавленной стоимости, которую они должны были принести нашим клиентам. Мы делаем это, следуя принципам BFLNT, которые я описал в предыдущем сообщении блога.

Наконец, это сочетание операционной и финансовой эффективности, а также уровня автоматизации в подразделениях помогает нам разрабатывать все более рентабельные решения и обеспечивать нашим клиентам еще большее соотношение цены и качества.

CAPEX — это ценность

Чтобы поддержать свои амбиции, компании, которые несут высокие капитальные затраты, тратя большие суммы на инвестиции в недвижимость или оборудование, никогда не получают высокой оценки на финансовом рынке. Чтобы обезопасить эти крупные инвестиции, они часто используют сложные — даже непрозрачные — финансовые схемы, которые воспринимаются как слишком большой риск.

Для OVHcloud эти большие суммы являются основой нашей действенной модели — инвестирования в строительство и улучшение наших центров обработки данных, обновление производственного оборудования и приобретение новых производственных помещений. Наша бизнес-модель полностью демистифицирует эти масштабные инвестиции, поскольку она изначально обеспечивает возврат инвестиций. Наша способность инвестировать за счет повышения прибыльности позволила нам привлечь капитал в 2016 году (279 миллионов долларов от KKR и TowerBrook) и даже привлечь долг в конце 2019 года (976 миллионов долларов). CAPEX — это наш основной вектор создания стоимости. Мы должны постоянно инвестировать в будущие инновации и инфраструктуру, чтобы обеспечить нашу устойчивость и конкурентоспособность.

Благодаря всей работе, проделанной за последние три года, мы также смогли внести огромные изменения в нашу бизнес-модель. С помощью сложного анализа, который мы получили, теперь мы можем рассчитать цену сервера на основе нескольких переменных, таких как время выполнения обязательств, объем заказа, тип сервера и инвестиционные затраты на инфраструктуру и сам бизнес. Эта новая финансовая модель внутри компании называется «Джекпот», так как любое сокращение наших капитальных или операционных расходов (операционных расходов), безусловно, снизит цену для наших клиентов. И в случае, если мы не предоставляем ожидаемую цену — а это означает, что наши решения CAPEX или OPEX недостаточно оптимизированы — мы всегда ищем, где мы можем внедрять инновации и на каком уровне нам нужно изменить. Потому что, если мы уменьшим наши затраты, мы снизим наши цены, а не увеличим маржу. Эта постоянная самоанализа через инновации позволяет нам предлагать клиентам более выгодные цены, как мы скоро сделаем это с Premium Bare Metal Cloud.

T3-96-6KW-W

96 серверов на стойку мощностью 6 кВт

при 4 уровнях стоек у нас 384 сервера типа ADV-1/2/3

Все серверы имеют водяное охлаждение.

PUE = 1,07

Это означает лишь 7% потерь энергии!

Новые методы использования ресурсов

Новые методы использования ресурсов

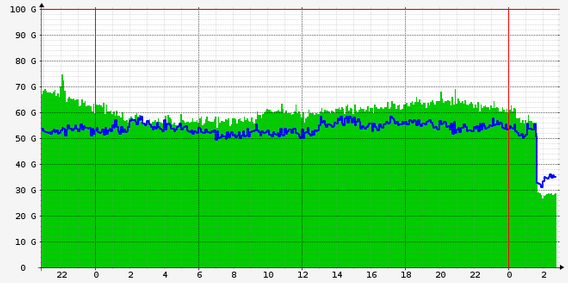

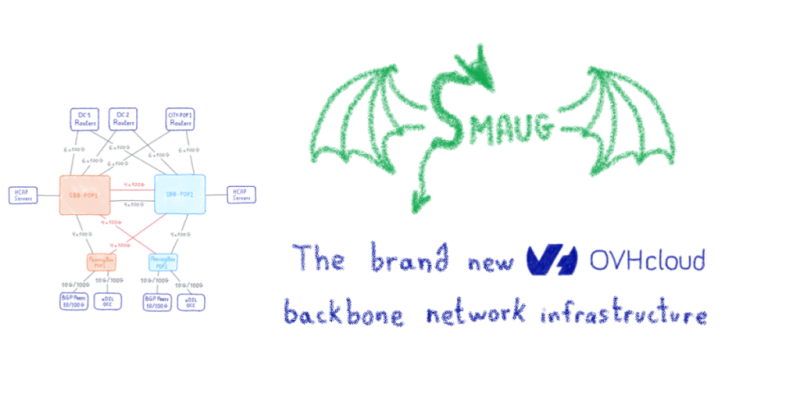

Наша цель — стать мировым экспертом в Premium Bare Metal Cloud. Мы хотим встряхнуть рынок с 350 до 2500 долларов в месяц (для серверов премиум-класса высшего класса) и стать эталоном, как мы уже делаем для серверов начального и среднего уровня. Клиенты, которым нужна максимальная мощность и мощность, начнут замечать первые результаты нашей стратегии. Чтобы лучше выполнять свои задачи, к концу 2020 года наши публичные цены упадут. Но мы сохраним такую же высокую производительность. В дополнение к нашей промышленной модели, которая уникальна в плане полного контроля и позволяет нам постоянно адаптироваться, в последние месяцы именно наша новая бизнес-модель «Джекпот» помогла нам пойти еще дальше. И на основе этой новой модели мы рассмотрели все — серверы, сеть, энергоснабжение и водяное охлаждение. Сейчас, более чем когда-либо, мы являемся лидером по цене по своему замыслу.

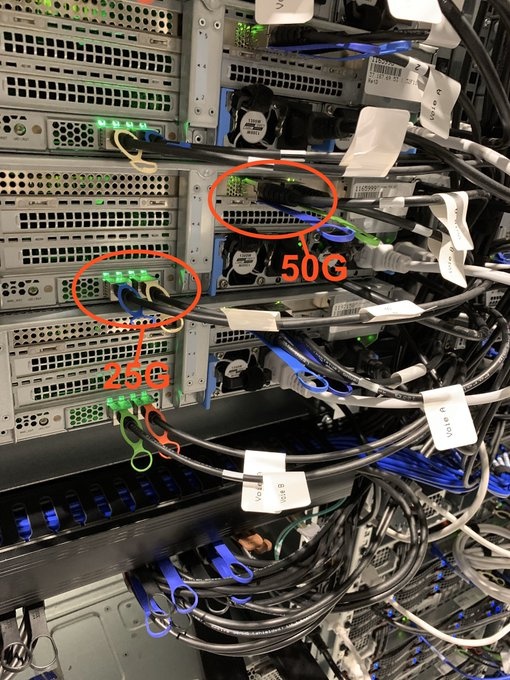

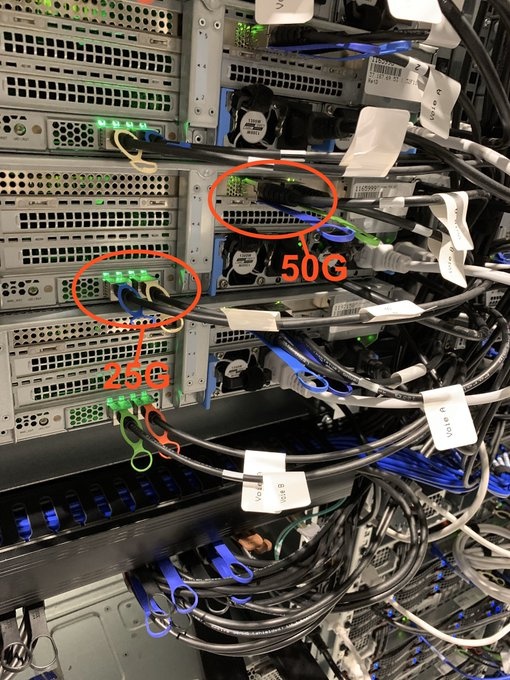

POC HGv2 / FSv2 T5 2U 2x25G+2x50G

Новая финансовая модель, позволяющая нам более точно отслеживать жизненный цикл продуктов, также позволяет нам пересмотреть наши модели обязательств. До конца года мы предложим более конкурентоспособные цены по долгосрочным обязательствам. В дополнение к уже доступным моделям ежемесячной оплаты, то есть без обязательств или с обязательством на 6, 12 или 24 месяца, мы также предложим планы с обязательствами на 3, 4 или 5 лет. Наши цены будут еще лучше для клиентов, которые могут использовать как объем (3 или 12 стоек с 48 или 96 серверами), так и продолжительность (3, 4 или 5 лет). В будущем наши клиенты также смогут получать почасовые расценки на Bare Metal с посекундной оплатой.

Наконец, для клиентов, которым требуется много серверных стоек и которые не хотят управлять своей инфраструктурой, мы уже можем предоставить частные помещения в наших центрах обработки данных с 12, 24 или 48 стойками *, оборудованными камерами, значками и журналами. Этот вариант использования удовлетворяет потребности не только клиентов Bare Metal Cloud, но также клиентов Public Cloud и Hosted Private Cloud в режиме «частного региона». Начиная со 100 стоек, мы можем поставить настоящие частные центры обработки данных в зданиях третьих сторон (в помещениях клиентов) *, где бы они ни находились. Это значительно снижает их затраты. Для этих центров обработки данных мы применяем наш промышленный и технический опыт, в том числе нашу эксклюзивную технологию водяного охлаждения, и все наши аппаратные инновации, включая самые последние технологии на рынке. Мы также управляем всеми уровнями программного обеспечения и их жизненными циклами.

Глобальное воздействие

Цель этого сообщения в блоге — не детализировать наши будущие предложения, а объяснить долгий путь, который привел к снижению цен на Premium Bare Metal Cloud. Но если вы подписаны на мою учетную запись в Twitter (@olesovhcom), вы, возможно, видели некоторые их превью, потому что я регулярно делюсь информацией о нашей работе.

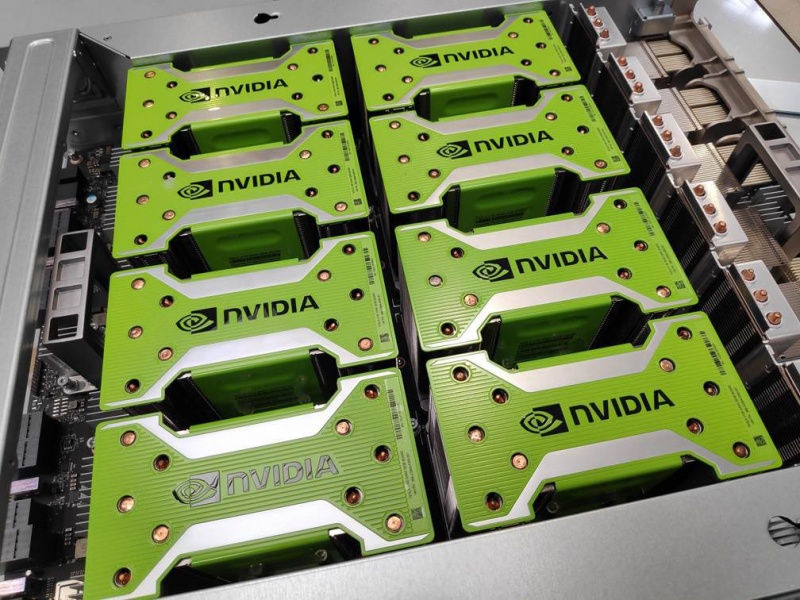

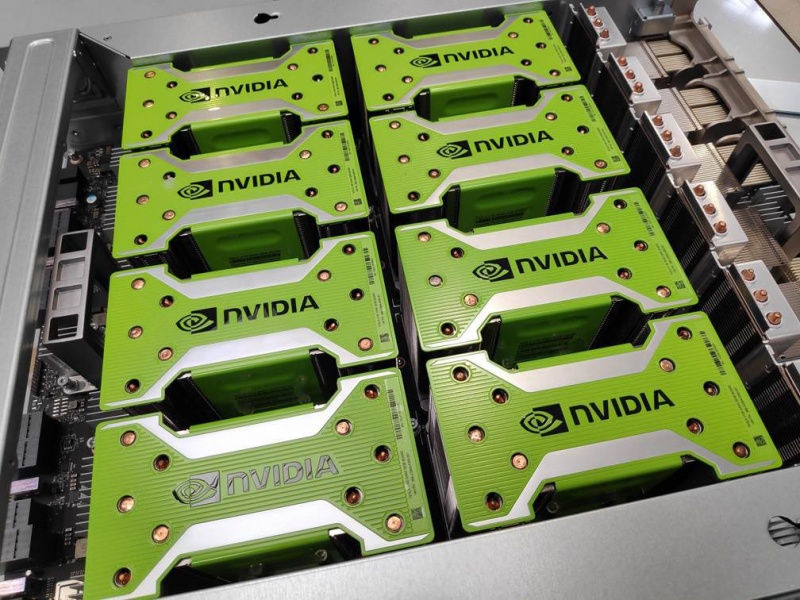

«We need GPUs. Lot of GPUs.»

New POC: AI Training, Inference, (Software in VDI)aaS.

OVHcloud will offer a large range of the products AI/DL+ML based on GPU/CPU/FPGA/Optical.

Всего OVHcloud скоро предложит около 300 моделей Bare Metal Cloud! Это очень широкий диапазон, и наши маркетинговые команды взяли на себя впечатляющую задачу, предложив упрощенный просмотр, чтобы вы могли найти именно то, что вам нужно. В конце октября 2020 года название меню изменится с «Сервер» на «Bare Metal Cloud». Это будет первым шагом в переходе, который произойдет в ближайшие месяцы, с гораздо более ориентированным на использование подходом, таким как виртуализация, хранение, глубокое обучение, базы данных и т. Д. Цель состоит в том, чтобы упростить ваше путешествие, и поможет вам легко выбрать модели, наиболее соответствующие вашим потребностям.

Как внутренние клиенты, наши три других облачных юниверса (веб-облако, общедоступное облако, размещенное частное облако), которые все полагаются на наши инфраструктуры Bare Metal Cloud, также получат выгоду от этих инноваций и новых цен. Прежде чем оказывать такое глобальное влияние, нам нужно было изучить основы облака. Ожидайте отличных анонсов в 2020-2021 годах!

working on BETA Public Cloud IAaaS Deep Learning for training and inference… deploying 2 clusters (> 5M cores each) in FR and CA… the technology PaaS will allow to reduce the cost by 50% vs hyperscalers and change the mindset: run the jobs, not VMs

Чтобы узнать больше, отправляйтесь на OVHcloud EcosystemExperience, наше новое виртуальное мероприятие, которое состоится 3, 4 и 5 ноября.

Чтобы узнать больше, отправляйтесь на OVHcloud EcosystemExperience, наше новое виртуальное мероприятие, которое состоится 3, 4 и 5 ноября.

Мы докажем вам конкретными словами, что, нестандартно мыслящие через разрушение и создавая прочную экосистему, мы ежедневно помогаем сделать OVHcloud подлинной альтернативой в облачной индустрии.