Наш ЦОД «Медведково», о котором мы уже рассказывали, в 2024 году стал кластером, так как рядом был построен еще один дата-центр — «Медведково-2». В этой статье мы покажем, как устроен новый ЦОД.

Здание «Медведково-2» возвели за год, параллельно проводили интеграцию инженерных систем. К 2024 году ЦОД полностью подготовили для проведения аудита и сертификации. Дата-центр успешно прошел испытания Uptime Facility и получил сертификат Tier III.

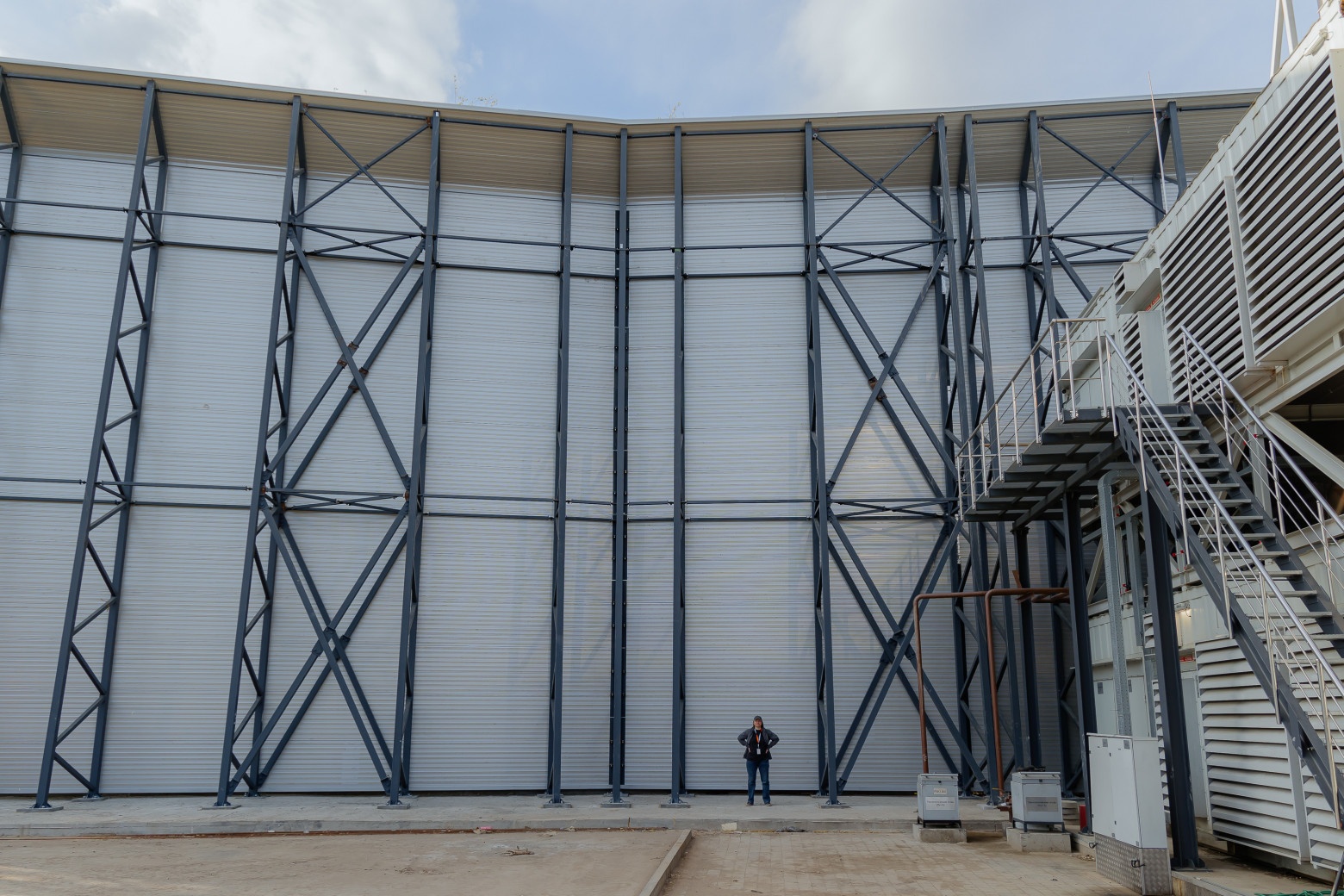

Главное отличие «Медведково-2» — это вертикальная архитектура, так называемый стакан. За счет этого для нагрузки 36 МВт, как в «Медведково-1», потребовалась меньшая площадь застройки.

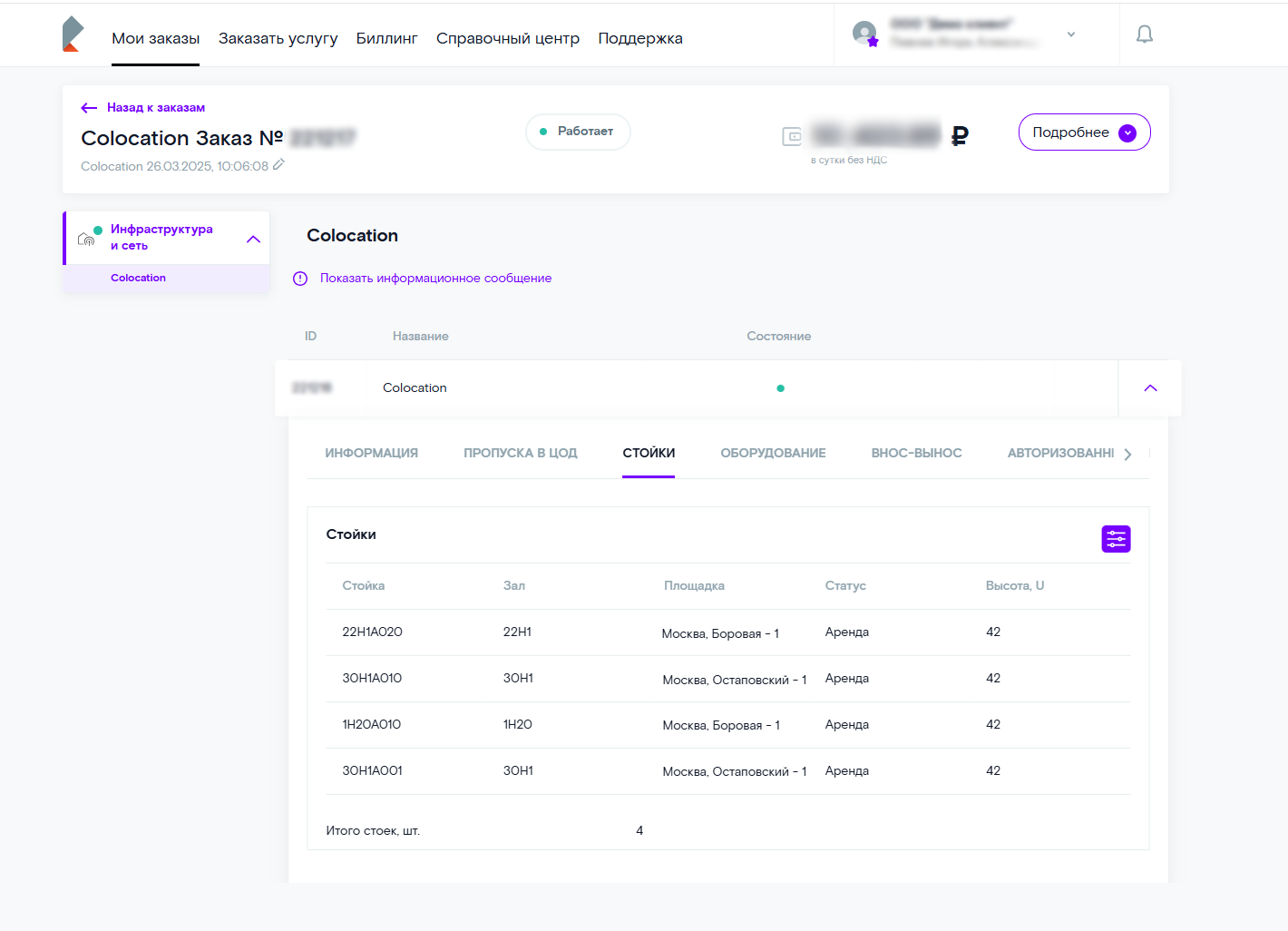

Всего в «Медведково-2» семь этажей, высота здания — 40 метров. 16 машзалов рассчитаны на 4000 стоек — по 250 на каждый зал. Площадь технологических помещений составляет 22 000 кв. м. На двух нижних этажах расположены четыре независимых энергоцентра: РУ 10 кВ, ГРЩ, ТП, ИБП, на остальных — машинные залы, которые относятся к одному из четырех энергоцентров. На кровле размещены чиллеры.

В ЦОДе соблюдается единый стандарт обслуживания клиентов РТК-ЦОД: круглосуточный доступ в дата-центр, бесплатная парковка, комфортная зона для переговоров.

Физическая безопасность

Физическая безопасность

Работает круглосуточная охрана. Во всех помещениях и на территории ЦОДа ведется видеонаблюдение. Все соответствует национальному стандарту Российской Федерации «Системы охраны и безопасности» ГОСТ Р 52551-2016 и стандартам ISO 27001, PCI DSS.

Машинные залы

Машинные залы

Машинные залы защищены от пыли, колебаний уровня влажности и температуры. Внутри поддерживается оптимальный микроклимат, есть система автоматического пожаротушения, ведется круглосуточный мониторинг инженерного оборудования.

Топология размещения серверных стоек реализована по принципу холодных и горячих коридоров. Расстояние между рядами стоек в холодном коридоре составляет 1200 мм.

Подача охлажденного воздуха к серверным стойкам идет через перфорированную плитку фальшпола в холодных коридорах. Высота фальшпола — 1350 мм. Пропускная способность перфорированных плиток составляет не менее 38% от общей площади плитки.

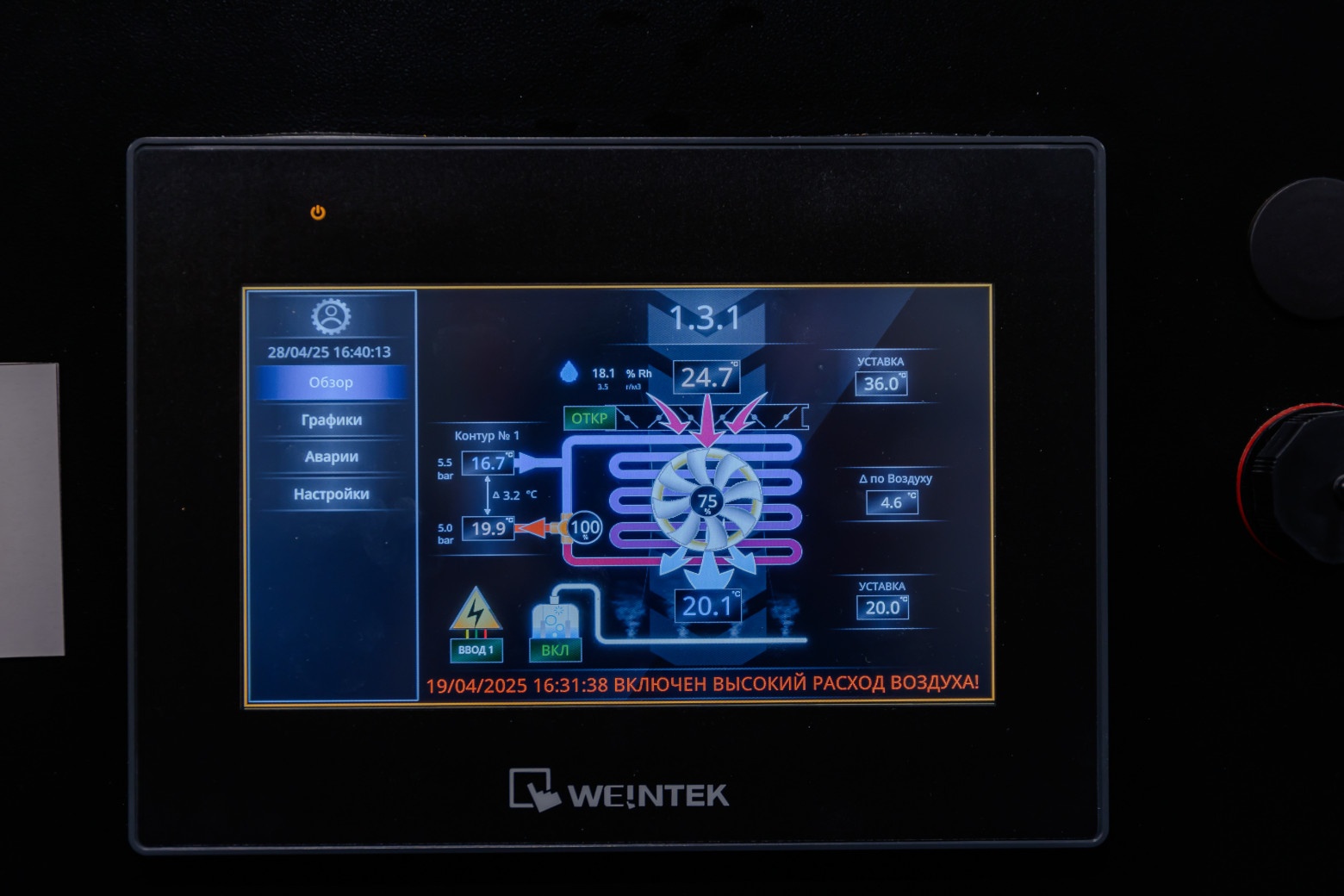

В холодных коридорах поддерживается температура 23±3 °С и влажность 30–70 %. Увлажнители размещены внутри корпусов кондиционеров. Каждый модуль рассчитан на отвод 6 МВт тепловой нагрузки от ИТ-оборудования.

По вопросам установки и эксплуатации клиентского оборудования круглосуточно доступны филды и дежурные инженеры (услуга Smart Hands).

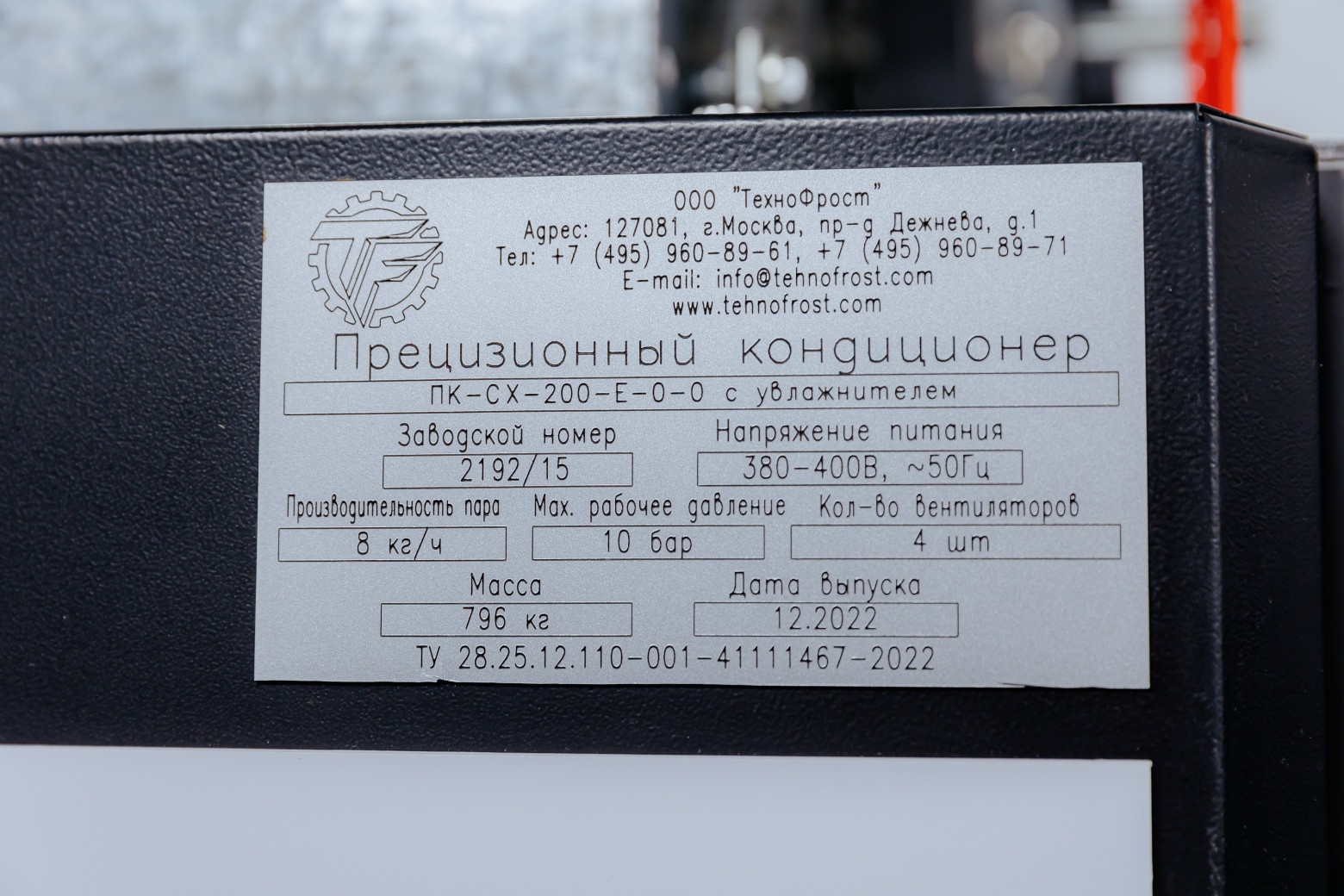

Климат

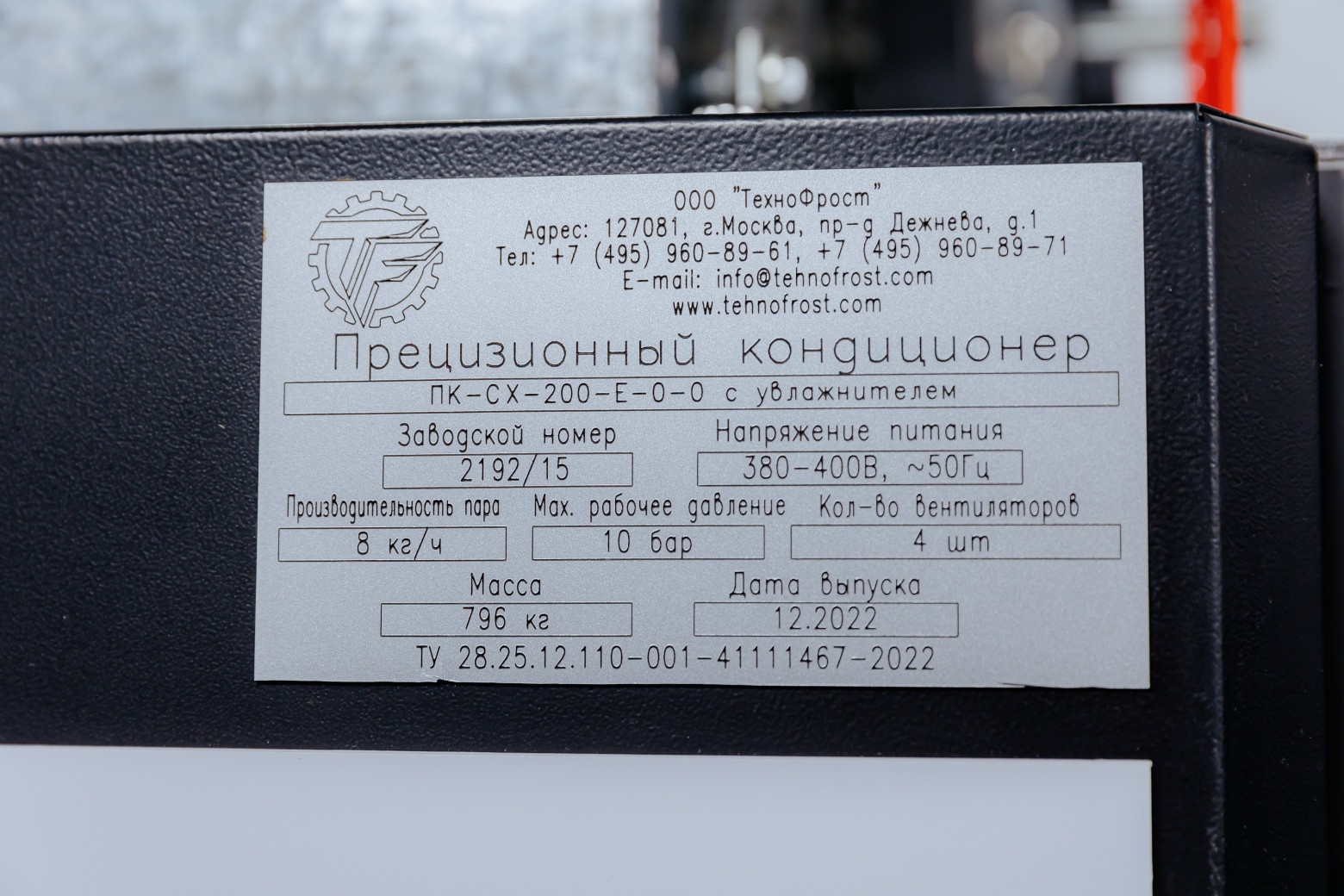

В системе холодоснабжения «Медведково-2» работает 170 прецизионных кондиционеров внутри ЦОДа и 74 чиллера на крыше. Они обслуживают 16 машинных залов и помещения MMR, MDA, ИБП, КСБ.

Вентиляционные коридоры с кондиционерами отделены от машинного зала с клиентским оборудованием. Это позволяет службе эксплуатации проводить плановые работы без посещения основного пространства машинного зала.

Мощность каждого кондиционера — 230 кВт. Оборудование оснащено датчиками протечки воды. Каждый кондиционер на теплообменнике имеет фильтр для обработки проходящего через него воздуха (класс очистки — М5).

Оптимальный уровень влажности по SLA обеспечивают увлажнители и осушители. Схема резервирования системы холодоснабжения N+1.

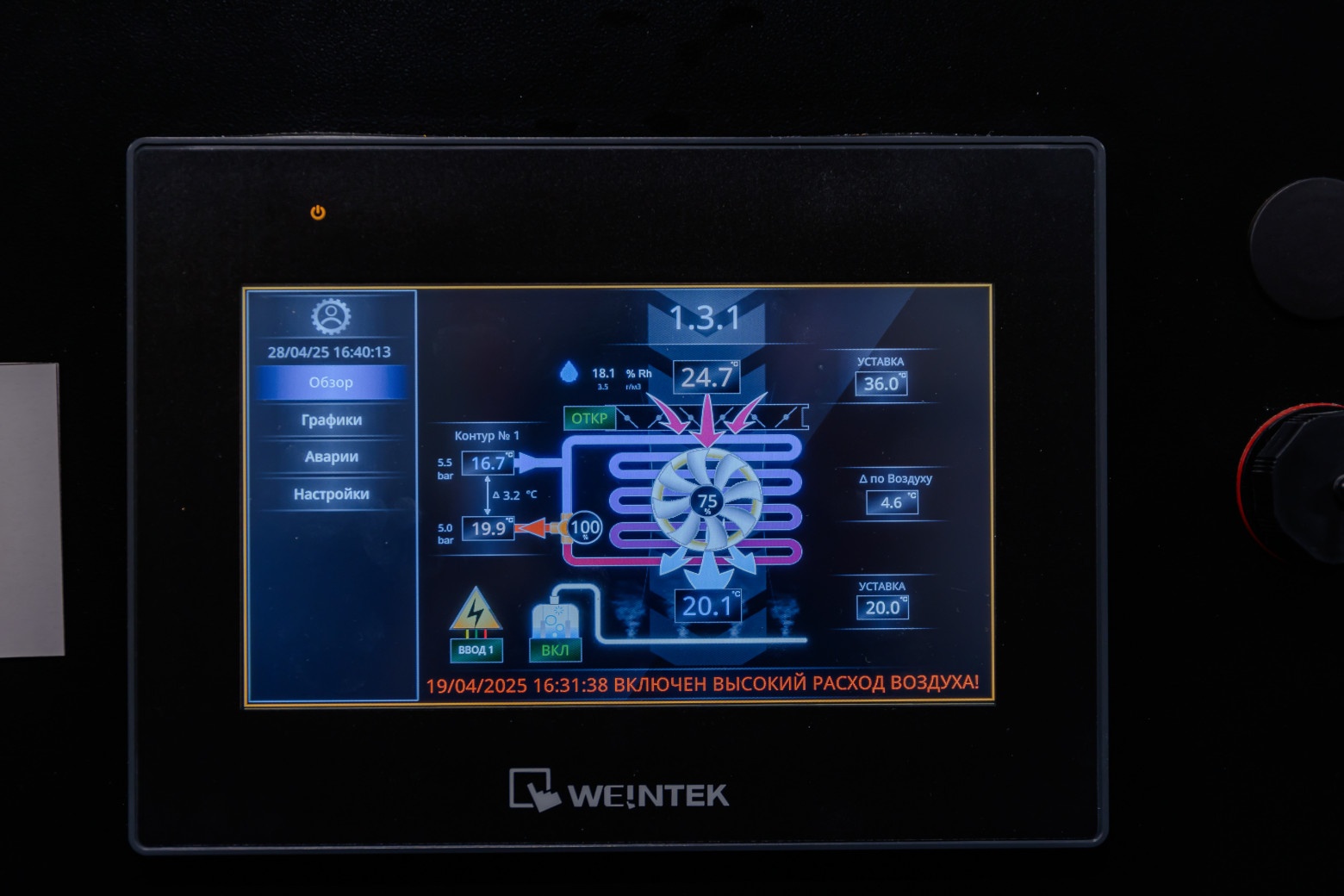

При номинальной проектной нагрузке одновременно работают все восемь кондиционеров в машзале, включая резервные. Если один кондиционер выходит из строя, оставшиеся семь автоматически распределяют тепловую нагрузку между собой с изменением уставки на повышенный расход воздуха. Неисправный кондиционер автоматически выводится из работы, чтобы не произошла подача горячего воздуха в машинный зал.

На крыше находятся аккумулирующие баки емкостью 3000 литров каждый. В них — охлажденный этиленгликоль на случай отказа электропитания компрессоров в чиллерах. Если пропадает электропитание в общегородской сети, во время перехода на дизель-генераторные установки (ДГУ) часть компрессоров в чиллерах перезапускается. Для выхода на рабочую мощность чиллерам нужно до 3 минут. Баки обеспечат до 4 минут поддержания температуры гликоля. В схеме электроснабжения насосных групп чиллеров присутствует ИБП, при переходах на резервный источник питания насосы не перезапускаются.

Мощность каждого чиллера — 470 кВт. Чиллеры имеют один холодильный контур с винтовыми и безмасляными центробежными компрессорами. Предусмотрена плавная регулировка холодопроизводительности. Уровень резервирования холодильных машин N+1: из 16 чиллеров два — резервные с учетом топологии ЦОДа. 14 работающих чиллеров производят 100% холода для четырех машинных залов каждого энергоцентра.

При температуре воздуха снаружи ниже +10 °С чиллеры переходят в режим фрикулинга, что дает большую энергоэффективность ЦОДа. Если температура окружающей среды выше +10 °С, чиллеры запускаются в компрессорном режиме.

Система холодоснабжения оборудована баками компенсации давления. В случае увеличения давления гликоля в системе холодоснабжения это позволяет стабилизировать давление в контуре на нужном уровне.

Станция подпитки гликолем постоянно функционирует в дежурном режиме. Если возникнет нехватка гликоля в результате протечки или потери давления, то дежурный персонал оперативно подпитает систему. Станция оснащена подогревом. В зимний период при выводе холодильной машины или чиллера в сервис мы включаем насос, и гликоль циркулирует через станцию подогрева гликолевого контура, чтобы не остывать ниже рекомендуемой производителем температуры эксплуатации (–28 °С).

Энергетика

ЦОД запитан по высокому напряжению от электросетей: по 10 кВт от городского питания и от резервного источника питания КДГУ. К электропитанию потребителей ИТ-нагрузки по напряжению 0,4 кВт приходит 4 луча электропитания по топологической схеме резервирования 4/3 N. Магистральный шинопровод электропитания организован в вертикальной проекции и горизонтально расходится по этажам в машзалы.

В составе ЦОДа предусмотрены четыре независимых энергоцентра: РУ 10 кВ, ГРЩ, ТП, ИБП, РП ДГУ, ШП, ЩР. На каждый энергоцентр приходится 6 МВт ИТ-нагрузки и 3 МВт — механической для инженерных систем, на каждую стойку — от 5 до 15 кВт.

К каждому энергоцентру подведены независимыми маршрутами два отдельных ввода электропитания.

Действует система гарантированного и бесперебойного энергоснабжения на базе ДГУ и ИБП, в экстренной ситуации для автоматического переключения между вводами и ДГУ сработает автоматический ввод резерва АВР.

Заземление всех конструкций и оборудования организовано по единому контуру.

В отличие от «Медведково-1», где ИБП со свинцовыми аккумуляторами, в новом дата-центре используются литий-ионные аккумуляторы. При той же мощности у них меньший объем, сами устройства более экономны и долговечны. В батарейные блоки встроены модули, которые обеспечат тушение при повышении температуры выше 80 °С. В батарейных модулях используется негорючий литий, что подтвердили испытания, которые были проведены совместно с нашими инженерами на заводе АКБ VISION в Китае.

При переходе с высокой стороны на низкую (400 вольт) в энергоцентрах используются сухие трансформаторы. За счет отсутствие масла эксплуатация удобнее и экологичнее, выше пожарная безопасность.

Система гарантированного энергоснабжения

Рядом с ЦОДом установлено 24 контейнерных дизель-генераторных установки (КДГУ) суммарной мощностью 48 МВт. Объем топливохранилища — 192 тонны, по 8 тонн на каждую КДГУ. Энергопроизводительность каждой машины — 2 МВт.

Запаса топлива хватает на 17 часов автономной работы дата-центра. Топливо доставляют два независимых поставщика. Гарантированный срок поставки топлива для дозаправки ДГУ — четыре часа.

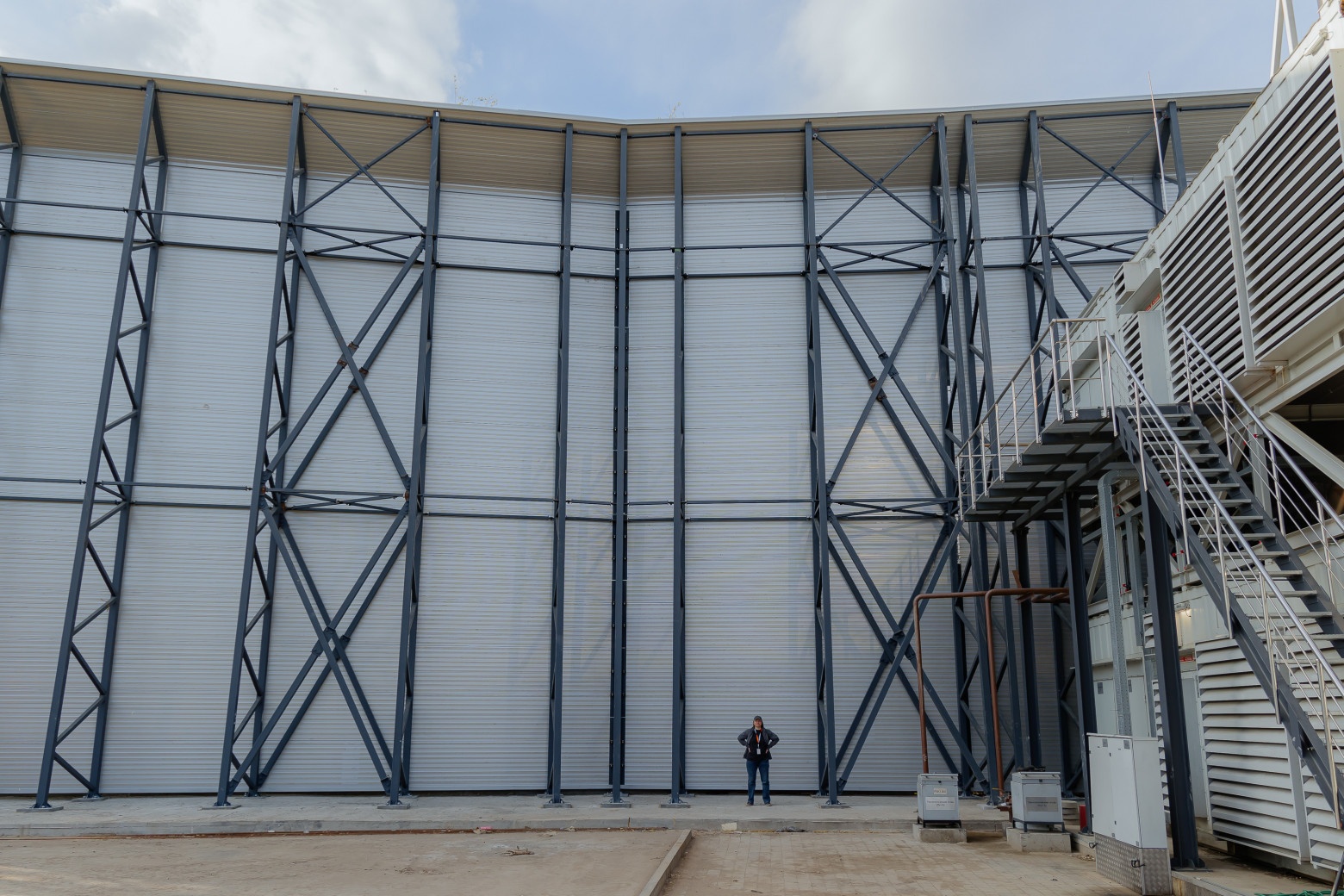

Двухэтажная площадка КДГУ двухэтажная оборудована дополнительными кожухами шумопоглощения и со стороны спальных районов города закрыта 15-метровой шумопоглощающей стеной.

Пожарная безопасность

Пожарная безопасность

В ЦОДе ведется круглосуточный мониторинг, работают система раннего обнаружения продуктов горения (СРОП) и система газового пожаротушения на основе газа хладон-227еа. Общий объем станции газового пожаротушения — 48 тонн. Схема резервирования системы — 2N.

Телеком

В ЦОД выстроена отказоустойчивая сетевая инфраструктура на основе двух независимых волоконно-оптических сетевых вводов. Есть Meet-Me-Roomи восемь отдельных помещений пассивного оптического кросса. Поддерживается сетевой нейтралитет, можно подключать каналы связи любого оператора или использовать ВОЛС РТК-ЦОД.

Дата-центр «Медведково-2» обеспечивает стабильную работу тысяч информационных систем. Вместе с «Медведково-1» ЦОД признан «Кластером ЦОД года» по версии премии «ЦОДы.РФ» 2025 года. Жюри высоко оценило масштаб, соответствие высоким стандартам отказоустойчивости, инновационную архитектуру и надежность кластера.

cloud.rt.ru/registration

cloud.rt.ru/showcase/tariffs

cloud.rt.ru/registration

cloud.rt.ru/showcase/tariffs