История одного десктопного дата-центра

У одних хостингов сложный был год, у меня он был приключенческим (даже остросюжетным). В начале 2023-го мы обустраивали новую локацию на территории оборонного завода. Затем перевозили наши GPU-серверы в неё. Потом учились работать с промышленными UPS, кабель менеджменту, общению с интернет-провайдерами и оказанию техподдержки клиентам. Во второй половине 2023 я развернул бизнес в сторону «выделенных серверов на десктопном железе». Всё равно получились GPU-серверы, просто видеокарты были встроенными в чипсет. Опирался я тогда на нового (теперь уже бывшего) партнёра с приличным финансовым рычагом, а теперь делаю следующий поворот (ниже описываю какой именно).

Примерно на этой ноте заканчивается повествование предыдущей публикации. Благодаря ей, я получил множество откликов из разных уголков земли (от Манчестера и Литвы до Астаны и Находки). За что благодарен всем написавшим. Вот что из всего это я понял.

Вывод №1. По-всему миру множество скучающих ИТ-шников. Кто-то развлекается майнингом, кто-то виртуализацией десктопных видеокарт, кто-то берёт с собой 2-3 макбука по дороге в Россию, а кто-то готов, благодаря моей истории, запустить свой домашний дата-центр в загородном доме с 10G аплинком и 11 кВт электроэнергии. Все очень разные. Поэтому я решил, что нужно фокусироваться на главном, чтобы бизнес продолжал расти.

Из «домашнего дата-центра» в «colocation»

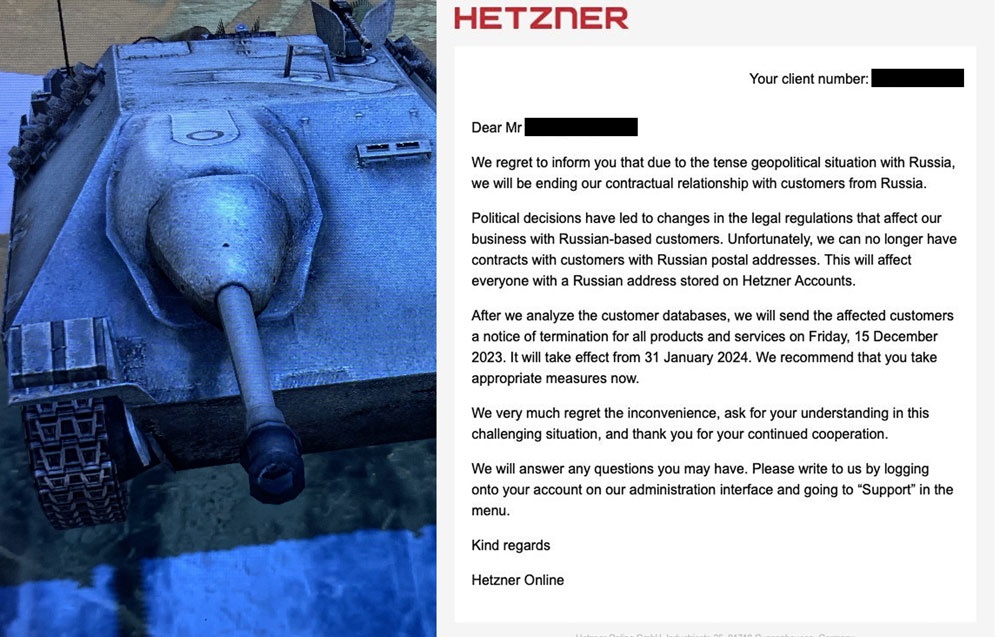

Вывод №2. Из-за санкций и проблем с платежами (в обе стороны США/ЕС ↔ РФ), компании из РФ начали переходить на отечественные хостинги и больше ориентироваться на рынок СНГ. Поэтому решение Хетцнера отказать российским компаниям в обслуживании к концу января, стало триггером для переезда. Прямо сейчас многие компании переезжают на мощности в России, кто-то размещает оборудование у себя в офисе, кто-то арендует серверы у российских хостингов, кому-то оптимальнее разместить собственное оборудование на колокейшн.

Поэтому мы решили сфокусироваться на услуге колокейшна для десктопного железа в 2024 году под новым брендом «ChipDC», чтобы сохранить позиционирование Unit7 как «GPU-серверы». Ну ещё потому, что финансового рычага для закупки оборудования по прежнему нет. Мой бизнес, вопреки западной моде на многомиллионные убыточные стартапы, создаётся на собственные средства, с первых дней прибыльным, и каждый шаг кропотливо выверяется в эксельке. По крайне мере, последние 15 месяцев с момента освоения управленческого учёта.

В «ChipDC» игра слов, «chip»→«cheap» как «недорогой», т.к. в фокусе десктопное железо. Был ещё вариант «Простой Дата-центр» со слоганом «Серверы стоят в Простой, очевидно же», но аура у названия не очень.

Стойки под десктопное железо

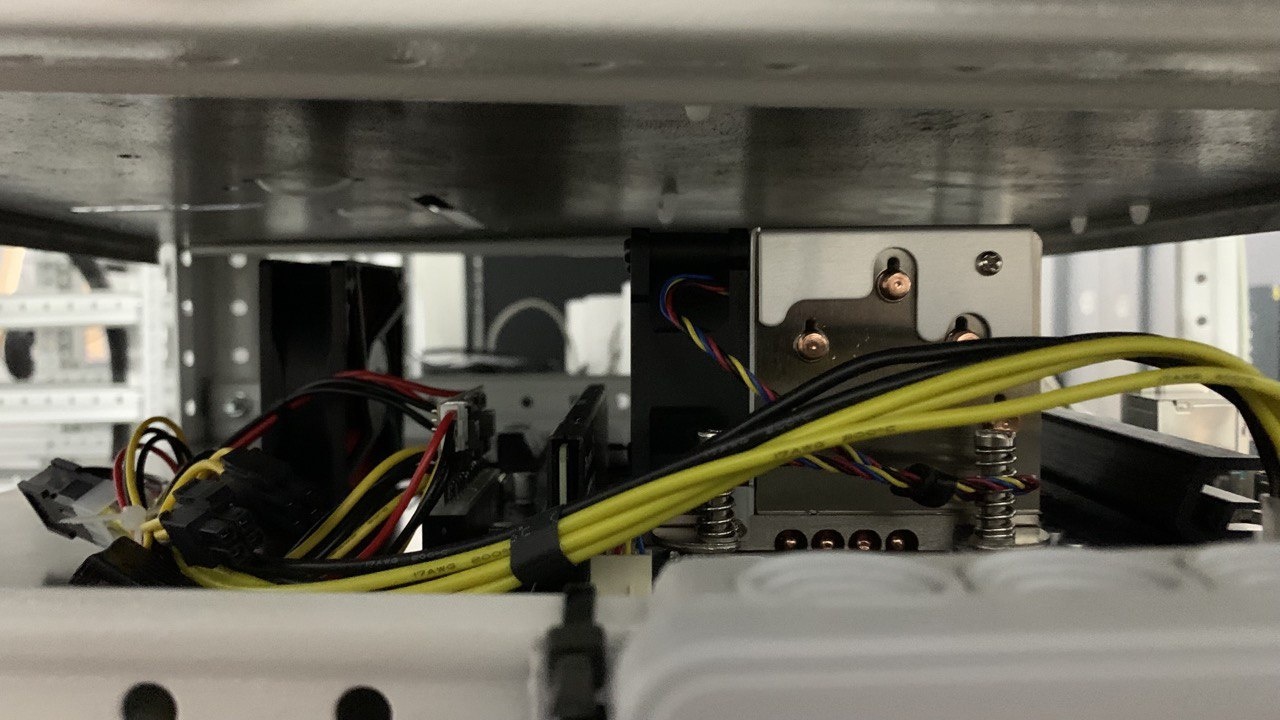

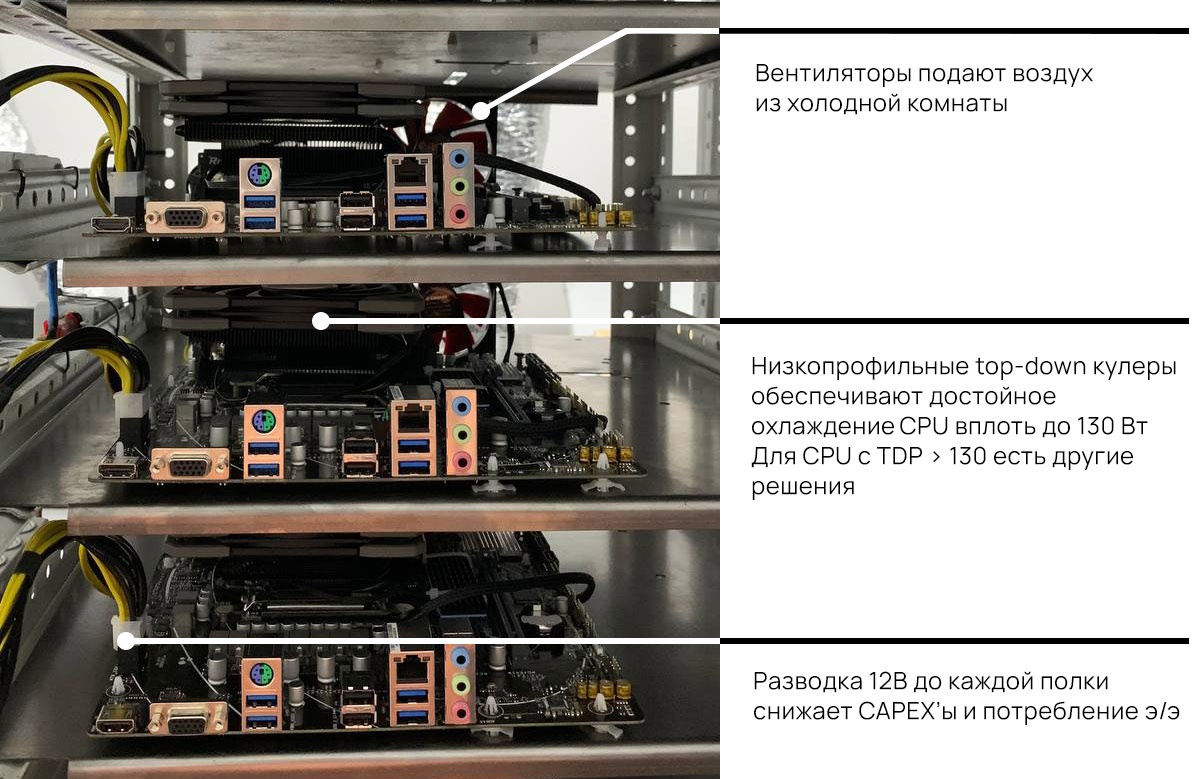

Вывод №3. Стойки для десктопного железа имеют спрос, но отсутствуют в продаже как таковые. Полагаю, дело в том, что обычно десктопное железо размещают в midi-/full-tower корпусах и, если нужно, арендуют место под них. Однако, наш анализ рынка и себестоимости показал, что если размещать десктопное железо плотнее, от этого снижается себестоимость размещения одного сервера и предложение получается интересное. Например, размещение tower сервера в дата-центре уровня Tier II будет стоить от 3500₽/месяц. Наша последняя разработка: стойка высотой 2м и шириной 0.5м вмещающая 24 сервера, блок питания на 3 кВт (можно больше) и коммутатор на 24 порта (да, от стойки в итоге идёт 2 патч-корда). Получается, что цена аренды одного стойко-места (40К₽/месяц) делится на 24 сервера и выходит 1667₽/месяц на сервер. В стойке может быть и 2 активных блока питания, для повышения отказоустойчивости (при желании), и больше. Проводка и прочее держат до 225 Вт на полку. При этом цена аренды сервероместа получается в 2 раза!

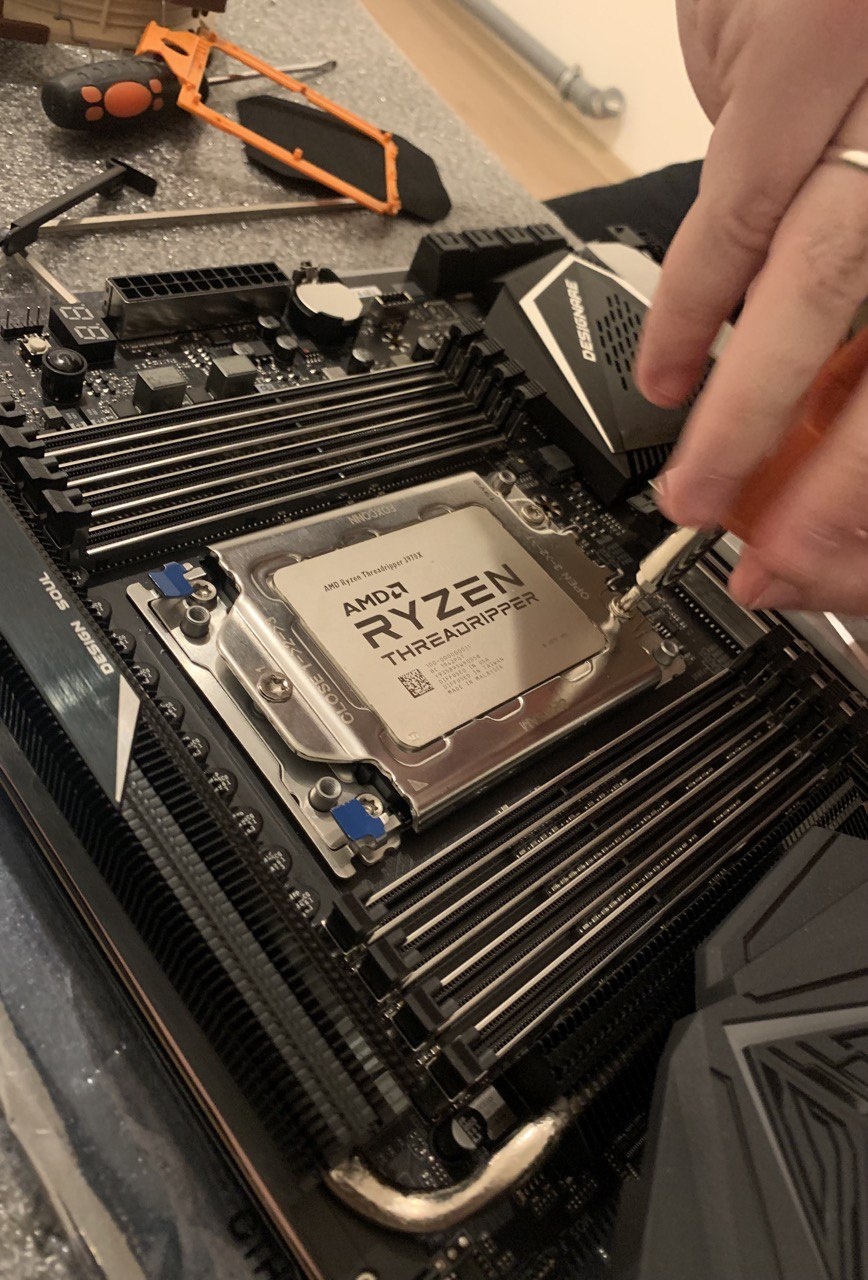

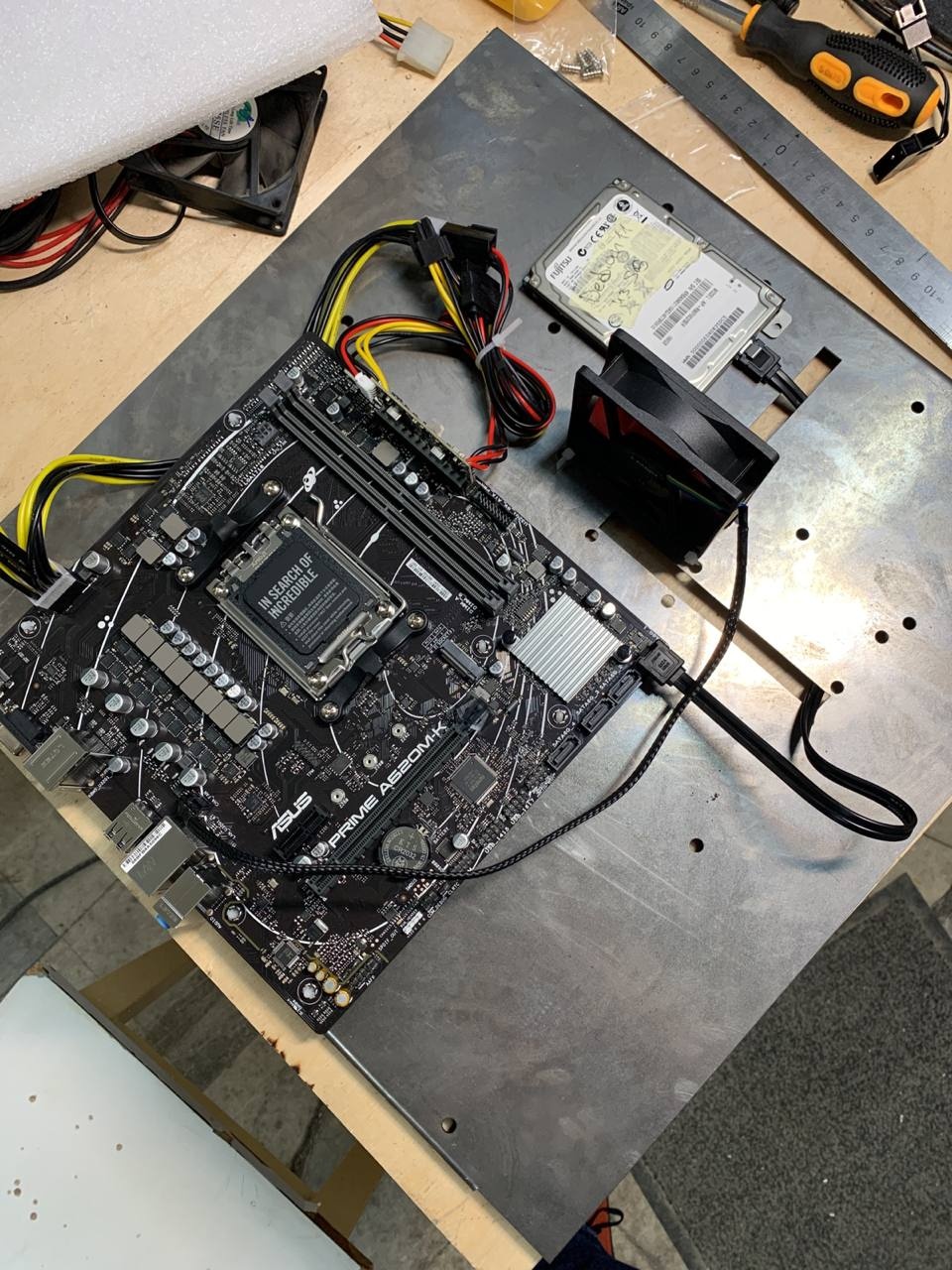

Поэтому, во-первых, я собираю заявки на колокейшн десктопного железа в нашем дата-центре для тех, кому интересно размещаться стойками (т.е. от 24 серверов). С каждым клиентом мы проходим от проектирования и составления сметы, через закупку комплектующих, сборку нашими силами и сдачу заряженных в стойки серверов с доступом через IP KVM.

Во-вторых, готовы делать стойки под заказ и продавать тем, кто хотел бы разместить своё железо у себя в офисе. Разумеется, после согласования проекта. Сейчас цены на производство таких стоек небольшие (делаем из имеющихся запасов), в феврале подскочат (комплектующие у поставщиков уже подорожали).

Стратегия 2024

В последние 5-7 лет в России появилось множество прекрасных технологий в сфере оптимизации расходов на майнинг. В т.ч. оказалось, что можно создавать ЦОДы в формате морских контейнеров (20-40-футовых) с фрикулингом вместо дорогостоящих кондиционеров. При этом, уже давно решены все связанные с этим задачи, вроде фильтрации воздуха, рекуперации, учёта точки росы, взломоустойчивости и т.д. и т.п. Поэтому в 2024 году мы решили запустить ЦОД в 40-футовом контейнере. Говорят, моду задал Газпром, заказывая дизельные электростанции контейнерного типа для разработок своих новых месторождений (в чистом поле).

Во-первых, такой дата-центр будет работать по технологии фрикулинга. Что обеспечит экономию расхода электроэнергии. Рефы про фрикулинг и «Средние температуры воздуха в Санкт-Петербурге» говорят о том, что в СПб возможно обеспечить требуемые в ЦОДе 25 градусов ± 2 в холодной комнате фрикулингом даже в жаркие периоды. При том, что десктопное железо рассчитано на эксплуатацию в более тёплых условиях. С другой стороны, такой подход будет требовать высококлассную работу с фильтрами для очистки воздуха и обеспечением физической безопасности, разумеется.

Во-вторых, так как речь про формат морского контейнера, его можно будет транспортировать (хоть грузовиком, хоть грузовым вертолётом) и устанавливать в нестандартных местах. Главные критерии здесь: наличие высокоскоростного интернета и свободной электроэнергии в локации. Это может быть даже крыша здания в какой-нибудь промзоне (там есть доступная э/э), если вывести кабель на 80-100 кВт. Хотя этот вариант близкий к экстремальному, есть компании, которым он может подойти.

Итогошечки

В 2024-м мы решили сфокусироваться на услуге колокейшна. В начале дозаполнить стойками текущую локацию (здесь места осталось на 14 стоек нашего формата), а затем расширяться контейнерами с фрикулингом. Это должно дать не только быстрый рост (в сравнении с ремонтом и обустройством помещений), но и снижение себестоимости, а значит, и цены для клиентов.

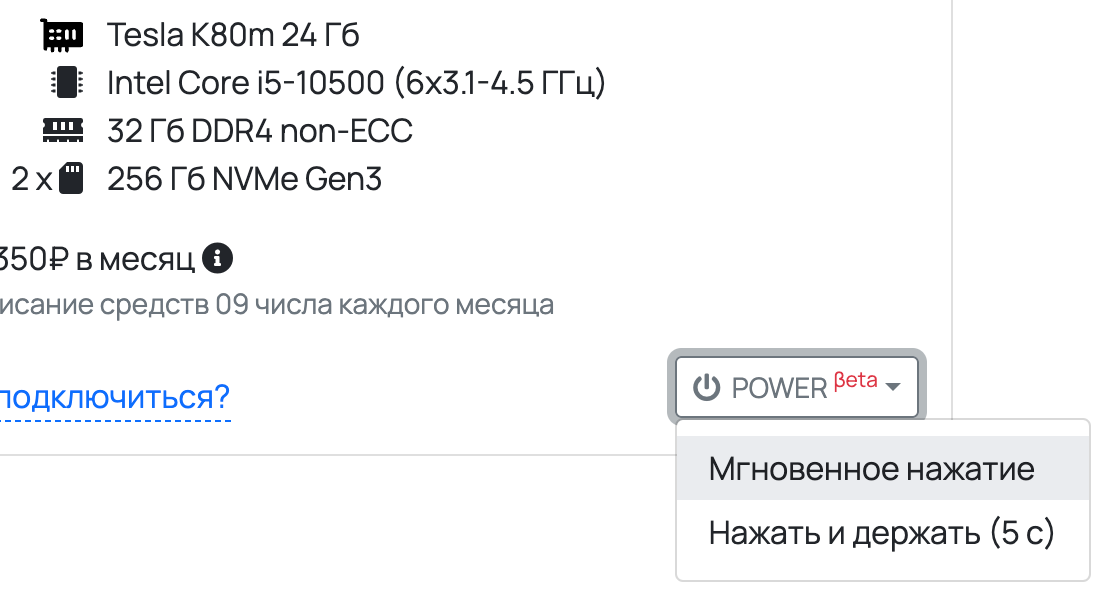

У нас есть дата‑центр Unit7 с собственными вычислительными ресурсами (хостинг). Но новая стратегия не означает распродажи материальных активов. Просто Unit7 получился основным бизнес‑кейсом, в нём мы обкатываем последние наработки, собираем (и исправляем) косяки. Мы голосуем собственными вычислительными ресурсами, чтобы затем давать клиентам качественные технологии. Именно на Unit7 сейчас работает первая созданная нами стойка для десктопного железа. И именно серверы Unit7 будут первыми размещены в контейнерном мини‑ЦОДе.

chipdc.ru

unit7.ru