31 марта 2025 NVIDIA выпускает коммутатор Silicon Photonics CPO

31 марта 2025 NVIDIA выпускает коммутатор Silicon Photonics CPO

На конференции GTC 2025 компания NVIDIA представила кремниевые фотонные сетевые коммутаторы NVIDIA Spectrum-X (на основе стандарта Ethernet) и NVIDIA Quantum-X (на основе стандарта InfiniBand), которые позволяют фабрикам искусственного интеллекта подключать миллионы графических процессоров по всему миру, значительно сокращая при этом потребление энергии и эксплуатационные расходы.

26 марта 2025 FiberMall запускает жидкостно-охлаждаемые оптические модули и AOC, способствующие экологичному и эффективному подключению центров обработки данных

FiberMall, мировой лидер в области решений для оптической связи, сегодня официально объявила о запуске нескольких жидкостно-охлаждаемых оптических модулей и активных оптических кабелей (AOC), охватывающих скорости передачи данных от 10G до 200G. Эта новая линейка продуктов включает в себя ключевые модели, такие как 10G SFP+, 25G SFP28, 100G QSFP28, 200G SFP56, 400G QSFP112, 400G OSFP и 800G OSFP, представляющие собой значительный прогресс в высокопроизводительных, энергоэффективных межсоединениях центров обработки данных. Это нововведение призвано помочь глобальным клиентам решать проблемы, связанные с рассеиванием тепла и энергоэффективностью в сценариях высокоплотных вычислений.

19 марта 2025 Закон масштабирования неправильно понят, NVIDIA запускает Blackwell & Rubin

19 марта 2025 Закон масштабирования неправильно понят, NVIDIA запускает Blackwell & Rubin

1. Blackwell GPU выходит на полную мощность

2. Blackwell NVLink 72 с программным обеспечением Dynamo AI

3. Ежегодная дорожная карта NVIDIA для инфраструктуры ИИ

17 февраля 2025 Взгляд на DeepSeek и новую эру ИИ

Нет сомнений, что DeepSeek превзошел Meta Llama, но он все еще сильно отстает от игроков первого эшелона, таких как OpenAI, Anthropic и Google. Например, Gemini 2.0 Flash, мощный и полностью модальный, стоит дешевле DeepSeek. Внешний мир недооценивает возможности игроков первого эшелона, представленных Gemini 2.0, исходный код которого не был открыт для достижения сенсационного эффекта.

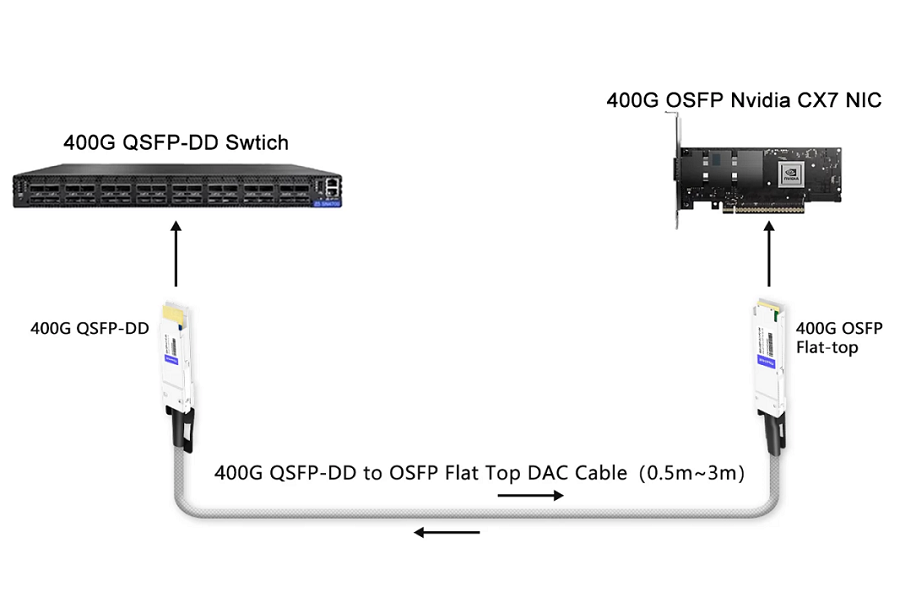

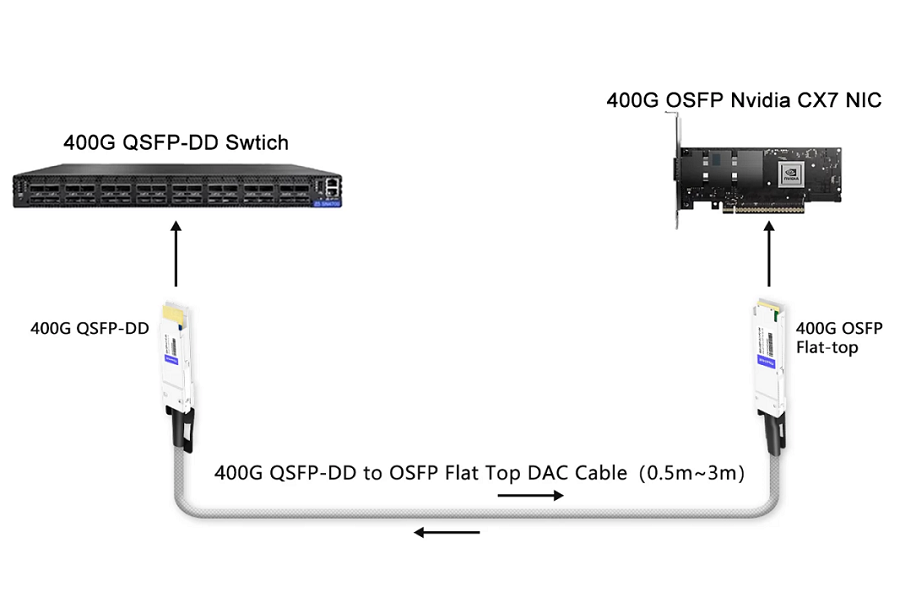

9 января 2025 FiberMall объявляет о массовом производстве кабелей 400G QSFP-DD to OSFP Flat Top DAC для соединений коммутатора 400G с сетевыми картами 400G

8 января 2025 Влияние активных электрических кабелей (AEC) на замену оптических модулей

8 января 2025 Влияние активных электрических кабелей (AEC) на замену оптических модулей

AWS: Ожидается, что наибольший вклад в рост внесет AWS: к концу этого и следующему году будет продано более 2 миллионов устройств.

Microsoft: Поступательный рост остается стабильным, в основном в сфере облачных вычислений и некоторых сетей ИИ.

X.AI: переживает быстрый рост, потенциально требуя 800,000 900,000–XNUMX XNUMX единиц в год.

Google/NVIDIA: Планируются только незначительные обновления.

Китайские Alibaba, ByteDance и т. д.: постепенное увеличение популярности, способствующее общей тенденции к росту.

7 января 2025 Nvidia инвестирует в AyarLabs

В эти дни все говорят о том, что Nvidia, AMD и Intel инвестировали в фабрику, чтобы положить конец медным соединениям. Фактически, Ayarlabs была основана давно, и Intel долгое время была одним из ее инвесторов. Новым является присоединение NVIDIA.

17 декабря 2024 Уведомление об обновлении логотипа

Мы рады сообщить вам о значительном обновлении нашего фирменного стиля. Fiber Mall с гордостью представляет наш новый логотип, который органично сочетает название нашего бренда с динамичным изображением света, проходящего через оптоволокно.

Старый

28 июня 2024 Набор USB4 AOC от FiberMall для массового производства

28 июня 2024 Набор USB4 AOC от FiberMall для массового производства

Поскольку тенденция к использованию изображений с высоким разрешением 4K и 8K сохраняется, а также увеличивается размер файлов данных, потребность в высокоскоростной передаче остается острой. USB4, который поддерживает скорость двунаправленной передачи данных до 40 Гбит/с (в два раза выше скорости USB 3.2), готов стать звездой завтрашнего дня. Однако традиционные медные пассивные USB-кабели сталкиваются с ограничениями из-за импеданса и повышенных потерь, вызванных скин-эффектом. Для таких приложений, как подключение проекций с большим экраном, игр или носимых устройств AR, пассивные медные кабели USB0.8 длиной 3–4 метра не подходят. Даже активные медные кабели, хотя и более гибкие по длине, стоят дороже.

21 мая 2024 Nvidia начинает глобальное развертывание CUDA-Q

21 мая 2024 Nvidia начинает глобальное развертывание CUDA-Q

Nvidia подробно рассказала, как ее чипы ускоряют инновации в индустрии высокопроизводительных вычислений (HPC), особенно в системах на базе искусственного интеллекта, которые будут способствовать научному прогрессу с помощью суперкомпьютеров.

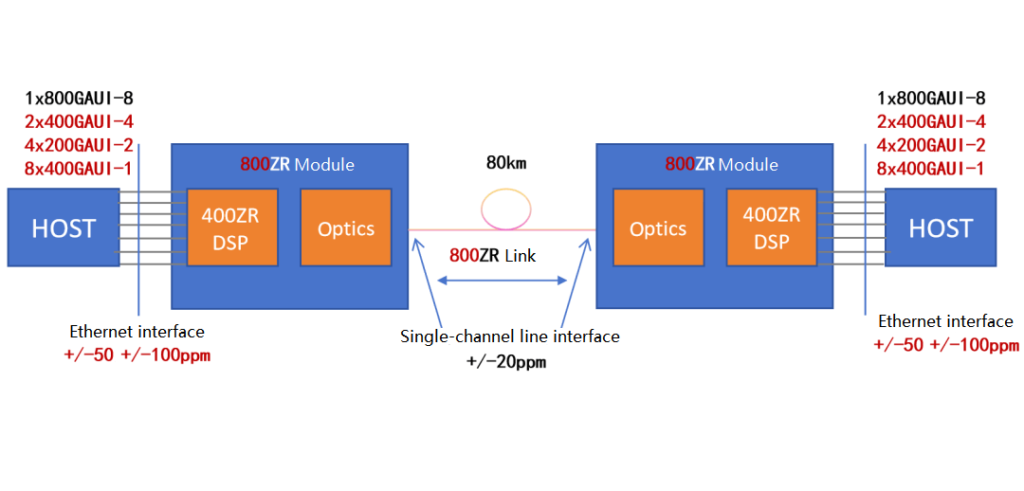

17 мая 2024 OFC 2024: Демонстрация совместимости 400G ZR и 800G ZR

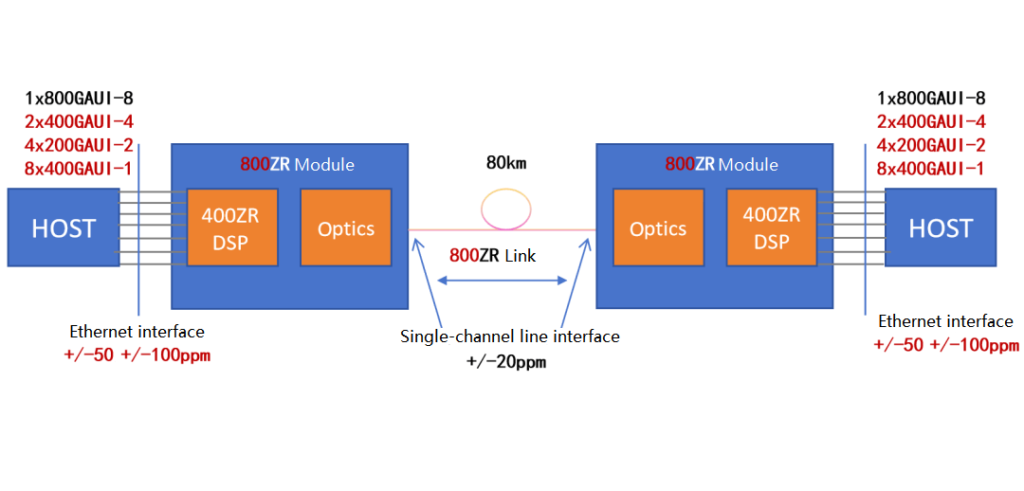

На конференции OFC в этом году несколько поставщиков продемонстрировали применение технологий 400G ZR, 800G ZR и 400G ZR+ в межсоединениях центров обработки данных (DCI) и телекоммуникационных сетях.

20 марта 2024 Представлен графический процессор Nvidia B200: энергопотребление достигает 1000 Вт

20 марта 2024 Представлен графический процессор Nvidia B200: энергопотребление достигает 1000 Вт

Dell раскрывает AI-чип Blackwell следующего поколения от Nvidia: B100 будет выпущен в 2024 году, B200 — в 2025 году.

18 марта 2024 NVIDIA представляет графический процессор Blackwell B200, коммутатор Quantum-X800 Q3400 InfiniBand, ConnectX-8 SuperNIC

Пять лет спустя всемирно известное мероприятие в области компьютерных технологий искусственного интеллекта, ежегодная конференция NVIDIA GTC, значительно вернулось в очный формат. Сегодня основатель и генеральный директор NVIDIA Дженсен Хуанг выступил с двухчасовой программной речью, представив новейший революционный чип искусственного интеллекта — графический процессор Blackwell.

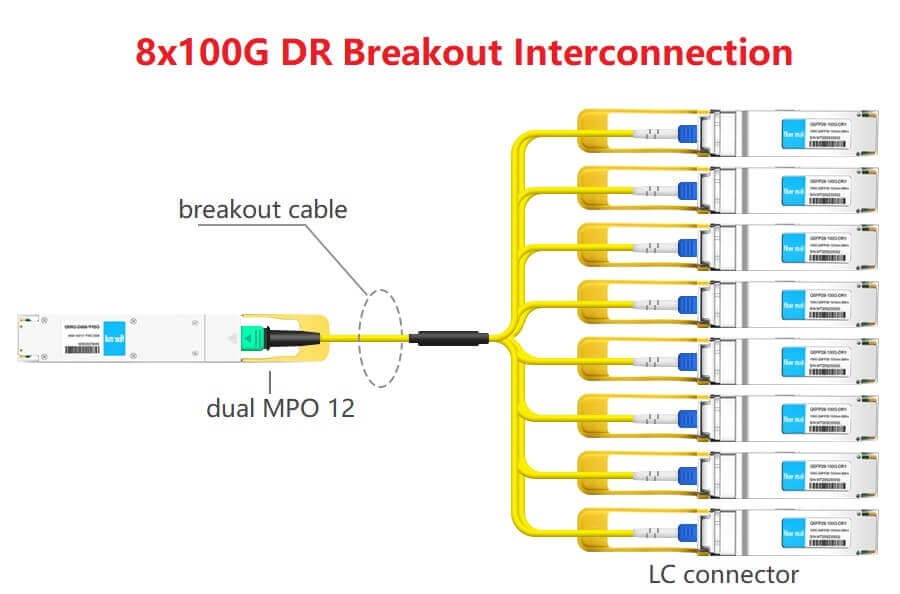

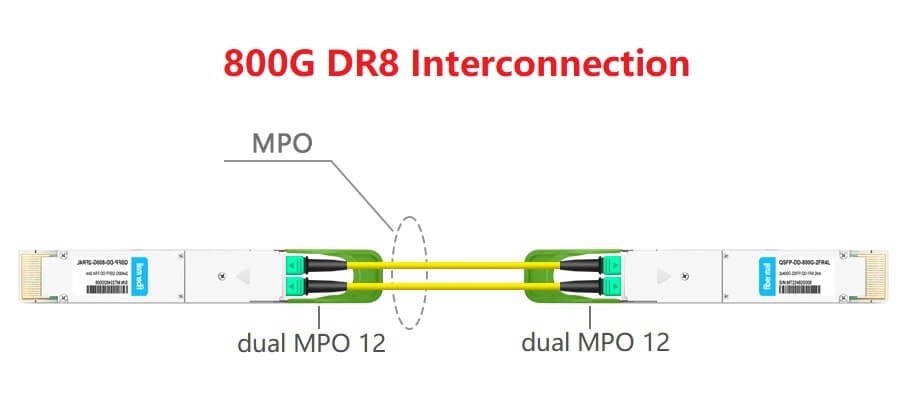

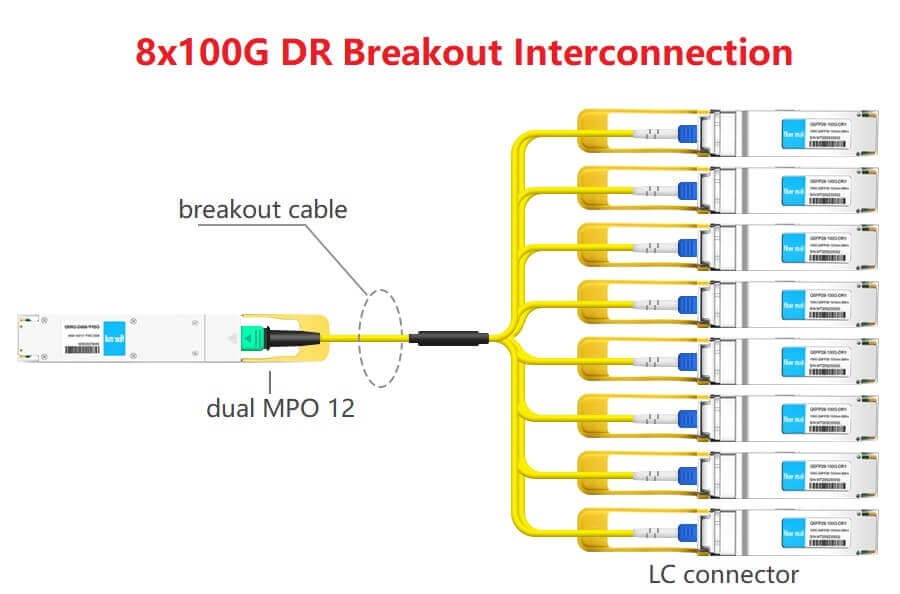

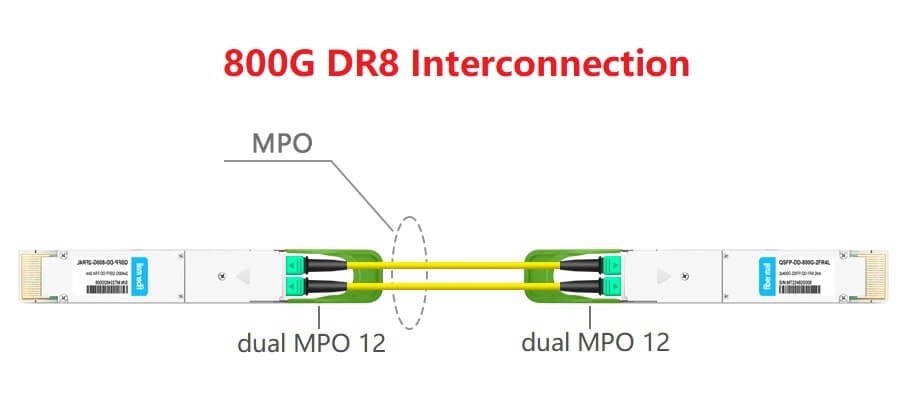

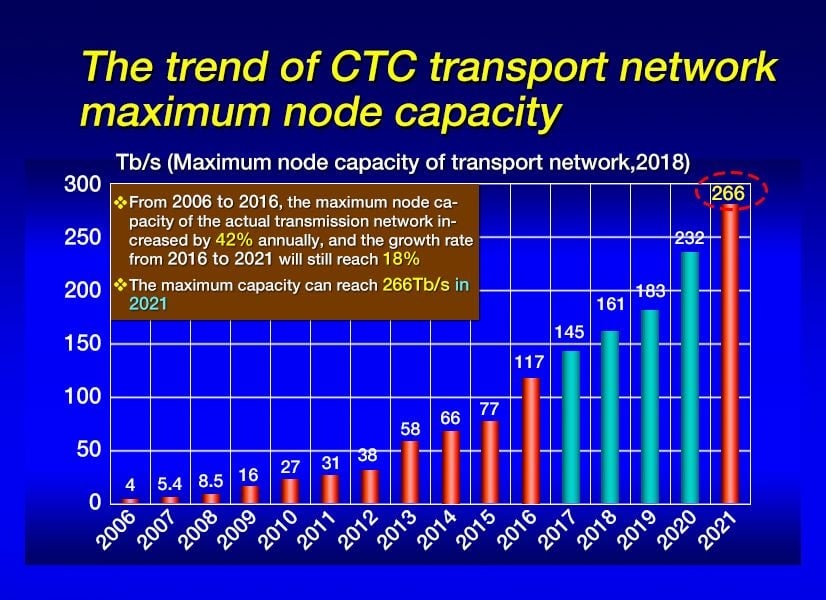

7 декабря 2023 Технология 800G переопределяет сетевую среду

Первая партия коммутаторов с портами 800G вышла на рынок, что позволяет поставщикам услуг продолжать оценивать возможности и планировать развертывание. Выпущены клиентские оптические модули 800G, поддерживающие два соединения 400GE или восемь соединений 100GE, а версия 800GE будет представлена по мере развития стандартов. Технологическое развитие 400G упрощает переход на 800G, позволяя использовать оптические модули двойной плотности и разветвленные схемы подключения.

6 декабря 2023 FiberMall выпускает когерентную сеть 100G DWDM QSFP28 DCO ZR

6 декабря 2023 FiberMall выпускает когерентную сеть 100G DWDM QSFP28 DCO ZR

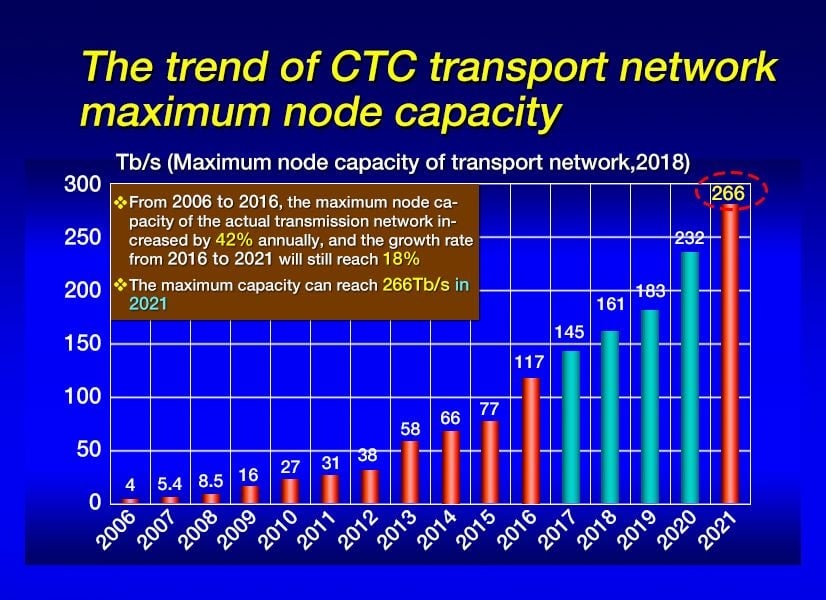

Чтобы справиться с непрекращающимся ростом трафика данных, сетевые операторы вынуждены расширять свои сети агрегации периферийных устройств для поддержки скорости 100 Гбит/с. Этот переход часто влечет за собой значительные расходы и сложности. Необходимо найти оптимизированное и экономичное решение, позволяющее проводить модернизацию без необходимости отказываться от существующего оборудования. Наш подключаемый трансивер Coherent 100G DWDM QSFP28 DCO ZR с экономичной и энергоэффективной конструкцией QSFP28 легко интегрируется в существующие головные устройства. Эта интеграция способствует беспрепятственному внедрению когерентной технологии 100 Гбит/с на периферии сети, устраняя необходимость существенных изменений в существующей структуре и сохраняя при этом доступность.

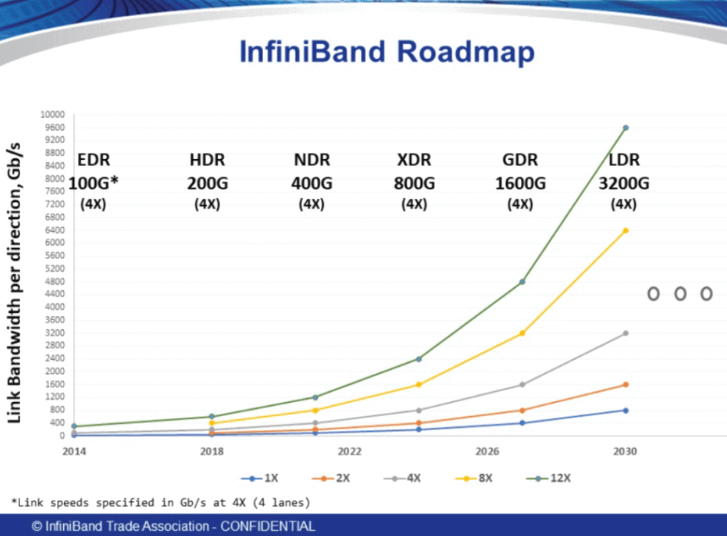

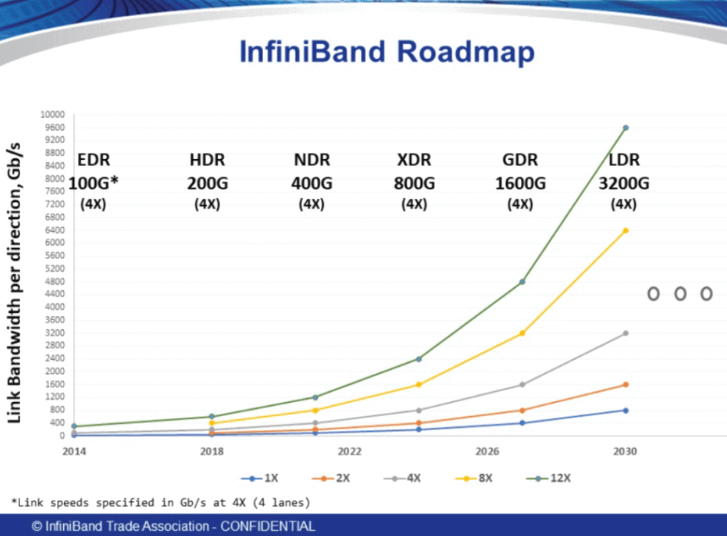

16 ноября 2023 IBTA представляет спецификацию XDR (800G) InfiniBand

IBTA запускает спецификацию XDR InfiniBand, обеспечивающую беспрецедентную скорость подключения к серверам и хранилищам со скоростью 800 Гбит/с для следующего поколения искусственного интеллекта и научных вычислений, а также дальнейшее расширение возможностей инфраструктуры искусственного интеллекта и высокопроизводительных вычислений.

16 мая 2023 Высокоскоростное оборудование FSO прошло испытания на реке

16 мая 2023 Высокоскоростное оборудование FSO прошло испытания на реке

Во второй половине дня 27 апреля 2023 года компания FiberMall успешно завершила тестовый эксперимент по передаче через реку своего высокоскоростного оборудования беспроводной лазерной связи со скоростью 10 Гбит/с. Технический персонал FiberMall быстро настроил двустороннюю связь и мигрировал коммуникационное оборудование, обеспечив передачу аудио и видео высокой четкости в режиме реального времени с малой задержкой. Этот эксперимент подтвердил отличные характеристики беспроводного лазерного коммуникационного оборудования FiberMall с точки зрения портативности, быстрого развертывания, простоты эксплуатации и коммуникационных возможностей, что соответствует критериям приемки.

9 марта 2023 Marvell представляет 5-нм 800G PAM4 DSP

Взгляд Marvell на следующее поколение когерентных DSP 800G и согласование алгоритмов преследует общую цель снижения энергопотребления, улучшения целостности сигнала и уменьшения размера. Уменьшение масштаба процесса узла полевого МОП-транзистора и повышение точности — это традиционный путь оптимизации.

Marvell занимает доминирующее положение в PAM4 DSP с выпуском 400G PAM4 на базе 7-нм чипа DSP в 2020 году и его обновленной версии в конце этого года. На прошлой неделе Marvell представила 5-нм 800G PAM4 DSP. 800G с 5-нм DSP будет потреблять около 13-14 Вт энергии в оптическом модуле.

7 марта 2023 Fiber Mall запускает 100G QSFP28 ZR4 BIDI

Чтобы удовлетворить потребность в передаче на большие расстояния в условиях дефицита волоконных ресурсов в сетях с граничным доступом, FiberMall запускает продукты 100G QSFP28 ZR4 BIDI и продемонстрирует двунаправленную передачу услуг по одному волокну на 100 км на 80G. Это еще один первый в отрасли продукт FiberMall после дебюта промышленного оптического модуля 100G QSFP28 4WDM-20 BIDI в 2020 году, который был единодушно признан рынком.

25 октября 2022 Cisco представляет новые коммутаторы 800G

Новые продукты Cisco включают коммутаторы Nexus 9232E и 8111, оба из которых основаны на чипе Cisco Silicon One G100 и поддерживают коммутационную способность 25.6 Тб. Основное различие между этими двумя продуктами заключается в разнице в программном обеспечении: Nexus предназначен для пользователей телекоммуникационных, корпоративных и других интегрированных решений, а серия 8000 больше подходит для приложений стекирования суперцентров обработки данных.

20 сентября, 2022 Как разрабатывался и производился 50G PAM4 VCSEL?

20 сентября, 2022 Как разрабатывался и производился 50G PAM4 VCSEL?

Заместитель генерального директора компании по исследованиям и разработкам VCSEL сообщил FiberMall, что в 2020 году компания осуществила переход от этапа исследований и разработок продукта к коммерческому использованию, при этом инвестиции в исследования и разработки составили более 40 миллионов юаней. В начале 2021 года был построен и введен в эксплуатацию новый цех, и компания продолжает поддерживать высокую интенсивность инвестиций в НИОКР. Общая площадь компании составляет 10,000 5,000 квадратных метров, в том числе 4 150,000 квадратных метров передовых производственных цехов. Основное оборудование запущено в круглосуточную производственную эксплуатацию после отладки и проверки. Компания построила две XNUMX-дюймовые линии по производству арсенида галлия с проектной производительностью более XNUMX XNUMX штук в сутки.

13 сентября, 2022 Fiber Mall объявляет о выпуске высокопроизводительного оптического приемопередатчика 400G DR4 Silicon Photonics

Компания FiberMall выпустила высокопроизводительный кремниевый оптический трансивер DR400 4G DR400. Решение использует кремниевый фотонный чип в сочетании с недорогим пакетом COB, оптимизированной конструкцией целостности высокочастотного и силового сигнала, эффективно решая проблемы корпуса оптического приемопередатчика кремниевой фотоники и фотоэлектрических перекрестных помех, чтобы достичь лидирующей в отрасли производительности кремниевой фотоники 4G DR400. приемопередающие решения. Решение будет продемонстрировано на выставке CIOE в Шэньчжэне. Для кремниевых фотонных оптических чипов компании клиенты могут открывать технологические решения модулей XNUMXG и предоставлять услуги OEM для оптических двигателей.

Fiber Mall открыл канал передачи 4x100G DWDM QSFP28 BIDI

Июль 12, 2022 Проект трансивера Fiber Mall Silicon Photonics

Июль 12, 2022 Проект трансивера Fiber Mall Silicon Photonics

Проект приемопередатчика кремниевой фотоники FiberMall направлен на независимые исследования, разработку и инновации технологии оптических чипов и сосредоточен вокруг отрасли оптической связи. Его основной бизнес охватывает проектирование, упаковку и тестирование оптических чипов. FiberMall стремится продвигать комплексное отраслевое решение оптических двигателей. Его основная продукция охватывает микросхемы и компоненты WDM на основе AWG (решетчатой волноводной решетки) 40G / 100G / 400G / 800G, кремниевые фотонные микросхемы выше 400G, микросхемы модуляции DSP и демодуляции.

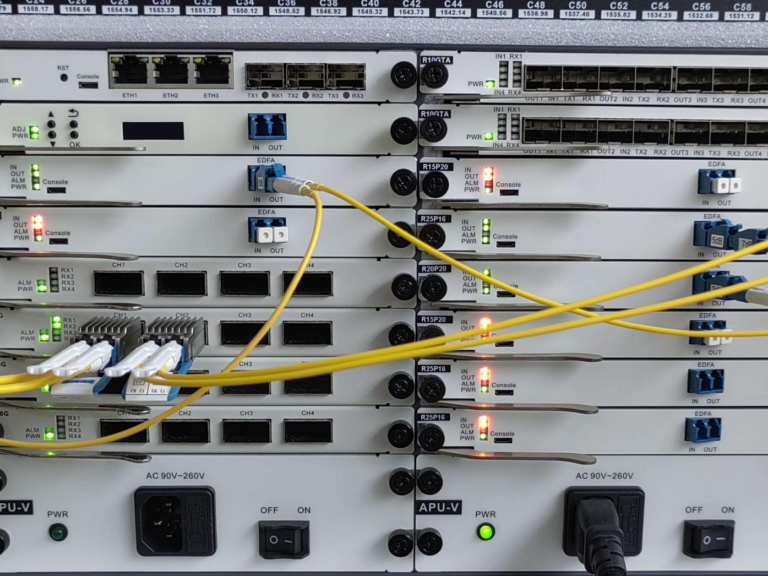

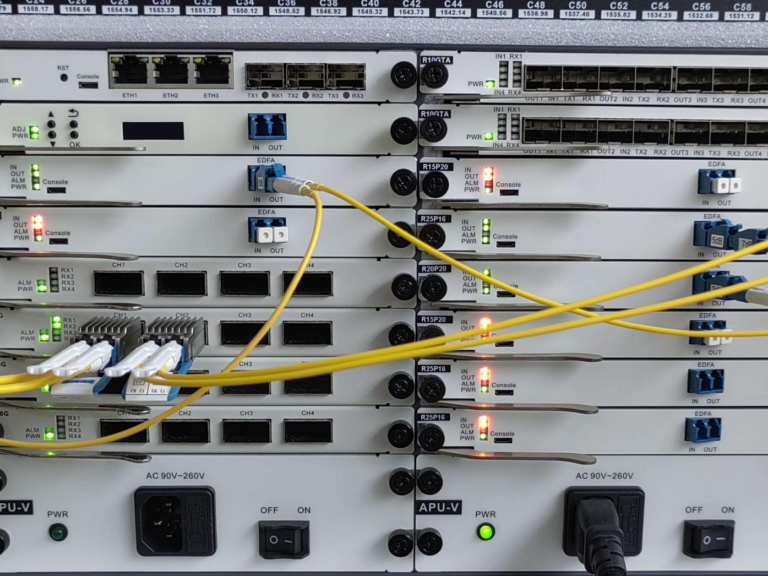

24 мая 2022 Fiber Mall анонсировала мукспондер от 4x100G QSFP28 до 1x400G QSFP-DD Muxponder

Недавно FiberMall, ведущий поставщик оптических сетевых решений, объявил о выпуске мукспондера 4Q28-QDD-400G для уровня агрегации 100G систем 400G DWDM. Этот продукт обеспечивает простоту эксплуатации, экономичность и низкую задержку для сетевых операторов при развертывании в городских сетях.

4Q28-QDD-400G — это мукспондер со спецификациями уровня 1 и OpenZR+, который поддерживает четыре клиентских канала 100G и линейные интерфейсы 400G. Это дает сетевым операторам возможность развертывать системы DWDM 100G, 200G, 300G или 400G.

24 апреля 2022 Рынок оборудования доступа PON превысит 16 миллиардов долларов к 2027 году

Согласно последнему прогнозному отчету исследовательской компании Omdia по оптоволокну и медному доступу, мировой рынок оборудования доступа PON будет расти со среднегодовым темпом роста (CAGR) 12.3% в период с 2020 по 2027 год с ожидаемой выручкой в размере 16.3 млрд долларов к 2027 году. оборудование. Технология PON будет по-прежнему использоваться для поддержки FTTH, но ее роль для многих операторов будет меняться.

22 апреля 2022 Оптический трансивер 100G QSFP28 BIDI на 20 км запущен компанией Fiber Mall

Исходя из этого, компания FiberMall создала пакетный продукт QSFP28, который не только адаптируется к температуре наружного воздуха, но и экономит ресурсы оптоволокна — оптический трансивер 100G QSFP28 BIDI. По сравнению с обычным оптическим приемопередатчиком 100G QSFP28, это решение экономит 50% ресурсов оптоволокна и может широко использоваться в области телекоммуникаций, центров обработки данных и беспроводной связи.

- КСФП28-100Г23-БС20 100G QSFP28 BIDI трансивер, TX1280 нм/RX1310 нм, симплексный LC, 20 км, -20~+85℃, с DDM

- КСФП28-100Г32-БС20 100G QSFP28 BIDI трансивер, TX1310 нм/RX1280 нм, симплексный LC, 20 км, -20~+85℃, с DDM

17 марта 2022 Broadcom 100G PAM4 DSP помогает применять модуль 400G

На недавней выставке OFC 2022 компания Broadcom продемонстрировала свой оптический чип физического уровня PAM100 DSP (цифровой сигнальный процессор) со скоростью 4 Гбит/с на канал BCM87412, который разработан на основе 7-нанометрового CMOS-процесса и объединяет трансимпедансный усилитель (TIA) и лазерный драйвер с большим размахом. (драйвер) и оптимизирован для применения модуля 400G DR4/FR4. BCM87412 также обладает ведущими в отрасли функциями FEC, предоставляя рынку беспрецедентное конкурентное преимущество.

25 февраля 2022 Когерентный трансивер 400G ZR/ZR+ запущен компанией Fiber Mall в 2022 году

Недавно компания FiberMall запустила решение DWDM с использованием когерентного трансивера QSFP-DD-400G-DCO-ZR/ZR+. Это решение напрямую вставляет когерентные приемопередатчики 400G ZR/ZR+ в коммутатор и реализует DWDM-передачу DCI через передачу на оптическом уровне. Внедрение этого решения поможет снизить сложность сети при соединении центров обработки данных (DCI), повысить надежность системы передачи, реализовать передачу с большой пропускной способностью, а также снизить энергопотребление и стоимость системы.

15 октября 2021 Как эти страны развивают 5G в условиях кризиса COVID-19?

Однако для мировой индустрии 5G 2020 год не ознаменовал ожидаемого «взрыва 5G» радости, а, скорее, нанес серьезный удар со стороны предложения и потребления в связи с глобальной вспышкой COVID-19. В результате эпидемии глобальное развертывание 5G было значительно отложено.

13 октября 2021 Дефицит чипов продолжает влиять на рынок оптических устройств

В отчете об исследовании, опубликованном компанией LightCounting, занимающейся исследованием рынка оптических коммуникаций, говорится, что расходы поставщиков облачных услуг и ICP продолжали расти быстрыми темпами во втором квартале 2021 года. Кроме того, западные CSP также продемонстрировали сильный рост доходов по сравнению с за тот же период в 2020 году при росте закупок оборудования на квартал. Это также отражается на высоких показателях многих поставщиков оптических устройств. Существует высокий спрос на сопутствующие товары, в том числе на 400G КСФП-ДД оптические трансиверы, когерентный модуль, ROADM, лазер накачки и чип 3D-датчика.

12 октября 2021 Оптический трансивер 800G появится на рынке в 2022 году

По прогнозу Omdia, переход от 100G к 400G официально начнется в 2022 году, когда спрос на 100G начнет снижаться, а 400G начнет набирать обороты. Таким образом, из ритма выпуска отраслевой цепочки, время коммерциализации Оптический трансивер 800G будет 2022 г., а крупномасштабное развертывание — 2023 г.

11 октября 2021 Fiber Mall запустил оптический трансивер 50G SFP56 FR LR для беспроводной сети

11 октября 2021 Fiber Mall запустил оптический трансивер 50G SFP56 FR LR для беспроводной сети

Накануне 2021 Китайская международная выставка оптоэлектроники (CIOE)Компания FiberMall, ведущий мировой производитель оптических модулей связи, объявила об официальном запуске трансиверов 50G SFP56 FR/LR для приложений передачи данных 5G Fronthaul и проведет ПРЯМУЮ демонстрацию производительности продукта на выставке CIOE 2021.

В настоящее время fronthaul передача при агрегации с двумя несущими в основном 2x25G, но с совместным прогрессом технологий и производственной цепочки спрос на одноканальные оптические модули 50G скоро созреет. Поэтому компания FiberMall выпустила оптические модули серии FR/LR 50G SFP56 для приложений беспроводной сети.

2 июня 2021 Fiber Mall приступил к массовому производству оптических модулей 400G QSFP-DD

Чтобы соответствовать постоянному росту пропускной способности сети и обеспечить плавный переход сетевой архитектуры, в первом квартале 1 года компания FiberMall успешно выпустила оптические трансиверы, которые можно применять в центрах обработки данных следующего поколения: 400G КСФП-ДД SR8 и 400G QSFP-DD AOC. В этой серии продуктов используется высокоточная технология упаковки Chip-on-Board (COB), которая обеспечивает решение нового поколения с более низкой стоимостью и энергопотреблением, более высокой плотностью и скоростью для масштабирования центров обработки данных. Оптические модули 400G QSFP-DD SR8/AOC были массово произведены компанией FiberMall в первом квартале 1 года. После этого, в течение 2019–2019 годов, FiberMall последовательно запускала оптические модули 2021G QSFP-DD FR400/DR4 и предоставляет большой объем для интернет-клиентов. Оптические модули 4G QSFP-DD DR400/FR4 можно было отгружать оптом в первом квартале 4 года, что означает, что продукты полной серии 1G от FiberMall перешли на стадию массового производства.

9 апреля 2021 Спрос на оптический трансивер 400G QSFP-DD вырастет в 2021 году

Согласно последним ежеквартальным отчетам поставщиков полупроводников, оптических компонентов и компаний, занимающихся облачными вычислениями, рынок оптики получит хороший старт в 2021 году. Благодаря высокому спросу со стороны компаний, занимающихся облачными вычислениями, таких как Amazon, рынок оптических трансиверов, особенно 400G. Ожидается, что в 2021 году рынок приемопередатчиков будет расти.

9 апреля 2021 AT&T представляет стратегию развертывания сетей 5G и FTTP

AT & T объявил в случае аналитика, что это wУальд инвестировать 6-8 миллиардов долларов США в период с 2022 по 2024 год для использования своего нового IF группаширина Спектр C-диапазона для предоставления услуг 5G для 70-75 млн человек к 2022 году и 100 млн человек к началу 2023 г. Но эти цели отстают от целей, ранее озвученных Verizon и T-Mobile на аналитических мероприятиях.

9 апреля 2021 Fiber Mall представляет модуль приемопередатчика QSFP200 FR56 4G

Быстрое развитие больших данных, облачных вычислений, искусственного интеллекта и 5G Internet of Everything (IOE) привело к увеличению объемов данных в центрах обработки данных, мотивируя итеративное обновление оптических модулей. В настоящее время архитектура центра обработки данных постепенно переходит в эру 200G / 400G. По сравнению с низкоскоростной 100 Гбит / с и высокой ценой 400 Гбит / с, 200 Гбит / с является более экономичным решением для межсоединений центров обработки данных.

Благодаря многолетнему опыту работы в области оптических приемопередатчиков для центров обработки данных компания FiberMall преуспела в конкуренции и вызовах, а поставка оптических модулей 100G CWDM4 и PSM4 возглавляет мировой рейтинг. Этот недавно появившийся оптоволоконный модуль 200G FR4 принесет клиентам совершенно новый и лучший опыт работы с продуктом.

9 апреля 2021 Выпущена серия оптических трансиверов Fiber Mall 25G SFP28 WDM

Компания FiberMall выпустила полную серию приемопередатчиков 25G SFP28 с независимыми правами на интеллектуальную собственность, чтобы удовлетворить растущий спрос на сети со стороны операторов интернет-услуг. Это семейство оптических модулей SFP28 25G включает 25G SFP28 DWDM, 25G CWDM, 25G SFP28 LWDM и 25G MWDM.

9 апреля 2021 FTTH | Telecom Italia пробует XGS-PON

Недавно Telecom Italia (TIM) реализовала свой первый сверхширокополосный FTTH (Fiber to the Home) со скоростью передачи данных 10 Гбит / с, укрепив свое лидерство в области инноваций и развития сетей и услуг следующего поколения. Итальянское телерадио «Amici» первым в Италии применило эту сверхбыструю технологию XGS-PON для соединения FTTH. В частности, XGS-PON работает в симметричной системе со скоростью 10 Гбит / с в нисходящем направлении (от поставщика к клиенту) и 10 Гбит / с в восходящем направлении.

24 февраля 2021 Завершился корпоративный отдых Fiber Mall в загородном клубе Mission Hills!

Все сотрудники FiberMall отправились в клуб Fenghuo Country Tribe в Shenzhen Mission Hills Golf. & 16 января Country Club проведет общественные мероприятия на свежем воздухе. Это групповое мероприятие было направлено на улучшение физического и психического здоровья сотрудников за счет длительных совместных прогулок, восхищения красивыми пейзажами и активного отдыха на свежем воздухе. Такое отступление увеличивает общую продуктивность и помогает создать позитивное и гостеприимное рабочее место, чтобы внести больший вклад в индустрию оптической связи.

19 января 2021 Fiber Mall представил двухпортовый серверный сетевой адаптер SFP25 28G Ethernet

Хотя текущая основная сеть адаптер на рынке доминировали NIC на базе портов 10GbE и 40GbE, многие пользователи серверов делали переход к сетевой карте с портами 25/50/100GbE. FMXXV710-25G-S2, недавно выпущенный FiberMall, представляет собой серверный адаптер Ethernet 25GbE с двумя портами SFP28.

14 января 2021 Fiber Mall выпустит 100G Single-Lambda QSFP28 DR1, FR1, LR1

14 января 2021 Fiber Mall выпустит 100G Single-Lambda QSFP28 DR1, FR1, LR1

Технологии, применяемые в 100G QSFP28 серии оптических трансиверов для IDC достигли своей зрелости. Во второй половине 2016 года наблюдался быстрый рост числа оптических модулей, среди которых QSFP28 был самым быстрорастущим продуктом, используемым для оптического соединения в центре обработки данных. См. Следующий рисунок Объем модулей Ethernet.

1. 100G однолямбда (QSFP28 DR1 / FR1)- Решения, ориентированные на рынок

2. Оптический модуль 100G Single-Lambda-Лучшее решение для обновления NextGen IDC

3. Оптический трансивер FiberMall 100G Single-Lambda — обновление IDC

8 января 2021 Дебют двух новых переключателей White Box от Delta на региональном саммите OCP

AGCX422S — это спинной коммутатор, на передней панели которого расположены 22 встроенных порта QSFP100 28 Гбит / с и 4 порта QSFP-DD 400 Гбит / с. Задняя часть корпуса коммутатора оснащена двойным блоком питания и тройным вентилятором.

АГКВА48С Коммутатор предназначен для соединения между устройствами доступа с более низкой скоростью передачи данных. С 48 25G SFP28 портов и 10 100G QSFP28 интерфейсы на передней панели, дизайн в задней части АГКВА48С переключатель точно, такой же, как у AGCX422S переключатель, в то время как AGCVA48S может восходить к AGCX422S для конвергенции.

1 января 2021 Недавно прибыл медный трансивер Fiber Mall 10GBase-T SFP + 80M

10 ГБase-T 80m SFP + медные трансиверы передают 10 Gigabit Ethernet по Cat 6a / Cat7 tсплетенныйpвоздух кабель. Этот медный модуль SFP +, соответствующий стандарту SFF-8432 MSA (соглашение с несколькими источниками), соединяет 10-гигабитный электрический порт. NIC (сетевая карта) с интерфейсом RJ-45 и 10-гигабитным коммутатором с портом SFP +, обеспечивающим расстояние до 80 м. FiberMall 10GBase-T 80м SFP + медный модуль принимает BroadcomМикросхема PHY BCM84891 обычно взаимодействует с коммутаторами, серверами, сетевыми картами при низком энергопотреблении 2.0 Вт.

Как мы все знаем, оптический модуль SFP + не может работать в существующей медной инфраструктуре, если не развернуто такое оборудование, как коммутаторы Ethernet или оптические преобразователи оптико-электрический преобразователь. Тем не мение, От 10G SFP + до RJ45 80m приемопередатчик обеспечивает высокопроизводительные соединения 10GbE Ethernet по существующей медной кабельной инфраструктуре, что значительно снижает затраты конечных пользователей на прокладку кабелей.

23 декабря 2020 NVIDIA Mellanox представляет продукты InfiniBand нового поколения 400G на выставке SC20

15 декабря 2020 Fiber Mall запускает оптические трансиверы 100G ZR4 QSFP28

15 декабря 2020 Fiber Mall запускает оптические трансиверы 100G ZR4 QSFP28

Предстоящий оптический модуль 100G ZR4 QSFP28 компании FiberMall используется для приложений межсетевого взаимодействия и маршрутизации в высокоскоростном центре обработки данных с дальностью передачи до 80 км. Построен с широко распространенными оптическими компонентами 4 x 25G NRZ, 100 г ZR4 QSFP28 Модуль, который применяется в центрах обработки данных и высокоскоростных каналах Lightwave, является новейшим членом ведущего портфеля продуктов FiberMall, состоящего из одномодовых оптических приемопередатчиков 100/200/400G.

8 декабря 2020 Представлены новые спецификации 100G Lambda MSA для 20 км / 30 км / 40 км 100 GbE

The 100G лямбда Группа по соглашению с несколькими источниками (MSA) объявляет о выпуске трех улучшенных 100 Gigabit Ethernet (GbE), расширяя зону действия до трех различных длин до 20, 30 и 40 км по одномодовому волокну, т.е. 100G-LR1-20(20km), 100G-ER1-30(30km), 100G-ER1-40(40km) respectively.

Цель MSA также включает 400GbE на длине волны 4* 100G. Группа запустила 400G-FR4 в самом начале своего создания и в прошлом месяце выпустила прикладной стандарт 400G LR4-10 для 10 км. MSA сообщила, что следующим шагом будет потребность в 400GbE более чем на 10 километров.

24 ноября 2020 Fiber Mall 100G QSFP28 Дебют оптического трансивера BIDI

В связи с быстрым развитием оптических сетей оптоволоконный ресурсы станут дефицитными, в то время как потребность в решениях для экономии ресурсов волокна is увеличиваетсяИНГ. По сравнению с обычным 100G QSFP28 SR4, 100 Гбит / с QSFP28 BIDI Оптический модуль экономит 75% ресурсов оптического волокна и может широко применяться в телекоммуникациях, центрах обработки данных и беспроводной связи.

2 ноября 2020 Оптические модули, совместимые с 3 суббрендами HPE, помечены

Из-за обновления продукта многие ранее приобретенные бренды постепенно интегрируются или постепенно уходят с рынка. В настоящее время часто используемые продукты ориентированы на 10G 25G 40G 100G и т. Д. Основные суббрендовые системы включают ARUBA NETWORKS, H3C, Blade system и другие продукты. В будущем мы будем лучше разбирать оптические модули и кабельные продукты, такие как DAC AOC, которые совместимы с подсистемой HPE в виде списка.

15 октября 2020 Проблемы отрасли оптической связи в 5G

21 марта 2020 OFC 2020: оптическая связь в следующем десятилетии

21 марта 2020 OFC 2020: оптическая связь в следующем десятилетии

Каким мы представляем будущее волоконно-оптической связи? За последние 50 лет мы увидели, что отдельные пользователи потребляют все больше и больше полосы пропускания, коммуникация человек-человек и человек-машина достигла очень высокого уровня развития. Следующим поворотным моментом станет межмашинная связь, сначала соединение центра обработки данных, а затем Интернет вещей. Это будущий спрос. В отличие от прошлого, сегодня самые ценные компании в Америке — это почти все компании, работающие с данными. Итак, что означают данные? Без оптоволоконной связи не было бы социального развития. Можно сказать, что развитие Интернета изменило определение страха, изменило границы, изменило определение валюты и изменило государственные и финансовые правила. Итак, никакая технология не повлияла на человеческое общество, политику и экономику сильнее, чем оптоволоконная связь.

Самая впечатляющая часть речь Алексей Пилипецкий из SUB COM, поставщика услуг подводного кабельного телевидения, поскольку он упомянул, что второй независимый подводный кабель Google Dunant стал первым в мире коммерческим подводным кабелем, основанным на технологии SDM. Подводный кабель соединяет Америку и Францию общей протяженностью 6,400 250 километров и пропускной способностью 12 Тбит / с на основе 32 пар оптических волокон. Это, несомненно, важный знак для тех, кто не уверен в перспективах приложений SDM. В своем выступлении Пилипецкли также отметил, что проблема стоимости одного бита морской системы все еще остается актуальной, по их мнению, подводные кабельные системы с более чем 1 волокнами больше не могут обеспечить снижение маржинальных затрат. Забегая вперед, он считает, что подводная кабельная система со скоростью 2025 Пбит / с появится в XNUMX году.

30 ноября 2019 НАС. FCC запускает фонд строительства сетей 9G на сумму 5 миллиардов долларов

Председатель FCC Аджит Пай объявил, что планирует запустить $ 9 млрд. 5G фонд для сельских районов в Соединенных Штатах, цель которого — инициировать развитие передовых мобильных беспроводных технологий по всей стране в Соединенных Штатах.

14 ноября 2019 Выпущена подсистема, предварительные исследования оптических модулей высокого класса

Наша компания собирается провести предварительные исследования по всей серии продуктов, таких как 400G, и высококлассных оптических модулях, таких как 200G CFP2 PAM4. Наши предстоящие продукты: различные волоконно-оптические усилители, подсистемы, 100G QSFP28 ER4 / CFP2 ER4 / CFP ER4.

30 сентября, 2019 OptiCON стремится увеличить пропускную способность волоконно-оптического кабеля

14 сентября, 2019 Поставки оптических модулей 100G резко выросли

14 сентября, 2019 Поставки оптических модулей 100G резко выросли

С быстрым развитием облачных вычислений и больших данных рынок центров обработки данных по-прежнему быстро растет. Производители оптических модулей, ориентированные на рынок цифровой связи. Еще в 2014 году компания FiberMall накопила запасы для рынка передачи данных, а в 100 году выпустила продукты 28G QSFP4 PSM4 / CWDM2015, а также наладила массовое производство. У нас много заказов и клиентов на рынке хранения и пользователей корпоративных сетей. В то же время изменения в сетевом трафике IDC также предъявили новые требования к построению архитектуры телекоммуникационной сети. Как важная инфраструктура, дата-центр IDC неизбежно вступит в период быстрого расширения.

31 августа 2019 Победив Huawei, Эрикссон выиграл 75 глобальных контрактов на 5G

По сообщениям зарубежных СМИ, по мере того, как все больше и больше стран запускают коммерческие сети 5G, а масштабы коммерциализации 5G становятся шире, компании, производящие телекоммуникационное оборудование, также получают все больше и больше коммерческих контрактов на 5G. Текущие коммерческие контракты Ericsson на 5G превысили 75.

14 августа 2019 FiberMall запускает оптический модуль XGS-PON OLT/ONU

XGS-PON также называют симметричным 10G GPON. Оптический модуль XGS-PON OLT в основном используется в центральном офисе системы XGS-PON. Нисходящая линия использует длину волны 1575 ~ 1580 нм для передачи непрерывного сигнала 9.953 Гбит / с, в то время как восходящая линия использует длину волны 1260 ~ 1280 нм для передачи пакетного сигнала 9.953 Гбит / с. С 1 частью 128-канальной системы расстояние передачи может достигать 20 километров. Выпущенный оптический модуль XGS-PON OLT упакован в XFP, который разделен на N1 и N2.

Июль 31, 2019 WIOF2019: будущее сетей PON по-прежнему светлое

10G PON уже является современным, так что же такое следующее поколение PON? Почему не 25G PON, а 50G PON? Доктор Ван Ли сказал, что в прошлом стандартная скорость PON была увеличена в 4-10 раз, и улучшение 25G PON не было очевидным по сравнению с 10G PON. Большинство иностранных операторов выступают за 25G PON.

30 июня 2019 Openreach ищет третьего поставщика FTTP

Компания Openreach, дочерняя компания British Telecom (BT) по работе с сетями широкополосного доступа, ищет третьего поставщика волоконно-оптических широкополосных технологий для поддержки своего плана «Fiber First» — оптоволокно до дома (FTTP). По сообщениям СМИ, срок действия предложения истечет в январе 2020 года, и поставщики будут окончательно определены во втором квартале.

14 июня 2019 Fibermall выпустила оптические модули 25G SFP28

Чтобы соответствовать требованиям 5G ERA, компания FiberMall с прошлого года инвестировала огромные ресурсы в разработку продуктов для фронтальных сетей 25G SFP28.

FiberMall запускает следующие продукты: 25G SFP28 SR, LR, ER 25G SFP28 BIDI 10 км, 30 км 25G SFP28 CWDM шесть длин волн 1270 нм ~ 1370 нм 25G SFP28 DWDM поддержка ITU 21 ~ 60 каналов

Полный ассортимент оптических модулей 25G SFP28 от FiberMall достиг массового производства со стабильной производительностью продукта и высокой стоимостью производительности для удовлетворения потребностей клиентов в различных сценариях применения. 25G SFP28 DWDM, 25G SFP28 CWDM, 25G SFP28 BIDI, продукты серии 25G SFP28. Оптический модуль 25G SFP28 использует оптический порт LC, который совместим с такими стандартами, как IEEE802.3by и SFF-8472, отличается низким энергопотреблением, небольшим размером и высокой скоростью. В основном используется в сетях 5G, центрах обработки данных, Fibre Channel, 25G Ethernet и других средах. Оптический модуль 25G SFP28 можно адаптировать к HW, H3C, Cisco, Alcatel-Lucent, Juniper и другому оборудованию.

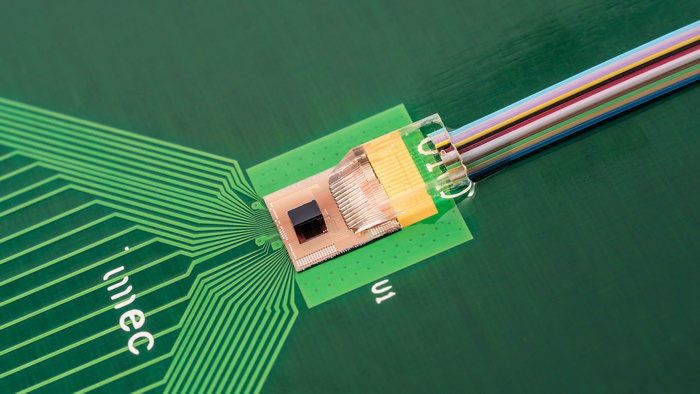

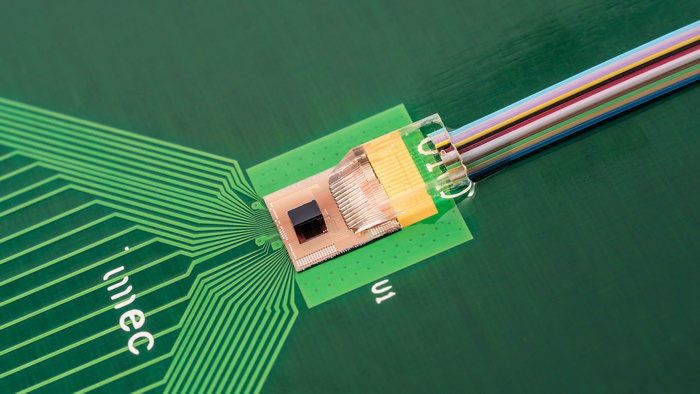

31 мая 2019 IMEC расширяет портфолио кремниевой фотоники

31 мая 2019 IMEC расширяет портфолио кремниевой фотоники

Во время ECOC2019 IMEC, ведущий мировой исследовательский центр в области наноэлектроники и цифровых технологий, а также центр инноваций, в сотрудничестве с IDLab и Photonics Research Group исследовательской лаборатории Imec в Гентском университете, совместно обнародовали вехи важных достижений в кремниевой фотонике (SiPho). ) технологические исследования. Продемонстрированная архитектура конструкции обеспечивает достижимый путь для коммутаторов центров обработки данных следующего поколения с 400 Гбит / с, высокоскоростных оптических каналов и совместно упакованных оптических устройств, которые станут ключевыми технологиями для передачи данных в центрах обработки данных будущего. Основные достижения этого достижения включают в себя: прототип оптического приемопередатчика CMOS-SiPho высокой плотности (Тбит / с / мм2) с поддержкой TSV, маломощный передатчик PAM106 SiPho 4 Гбит / с, высокоскоростной германиево-кремниевый ЛФД и сверхширокополосный низкопотенциальный преобразователь частоты. Одномодовый волоконный ответвитель.

30 апреля 2019 3 прогноза о центрах обработки данных в 2019 году

30 апреля 2019 3 прогноза о центрах обработки данных в 2019 году

1. географическая декомпозиция центров обработки данных станет более распространенной

2. Дата-центр будет продолжать развиваться.

3. Кремниевая фотоника и КМОП станут ядром развития оптических модулей.

14 апреля 2019 100G QSFP28 AOC поставляется в больших количествах

FiberMall's 100G QSFP28 — QSFP28 представляет собой высокопроизв?

Читать дальше →