Мёд или жизнь: как AI-пчела понимает абстрактные концепции

Способность понимать абстрактные понятия, такие как «сходство» и «различие», считается когнитивной (познавательной) функцией высшего порядка наравне с вниманием и восприятием. Удивительно, но медоносные пчёлы обладают не только этой способностью, но также могут решать ряд простых и сложных ассоциативных задач.

Мы сделали конспект статьи, в которой расскажем о разработке новой нейронной сети, моделирующей структуру мозга медоносной пчелы.

Обучение абстрактным понятиям

Модель даёт достаточно точное представление о том, как реальные пчёлы воспринимают абстрактные понятия независимо от способа обработки информации.

Считается, что способность распознавать абстрактные концепции формирует основу мышления человека, а также других млекопитающих и птиц. Она связана с активностью нейронов в префронтальной коре головного мозга. Однако у медоносной пчелы нет ничего похожего на префронтальную кору в её гораздо меньшем мозге.

Для исследования способности насекомых обучаться абстрактным концепциям будет использоваться подход моделирования. Для начала мы более подробно опишем, как эту задачу решают медоносные пчёлы и другие животные.

Задачи «совпадает с образцом» («Match-To-Sample», MTS) разработаны для оценки обучения невербальному восприятию одинаковых и разных объектов. Животным сначала показывают один образец (стимул), а через некоторое время — два новых: первый соответствует изначальному, а второй нет. Чтобы изучить, какая продолжительность «рабочей памяти» («working memory») необходима для выполнения задачи, новые объекты показывались с задержками различной длины. Это называется «Delayed-Match-To-Sample» (DMTS).

Тесты, где животным надо наоборот выбирать не совпадающие с оригиналом предметы, называются «не совпадает с образцом» («NotMatch-To-Sample», NMTS или DMTS). Но этих задач недостаточно для демонстрации обучения абстрактным понятиям. Необходимо показать, что если животное научилось определять совпадающие или несовпадающие объекты, то оно сможет применить принцип сходства или различия и в новом контексте. Обычно это делается с помощью проверки на новом наборе образцов и называется трансферным тестом.

Исследования показали, что медоносные пчёлы могут учиться как DMTS, так и DNMTS-задачам и обобщать их на новые объекты. В опыте использовался лабиринт в форме буквы Y с исходным стимулом на входе и двумя разными объектами в каждом из ответвлений. Пчёлы прошли 60 испытаний, чтобы освоить эти задачи — это намного дольше, чем изучение простых обонятельных или визуально-ассоциативных навыков, для которых им требуется всего 3 испытания.

Показатели точности при этом не были идеальными — средняя эффективность составила около 75%, но это лучше, чем шанс простого «угадывания».

Концепция рабочей памяти имеет решающее значение для задач DMTS/DNMTS, поскольку животное не видит первоначальный стимул в процессе выбора. Если нет нейронной информации, которая могла бы идентифицировать совпадение, то проблема не может быть решена. Поэтому необходимо определить, как пчела запоминает эту информацию, и создать модель для решения задачи.

Модель строго ограничена установленными нейрофизиологическими и нейроанатомическими особенностями поведения настоящих пчёл. Мозг пчелы структурирован в виде отдельных областей нейропиля (зоны синаптического контакта). Особенности их взаимодействия хорошо изучены и описаны. Обучение происходит с помощью грибовидных тел (corpora penduculata) — они обрабатывают обонятельные, зрительные и механосенсорные данные.

До сих пор не было ясно, каким образом грибовидные тела и связанные с ними структуры могут изучать абстрактные понятия, которые не зависят от каких-либо специфичных особенностей объектов. Компьютерное моделирование грибовидного тела потребует реализации двух вычислительных компонентов: рабочей памяти для хранения идентичности образца и механизма для её использования, чтобы влиять на поведение модели в момент принятия решения.

Модель сети на основе мозга пчелы

Схема модели и основные принципы

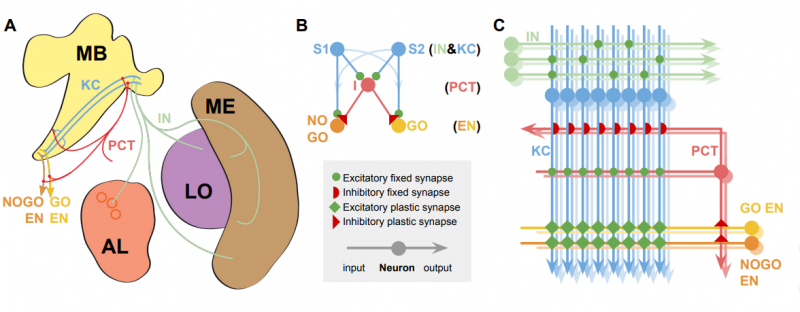

A — нейроанатомия: MB (Mushroom Bodies) — грибовидные тела; AL (Antennal Lobe) — гломерулы антенной доли (круги); ME и LO — нейропили глубоких частей зрительной доли (Medulla и Lobula). Соответствующие нейронные пути помечены для сравнения с моделью.

B — упрощённая модель. Классы нейронов указаны справа.

C — полная модель, отражающая соединения и приблизительное число нейронов каждого типа. Цветовая маркировка и метки сохраняются на всех диаграммах.

Основные типы нейронов: KC (Kenyon Cells) — Клетка Кеньона, PCT (Protocerebellar Tract neurons) — протоцеребеллярный тракт нейронов, IN (Input Neurons) — входные нейроны (обонятельные или зрительные), EN (Extrinsic Neurons) — внешние нейроны грибовидных тел из субпопуляций GO и NOGO.

Грибовидное тело смоделировано как ассоциативная сеть из трёх слоёв. Входные нейроны IN обеспечивают обработку обонятельных, визуальных и механосенсорных данных. Слой клеток Кеньона KC выполняет разреженное кодирование (sparce-coding) сенсорной информации для эффективной классификации образцов. И, наконец, внешние нейроны грибовидного тела EN связаны с премоторной корой и активируют различные возможные поведенческие реакции. Для простоты мы рассматриваем EN как две субпопуляции, контролирующие только ответы «go» или «no-go» при выборе между различными вариантами объектов. Связи между выходом KC и EN модифицируются синаптической пластичностью и могут поддерживать изученные изменения в поведенческих реакциях на стимулы.

Как упоминалось выше, нам требуются два вычислительных механизма для решения задачи DMTS/DNMTS. Первый — находит средство для сохранения идентичности стимула, и второй — учится использовать эту идентичность для управления поведением и решения задачи.

Более того, результат обучения должен распространяться на новые стимулы, что требует большой вычислительной сложности.

У клеток Кеньона есть особенность, выполняющая требование обнаружения новизны — сенсорная аккомодация. У медоносных пчёл, даже при отсутствии вознаграждения или наказания за правильные или неправильные решения, KC резко снижают активность между начальными и повторными образцами до 50%. Этот эффект сохраняется в течение нескольких минут и может влиять на поведение во время испытания, но вряд ли повлияет на последующие опыты.

Теперь нам необходим второй механизм, который может использовать это свойство KC для управления поведением при выборе направления Y-лабиринта. При этом надо учесть, что пчёлы должны решать как DMTS, так и DNMTS-задачи, и не столкнуться с противоречием. Например, постсинаптическое обучение пропорционально увеличивает как более слабую (повторную) стимулирующую активность в субпопуляции GO EN, так и более сильную (единичную). Чтобы выбрать «go», активность GO для текущего стимула должна быть выше, чем активность NOGO, которая остаётся фиксированной. Это подойдёт для задачи DMTS, но в DNMTS должен применяться обратный принцип — ни одно правило постсинаптического обучения не удовлетворяет этому требованию.

Поэтому для решения DMTS и DNMTS задач необходим отдельный набор нейронов, которые могут выступать в роли переключателя между KC и поведением. Наиболее подходящий кандидат — тормозящие нейроны (inhibitory neurons), образующие протоцеребеллярный тракт (PCT). Они участвуют в регулировании входных данных для KC, и мы предполагаем, что они также могут регулировать активность популяций EN в выходные области KC с помощью синаптической пластичности. Если мы предположим, что при высоком пороге активности нейронов PCT повторные стимулы не будут их активировать, а единичные будут, тогда станет возможной синаптическая пластичность от PTC к EN. Это позволит решить DMTS и DNMTS задачи и передать это обучение новым стимулам.

Итак, мы представляем две модели, основанные на анатомии и свойствах мозга медоносной пчелы. Первая модель — упрощённая демонстрация того, что вышеизложенные принципы могут решать задачи DMTS и DNMTS и обобщать обучение для новых наборов образцов. Но эта модель не может продемонстрировать, что ассоциативное обучение в синапсах от KC до EN не препятствует обучению в синапсах от PCT до EN или наоборот. Поэтому вторая модель будет более полной и сможет решать как DMTS и DNMTS с переходом к новым стимулам, так и набор других ассоциативных задач.

Упрощённая модель

Упрощённая модель показана на рисунке (B). Входные узлы S1 и S2 — альтернативные стимулы, где KC для простоты разделены на два непересекающихся узла, поэтому нам не нужно отдельно моделировать входные нейроны IN. Узел I (который соответствует нейронам PCT, опять же в упрощённом виде) — это тормозящие нейроны, связанные с выходами GO и NOGO. Узлы S1 и S2 проецируются на узлы I, GO и NOGO с фиксированной возбуждающей взвешенной связью. I проецируется на GO и NOGO с помощью пластичных тормозящих взвешенных связей. Он имеет пороговое значение, поэтому реагирует только на новые стимулы.

Модель регулирует веса между I и GO, чтобы изменить вероятность выбора несоответствующего стимулу объекта. При этом веса от I до GO/NOGO инициализируются половиной максимального значения веса. Поскольку условия для изменения весов выполняются, когда для «go» выбирается единичный стимул, модель учится только на неудачных попытках для DMTS (увеличение веса) или успешных попытках для DNMTS (уменьшение веса).

Полная модель

Полная модель также изображена на рисунке ©. Ниже показана эффективность обеих моделей:

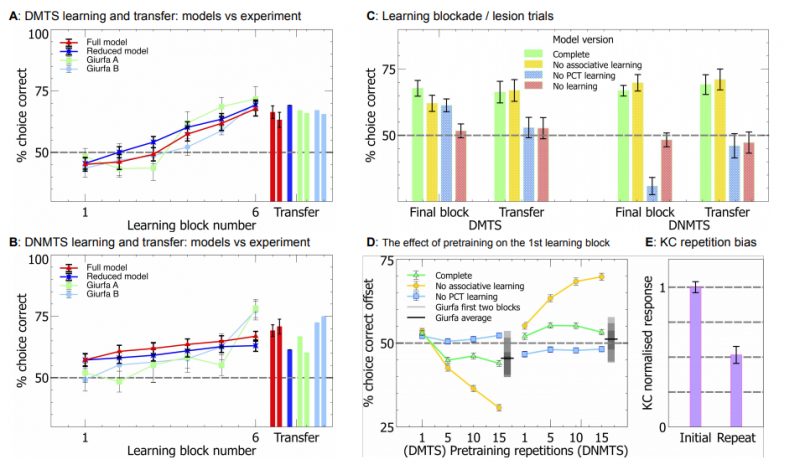

Области A и B показывают эффективность упрощённых моделей при обучении и переходе к новым образцам. Можно заметить, что процесс предварительного обучения сильно смещает модель в сторону единичных стимулов.

На области D изображена эффективность полной модели для первого блока обучения. Здесь тоже наблюдается смещение в сторону единичных образцов при обучении только по пути PCT. Это смещение уменьшается при наличии ассоциативного обучения по пути KC и не зависит от количества этапов предварительного обучения.

Область C отражает результаты обучения по пути от PCT к EN. Мы попытались подтвердить, что это позволило обеспечить обобщение результатов на новые наборы стимулов. Здесь из модели выборочно исключены: ассоциативное обучение по пути KC, обучение по пути PCT и полное обучение (синаптические веса остаются неизменными). На рисунке видно, что обучение по пути PCT является необходимым условием обобщения, в то время как обучение только по пути KC не влияет на эффективность этой задачи по сравнению с полностью исключённым обучением.

Эксперименты

Для того чтобы упростить задачу исследования нашей модели, мы воплотим её в мире, который можно описать конечным автоматом. Этот мир не сталкивается с некоторыми навигационными проблемами реального мира, но для доказательства эффективности модели такое упрощение приемлемо.

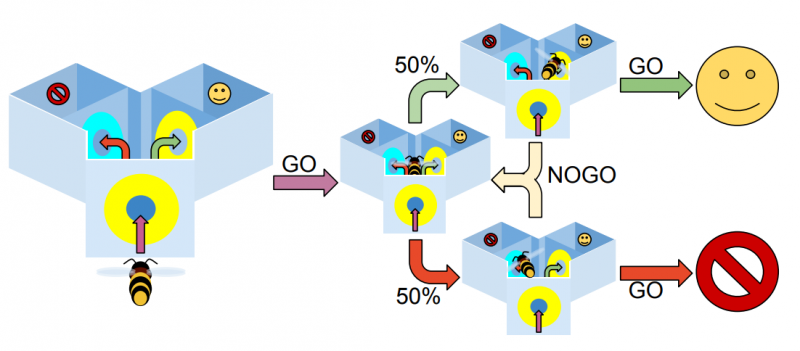

Экспериментальная установка Y-лабиринта изображена на рисунке ниже. Модель пчелы перемещается между набором состояний — различными местоположениями лабиринта: на входе, в центре справа, в центре слева, в правой ветви, в левой ветви.

Находясь у входа, пчела видит исходный стимул. В центральной камере перед ней два входа с объектами, из которых надо выбрать один согласно испытанию (DMTS или DNMTS).

В упрощённом Y-лабиринте модель пчелы может занять одно из трёх положений: на входе, в точке выбора перед левой ветвью, в точке выбора перед правой ветвью. В каждом положении для неё доступны два выбора: идти или не идти («go» и «no-go»). На входе всегда выбирается «go» — если пчёлы отказываются входить в лабиринт, то не участвуют в эксперименте. После этого случайно выбирается одна из ветвей: левая или правая. Если модель выбирает «no-go», то процедура повторяется, пока она не выберет «go». Поскольку на этом этапе обучения не происходит, модель может постоянно перемещаться между двумя входами, никогда не выбирая «go». Чтобы этого избежать, мы вводим равномерно распределённое случайное смещение в канал «go», которое увеличивается с числом раз, когда модель выбирает «no-go».

Нейроны IN делятся на непересекающиеся группы по 8 нейронов, каждая из которых представляет собой стимул:

- Z: стимул для предварительного обучения

- A, B: обучающие стимулы

- C, D: стимулы для трансферного теста

- E, F: стимулы для повторного трансферного теста

Нейроны в каждой из групп равны нулю, когда стимул отсутствует, и определённому значению, когда стимул активен. Это значение согласуется для каждой пчелы, но не между ними.

Предварительное обучение

Как и в опытах с реальными пчёлами, сначала мы знакомим наши простые модели с экспериментальным аппаратом. Мы проводим 10 этапов обучения с «поощрением» пчелы, которая входит в Y-лабиринт, без использования стимулов. После этого модель обучается ещё 10 этапов, чтобы перемещаться к каждой из ветвей лабиринта. В этом случае пчела не выбирает между «go» и «no-go», поскольку цель обучения — дать ей достаточное поощрение, чтобы потом она заходила в лабиринт и могла участвовать в дальнейшем эксперименте.

Обучение

Процедура состоит из 60 испытаний, разделённых на блоки по 10 испытаний. Опыт включает набор повторяющихся четырёх этапов: по два испытания с разными стимулами на входе в лабиринт. В каждом из испытаний объекты на левой и правой ветви менялись местами. Если модель решает задачу MTS, то она награждается за выбор объекта, совпадающего со стимулом, и наказывается за выбор другого. В задаче DMTS — наоборот.

Трансферный тест

В трансферном тесте мы не используем вознаграждение или наказание, а тестируем модели с помощью процедуры обучения, заменяя обучающие стимулы на тестовые. Используется два набора трансферных стимулов и 4 повторения (с заменой объектов в левой и правой ветви) для каждого из них.

Другие ассоциативные эксперименты

Теперь мы должны подтвердить, что наша модель может решать задачи обусловливания. Важный момент — они выполняются с точно такими же параметрами модели, как в DMTS/DNMTS; и характеристиками, обнаруженными в экспериментах на реальных пчёлах. Мы выбрали четыре опыта, включая эксперимент по обонятельному обучению с использованием рефлекса удлинения хоботка (proboscis extension reflex, PER), и визуальное обучение со свободно летающими пчёлами.

Обучение/переучивание

Эти эксперименты проводятся так же, как и DMTS, но с одним отличием — для первых 15 испытаний поощряется выбор одной соответствующей стимулу ветви (за неправильный выбор нет наказания), а после 15 испытания — другой соответствующей ветви. При этом не проводится никакого предварительного обучения, и данные анализируются для каждого опыта, а не для блоков по 10. В эксперименте используются 200 виртуальных пчёл.

Рефлекторное удлинение хоботка (PER)

Рефлекс удлинения хоботка — классический опыт с неподвижными пчёлами. В этом эксперименте пчёлы находятся в маленьких металлических трубках, открыты только голова и усики. Им подносят обонятельный стимул (условный раздражитель) и дают вознаграждение в виде раствора сахарозы (безусловный раздражитель). Для экспериментов PER мы разделяем нейроны IN так же, как было описано. Но так как пчёлы неподвижны, запахи представляются в заранее определённом порядке, и выбор пчелы на него не влияет.

Обучение одному запаху

В экспериментах с одним запахом обучение и тестирование происходят одновременно. Реальным пчёлам дают запах и с некоторой задержкой награждают раствором сахарозы. Если насекомое расширяет хоботок в течение задержки, его считают отреагировавшим, если нет — его всё равно награждают, но считают не отреагировавшим. Чтобы соответствовать этому плану, эффективность модели записывалась в каждом испытании, при этом NOGO — отсутствие реакции на стимул, GO — ответ на стимул. Награда давалась независимо от эффективности модели.

Положительное/отрицательное упорядочивание

Обучение делится на блоки, каждый из которых содержит четыре представления о запахе или комбинации запахов. При положительном упорядочивании мы не вознаграждаем отдельные запахи A и B, а только комбинацию AB (A -, B -, AB +). При отрицательном упорядочивании — наоборот (A +, B +, AB -). В обоих случаях объединённый запах используется дважды для каждого представления отдельных запахов, поэтому блоком для положительного упорядочивания является, например, [A -, AB +, B -, AB +], а для отрицательного: [A +, AB -, В +, AB -]. Эффективность оценивается так же, как при обучении одному запаху.

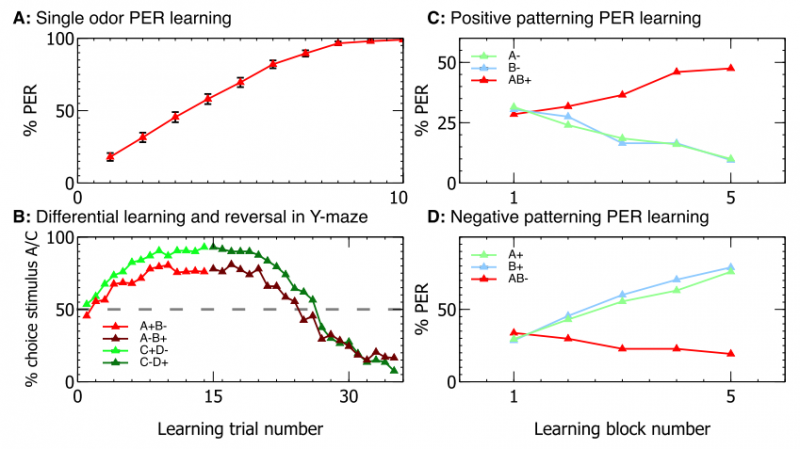

Результаты экспериментов показали, что полная модель способна успешно выполнять эти задачи. Количественная эффективность показана на рисунке ниже и почти соответствует экспериментам с реальными пчёлами.

Здесь A — обучение одному запаху, B — обучение/переучивание, C и D — положительное/отрицательное упорядочивание.

Использование модели

Упрощённая модель построена в GNU Octave, а полная модель создана с помощью набора инструментов SpineML и SpineCreator GUI (всё ПО с открытым исходным кодом). Входные векторы для нейронов IN и механизм состояний для навигации по Y-лабиринту моделируются с помощью сценария на Python через соединение TCP/IP.

Исходный код доступен на github.

Установите SpineML_2_BRAHMS, как описано здесь. Для простоты мы рекомендуем использовать Ubuntu Linux.

Клонируйте репозиторий с github и измените файл scripts/setup.py, добавив ваш путь к репозиторию и путь к SpineML.

Модель можно протестировать на разных экспериментах с помощью batch_X.py, а для анализа данных можно запустить сценарий process_data.py.

Если вы хотите визуализировать модель, то сделать это можно в SpineCreator GUI (инструкция по установке). Откройте файл .proj в каталоге /model с помощью меню File/Open Project в SpineCreator. Модель можно запускать из SpineCreator, но перед этим убедитесь, что вы запустили правильный файл scripts/world_X.py.

Упрощённую модель можно найти в каталоге /matlab_model и запустить в GNU Octave или Matlab.

Нейронные архитектуры, способные оперировать абстрактными понятиями — первый шаг на пути построения полноценного искусственного интеллекта. Развитие этих моделей позволит оперировать более сложными признаками и зависимостями, например, точнее распознавать эмоции из особенностей разных частей лица. Нейросети смогут оперировать не только сведениями об объектах, но и понимать их назначение и способы применения.

С оригинальной статьёй можно ознакомиться на портале biorxiv.org

0 комментариев

Вставка изображения

Оставить комментарий