Управляемые базы данных для PostgreSQL теперь GA. Пробелы получает пользовательскую поддержку субдомен и расширяется во Франкфурте.

Здесь на DigitalOcean, мы прилагаем все усилия, чтобы улучшить нашу платформу, так что вы можете хранить и извлекать все виды данных — быстро и надежно.

Здесь, в DigitalOcean, мы прилагаем все усилия, чтобы улучшить нашу платформу, чтобы вы могли надежно и быстро хранить и извлекать все виды данных.

С тех пор, как мы запустили управляемые базы данных для PostgreSQL, многие клиенты выразили признательность за то, как легко раскрутить управляемые, беспроблемные кластеры баз данных. Благодаря таким функциям, как автоматическое переключение при сбое и резервное копирование, вам не нужно беспокоиться о проблемах, которые могут привести к катастрофическим последствиям с самоуправляемой базой данных.

Управляемые базы данных DigitalOcean изменили правила игры. Они проделали фантастическую работу по устранению сложности настройки, настройки и защиты баз данных для производственного использования. Мы не являемся администраторами баз данных, поэтому было очень приятно ориентироваться в простом пользовательском интерфейсе и уверенно выполнять задачи в несколько кликов, которые раньше требовали бы несколько дней исследований.

Брэд Килшоу, основатель, Nivel Technologies

За последние несколько месяцев некоторые из вас уже стали полагаться на наш управляемый сервис Postgres. Но для тех, кто все еще находится на грани, мы рады сообщить, что управляемые базы данных для PostgreSQL теперь готовы к работе и общедоступны. Кроме того, сегодня мы представляем новые функции, в том числе бесплатную интегрированную службу мониторинга, которая автоматически обеспечивает понимание и позволяет устанавливать оповещения для ваших баз данных.

Кроме того, что касается хранения данных, мы рады сообщить, что наша служба хранения объектов Spaces теперь доступна в нашем дата-центре во Франкфурте (FRA1).

Мониторинг и управление вашей базой данных, все в одном месте

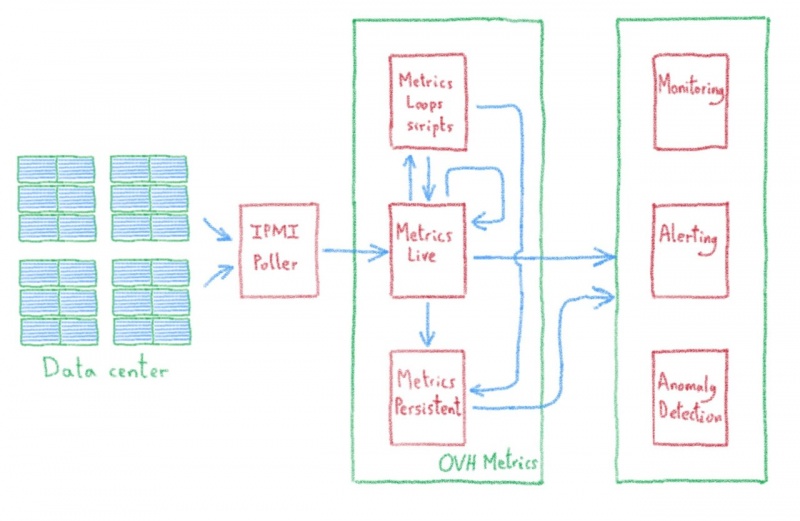

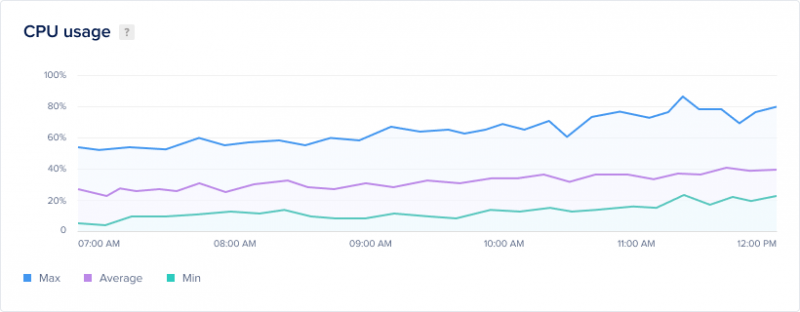

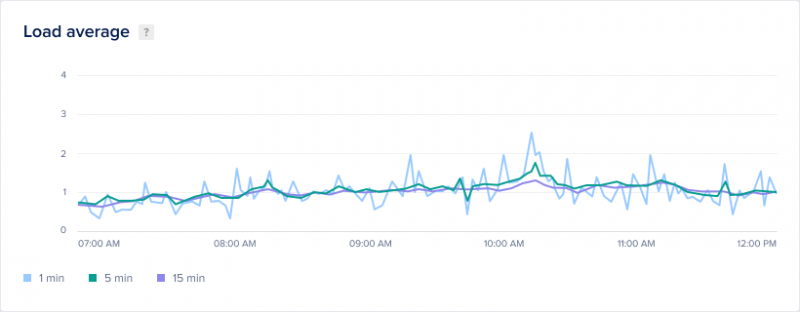

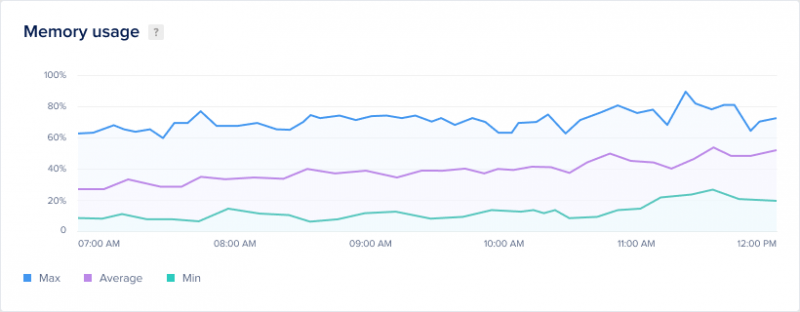

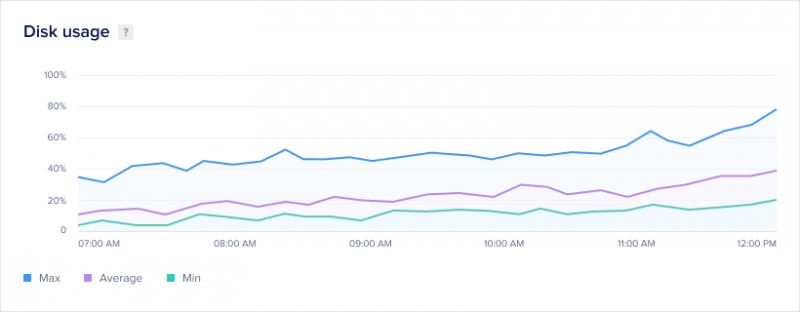

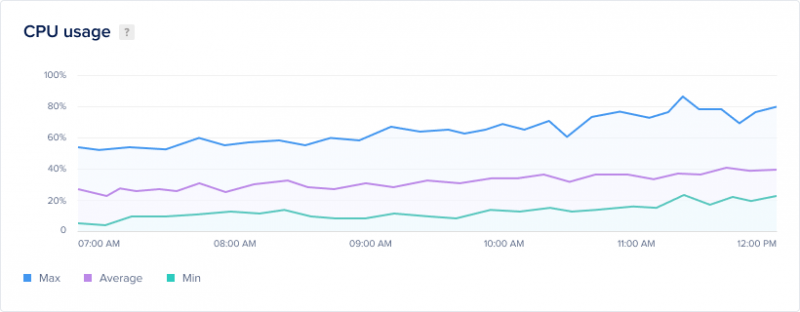

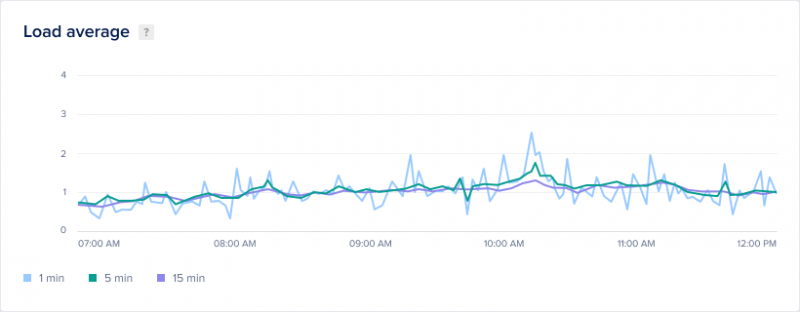

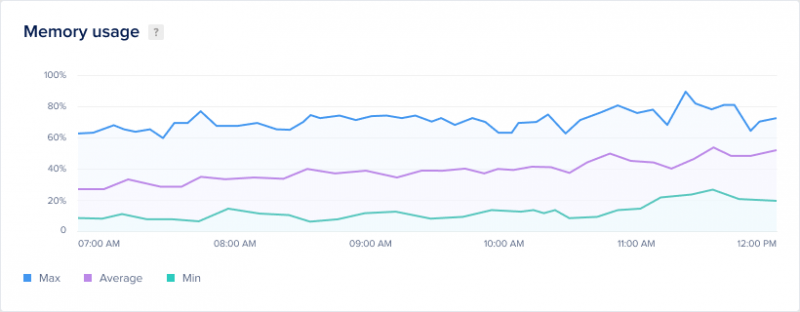

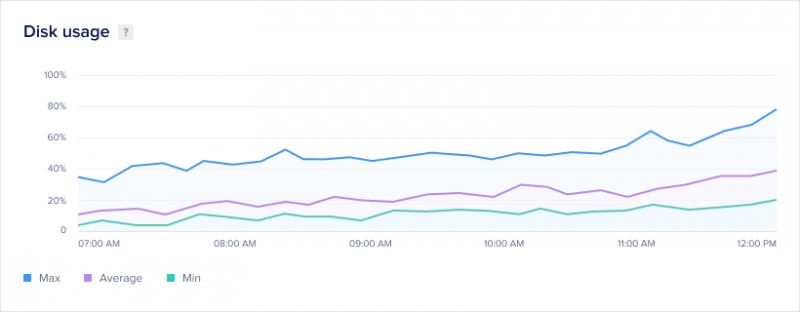

Чтобы помочь вам поддерживать высокую производительность вашей базы данных PostgreSQL, DigitalOcean интегрировал бесплатную службу мониторинга прямо в панель управления управляемыми базами данных. Метрики производительности кластера базы данных помогают вам масштабировать и масштабировать базовую инфраструктуру вашей базы данных для удовлетворения текущих и будущих потребностей. Благодаря нашей интегрированной информации вы увидите агрегированное использование ресурсов для всего кластера:

- использование процессора

- 1-, 5- и 15-минутная средняя нагрузка

- Использование памяти

- Использование диска

Чтобы получать информацию о состоянии вашего кластера, вы также можете настроить политики предупреждений для этих же показателей с опциями электронной почты и уведомлений Slack.

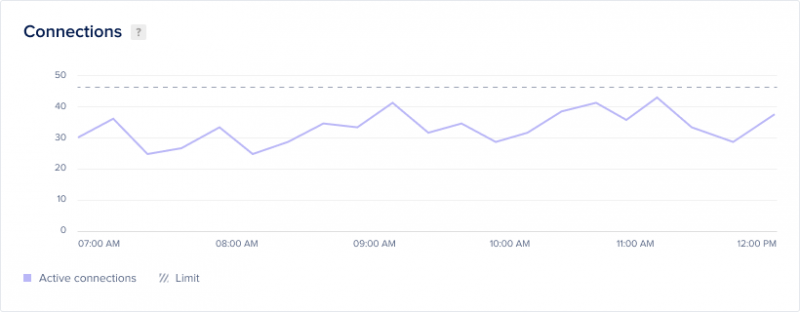

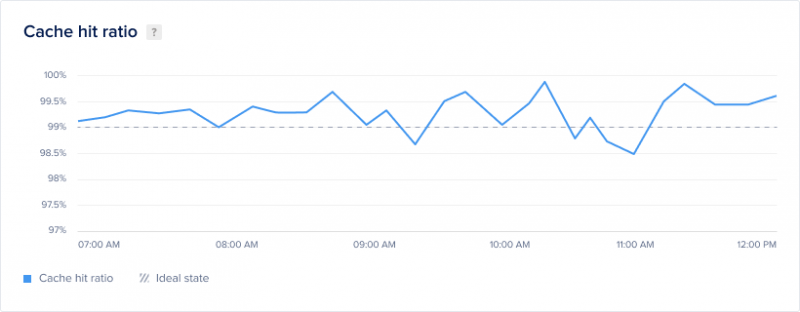

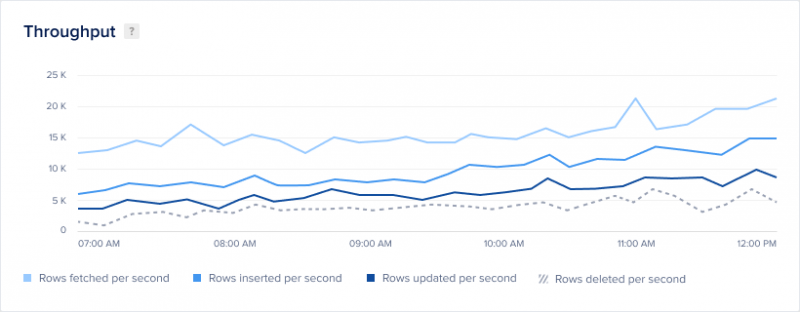

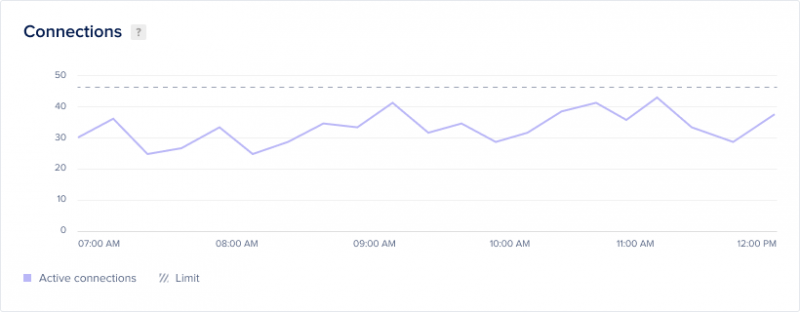

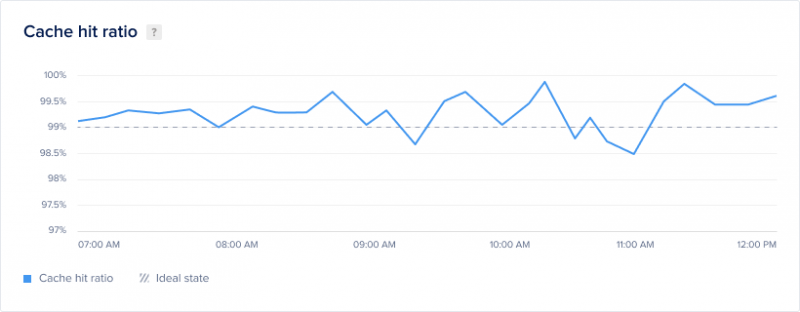

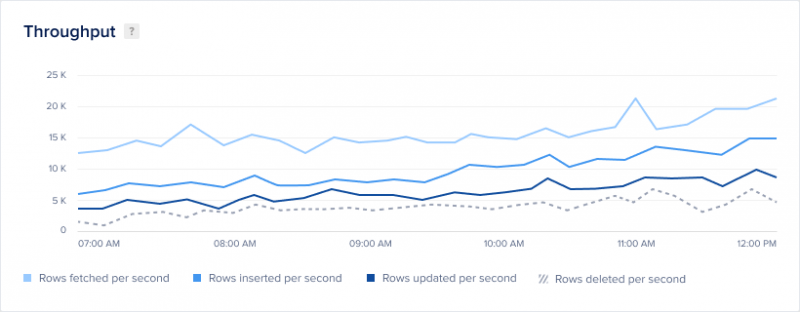

Для поддержания максимальной производительности PostgreSQL также важно отслеживать шаблоны доступа к базе данных, чтобы знать, когда и как оптимизировать схему и конфигурацию. DigitalOcean избавляется от догадок при мониторинге шаблонов доступа, предоставляя ключевые показатели производительности базы данных, в том числе:

- Соединения и ограничения соединения

- Коэффициент попадания в кэш

- Последовательное сканирование против сканирования индекса

- Выборка строки, вставка, обновление и удаление пропускной способности

- Скорость создания тупиковой ситуации

- Задержка репликации

Если после мониторинга и оптимизации базы данных вы пришли к выводу, что вам необходимо увеличить масштаб базы данных, чтобы повысить производительность, или уменьшить масштаб базы данных, чтобы сократить расходы, DigitalOcean делает изменение размера кластера простым и безболезненным.

Полностью автоматизированная репликация, резервное копирование и другая конфигурация на уровне базы данных являются обязательными для нас. Так что мы были невероятно счастливы, когда DigitalOcean анонсировала свой сервис управляемых баз данных. Это плюс их предсказуемая цена и отличная поддержка сделали наш выбор поставщика облачных услуг простым.

Рафаэль Коста, технический директор @ Eficiência Fiscal

Обеспечить высокую производительность благодаря глобальному распределению данных

Чтобы обеспечить высокую производительность приложений, мы всегда рекомендуем размещать ваши капли и данные рядом с пользователями.

Управляемые базы данных обычно доступны в восьми местах

С сегодняшним запуском вы можете создавать управляемые базы данных для PostgreSQL во всех регионах нашего центра обработки данных: в

Нью-Йорке, Амстердаме, Сан-Франциско, Сингапуре, Лондоне, Франкфурте, Торонто и Бангалоре.

Управляемые базы данных DigitalOcean дали нам готовый кластер PostgreSQL за несколько кликов. Наши клиенты заметили огромное изменение производительности нашего приложения, и наша команда разработчиков DevOps получила лучший способ управления базой данных.

Фернандо Руис, ведущий разработчик, OpenWebinars.net

Кроме того, Spaces, наше хранилище объектов со встроенным CDN, теперь доступно во Франкфурте, а также в Сан-Франциско, Амстердаме и Сингапуре.

В настоящее время Content Ignite использует почти все продукты DigitalOcean, но хранение объектов, предоставляемое DigitalOcean Spaces, и простота использования API DigitalOcean — это два качества, которые наша команда особенно ценит.

Ли Грумбридж, генеральный директор, Content Ignite

Гораздо больше впереди

Сегодня это важный этап в долгом путешествии по созданию широкого набора сервисов для хранения и извлечения данных. Наш следующий приоритет для управляемых баз данных — это поддержка возможности запуска ваших баз данных в частной сети, что позволяет пользователям изолировать связь на уровне учетной записи или команды. Кроме того, мы усердно работаем над поддержкой дополнительных механизмов баз данных, таких как MySQL и Redis.

Но если PostgreSQL является вашей реляционной базой данных, мы будем рады, если вы попробуете наши управляемые базы данных для PostgreSQL. И, как всегда, мы будем рады услышать ваши отзывы.

www.digitalocean.com/docs/networking/private-networking/overview/

cloud.digitalocean.com/databases/new

Теперь с пользовательскими субдоменами и доступны во Франкфурте

Теперь с пользовательскими субдоменами и доступны во Франкфурте

DigitalOcean Пробелы наш сервис для хранения объектов с встроенным CDN. С пробелами, вы можете легко хранить большие объемы данных, а затем автоматически распространять данные таким образом, чтобы пользователи могли получить доступ к нему быстро.

Вот что новые пространства:

- Пользовательские субдомены

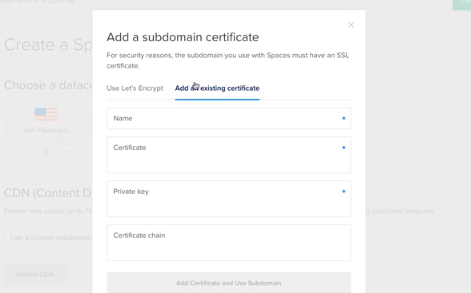

Теперь вы можете использовать свой собственный пользовательский поддомен URL для доставки активов, так что вам не нужно будет подвергать свой стек технологий. Это легко загрузить сертификат SSL для вашего собственного поддомена или использовать один свободный от Encrypt Давайте.

Пространства объектов хранения теперь доступна во Франкфурте

Пробелы теперь доступна во Франкфурте (FRA1), а также Сан — Франциско, Амстердаме и Сингапуре, так что вы можете хранить ваши данные еще ближе к своим клиентам.

В DigitalOcean мы всегда работаем над упрощением использования облака, чтобы вы могли сосредоточиться на создании великолепных вещей.

Часть пути к созданию облака разработчика включала запуск Spaces, S3-совместимого хранилища объектов, которое делает хостинг веб-ресурсов безболезненным. В сентябре 2018 года мы запустили встроенную функцию CDN для пространств, которая предоставляла возможность включить глобальное кэширование краев для пространства в любом из регионов, где были доступны пространства. Это позволило нашим клиентам быстрее доставлять ресурсы на свои веб-сайты и приложения до 70%.

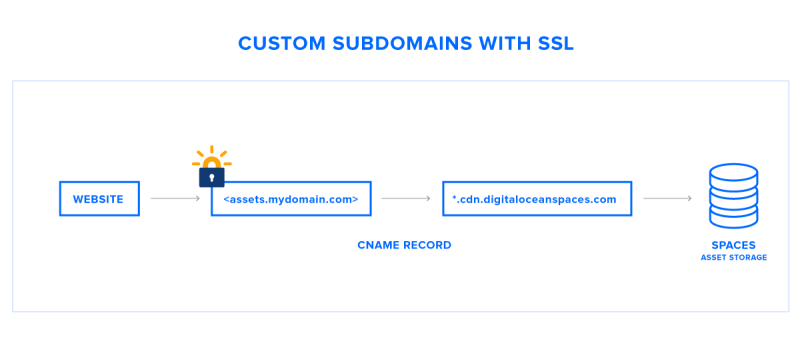

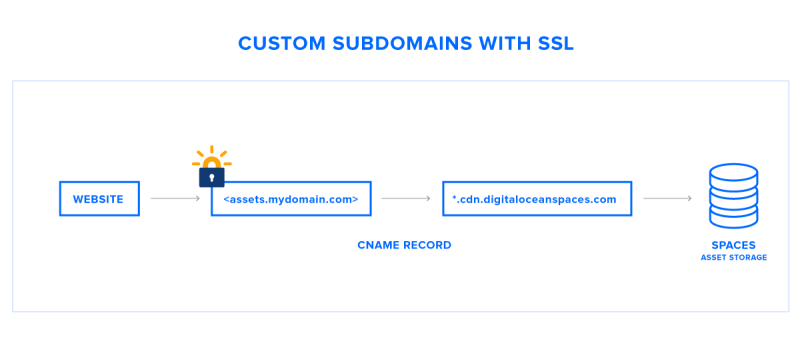

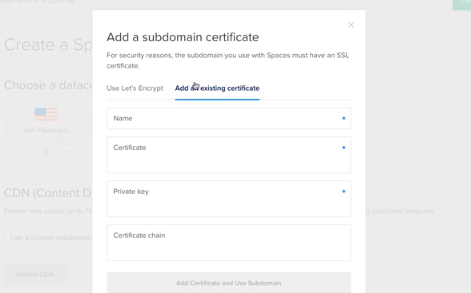

Сегодня мы рады объявить о создании пользовательских поддоменов для ваших конечных точек Spaces CDN. Теперь клиенты могут использовать собственный URL-адрес субдомена для доставки ресурсов из пространства, совместимого с S3, и защитить его с помощью сертификата TLS. Эти сертификаты могут быть выданы центром сертификации, самостоятельно подписаны или автоматически сгенерированы с помощью интеграции LetOCrypt от DigitalOcean без каких-либо дополнительных затрат.

Как это работает?

Как это работает?

Если у вас еще нет домена, вам необходимо приобрести его у регистратора доменных имен. Затем вам нужно настроить DNS-записи для вашего домена с помощью службы DNS-хостинга. Обратите внимание, что если вы планируете использовать интеграцию Let's Encrypt от DigitalOcean для создания сертификатов TLS для вашего поддоменов CDN, вам необходимо использовать службу DNS-хостинга DigitalOcean. Для самозаверяющих сертификатов вы можете использовать любой DNS-хостинг. Подробное руководство см. В нашей документации по продукту для пользовательских поддоменов.

www.digitalocean.com/docs/spaces/how-to/customize-cdn-endpoint

Добавьте запись DNS CNAME, такую как «assets», которая сопоставляется с конечной точкой CDN вашего Пространства, затем назначьте свой поддомен из меню «Настройки» для ранее существующего Пространства или при включении CDN для нового Пространства.

Зачем использовать пользовательские субдомены?

Есть несколько причин, по которым пользовательские субдомены могут быть полезны для вас.

Брендинг

Брендинг

Агентства и веб-разработчики, которые используют хранилище объектов Spaces для размещения своих активов, теперь могут использовать свой собственный поддомен. Это не только позволит избежать путаницы с конечными пользователями, но также сократит ваш технический стек. Никто, кроме вас, не должен знать, где вы размещаете свои цифровые активы.

Интегрированное управление SSL / TLS

Обеспечение вашего пространства является гибким и простым. Теперь вы можете загрузить сертификат для своего собственного субдомена или использовать бесплатный сертификат Let Encrypt, который можно легко получить всего несколькими щелчками мыши прямо из панели управления. Процесс создания сертификата Let Encrypt следует тем же простым принципам проектирования, которые использовались для создания сертификатов для балансировщиков нагрузки DigitalOcean.

www.digitalocean.com/products/load-balancer/

Простая конфигурация

Пользователям Spaces не нужно тратить дополнительные инженерные усилия на внедрение решения с обратным прокси-сервером для переадресации вызовов между *.cdn.digitaloceanspaces.com и *.myapp.com. Кроме того, при сопоставлении вашего собственного субдомена с конечной точкой CDN он автоматически добавляется в списки CORS, что экономит вам шаг. Теперь вы можете сосредоточиться на создании отличных приложений, а не на точной настройке инфраструктуры.

Нулевая стоимость

Пользовательские субдомены и интегрированное управление TLS включены в ваше пространство без каких-либо дополнительных затрат.

Что дальше

Хостинг веб-ресурсов — это только один вариант использования, который может использовать субдомен, подключенный к конечной точке CDN. Клиенты также просят размещать статические веб-сайты из своих пространств. Эта функция в настоящее время находится в стадии разработки и будет служить строительным блоком для фронт-энда как услуги, который использует некоторые из основных строительных блоков инфраструктуры хранения объектов и CDN, которые полюбились заказчикам.