Что мы сделали для вас в марте

Не будем долго рассуждать про сложную обстановку, просто скажем: мы с вами, на посту, заявленный SLA гарантируем. Стабильность работы — наш приоритет.

Страничка с полезными сервисами и акциями для бизнеса от наших коллег из Mail.ru Group: home.mail.ru/category/business/

Новости платформы Mail.ru Cloud Solutions за март

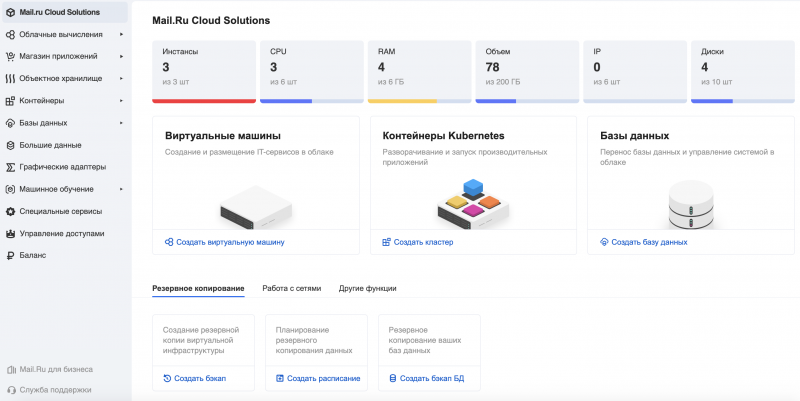

Удобная главная страница

На главной странице кабинета пользователя теперь представлены основные функции всех сервисов.

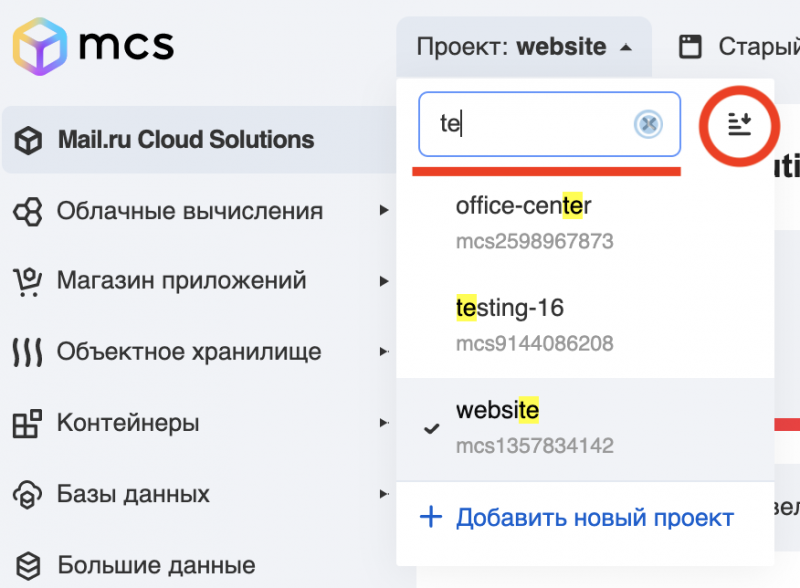

Поиск и сортировка в списке проектов

Когда у вас больше 5 проектов, бывает сложно найти нужный в списке. Поэтому мы добавили в список проектов поиск и кнопку сортировки.

Управляйте назначением внешнего IP-адреса при создании машины

Раньше публичный адрес назначался автоматически при создании машины. Теперь при создании машины появился флажок Назначить внешний IP, который можно убрать для машин в приватной сети. Эта возможность есть при создании виртуальных серверов, баз данных, балансировщиков.

Жёсткую перезагрузку теперь можно выполнять для выключенных машин

Например, при сбоях приложений или ОС. Для жёсткой перезагрузки выберите нужную машину в списке и нажмите Перезагрузить принудительно.

Образ диска машины без создания снапшота

Раньше для создания образа диска надо было делать его снапшот (снимок), из снимка делать новый непривязанный диск и с него уже делать образ. Теперь надо просто остановить машину и в разделе Образы сразу создать образ нужного диска. Если же нужно, чтобы машина продолжала работать в момент создания образа, образ диска работающей машины можно сделать по прежней схеме.

О создании образа в панели управления.

mcs.mail.ru/help/migration-to-mcs/image

Стоп и старт кластера для Kubernetes через веб-интерфейс

Теперь можно сделать через веб-интерфейс. Если вы остановите кластер, то не будете платить за использование памяти и процессорной мощности, пока он остановлен. Это может сэкономить вам до 60% для тестовых сред и является хорошей альтернативой спотовым инстансам.

Как Westwing Russia переехал с AWS на MCS

Технический директор Westwing Russia Александр Пряхин рассказывает, как компания переехала в облако MCS, чтобы предлагать российским клиентам все необходимое.

mcs.mail.ru/cloud-platform/success-story/westwing/

Почитать

Разработка и администрирование

- Хабр: Property-based тестирование для JavaScript и UI: необычный подход к автоматизированным тестам habr.com/ru/company/mailru/blog/494110/

- Хабр: Kubernetes в духе пиратства: наш путь к микросервисам и готовый шаблон для внедрения habr.com/ru/company/mailru/blog/490362/

Обзоры

- Завтра облачно: DBaaS побеждает традиционные базы данных: главные причины перенести базу данных в облако mcs.mail.ru/blog/dbaas-tradicionnye-bazy-dannyh-prichiny-perenosa-baz-v-oblako

- Завтра облачно: 6 выводов о Kubernetes: что волнует компании при внедрении этого инструмента mcs.mail.ru/blog/vyvody-o-kubernetes-chto-volnuet-kompanii-pri-vnedrenii

Новости

- VC: Беспилотные автомобили: сколько стоят, когда поступят в продажу и как ИИ справляется с бездорожьем и лихачами vc.ru/transport/116383-bespilotnye-avtomobili-skolko-stoyat-kogda-postupyat-v-prodazhu-i-kak-ii-spravlyaetsya-s-bezdorozhem-i-lihachami

- Завтра облачно: Тихая революция в VPN: почему маленький WireGuard победит IPsec? mcs.mail.ru/blog/revolyuciya-v-vpn-pochemu-malenkij-wireguard-pobedit-ipsec