Под Новый год у нас есть традиция. Нет, не ходить с друзьями в баню, а, конечно же, собирать дайджест года.

2025 получился плотным на события. Мы всерьез взялись за ИИ — внедрили AI-агентов, умные подсказки в саппорте и в наших сервисах. Прокачивали Kubernetes так, что апдейты выходили аж каждый месяц. Параллельно разгоняли мощности, осваивали новые регионы, релизили схему инфраструктуры, ивентили, брали премии… Так, без спойлеров!

Поехали распаковывать уходящий год в нашем большом рекапе →

В январе разогнались до 5 ГГц и запустили VMware

Решили не раскачиваться после праздников, а сразу добавить мощностей. Завезли серверы High CPU на AMD Ryzen 9 7950X с частотой до 5.5 ГГц в Москве. Конфигурации под любые аппетиты:

- Базовый минимум — 1х5.5 ГГц CPU / 1 ГБ RAM / 15 ГБ NVMe

- Роскошный максимум — 8х5.5 ГГц CPU / 16 ГБ RAM / 160 ГБ NVMe

Идеально для мгновенного отклика в 1С и Битрикс24, тяжелых баз данных и стабильной работы под высокими нагрузками.

А для более масштабных задач запустили публичное облако на базе VMware. Это не просто сервер, а полноценный виртуальный дата-центр с управлением через vCloud Director. Вы получаете полностью изолированные ресурсы и надежность уровня Enterprise.

- Под капотом связка серверов ASUS на Intel Xeon Gold (до 4.1 ГГц) и промышленной СХД NetApp

- И никаких капитальных затрат на свое оборудование и лицензии

В феврале заморозили S3 и прокачали почту

В феврале решили не отставать от погоды за окном и сделали холодный S3. Это идеальная «морозилка» для данных, которые не нужны каждый день, но должны быть под рукой на всякий случай.

В чем суть:

- Работает на более медленных дисках, поэтому стоит в разы дешевле стандартного хранилища

- Подходит для резервных копий, тяжелых архивов и логов за прошлые годы

А еще:

- Входящий трафик — бесплатно

- Исходящий — бесплатно первые 100 ГБ (для прайм-клиентов 1000 ГБ)

- Минимальный конфиг — от 1 ГБ

Допом прокачали корпоративную почту, добавив поддержку алиасов. Теперь к основному ящику можно привязывать альтернативные адреса, чтобы морозиться от спама и сохранять приватность.

Алиасы бесплатны — на один ящик можно создавать до десяти штук. Ищите новую вкладку в разделе «Настройки почтового ящика» → «Алиасы».

В марте открыли Франкфурт и упростили работу с дисками

Март получился про удобство и Германию.

Сначала про удобство: добавили возможность заказать сетевой диск NVMe или HDD в Санкт-Петербурге сразу при создании сервера. А еще уменьшили минимальный заказ HDD с 500 до 100 ГБ — теперь можно тестировать сетевые диски еще бюджетнее, не переплачивая за лишние полтерабайта.

Вторая новость марта — Guten Tag! Запустили долгожданную локацию в Германии. Франкфурт идеально подходит, если ваша аудитория находится в Европе или вам нужен надежный зарубежный узел связи.

За надежность отвечает NTT — разместили оборудование у одного из топовых мировых операторов ЦОД.

Отправиться в Дойчланд

В апреле запустили n8n в облачных серверах и Лондон-Париж в дедиках

Вспомним два апрельских релиза, которые вызвали бурный шквал «вау» в комьюнити.

Добавили в маркетплейс n8n — мощную open-source-платформу для автоматизации процессов. Теперь связывать разные сервисы можно без написания кода. Вы просто выбираете готовый образ n8n при создании сервера и собираете сценарии в удобном визуальном редакторе.

Можно интегрировать Телеграм, Google Таблицы и сотни других сервисов между собой. Пара кликов — и рутинные задачи выполняются сами, пока вы занимаетесь важным.

Затестили этот релиз и «в полях». Наш коллега поделился кейсом того, как настроил себе ассистента для рутинных задач.

t.me/timewebru/1731

И продолжили европейский тур. К Франкфурту добавились две столицы для выделенных серверов — Лондон и Париж. А процессоры мы подготовили на любой вкус и бюджет:

Нужно просто и надежно? Берите AMD EPYC 3151 2.7 ГГц

Нужна экстремальная мощность? Берите AMD EPYC 9354 с 32 ядрами

Затем выбирайте локацию, которая ближе к вашим пользователям, и наслаждайтесь скоростью.

В мае выпустили новую консоль и научили ноды в Кубере «самолечиться»

Пока кто-то жарил шашлыки, мы жарили релизы.

Сначала выкатили новую серийную консоль, которой так не хватало для комфортной работы с серверами. Теперь можно достучаться до сервера через браузер, даже если недоступен SSH или отвалилась сеть.

Почему это кайф:

- Копипаст: наконец-то работают привычные Ctrl+C / Ctrl+V

- Мышь: поддерживается скролл и выделение текста

- Удобство: подсветка синтаксиса включается одной кнопкой

- Скорость: консоль запускается мгновенно и не грузит вкладку

На новых серверах (которые вы создавали после мая) она включена по умолчанию. На старых (это те, что создавали до мая) — включается кнопкой в панели.

Затем запустили автохилинг воркер-нод для Kubernetes.

Или если по-простому — научили кластеры «лечить» себя самостоятельно, без участия инженеров.

Как это работает:

Система каждые 10 минут проверяет здоровье нод. Если видит статус NotReady или Failed:

- Сначала пробует аккуратно перезагрузить ноду

- Если не помогло — удаляет «больную» ноду и автоматически создает новую

Фича доступна для кластеров с автоскейлингом (без GPU). Для конкретных нод можно отключить автохилинг через лейбл kube-healer.kubernetes.io/healing-disabled:true.

В июне рисовали карту инфраструктуры и разрешили шерить серверы

Сначала про огромное событие — запуск визуализации инфраструктуры.

Это большая фича, которую мы внедрили первыми среди российских облаков. Теперь вам не нужно рисовать схемы в Miro или держать архитектуру проекта в голове — панель построит схему сама.

Что умеет схема:

- Строиться автоматически и показывать все связи внутри вашей инфраструктуры

- Жить в реальном времени — если добавили новый сервер, он сразу появится на схеме

- И кастомизироваться: сервисы можно группировать, добавлять к ним комментарии и др.

Всё это работает в полноэкранном режиме. Идеально, чтобы посмотреть на проект целиком и найти узкие места.

А еще мы реализовали одну из самых частых просьб — перенос серверов между аккаунтами. С бэкапами, IP и сетевыми дисками без тикетов и доп кликов.

Заходим в панель, выбираем сервер и нажимаем «Доступ»

Кликаем «Передать», указываем логин, на который переносится сервер, вводим код из почты и ждем апрува от получателя

Важно помнить — на время переноса любые действия с сервером будет временно заблокированы.

Команда Кубера работала в режиме конвейера, поэтому вместо долгих рассказов — короткая выжимка обновлений:

- Container Registry: запустили собственный реестр. Теперь хранить, загружать и скачивать Docker-образы можно внутри нашего облака.

- OpenID Connect: добавили поддержку OIDC. Настраивайте доступ через корпоративный IdP и забудьте про ручное управление правами доступа.

- Новые типы нод. Добавили High CPU, Dedicated CPU и GPU-ноды для тяжелых вычислений.

- TWC DBaaS Operator. Сделали свой аддон. Теперь разворачивать облачных базы (PostgreSQL, MySQL и Redis) и управлять ими можно через привычные YAML-манифесты.

- Scale to Zero. Научили группы нод масштабироваться в ноль. Идеально для тестовых окружений: ночью простаивают — вы не платите.

- Сетевые диски (CSI): полноценная поддержка persistent storage для баз данных, бэкапов и сохранения данных даже после перезапуска подов. Диски подключаются автоматически, чтобы приложения не теряли данные при рестартах.

- TWC Alert Bot: бот, который шлет уведомления о жизни кластера (рестарты, ошибки проб, падение нод) в Telegram, Discord или Slack.

- А еще мы сильно ускорили процесс выпуска обновлений версий Kubernetes. В 2025 выкатывали апдейты одними из первых на рынке и продолжим это и в 2026.

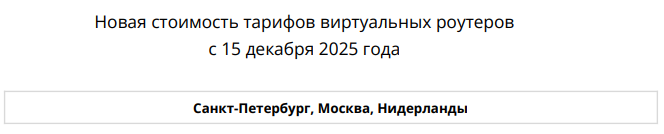

В июле запустили роутеры и status page

Июль — самый жаркий месяц года, и мы тоже были hot Точнее, наши релизы.

Первым делом выкатили виртуальные роутеры. Это спасение для тех, кто строит безопасные изолированные контуры.

Кейс: у вас есть серверы в закрытой частной сети (без доступа извне). Но им нужно ходить в интернет — например, качать обновления или отправлять данные.

Решение: подключаете виртуальный роутер, подключаете к нему приватную сеть и настраиваете SNAT. Серверы получают выход в сеть, оставаясь недоступными для входящего трафика извне.

Второй важный релиз — наш публичный status page.

Мы верим, что доверие строится на честности. Поэтому теперь состояние всех сервисов облака доступно вам в реальном времени.

Что там есть:

- Полная картина доступности по всем регионам

- Журнал инцидентов: если что-то сломалось, пишем об этом напрямую

- Постмортемы: подробные технические разборы инцидентов от нашего CTO

Там же можно подписаться на уведомления, чтобы узнавать о любых работах первыми.

В августе запустили AI-агентов и превратили тикеты в чат

Надеемся, в августе вы успели перехватить немного солнца и получить свою порцию дачных кабачков. Мы же закрывали лето мощным AI-релизом.

Запустили AI-агентов на базе LLM+RAG. Это не просто чат-бот, а конструктор умных помощников, которые читают вашу базу знаний. Вы загружаете в агента документацию, инструкцию и логи, и он превращается в эксперта:

- Отвечает на вопросы клиентов в поддержке

- Анализирует данные и генерирует отчеты

- Обучает новых сотрудников по вашим регламентам

Под капотом лучшие мозги: топовые модели GPT, DeepSeek, Claude, Grok и Gemini. Можно выбрать ту, которая подходит под бюджет и задачи.

Вторая новость — глобальный редизайн поддержки.

Мы окончательно убили формат устаревших тикетов. Теперь общение с инженерами выглядит как полноценный мессенджер, к которому вы привыкли. Почему это удобно:

- Переписка в формате живого диалога с историей, эмодзи, вложениями кода и файлов

- Все задачи, инциденты, архив и уведомления собраны в одном месте, не нужно прыгать по вкладкам

При этом история обращений никуда не делась — она аккуратно переехала в новый интерфейс.

В сентябре деплой из VS Code и сейф для данных S3

Пока все переворачивали календарь, мы переворачивали представление о деплое. Запустили MCP-сервер для App Platform (ex. Apps). Теперь, чтобы выкатить обновление, не нужно даже открывать браузер.

Как это меняет жизнь: вы пишете код в VS Code или Cursor, вводите одну команду — и приложение автоматически летит в облако. Без лишних кликов в панели и ручной настройки CI/CD.

Кстати, наш руководитель разработки, Миша Шпаков, записал для вас подробный туториал, как это настроить за пару минут. Зацените на досуге.

Помимо упрощенного деплоя выше выкатили Object Lock для S3. Функция позволяет «заморозить» объекты так, что их невозможно изменить или удалить в течение заданного времени.

Мы внедрили несколько режимов под разные сценарии угроз:

- GOVERNANCE — защита от ошибок. Рядовой пользователь удалить файл не сможет, но у админа с особыми правами такая возможность останется.

- COMPLIANCE — защита от катастроф. Файл нельзя удалить вообще никому — ни скрипту, ни хакеру, ни даже владельцу аккаунта с root-правами. Пока действует защита, данные бессмертны.

И без глобальной политики — тут блокировка версий объектов вообще не будет устанавливаться на бакете.

В октябре делали расходы и обновления предсказуемыми

Зарядились тыквенным латте и плотно поработали над прозрачностью финансов.

Мы полностью переделали историю списаний. Теперь вместо сухих цифр у вас перед глазами полноценная аналитика с графиками.

Вы сразу видите динамику трат. Легко отследить, в какой момент проект начал потреблять больше ресурсов или какой конкретный сервис «съедает» бюджет. Можно группировать данные по дням, неделям или месяцам и детализировать расходы в пару кликов.

А главный релиз стабильности — обновления по расписанию. Больше никаких сюрпризов с перезагрузкой баз данных или балансировщиков в разгар рабочего дня. Теперь вы сами решаете когда устанавливать обновления и патчи.

Как это работает: вы выставляете удобное окно (например ночью с 03:00 до 05:00), после чего все обновления будут происходить в этот интервал, пока ваши клиенты спят.

Бонус-трек: мгновенный импорт баз данных. Упростили жизнь тем, кто переезжает к нам или разворачивает новые среды. Теперь импортировать дамп в Managed PostgreSQL или MySQL можно буквально одной кнопкой.

Нужно: перейти в нужную базу → нажать кнопку «Импортировать» → ввести креды от базы-источника и выбрать владельца новой базы → done.

В ноябре были App Platform и автоскейлинг в S3

В ноябре были App Platform и автоскейлинг в S3

Ноябрь был суетным, но продуктивным. Мы попрощались со старым разделом Apps и выкатили вместо него мощный App Platform. Это полная перестройка архитектуры сервиса.

Что изменилось для разработчика:

- Импорт переменных: больше не нужно вбивать ключи руками. Просто загружаете свой .env-файл или вставляете текст через Ctrl+V.

- Актуальный стек: мы обновили вообще всё. Python 3.14, PHP 8.4, Node.js v24, свежие Go, .NET и Java — теперь доступны сразу.

Вторая вещь, которую мы убрали в ноябре, — неожиданная остановка проекта, когда бакет внезапно упирался в потолок по объему. Теперь S3 умеет масштабироваться автоматически.

Что важно знать:

- Появились новые тарифы стандартного S3: от 1 до 250 ГБ

- Всё, что выше 250 ГБ, считается по поресурсной тарификации. 2 ₽ за каждый гигабайт

- Объем хранения не ограничен — от 1 ГБ до ∞

- Холодное хранение теперь работает только по поресурсной модели

Всё подробно расписали в

доке.

Получили «вышку» по безопасности: аттестат УЗ-1 для 152-ФЗ

В этом году мы прошли самый сложный экзамен на безопасность и получили аттестат уровня УЗ-1.

Если коротко: это знак высшего качества защиты в рамках 152-ФЗ. Аудиторы проверили каждый винтик нашей платформы — от архитектуры до регламентов доступа сотрудников и подтвердили, что защита максимальна.

Локации с аттестацией: Москва, Санкт-Петербург, Новосибирск

В декабре добавляли и прокачивали ИИ в сервисах

На финишной прямой года мы успели положить еще пару ИИ-релизов под елку.

В недавно обновленный App Platform добавили TimewebGPT, чтобы он пристально следил за вашим деплоем и давал полный анализ по логам.

Когда ваш деплой завершается ошибкой, агент получает всё о вашем проекте:

- Логи сборки и запуска

- Язык и фреймворк

- Команду сборки, директорию, параметры и другие настройки

Теперь, если при развертывании возникает ошибка, вы получите конкретное объяснение: что не так → почему не так → как сделать, чтобы было так.

И конечно же, не обделили вниманием любимчиков пользователей — AI-агенты получили целую пачку улучшений. Кроме того, что мы добавили новинку GPT-5.2 в модельный ряд, в новых фичах:

- Научили AI-агентов работать не только в виджетах на сайте, но и через Telegram-ботов — вау!

- Индексация файлов баз знаний по ссылке. Достаточно вставить ссылку на файл, и агент автоматически скачает его и индексирует

- Реакции в виджете AI-агента — оценивайте ответы агента лайком или дизлайком. Так он будет знать, в какую сторону ему обучаться, а в какую не стоит

- Общая статистика по диалогу в истории чата, чтобы мониторить работу агента с пользователями

- И допом обновили страницу подключенных сервисов — теперь на ней отображаются AI-агенты и Базы знаний.

Вы предлагали — мы делали

Под конец года особенно приятно оглянуться назад и посмотреть, что получилось сделать вместе. В 2025-м вы активно делились идеями, а мы их аккуратно складывали в продуктовый мешок, чтобы потом достать и превратить в релизы.

- 815 идей мы получили от вас с начала года

- 210 реализовали в течение года

- 40 идей сейчас в работе и ждут своего часа уже в следующем году

Если посчитать, это 1,7 реализованных идей в день на протяжении всего года! И главное, всё по делу. Так, из идей выросли:

Container Registry для Kubernetes — упоминания часто всплывали в обсуждениях работы с кластерами, а в итоге появился полноценный сервис.

Интеграция n8n в маркетплейс — запрос на автоматизацию без костылей и долгой настройки. Забрали идею, сделали, выкатили.

И, конечно, App Platform. Огромное количество комментариев и фидбека по старым Apps помогли нам увидеть все болевые точки и задали направление для полной переработки платформы.

И еще один важный момент: в этом году мы перевалили за отметку в 1000 реализованных идей за всё время работы Timeweb Cloud. Поэтому хотим воспользоваться моментом и сказать спасибо за вашу вовлеченность и обратную связь. В новом году ждем от вас новые идеи — мы с удовольствием будем превращать их в релизы и в 2026!

Би-ту-би, блоги и рейтинги

Пока в панели появлялись новые фичи, за ее пределами тоже кипела жизнь. Встречи, кейсы, рейтинги, награды, выступления — всё, что происходило вокруг Timeweb Cloud в 2025, смотрите ниже.

Где встречались и что обсуждали

Инфраструктура — штука сложная, и иногда ее проще обсудить за живым разговором. Поэтому в этом году мы провели целых три собственных масштабных ивента.

Организовали закрытый мастермайнд в Москве для тех, кто строит и масштабирует инфраструктуру. Обсуждали рост проектов, сложные архитектурные кейсы и ограничения, с которыми сталкиваются команды.

На бизнес-завтраке в Москве с руководителями и топ-менеджерами обсуждали облака, архитектуру и кейсы за вкусной едой.

Впервые отправились в Казань и встретились с предпринимателями и ИТ-директорами, чтобы разобрать миграции, AI и сложные инфраструктурные сценарии.

Нам пишут: кейсы наших клиентов

- Не будем ходить вокруг да около — вот самые заметные истории наших клиентов в этом году:

- Медицинский онлайн-сервис НаПоправку написал о том, как обеспечить бесперебойную работу сервиса для 6 млн пациентов в месяц

- Компания uForce поделились опытом поддержки высоконагруженной SaaS-платформы с обработкой 6 000 видео в сутки

- И еще были GetCourse, которые построили почтовую систему в облаке на 10+ млн писем в день

Рейтинги, награды и другие достижения

- Не можем не поделиться. Мы стали лауреатами XXII Премии Рунета в номинации «Облачное решение года».

Для понимания масштаба: на премию подали 900 заявок из 44 регионов. В финал прошли всего по 6 проектов в 22 номинациях. И только 3 проекта в каждой категории экспертное жюри признало лучшими.

Вот чем еще мы отметились в этом году:

- Вошли в топ-10 рейтинга IaaS Enterprise 2025 от CNews

- Заняли 9 место в рейтинге крупнейших поставщиков IaaS-услуг в России от TAdviser

- Вошли в топ-500 крупнейших ИТ-компаний по версии CNews

- Взяли «Приз хакерских симпатий» от Standoff Bug Bounty на форуме Positive Hack Days

Записывали видео и давали интервью

- В 2025 мы всерьез взялись за производство видеоформата и запустили серию про наши сервисы. Первым в кадр вышли AI-агенты — показали, как они работают, в каких сферах применимы и чем будут полезны в проектах.

- Еще провели Kuber Talks, прямой эфир в Телеграме. Рассказали, как изменился Kubernetes за год, какие решения принимали, что тестировали и от чего отказались.

- Кроме наших видео, мы давали интервью в СМИ — про рынок, инфраструктуру и куда вообще движутся облака.

- Наш CEO Сергей Наумов пообщался с CNews о трендах облачного рынка, развитии инфраструктуры и новых потребностях бизнеса. А на TAdviser вышел большой обзор облачных решений с его комментариями.

- Максим Яковлев, наш СТО, тоже активно делился экспертизой и дал большое интервью для TAdviser о нашей собственной операторской сети, резервировании стоек, масштабировании платформы и переходе на 400G.

Книжная полка: что читали между релизами

- Разработчики отчитались: 5000+ доставок на прод

- Отчитывается и отдел контента: 1370+ публикаций — постов в соцсетях и статей в блогах

Наши блоги на Хабре, Виси, ДТФ и Пикабу, кстати, отличились в этом году не хуже, чем в прошлом. Давайте посмотрим:

- На Хабре — четвертый год уверенно занимаем позицию в топ-3 корпоративных блогов. Пишем много, интересно, без нейростатей — чтобы вам было полезно. И видим, что это так. Например, огромный огромный гайд по настройке рабочего окружения на 30 минут чтения сохранили в закладках аж 1077 раз.

- На ДТФ, напротив, стараемся вас немного отвлечь от технического контента в пользу развлекательного — про игры, фильмы и поп-культуру. В этом году часто вызывали приступ ностальгии и вспоминали любимые ретро-игры. Да так вспомнили, что собрали холивар на 366 комментариев.

- Блог на VC стал для нас настоящим экспериментом и вызовом — сможем ли его раскачать. Спойлер — смогли. Тут уверенно занимали 1 место в топе блогов целых три недели. А одна статья провисела в «Популярном» рекордные 16 часов. Не обошлось и без обзора сервисов: чего только стоит наша статья про Скайп.

- И, наконец, Пикабу. Блог, который приносит максимальные охваты. Не верите? А как вам такое — статья на целых 234к просмотров и 3 666 плюсов о том, как город в Норвегии купил себе солнце.

Уходящий 2025 показал, на что мы способны: на масштабные решения, глубокий рефакторинг сервисов, сложную инфраструктуру, большие ивенты и продукты, которые задают стандарты рынка.

Дальше — только интереснее. Увидимся в 2026 вместе с Timeweb Cloud!

Полный список, со всеми ссылками, если нужны подробности тут:

timeweb.cloud/blog/digest-2025