Hetzner Online: Первое место для веб-хостинг ++ Новый Tekktalk

Мы рады сообщить Вам о новых возможностях, а также новости компании в июне 2019г. Мы надеемся, что вы любите читать о темах этого информационного бюллетеня по:

1. HSP Awards 2019

Хостинг и провайдеров услуг Награды 2019: «Platinum» для Hetzner Online

Результаты в течение премии выбор читателей в этом году в представленной Vogel IT-Medien: первое место (Platinum) пошел Hetzner онлайн в категории «Webhosting».

В этом году ведущие компании в IT-индустрии встретились снова на хостинг и сервис-провайдер Summit во Франкфурте. Там они не только обсуждали последние тенденции, но и чествование победителей 11 категорий в хостинг и сервис-провайдер Awards.

Мы очень рады, что клиенты доверяют нам больше всего. Эта награда подтверждает, что продолжение разработки для наших веб-хостинг продуктов окупились

заявил руководитель отдела маркетинга, Christian Fitz.

Еще раз спасибо всем, кто принимал участие в опросе выбора читателя ХПП и кто помог нам выиграть Ваш голос!

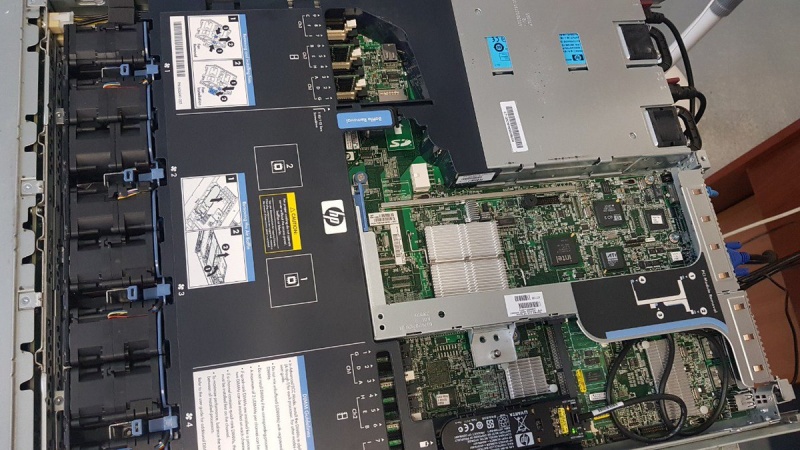

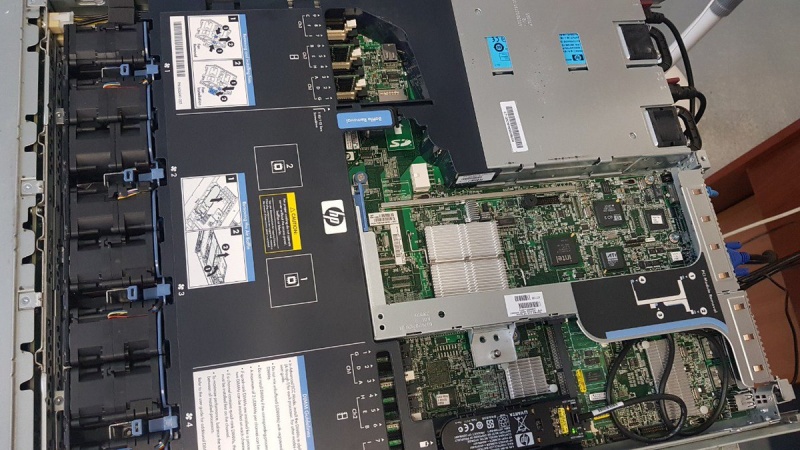

2. N-IX in DCP Nuremberg

Обмен Интернет — точка N-IX непосредственно в Центре данных Park Нюрнберге

Нюрнбергский Internet Exchange (N-IX), который имеет несколько мест в Нюрнберге, Германия, обеспечивает быстрый и экономичный обмен данных в северной Баварии.

Существует в настоящее время прямое N-IX место в нашем Data Center Park Нюрнберге, так Hetzner Online колокейшн клиенты, которые передают данные на местном уровне могут извлечь выгоду из частной взаимосвязи с чрезвычайно низкой задержкой.

Это устраняет необходимость в затратных маршрутов междугородних или даже международных перевозчиков, в свою очередь приводит к более финансовых сбережений и повышения надежности.

Заинтересовались? Вы можете найти более подробную информацию здесь о колокейшн

www.hetzner.com/colocation

3. New Images

Новые изображения: Debian 9.9 и Ubuntu 19.04

Мы сделали две новые версии доступны для установки программного обеспечения на специальных корневых серверов или vServers: Debian 9.9 и Ubuntu 19.04.

Новый выпуск Debian в основном состоит из новых обновлений безопасности.

Для получения более подробной информации, пожалуйста, ознакомьтесь с примечаниями к выпуску.

Ubuntu 19,04 базируется на Linux ядра 5.0 и будет поддерживаться до января 2020 года.

В дополнение к обновлениям программного обеспечения виртуализации, этот релиз Ubuntu включает в себя несколько обновлений ToolChain и текущие версии OpenStack, Open VSWITCH, DPKG и самбу.

Подробнее об этом в примечаниях к выпуску

www.debian.org/News/2019/20190427

wiki.ubuntu.com/DiscoDingo/ReleaseNotes

4. konsoleH

Новое: Настройка расширения веб — сервера на konsoleH

Теперь возможно настроить три полезных расширений веб-сервера для управляемого сервера и веб-хостинга счетов. Вы можете активировать или деактивировать каждый модуль расширения для удовлетворения ваших личных потребностей:

HTTP/2 (повышает скорость и безопасность для передачи данных)

Дефлятируют (выполняет сжатие без потерь данных, уменьшает объем данных)

PageSpeed (оптимизирует кэшируемости = экономит ресурсы веб-сайтов между посещениями)

Вы можете найти модули расширения в konsoleH, перейдя в «Услугах, расширение веб — сервере», или если у вас есть управляемый сервер, вы можете найти их весь сервер в «Управлении счета, расширение веб — сервере».

5. konsoleH

Статистика konsoleH веб — Свободна с отдельным логином

Там хорошая новость для клиентов konsoleH! Теперь

вы можете дать вашим собственным клиентам или коллегам отдельные Логины, чтобы они могли получить доступ к веб-статистики, и ничего другого. Чтобы сделать это, сначала нужно войти в свою учетную запись для konsoleH интерфейса администрирования с вашим номером клиента и паролем.

Вы можете найти ссылки и доступ к данным, которые вам нужны, перейдя в «Службу; Вход данные; веб-статистика».

6. New #Tekktalk

Новый #Tekktalk — Объемы

В последнем #Tekktalk, Маркус и Кэти из Hetzner Online чата о некоторых из основ для томов, решение для хранения блока для Hetzner Cloud.

Возьмите пик!

Найти больше видео о Hetzner онлайн на нашем канале

YouTube

Наш полный ассортимент продукции можно найти на сайте

hetzner.com

Если у Вас есть какие-либо вопросы, наша служба поддержки будет рада помочь. Просто посетите Центр поддержки по адресу Hetzner

www.hetzner.com/support-center