Организуем личную базу знаний: тест 3-х сервисов

Закладки в браузере, хаотичные записи в Notes и мысли в голове растут с геометрической прогрессией. Структурировать знания и навести порядок в текстовых и графических записях поможет личная база знаний.

Специально для блога Selectel, Ксения Калинина исследовала три популярных сервиса и делится впечатлениями.

Скорее всего, сейчас многие из ваших записей хранятся на Google диске, а ссылки, которые вы прочитаете «когда-нибудь потом», — в открытых вкладках браузера, но это не всегда практично и удобно. Рассмотрели менее очевидные способы для организации баз знаний. Они просты и удобны: имеют веб-версию и мобильное приложение, поддерживают совместную работу и импорт файлов с разных площадок.

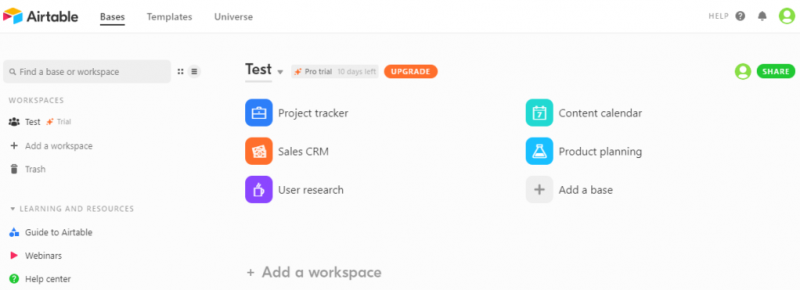

Airtable табличный

Удобный инструмент для создания многофункциональных таблиц.

Удобство. Широкий функционал Airtable немного усложняет интуитивный онбординг, но внутри приложения предусмотрены подробные инструкции и подсказки. Можно выбрать предустановленные шаблоны, чтобы сделать работу проще и быстрее.

Минусы. Может показаться слишком сложным и запутанным при первом использовании.

Что порадовало. Основной упор в приложении сделан на таблицы. Их наполнение может быть не только текстовым: добавляйте фото, ссылки, цветовые пометки и так далее. Загруженные в базу документы доступны для просмотра, но редактировать внутри Airtable их нельзя. Таблицы можно связать между собой – занесенные в одну таблицу данные будут отображаться и в другой. Звучит сложнее, чем работает.

Навигация. В приложении легко создавать разветвленную структуру базы знаний. Можно организовать несколько рабочих пространств и добавлять тематические секции с иконками. Внутри каждой секции обычно находятся несколько листов с таблицами. А внутри таблиц – страницы с данными отдельной строки.

Для упрощения навигации можно добавить блок поиска по документам. Но эта функция почти бесполезна, если вы заносите данные на русском языке. Поиск работает для пяти языков, и русский туда не входит. Дополнительный стимул вести понятную базу знаний, в которой все можно найти вручную.

Вердикт. Airtable подходит для структуризации данных, но требует тщательного изучения, чтобы стать Power User.

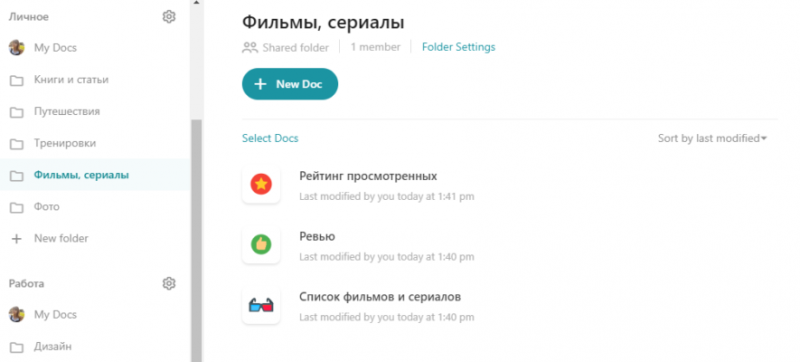

Рабочий Notion

Универсальное рабочее пространство.

Удобство. В приложении много готовых шаблонов для разных типов документов. Есть возможность создавать и собственные «трафареты» для стандартизации заметок.

Минусы. Полностью на английском языке, что для кого-то может стать проблемой. Освоить базовые функции можно самостоятельно, а вот для более продвинутой работы стоит изучить гайды и скринкасты. Можно найти их на сайте Notion, YouTube-канале или рунете.

Что полезного. Документы поддерживают все наиболее распространенные форматы – доски, таблицы, ссылки, фото и видео. На таблицах остановимся подробнее, ведь они представляют целую базу данных. Каждая строка таблицы имеет отдельную страницу внутри документа, куда можно записать подробную информацию.

Notion открыт для новых пользователей, которые до этого размещали свои документы на разных носителях. Так, кроме банального импорта файлов с рабочего стола и Google Диска, возможен импорт досок из Trello, файлов из Asana и Evernote.

Навигация. Внутри приложения есть разделение хранилища на workspace и private, что снижает риск случайно поделиться с коллегами личной информацией. Совместная работа тоже доступна, но этим никого не удивишь.

Все страницы отображаются в боковом меню. Масштабируемость структуры – одно из преимуществ Notion. Каждую категорию бокового меню можно дополнить несколькими подкатегориями, которые также подвластны делению.

Вердикт. Приложение Notion поможет организовать документы и заметки в одном месте.

Мульти Coda

Документ, который стремится быть приложением.

Удобство. Организация документов и таблиц понятна на интуитивном уровне. Благодаря шаблонам легко создать личную базу. В приложении есть галерея документов, где хранятся файлы других пользователей. Можно посмотреть, как другие организуют знания, и вносить изменения в документы. Не переживайте, они все равно не сохранятся и не доставят никому проблем.

Функционал. Импортированные из Google Drive документы отображаются также, как на диске, форматирование не «съезжает». В документ можно интегрировать диаграмму Ганта, видео, кнопки с разными действиями. С помощью шаблонов таблиц удобно организовать список фильмов, программу тренировок, рабочие задачи.

Большой плюс. Coda можно связывать с другими сервисами: Instagram, YouTube, Wikipedia, а также Gmail, Slack и Jira в платной версии. Документ становится не только пассивной базой знаний, но и связующим звеном разных приложений.

Основной инструмент в Coda — таблицы. Множество шаблонов и легкость создания делают их мощным инструментом для структуризации данных. Таблицы можно связать между собой в одну сложную базу данных.

Навигация. Корневые папки структуры отображаются в боковом меню. Внутри них – документы, которые могут содержать неограниченное количество страниц и подстраниц.

Минус. Для просмотра одной ветки иерархии целиком придется открывать файл в папке. Только оттуда доступен просмотр имеющихся страниц.

Вердикт. Coda дает больше, чем просто организацию знаний. В приложение есть почти все, что необходимо современному человеку для работы.

В заключение, предлагаем несколько советов для создания собственной базы знаний.

От теории к практике

Чек-лист для организации личной базы знаний:

• Определите цель.

Организация базы знаний ради организации базы знаний – плохая идея. Вы точно должны понимать, к чему стремитесь. Глобально, цель – сохранить и доступно организовать знания, чтобы работать и учиться более эффективно.

• Создайте единое пространство для хранения.

Соберите все свои локальные заметки, документы, фотографии, скриншоты и таблицы в одном сервисе. Так вы свяжете их в единую систему (пресловутую базу знаний) и в зависимости от выбранного инструмента будете пользоваться такими преимуществами, как доступ к данным с любого устройства, синхронизация, удобство хранения.

• Возьмите за основу уже сохраненную информацию.

Приятная вещь в организации базы знаний – вы никогда не столкнетесь со страхом чистого листа. Структура хранилища создается на основе данных, которые уже пылятся на полке под грифом «Меня сложно найти, легко потерять и невозможно запомнить». Просто разделите их на отдельные секции.

• Позаботьтесь о масштабируемости структуры.

Нет смысла дробить информацию на слишком детализированные папки и документы. Лучше всего начать с крупных тематических секций и наполнять их контентом. Если почувствуете необходимость, создайте более удобное и прицельное разделение. Плодить в базе знаний папки с одним-двумя файлами и заметками – неэффективно. Это создаст видимость порядка, но будет неудобно для навигации и масштабирования. Ведь тогда добавление заметок потребует создания новых папок и дальнейшего усложнения структуры.

• Сделайте новые заметки понятными.

Добавляя ссылку или файл в базу знаний, подпишите их. Сегодня вы знаете, в чем состоит ценность этой информации и где ее можно применить. А завтра? А через неделю? Отметьте полезность каждого нового материала, чтобы не тратить время на рефлексию и попытки проникнуть в сознание себя вчерашнего.

• Не стремитесь к идеалу.

База знаний – инструмент для эффективного структурирования информации. А инструмент проверяется и настраивается в работе. Помните о динамичности и гибкости. Структура кажется удобной и полезной сейчас, но через какое-то время потребует доработки и реорганизации.

Воспользуйтесь правилом ленивого человека: не придумывайте нового. Базы знаний упрощают жизнь. Не пытайтесь с первого раза сделать структуру идеальной. Все равно не получится, а вы зря потратите время.

• Будьте безжалостны.

Не добавляйте в заметки то, что «возможно, пригодится». Все данные в базе знаний должны иметь реальную ценность. Регулярно пересматривайте файлы и удаляйте ненужное. Информация очень быстро устаревает. Иногда мы сохраняем файлы для решения оперативных задач и больше никогда их не используем. Если вы изначально понимаете, что данные нужны ненадолго, поставьте пометку и удалите их после использования.