Желаю вам счастливого и безопасного праздника

community.centminmod.com/threads/wish-everyone-a-safe-happy-holidays-2021.22283/

Это электронное письмо информирует вас о важных обновлениях безопасности Centmin Mod, которые доступны сейчас и требуют вашего немедленного внимания.

Это рассылка Centmin Mod охватывает некоторые важные обновления, о которых вам следует прочитать, если вы используете стек Centmin Mod LEMP. Наиболее важные обновления обычно публикуются на форуме Centmin Mod News по адресу

community.centminmod.com/forums/centmin-mod-news.3/. Вы можете отказаться от подписки на эти рассылки, выполнив инструкции в конце этого письма. Тем не менее, я настоятельно рекомендую вам продолжать получать эти рассылки, поскольку они обычно отправляются только для обеспечения безопасности и серьезных обновлений для исправления ошибок. Или просто подписывайтесь на Centmin Mod в Twitterhttps://twitter.com/centminmod ;)

Если вы откладываете обновление мода Centmin из-за ваших настроек и т. Д., Прочтите это руководство о том, как обновить и сделать резервную копию ваших настроек на

community.centminmod.com/threads/how-to-upgrade-centmin-mod-backing-up-customisations.8092/

Если вы найдете Centmin Mod полезным, помните, что есть способы поддержать Centmin Mod финансово

community.centminmod.com/threads/ways-to-support-centmin-mod.11435/ ;) Я хотел бы поблагодарить всех участников кто обновился до премиум-членства на форуме

community.centminmod.com/premium. Ваша поддержка очень ценится :)

Форум модов Centmin, обновления и новости сайта

В официальном блоге Centmin Mod есть больше обновлений и активности для более глубокого погружения в некоторые темы, представляющие интерес для пользователей Centmin Mod

blog.centminmod.com

Количество сайтов с поддержкой Centmin Mod с высоким трафиком растет в течение нескольких месяцев, когда они появляются в отчете HTTP Archive Core Web Vital Technology

blog.centminmod.com/2021/10/18/2622/http-archives-core-web-vital-technology-report/. В отчете учитываются только исходные сайты, трафик которых соответствует пороговому значению для включения отчета Google Chrome User Experience (CRuX). Моей первоначальной целью для Centmin Mod было разработать веб-стек, который может масштабироваться и работать для моих собственных сайтов и для сайтов с высоким трафиком, чтобы извлечь выгоду из улучшений производительности и масштабируемости, которые я добавляю в Centmin Mod. Отчет определенно подтверждает, что Centmin Mod движется в правильном направлении.

Обновления кода мода Centmin

Также были другие обновления как для веток 123.08stable, так и для новых веток github 123.09beta01, поэтому вы захотите обновить свой код Centmin Mod, как описано на

centminmod.com/upgrade.html через параметры подменю в пункте 23 меню centmin.sh 1 и 2 для стабильной версии 123.08 или с помощью команды cmupdate для версии 123.09beta01 или выше.

123.08 стабильный

—

github.com/centminmod/centminmod/tree/123.08stable

—

community.centminmod.com/threads/centmin-mod-1-2-3-eva2000-08-how-to-install-update.4061/

123.09beta01

—

github.com/centminmod/centminmod/tree/123.09beta01

—

community.centminmod.com/threads/centmin-mod-09-beta-branch-testing.4128/

Праздничные обновления, включая установку сервера Redis по умолчанию

Удалось втиснуть несколько исправлений ошибок и улучшений Centmin Mod 123.09beta01, которые вы можете увидеть в списке на

community.centminmod.com/forums/centmin-mod-github-commits.41/?prefix_id=19. В том числе несколько улучшений скорости начальной установки для установок PHP 7+ и 8+ по умолчанию. Одним из ключевых обновлений является установка сервера Redis во время начальной установки Centmin Mod

community.centminmod.com/threads/install-redis-server-by-default-in-123-09beta01.22297/. Для существующих пользователей Centmin Mod, запуск команды cmupdate для обновления кода локального сервера, а затем запуск опции 1 или 2 подменю 13 пункта меню centmin.sh должен автоматически определять, установлен ли сервер Redis или нет, и автоматически устанавливать сервер Redis, если он еще не установлен.

Обновления PHP 7.4.27, 8.0.14 и 8.1.1

Были исправлены ошибки PHP и обновления безопасности, поэтому вы хотите быть в курсе последних событий, используя команду cmupdate + пункт меню 5 centmin.sh

community.centminmod.com/threads/php-8-0-13-7-4-26-7-3-33-security-update-backported-php-7-2-34-7-1-33-7-0-33-5-6-40.22148/. Хотя с тех пор было выпущено еще одно обновление версии для выпусков с исправлениями ошибок, поэтому смотрите версии ниже, чтобы узнать последние на момент написания. Примечание. Centmin Mod 123.08stable полностью поддерживает только максимальную версию PHP 7.0.33 и в настоящее время не имеет встроенных исправлений. Для более поздней версии PHP и поддержки исправлений с обратным переносом вам необходимо использовать Centmin Mod 123.09beta01 для поддержки PHP 7.1, 7.2, 7.3, 7.4 и 8.0.

- Добавлена ошибка PHP 5.6.40 EOL и исправления безопасности.

- Добавлена ошибка PHP 7.0.33 EOL и исправления безопасности.

- Добавлена ошибка PHP 7.1.33 EOL и исправления безопасности.

- Добавлена ошибка PHP 7.2.34 EOL и исправления безопасности.

- Добавлена ошибка PHP 7.3.33 EOL и исправления безопасности.

- Последняя стабильная версия PHP 7.4.27 с обновлениями безопасности и исправления ошибок.

- Последняя стабильная версия PHP 8.0.14 с обновлениями безопасности и исправления ошибок.

- Последняя стабильная версия PHP 8.1.1 с обновлениями безопасности и исправления ошибок.

Обновления и исправления интеграции SSL-сертификата Letsencrypt

Процедуры интеграции Letsencrypt в Centmin Mod 123.09beta01 в последнее время претерпели множество обновлений из-за истечения срока действия сертификата DST Root CA X3 Letsencrypt 30 сентября 2021 года, что вызвало проблемы с сайтом у некоторых посетителей в старых браузерах и клиентах и привело к сбою системных клиентов, таких как wget и curl. В блоге Centmin Mod описано, как я решил эти проблемы и какие шаги нужно предпринять пользователям Centmin Mod на

blog.centminmod.com/2021/10/02/2425/centmin-mod-managing-letsencrypt-dst-root-ca-x3-certificate-expiration-on-centos-7/ и на форумах по адресу

community.centminmod.com/threads/letsencrypt-dst-root-ca-x3-expiration-september-30-2021-workaround-on-centos-7-x-openssl-1-0-2.21965/

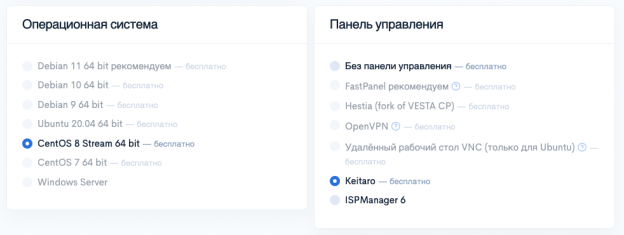

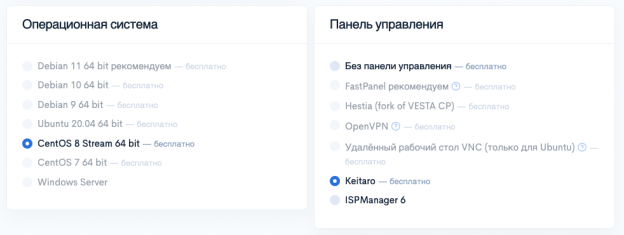

Centmin Mod CentOS 8 Тестирование совместимости

CentOS 8 выпущен уже давно. Тем не менее, Centmin Mod требует некоторой доработки, чтобы обеспечить его совместимость с CentOS 8 и новыми операционными системами AlmaLinux 8 и Rocky Linux 8, альтернативными EL8. Вы можете следить за рабочим журналом разработки и совместимости по адресу

community.centminmod.com/threads/centmin-mod-centos-8-compatibility-worklog.18372/ и за тегом CentOS 8 на форуме по адресу

community.centminmod.com/forums/centos-redhat-oracle-linux-news.31/?prefix_id=81

Хорошая новость заключается в том, что люди VPSDime

centminmod.com/vpsdime/ были достаточно любезны, чтобы предоставить несколько серверов VPS для выделенных AlmaLinux 8 и Rocky Linux 8 на совместимость и тестирование разработки для Centmin Mod. VPS имеет 12-16 потоков процессора, поэтому идеально подходит для более быстрой компиляции кода и тестирования, необходимого для Centmin Mod. В их линейке Premium VPS есть серверы, оснащенные более старыми процессорами Xeon. Однако у них есть возможность подключения к сети 10 Гбит / с. Вы можете увидеть более старые тесты производительности, которые я провел на

community.centminmod.com/threads/4gb-vpsdime-premium-kvm-vps-benchmarks-review.10646/

Обновление кода мода Centmin.

Для стабильной версии .08 прочтите информацию об обновлении / обновлении на

community.centminmod.com/threads/centmin-mod-1-2-3-eva2000-08-how-to-install-update.4061/ (настоятельно рекомендуется вы обновляете или используете 123.09beta01)

Для бета-версий .09 прочтите информацию на

community.centminmod.com/threads/centmin-mod-09-beta-branch-testing.4128/

Или для обоих посмотрите обновления командной строки git на

community.centminmod.com/threads/working-with-git-command-line-for-updating-centmin-mod-local-copies.2150/ и auto cronjob обновление

community.centminmod.com/threads/cronjob-auto-updating-centmin-mod-08-beta03-how-to-guide.3398/. На официальной странице сайта также есть информация по адресу

centminmod.com/upgrade.html

Премиум-членство в Centmin Mod

Я хотел бы поблагодарить тех участников, которые уже перешли на премиум-членство форума сообщества модов Centmin по адресу

community.centminmod.com/premium. Ваша поддержка очень ценится, так как собранные деньги идут на centminmod.com расходов на эксплуатацию, хостинг и лицензирование для поддержания centminmod.com сайта centminmod.com и форумов сообщества :) В качестве сценария dbbackup.sh для MySQL добавлено преимущество для членов Premium. резервное копирование базы данных — он поддерживает локальное резервное копирование, облачное резервное копирование Amazon S3 и до 3 отдельных удаленных мест резервного копирования ftp

community.centminmod.com/threads/dbbackup-sh-quick-mysql-database-backups-for-centmin-mod-stack.4573/

Centmin Mod Facebook, Twitter

Страницы Centmin Mod в социальных сетях можно найти по адресу

community.centminmod.com/threads/centmin-mod-social-media-pages.1290/

увидимся на форумах, и если вы еще не представились на вводных форумах

community.centminmod.com/forums/introductions.5/, возможно, вы захотите это сделать;)

ваше здоровье

Георгий / eva2000