OVH et OVH US: working together

С созданием OVH US группа расширяет свое присутствие на крупнейшем и наиболее зрелом рынке в мире. Реальная проблема, особенно для компании, рост которой пока был органичным. Ставки высоки, но проблема особенно мотивирована, потому что каждый должен получить, группу, ее рост и своих клиентов, как объяснил Рассел Ридер, президент и главный исполнительный директор OVH US, и Джон Газал, директор трансформация для OVH.

Почему OVH решила ступить на американскую землю?

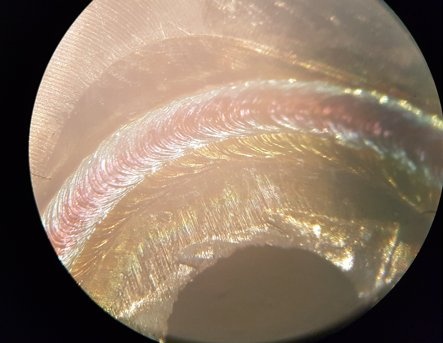

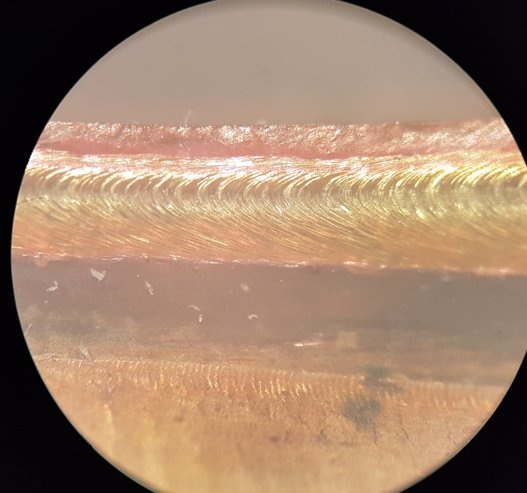

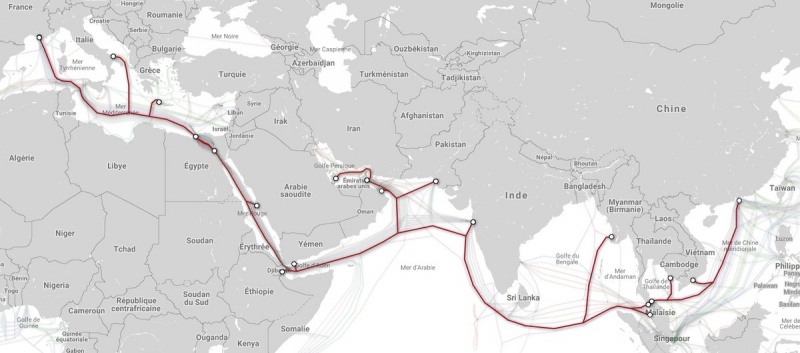

Russel Reeder. На глобальной арене облачного хостинга доля США оценивается в 57%. Важно экономически, этот рынок также является самым зрелым, потому что большинство компаний уже не первое поколение облаков, даже самых маленьких. Клиенты точно знают, чего хотят, и их уровень ожидания особенно высок. Таким образом, OVH сталкивается с самым требовательным облачным рынком. Большая проблема, но та, которая позволяет всей группе прогрессировать. Кроме того, OVH имеет серьезные преимущества, такие как уровень автоматизации, гиперсекретируемая волоконно-оптическая сеть, собственные центры обработки данных на восточном и западном побережьях, опыт сотрудников, «зеленые» технологии и культура лучшее соотношение между производительностью и ценой предложений. Это также состояние ума, которое OVH импортирует в Соединенные Штаты.

Джон Газаль. Для компании с высоким ростом, такой как OVH, это место на таком большом рынке является логическим продолжением. Многие новинки рождаются там, и наши основные конкуренты присутствуют. Нам нужно многому научиться на этом рынке, продвигаться все лучше и быстрее. После нашего создания в Канаде это был также естественный шаг. Благодаря приобретению vCloud Air мы начинаем с существующей базы больших счетов и, прежде всего, мы полагаемся на команду великих профессионалов.

Как вы восприняли культурный шок?

Джон Газаль. Реальная проблема заключается не столько в культурных различиях, сколько в интеграции двух команд с очень разными корпоративными культурами. Исторически сложилось, что OVH органично развивается, используя свои таланты, чтобы вдохнуть свое мышление в новые географические области. С интеграцией команды в США мы решили увидеть проблему корпоративной культуры как возможность проверить наши способы мышления и работы. Мы запустили программу «Работать вместе», которая стала мостиком слушания и объединения между двумя культурами и командами. Например, как и многие технологические игроки, OVH исторически имеет очень ориентированную на продукт культуру. Наши американские коллеги — эксперты по продуктам, но у них гораздо больше культуры, ориентированной на клиента. Это отражается на их организации, их процессах, управлении их командами и даже на их языке!

Russel Reeder — Эта нога на американском континенте представляет собой важный шаг, если не необходимый, в развитии OVH. Это возможность оценить его масштабируемость, процессы, дорожную карту и т. Д. Нам также необходимо интегрировать американское настроение «все о казни» для достижения наших амбиций.

Каковы ключевые моменты успеха такого предприятия?

Russel Reeder — Учитывая зрелость рынка, у клиентов большие надежды на продукты и услуги. Они хотят, чтобы это было просто, что оно идет быстро и что оно новаторское. Мы должны действительно сосредоточиться на потребностях клиента, его ожиданиях, проблемах, его идеях. Так много европейских компаний сломали свои зубы на рынке США, особенно в секторе новых технологий…

Джон Газаль — В дополнение к нашей способности удовлетворить требовательные ожидания рынка США, наш успех также включает в себя талант человека. OVH базируется в Соединенных Штатах в команде высококвалифицированных сотрудников, которые на протяжении многих лет находятся на облачном рынке и возглавляются признанными профессионалами. Они знают все входы и выходы и являются ценным ресурсом для развития OVH в Соединенных Штатах. Они пользуются большой автономией, работая с остальной группой.

Где вы находитесь в своей дорожной карте?

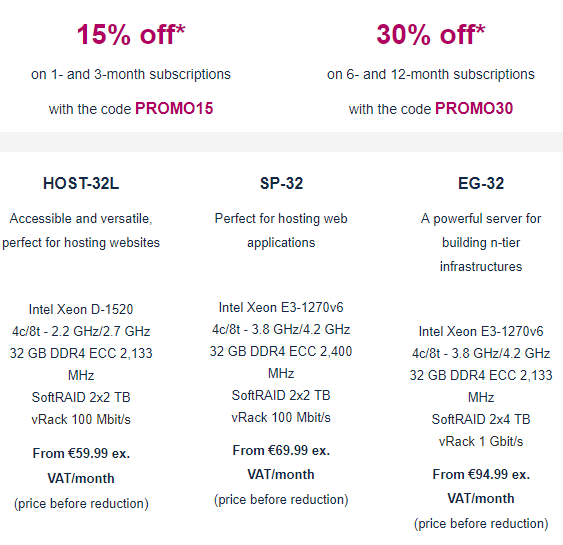

Russel Reeder — Выражение, которое приходит мне в голову, обычно англо-саксонское: «Приготовление с газом. Это означает выполнение после длительного периода неопределенности. Наша дорожная карта в первую очередь заключалась в создании юридически изолированной структуры США, чтобы обеспечить защиту данных других клиентов — что мы и сделали. Тогда нам пришлось более широко развить нашу известность. В этом смысле приобретение VMware vCloud Air стало огромным увеличением видимости для бренда OVH. Мы также открыли наш первый центр обработки данных на Восточном побережье и изменили наши услуги. Наконец, мы открыли наш второй центр обработки данных на западном побережье. Сегодня звезды выровнены и доступны первые выделенные серверные предложения. Теперь мы будем запускать другие продукты, Private Cloud, Public Cloud и VPS, чтобы они соответствовали ожиданиям клиентов и их стандартам.

Джон Газаль — проект на международном уровне всегда является сложным приключением, по языковым, культурным, маркетинговым, юридическим, финансовым причинам… Это особенно верно на самом развитом рынке в мире. Мы прошли долгий путь и столкнулись со многими проблемами. Американское приключение оказалось намного сложнее, чем запуск в новой зоне в Европе, но мы смогли справиться с этим со страстью и приверженностью, столь уникальной для мышления OVH. Новая глава открывается для нашей компании, но особенно для наших клиентов. В лучшем случае, если мы будем успешными, так же как и наши клиенты, и это наша самая большая награда!

Почему OVH решила ступить на американскую землю?

Russel Reeder. На глобальной арене облачного хостинга доля США оценивается в 57%. Важно экономически, этот рынок также является самым зрелым, потому что большинство компаний уже не первое поколение облаков, даже самых маленьких. Клиенты точно знают, чего хотят, и их уровень ожидания особенно высок. Таким образом, OVH сталкивается с самым требовательным облачным рынком. Большая проблема, но та, которая позволяет всей группе прогрессировать. Кроме того, OVH имеет серьезные преимущества, такие как уровень автоматизации, гиперсекретируемая волоконно-оптическая сеть, собственные центры обработки данных на восточном и западном побережьях, опыт сотрудников, «зеленые» технологии и культура лучшее соотношение между производительностью и ценой предложений. Это также состояние ума, которое OVH импортирует в Соединенные Штаты.

Джон Газаль. Для компании с высоким ростом, такой как OVH, это место на таком большом рынке является логическим продолжением. Многие новинки рождаются там, и наши основные конкуренты присутствуют. Нам нужно многому научиться на этом рынке, продвигаться все лучше и быстрее. После нашего создания в Канаде это был также естественный шаг. Благодаря приобретению vCloud Air мы начинаем с существующей базы больших счетов и, прежде всего, мы полагаемся на команду великих профессионалов.

Как вы восприняли культурный шок?

Джон Газаль. Реальная проблема заключается не столько в культурных различиях, сколько в интеграции двух команд с очень разными корпоративными культурами. Исторически сложилось, что OVH органично развивается, используя свои таланты, чтобы вдохнуть свое мышление в новые географические области. С интеграцией команды в США мы решили увидеть проблему корпоративной культуры как возможность проверить наши способы мышления и работы. Мы запустили программу «Работать вместе», которая стала мостиком слушания и объединения между двумя культурами и командами. Например, как и многие технологические игроки, OVH исторически имеет очень ориентированную на продукт культуру. Наши американские коллеги — эксперты по продуктам, но у них гораздо больше культуры, ориентированной на клиента. Это отражается на их организации, их процессах, управлении их командами и даже на их языке!

Russel Reeder — Эта нога на американском континенте представляет собой важный шаг, если не необходимый, в развитии OVH. Это возможность оценить его масштабируемость, процессы, дорожную карту и т. Д. Нам также необходимо интегрировать американское настроение «все о казни» для достижения наших амбиций.

Каковы ключевые моменты успеха такого предприятия?

Russel Reeder — Учитывая зрелость рынка, у клиентов большие надежды на продукты и услуги. Они хотят, чтобы это было просто, что оно идет быстро и что оно новаторское. Мы должны действительно сосредоточиться на потребностях клиента, его ожиданиях, проблемах, его идеях. Так много европейских компаний сломали свои зубы на рынке США, особенно в секторе новых технологий…

Джон Газаль — В дополнение к нашей способности удовлетворить требовательные ожидания рынка США, наш успех также включает в себя талант человека. OVH базируется в Соединенных Штатах в команде высококвалифицированных сотрудников, которые на протяжении многих лет находятся на облачном рынке и возглавляются признанными профессионалами. Они знают все входы и выходы и являются ценным ресурсом для развития OVH в Соединенных Штатах. Они пользуются большой автономией, работая с остальной группой.

Где вы находитесь в своей дорожной карте?

Russel Reeder — Выражение, которое приходит мне в голову, обычно англо-саксонское: «Приготовление с газом. Это означает выполнение после длительного периода неопределенности. Наша дорожная карта в первую очередь заключалась в создании юридически изолированной структуры США, чтобы обеспечить защиту данных других клиентов — что мы и сделали. Тогда нам пришлось более широко развить нашу известность. В этом смысле приобретение VMware vCloud Air стало огромным увеличением видимости для бренда OVH. Мы также открыли наш первый центр обработки данных на Восточном побережье и изменили наши услуги. Наконец, мы открыли наш второй центр обработки данных на западном побережье. Сегодня звезды выровнены и доступны первые выделенные серверные предложения. Теперь мы будем запускать другие продукты, Private Cloud, Public Cloud и VPS, чтобы они соответствовали ожиданиям клиентов и их стандартам.

Джон Газаль — проект на международном уровне всегда является сложным приключением, по языковым, культурным, маркетинговым, юридическим, финансовым причинам… Это особенно верно на самом развитом рынке в мире. Мы прошли долгий путь и столкнулись со многими проблемами. Американское приключение оказалось намного сложнее, чем запуск в новой зоне в Европе, но мы смогли справиться с этим со страстью и приверженностью, столь уникальной для мышления OVH. Новая глава открывается для нашей компании, но особенно для наших клиентов. В лучшем случае, если мы будем успешными, так же как и наши клиенты, и это наша самая большая награда!