Не операторы связи, а ЦОД: почему дата-центры наконец признали отдельной отраслью и что это значит для бизнеса

На связи Антон Турсунов. Я главный по эксплуатации центров обработки данных облачного провайдера Nubes, то есть директор по этой самой эксплуатации. И с удовольствием делюсь экспертным мнением по любым вопросам, касающимся дата-центров.

Сегодня расскажу об изменениях в законе «О связи», которые вступят в силу 1 марта 2026 года, и о том, действительно ли создание четких правил игры позволит отрасли развиваться более динамично, привлекать инвестиции и обеспечивать надежную инфраструктуру для хранения и обработки данных в масштабах страны.

Погнали!

Законодательство реагирует на тренд

Российский рынок ЦОДов очень быстро растёт — на 10-13 тысяч стойко-мест в год (13-18%). При этом частные инвесторы вкладывают в новые дата-центры порядка 55 млрд рублей в год, что составляет половину инвестиций в их строительство. Вторую половину затрат на ЦОДы берёт на себя государство.

Такими совместными усилиями каждый год вводятся в строй 20-25 новых частных и государственных дата-центров, что даёт клиентам облачных провайдеров возможность ещё быстрее наращивать мощности, повышать производительность, а также минимизировать простои IT-сервисов при технических проблемах. Проще говоря, чем больше ЦОДов, тем бизнесу лучше.

Однако, помимо возрастания нужд частного сектора, увеличивается доля государственных услуг для граждан, а также импортозамещённых сервисов. Строительство ЦОДов уже стало трендом, на который государство просто не может не реагировать, как заинтересованная сторона. В связи с этим стремление урегулировать деятельность рынка облачных сервисов вполне логично и ожидаемо.

Главные из ожидаемых нововведений:

- появление единого реестра ЦОД под управлением Минцифры;

- запрет майнинга в зарегистрированных дата-центрах;

- упрощение регуляторной нагрузки на операторов;

- возможности строительства по концессионным и ГЧП-соглашениям.

На позитивной волне

Итак, понятие «ЦОД» наконец-то будет чётко сформулировано в правовом поле. Под ним, согласно инициативе, подразумевается совокупность зданий, частей зданий или помещений с единым назначением, которые должны включать инженерно‑технические системы, предназначенные для размещения оборудования по обработке и хранению данных.

Раньше ЦОДы и операторы связи воспринимались пусть не как единое целое, но уж точно как ближайшие родственники. Теперь такие компании наконец разделятся. То есть к дата-центрам не будут применяться чуждые для них нормативные требования (обеспечение устойчивости функционирования систем связи, организация хранения метаданных и прочее). Это первый безусловный плюс для облачного бизнеса.

Второй ― перспективы увеличения инвестирования в отрасль. Но стоит учитывать, что в этом вопросе многое будет зависеть от реакции рынка на происходящие изменения. При этом предусмотренные новым законодательным актом реестр и классификация позволят дата-центрам рассчитывать на участие в программах государственной поддержки. Инициатива вполне способна обеспечить системный подход к поддержке ЦОД как объектов IT-инфраструктуры, а также она позволит изменить распределение господдержки и селективное финансирование закупок российского оборудования.

Также, с появлением реестра отрасль начнёт работать по единым правилам, а не каждый оператор ― в собственной парадигме. То есть бизнесу станет легче сравнивать поставщиков облачных услуг перед принятием конечного решения, что, безусловно, выгодно и удобно.

А с запретом майнинга в зарегистрированных дата-центрах будет исключена возможность получать льготы и субсидии направленные для поддержки ЦОД.

Кого сильнее зацепит ветер перемен

Большинство существующих дата-центров уже соответствует требованиям Федерального закона №152-ФЗ и Федерального закона №149-ФЗ, а также имеют необходимые сертификаты соответствия в области информационной безопасности. То есть нововведение сильнее всего затронет новых игроков рынка. Именно перед ними встанет вопрос обеспечения надлежащего оформления документации, необходимой для вхождения в реестр (исполнение требований к организации систем резервирования, противопожарной защиты, терморегуляции, отказоустойчивости IT-инфраструктуры). Все эти параметры станут обязательными для вхождения в реестр. А те, кто не сможет соответствовать установленным требованиям, неизбежно сойдут с дистанции. Что касается крупных игроков рынка, у них появится возможность стать ещё сильнее благодаря покупке активов менее конкурентоспособных. Не исключено и создание крупных объединений небольших операторов. То есть отрасль, вероятнее всего, подвергнется существенной реструктуризации.

К слову, благодаря просеиванию через реестр конечным потребителям облачных услуг станет удобнее оценивать уровень зрелости провайдеров и их готовность/неготовность к долгосрочному сотрудничеству.

Цифровое неравенство регионов, до свидания?

Появление реестра и нормативов способно помочь с устранением барьеров для появления дата-центров в российских регионах. Привлекательными для строительства ЦОД окажутся Рязанская, Новгородская и Тверская области. Они уже показывают значительный инвестиционный потенциал, и участвуют в реализации проектов по постройке ЦОД.

Перспективными локациями также способны стать Архангельская и Мурманская области, так как в этих регионах подходящий температурный режим, минимальные геополитические риски, а также Кольская АЭС, благодаря которой можно решить вопрос энергоснабжения. Схожая ситуация наблюдается в Сибири и на Дальнем Востоке.

Высоким потенциалом обладают крупные региональные центры с развитой транспортной доступностью, такие как Екатеринбург, Новосибирск, Казань, Красноярск и Челябинск.

После вступления закона в силу мы надеемся на появление новых точек присутствия и увеличение доступности услуг для региональных клиентов. Однако следует помнить, что строительство ЦОДов напрямую зависит от оптоволоконных сетей и стабильного интернет-соединения… И тут вся надежда на частное инвестирование и доступность мер государственной поддержки регионов.

А напоследок я скажу

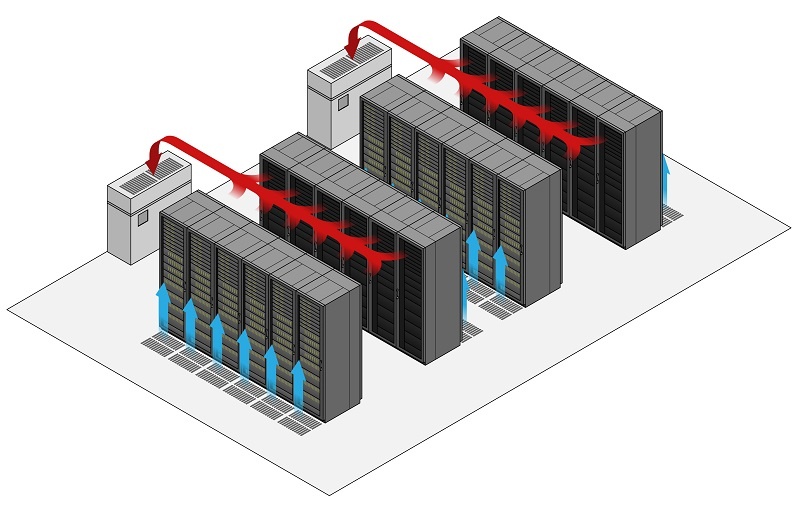

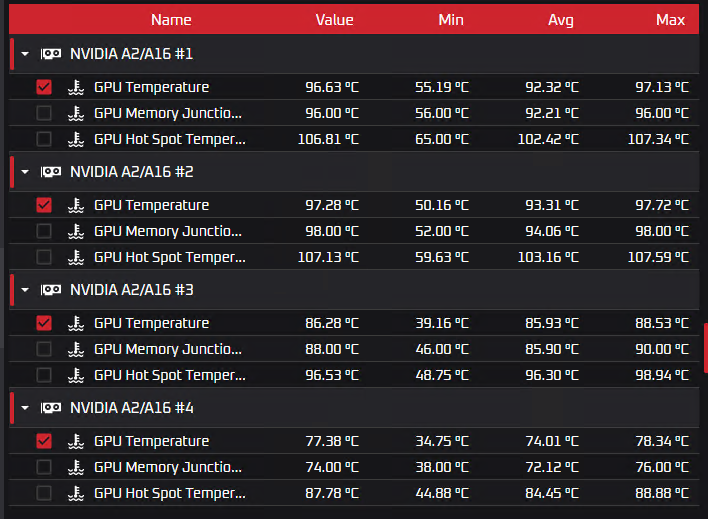

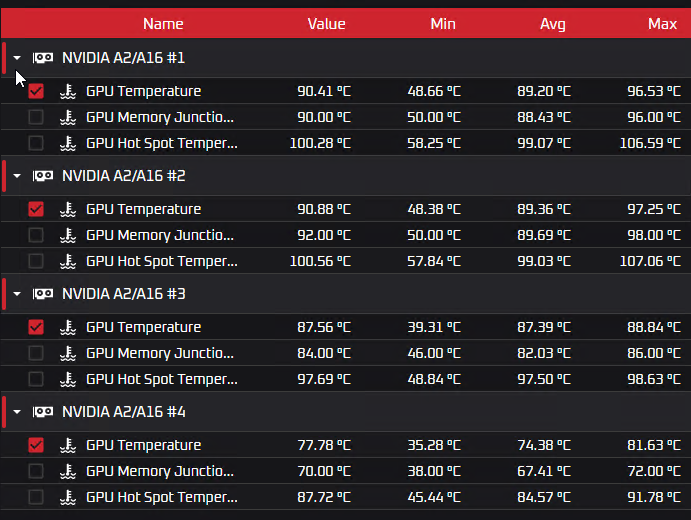

Максимально практичным решением для представителей бизнеса, пользующегося облачными сервисами, будет выбор в пользу тех провайдеров, которые уже сейчас соответствуют всем необходимым критериям информационной безопасности. Следует обращать внимание на выполнение требований федеральных законов №149-ФЗ и №152-ФЗ, организацию систем резервирования, противопожарной защиты, терморегуляции, отказоустойчивости IT-инфраструктуры. Так вы сможете обезопасить себя от потери данных и ненужной спешки в случае внезапного краха своего нынешнего поставщика облачных услуг.