Какую систему управления сайтом использовать под свой проект? Конечно, хочется самую лучшую, удобную и популярную. И такие существуют.

WordPress

Самая популярная бесплатная система управления для сайтов на протяжении многих лет. Первоначально созданная для блогов, платформа завоевала сердца миллионов вебмастеров. По данным рейтинга Amazon Alexa за 2018 год — 30% всех сайтов в интернете используют именно этот движок.

В декабре 2018 года была выпущена новая версия — Bebo, которая была снабжена новым блочным редактором. Для ценителей «классики», создатели обещали оставить поддержку предшественника до 21 года. Самая свежая версия на сегодняшний день 5.1.1 доступна для скачивания на официальном сайте движка.

Почему?

- Большое количество шаблонов, модулей и плагинов.

- Обилие документации, видеоуроков, форумов и сообществ.

- Легко найти разработчика.

- Регулярное обновление.

Для кого

В первую очередь для блогов, информационных ресурсов, сайтов-визиток и корпоративных сайтов. WordPress даже используют для интернет-магазинов благодаря таким плагинам, как WooCommerce. Тем не менее, эта CMS больше подходит для информационных сайтов.

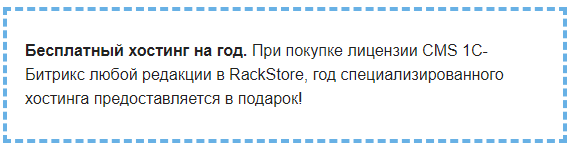

1С-Битрикс

Самая популярная и распространенная платная CMS. Идеальный движок для интернет-магазина, который обладает набором функций в зависимости от своей редакции. Например, редакция 1С-Битрикс Малый бизнес содержит: ядро магазина с личным кабинетом и корзиной; модули управления ценами, заказами и доставкой; интеграцию с Битрикс-24 и CRM-системами; дилерские и аффилиатские сети; модуль безопасности; интеграцию с платежными системами; форумы и блоги; опросы, А/Б тестирования; подписки и рассылки; модуль конверсии и т.д.

Самый максимальный функционал для интернет-магазина CMS 1С-Битрикс заключен в редакции Бизнес. Он обладает более расширенным функционалом: управлением продажами товаров и услуг; обменом данными с 1С в режиме реального времени; автоматизации обработки заказов. Добавляются модули: бизнес-процессов, конструктора отчетов, документооборота, социальных сетей, почты, календаря и т.д.

Почему?

- Наличие шаблонов и дополнительных модулей.

- Большого количество документаций, инструкций.

- Повышенная безопасность платформы.

- Поддержка большого количества форматов баз данных, возможности интеграции с системами 1C и другими бухгалтерскими программами.

- Широкий выбор параметров и настроек.

- Регулярное обновление.

Для кого

В первую очередь для интернет-магазинов. Пожалуй, лучший инструмент, который содержит в себе все необходимые данные для удобной и эффективной работы ресурсов e-commerce. Также используется для корпоративных сайтов, информационных порталов, рекламных лендингов. Для разного функционала сайта и величины бизнеса предусмотрена своя редакция.

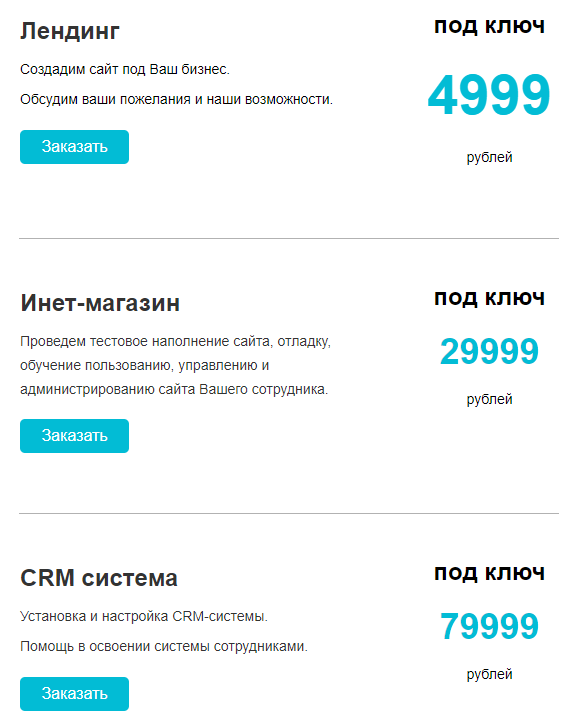

rackstore.ru/cms.html

rackstore.ru/cms.html