Самый мощный сервер Supermicro в Москве на основе AMD Epyc

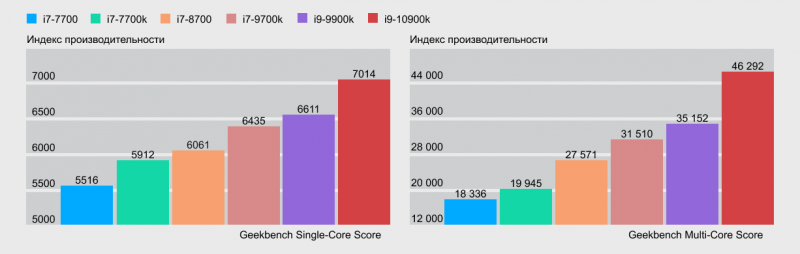

Многие годы на рынке серверных процессоров и чипсетов безоговорочно правил Intel с его ксеонами, но в 2017 году AMD наконец составили им конкуренцию, выпустив первую линейку своих новых серверных процессоров EPYC. С тех пор позиция их только укрепилась, а модельный ряд пополнился новой версией «эпиков». AMD поставляет свои современные процессоры многим известным компаниям, среди них Dropbox, Hetzner, Linode, ЦЕРН, OVHcloud, Scaleway, несколько университетов и организаций поменьше, включая дата-центры. Все хвалят платформы на EPYC и рекомендуют их для организации и масштабирования кластера высокопроизводительных серверов.

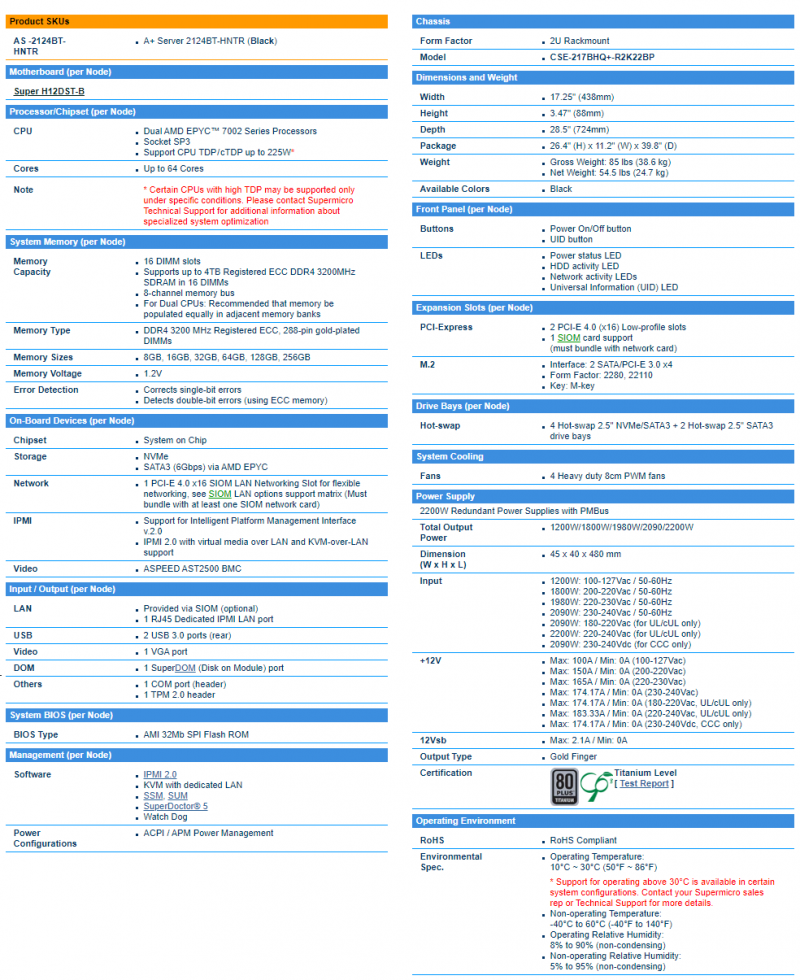

Когда начали поступать новости, о том что AMD начал делать процессоры, которые обходят по

производительности и по соотношению цена/качество процессоры Intel, мы начали задумываться об отдельной услуге на этой платформе. Выбор пал на Supermicro A+ Server 2124BT-HNTR. Сервер состоит из 4-х нод, каждая нода имеет следующую спецификацию:

- Процессоры: 2x AMD EPYC 7742 64-Core Processor 2.25GHz;

- Память: 16x64GB RAM 3200 MT/s;

- NVMe-диски для кластера: 4x INTEL SSDPE2KE076T8;

- Системный диск: 1x INTEL SSDSC2KB240G8;

- Сетевой контроллер: AOC-MH25G-m2S2T.

Подобного сервера в Москве и России не нашлось, нам пришлось заказывать его напрямую у

производителя. После ожидания, которое дополнилось некоторыми логистическими проблемами, связанными с COVID-19, сервер оказался у нас в начале июня.

Сборка

На первый взгляд нам показалось, что ничего особенно эпичного в сервере нет, поскольку мы имеем опыт работы с платформами по 12 нод для услуги Hi-CPU серверов. Эта же платформа представляет всего четыре независимых ноды, но мы ещё не понимали, какую мощь они дают в совокупности.

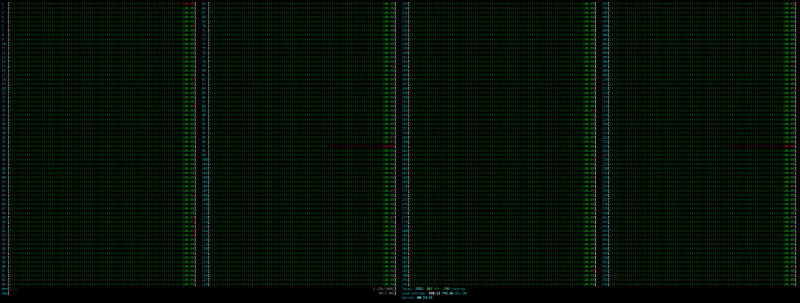

Тесты

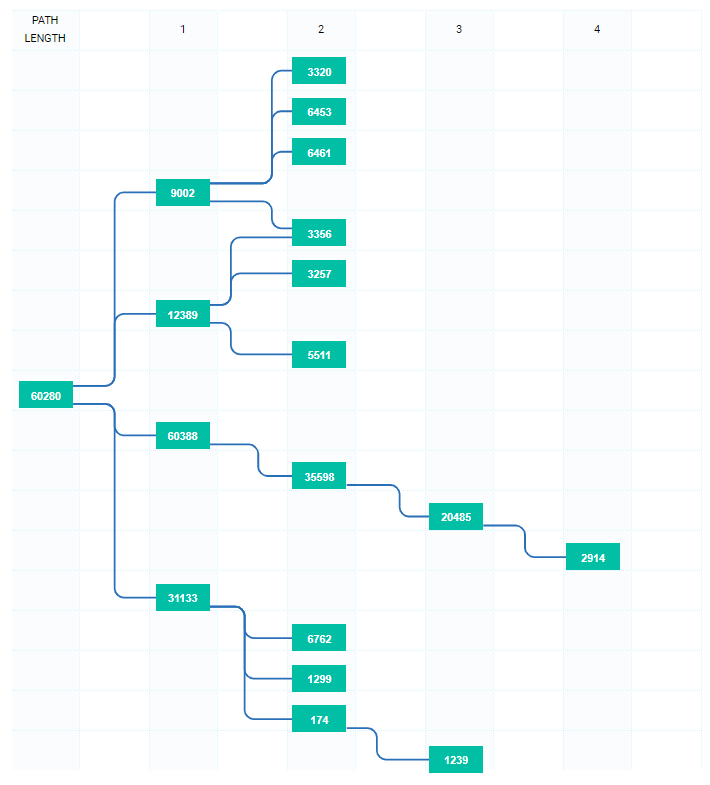

После сборки нам, разумеется, захотелось нагрузить сервер, мы ведь имеем дело с монстром, в

сумме, у которого на 4-х нодах: 1024 ядра, 4TB ОЗУ:

Результаты тестов производительности произвели на нас впечатление. Качество сборки от инженеров Supermicro тоже порадовало.

Монтаж

Смонтировали в стойку и начали собирать кластер:

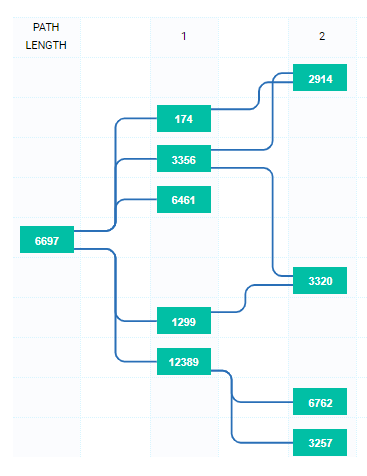

Кластер собран на этих 4-х нодах. В дальнейшем кластер может масштабироваться на подобном

оборудовании или на аналогичном от других вендоров. Публичная сеть кластера находится на

интерфейсах 25Gbps (SFP28), приватная сеть также 25Gbps (SFP28).

Доработка ПО

Основы и принципы, заложенные в программное обеспечение по управлению клиентскими услугами, позволили в короткие сроки доработать код для новой архитектуры, в середине июня услуга Эпичные серверы была запущена.

Преимущества для нас и клиентов

AMD EPYC позволяет создавать тарифы вплоть до ЭПИЧНЫХ 128 x 3.4 GHz CPU / 512 GB RAM / 4000 GB NVMe, чего никто не может предложить на платформе с процессорами от Intel. Кроме того мы используем Only NVMe сетевое хранилище с тройной репликацией данных.

За 2 месяца работы с данной платформой мы прочувствовали все её прелести — клиентам можно предоставлять те же ресурсы, что и в случае с Intel, но за меньшие деньги. Одна нода с 2-мя CPU от AMD заменяет 10 нод с 2-мя CPU Intel Scalable Silver.

Ложка дегтя

Такой сервер очень дорогой — стоимость около $ 150 000 и, естественно, покупался по полной предоплате, по сути мы покупали кота в мешке так как ранее не работали с серверами на AMD.

Второй момент, QEMU-KVM не позволяет налету мигрировать виртуальные машины с AMD на Intel и обратно, но используя наш функционал резервных копий можно без потерь данных перейти из одного типа серверов на другой в любой момент.

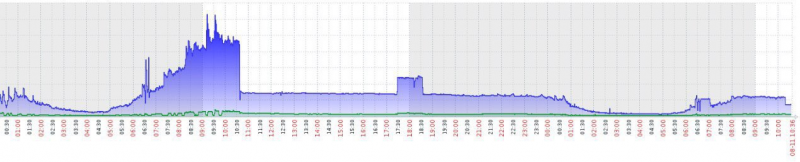

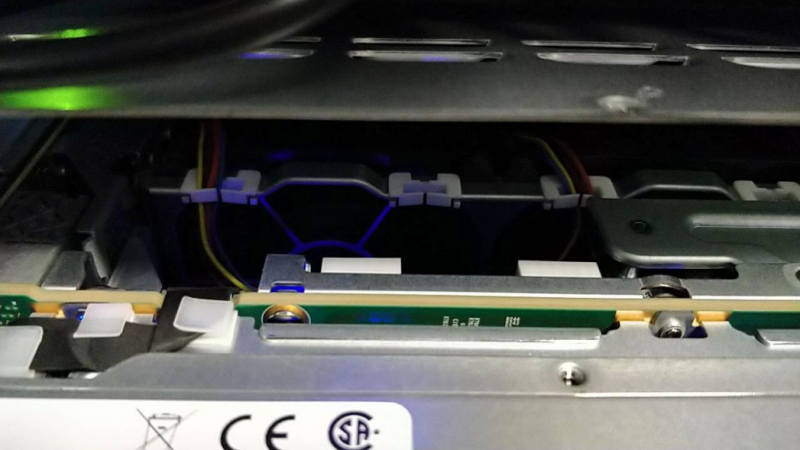

Кластер показал для нас неведомые до этого показатели производительности, что естественно

стало влиять на температуру процессоров. Даже при нагрузке процессоров 30% на ноде, температура подбиралась к отметке 95 градусов. Мы несколько оптимизировали охлаждение в

стойке, но какого-то либо значительного результата это не дало. Тогда в виде теста сняли крышку на корпусе сервера:

Скачок температуры вниз составил более 10 градусов и не превышает 80 градусов, даже при

нагрузке более 70%, что более чем нас удовлетворяет. Также в планах поставить дополнительное охлаждение в стойку.

Итог

В результате, сервер более чем оправдал наши ожидания, процессор AMD EPYC 7742 кажется нам неубиваемым в нагрузке. Схема, построенная на подобных решениях, будет дальше

масштабироваться, со временем планируем запустить эту услугу в Нидерландах. Нам понравилось работать с EPYC и надеемся, что и вам тоже понравится!