В этом году – 10 лет, как запущен наш

первый ЦОД OST-1. За это время мы с коллегами из службы эксплуатации и капитального строительства успели провести не одну модернизацию инженерной инфраструктуры дата-центра. Сегодня расскажу про самые интересные случаи.

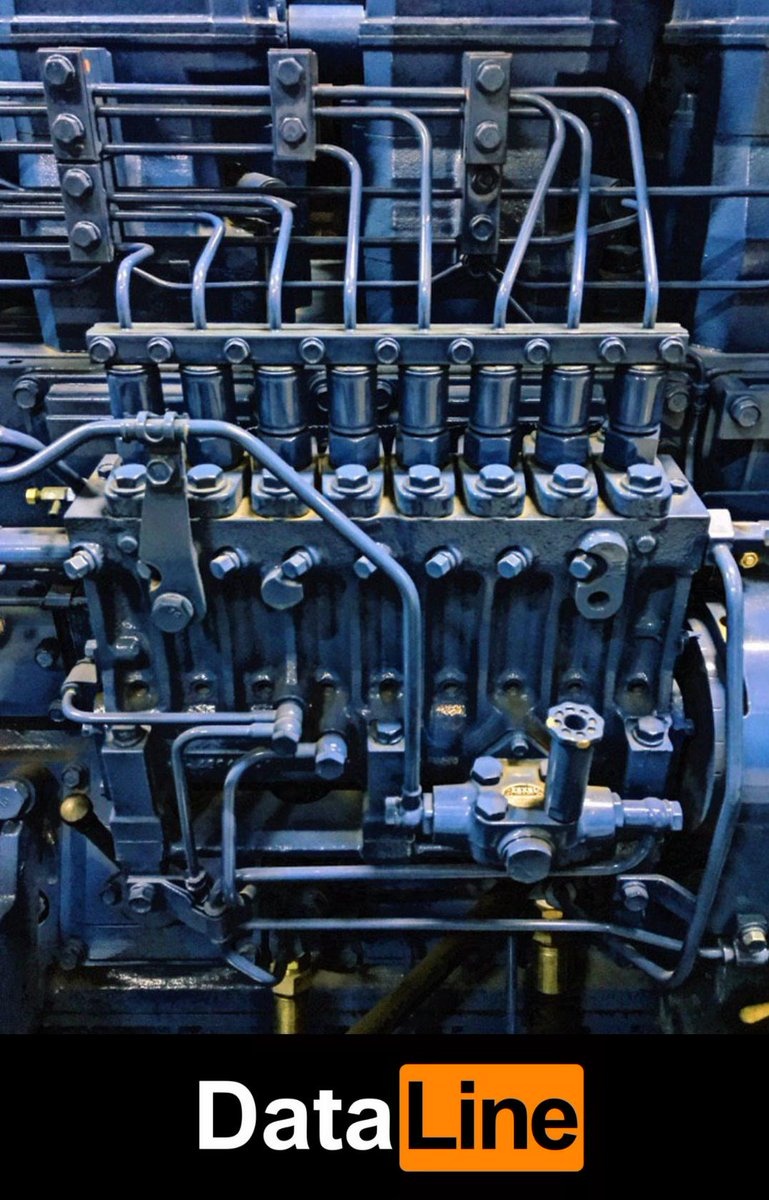

200-тонный кран устанавливает новый чиллер Stulz на раму. Модернизация системы холодоснабжения системы дата-центра OST-1 в 2015 году.

Дата-центр – живой организм, он растет, меняется, ломается:) Все, что можно отнести к модернизации, я условно делю на:

- плановые замены и ремонты. Оборудование морально устаревает, истекает его срок эксплуатации. Такие работы мы бюджетируем, планируем и делаем без спешки, когда нам удобно (например, полный апргейд «внутренностей» ИБП или замену выработавших свой срок аккумуляторных батарей).

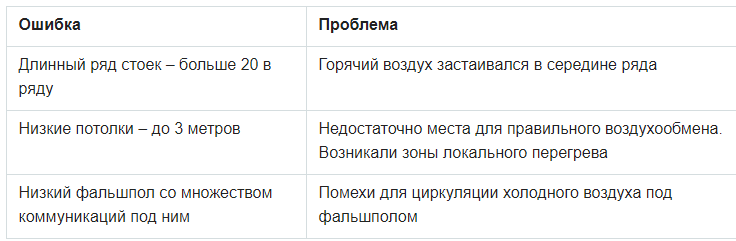

- ошибки проектирования. По заветам Uptime, все должно расходоваться и заканчиваться одновременно. Из-за неправильного проектирования баланс «холод – электричество – место» может нарушиться, например: есть куда ставить стойки, но зал уже не тянет по электричеству или кондиционированию. Самое неприятное с этими ошибками то, что всплывают они не сразу, а когда ЦОД приближается к проектной мощности.

- аварии. Бывает, что оборудование повреждается окончательно, бесповоротно и неожиданно, и его нужно менять.

На плановых заменах/ремонтах останавливаться не буду. Там практически все в нашей власти. Расскажу три истории об ошибках проектирования и послеаварийной модернизации.

История 1. Машинному залу не хватало холода

Это история про один из наших первых залов на Боровой. Он до сих пор работает. Зал с проектной мощностью 80 стоек по 5 кВт.

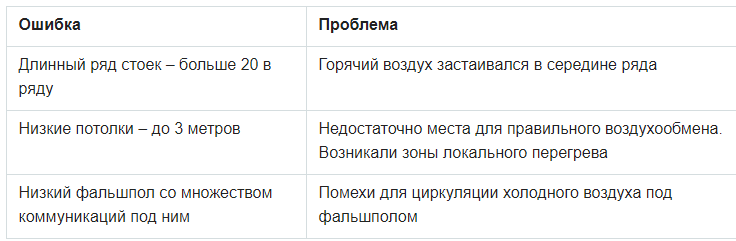

По мере заполнения зала перестало хватать холода: температура в холодных коридорах была выше, чем надо, постоянно возникали локальные перегревы. Это уже потом, с высоты своего опыта, мы поняли, что наделали ошибок в проектировании, и из-за этого страдало кондиционирование.

Какой-то «волшебной таблетки» от этих проблем мы тогда не видели, поэтому решили действовать поэтапно и по всем фронтам.

Сначала мы проверили, все ли оборудование установлено правильно и стоят ли заглушки в свободных юнитах. Мы также перепроверили раскладку перфорированных плиток и убрали лишние, установили дополнительные направляющие воздуха под фальшполом. Постарались найти и заделать все дырки, куда мог убежать холодный воздух. Советую вам тоже проверить, что у вас между кондиционером и стеной. Зазор в 5-7 см – это уже много.

Вот такой результат нам дало простое размещение заглушек в свободных юнитах.

Стало лучше, но недостаточно хорошо. Тогда мы решили изолировать холодные коридоры. Построили крышу, двери из поликарбоната. Получилось дешево и сердито. В результате мы избавились от паразитного смешения горячего и холодного воздуха и повысили КПД системы холодоснабжения.

Изолированный холодный коридор того же зала.

Мы понимали, что этого хватит ненадолго. С ростом ИТ-нагрузки нехватка мощности снова даст о себе знать.

Эту проблему попытались решить добавлением фреонового кондиционера, хотя зал работал на гликолевом охлаждении. Нас очень заботили габариты кондиционера (пройдет ли он в дверь, хватит ли угла поворота), поэтому подбирали модель с возможностью частичной разборки. Кондиционер установили не со стороны горячего коридора, как обычно это делают, а куда смогли втиснуть. Это добавило нам 80 киловатт по охлаждению.

Вот тот самый «гуттаперчевый» кондиционер Emerson.

Вся эта история оказалось непростой: нужно было придумать, как подвести фреоновые трассы до внешних блоков, как подвести к этим кондиционерам электричество, куда поставить внешние блоки кондиционера. Все это в работающем зале.

Просто для понимания, насколько там мало места.

После всех этих манипуляций мы избавились от локальных перегревов, температура распределялась равномерно в холодных и горячих коридорах. Получилось увеличить мощность зала и размещать в нем заявленные пятикиловаттные стойки.

Мораль этой истории в том, что не стоит бояться решать проблему мелкими шажками. Само по себе каждое из действий может показаться (и нам тогда казалось) неэффективным, но суммарно это дает результат.

История 2. В машинном зале закончились кондиционирование и энергоснабжение

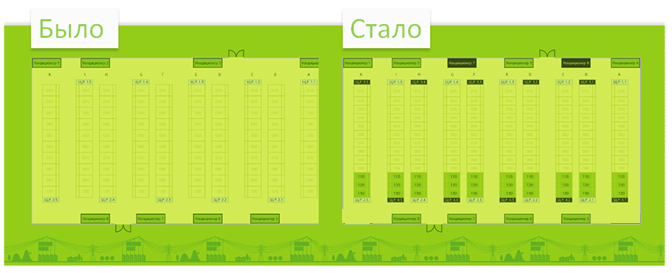

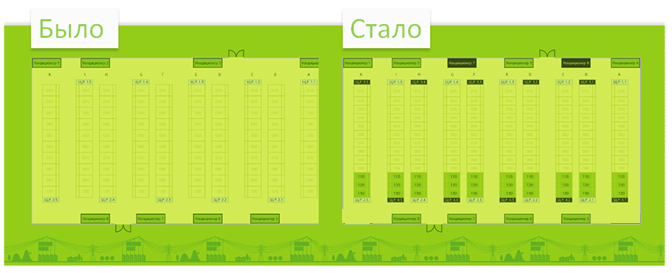

Под клиента был спроектирован машинный зал на 100 стоек по 5 кВт. Проектная ширина стойки 800 мм, в каждом ряду 10 стоек. Потом клиент передумал заезжать, и зал сдавали на общих основаниях. В жизни стойки шириной 800 мм нужны в основном под сетевое оборудование, для всего остального нужны шестисотые. В итоге вместо 10 стоек в ряду у нас получилось 13, и еще оставалось место. А вот электричества и холода уже не хватало.

В ходе модернизации выделили новое помещение под два дополнительных ИБП по 300 кВт.

В зале появились дополнительные распределительные щиты.

Новую мощность нужно было распределить равномерно. Чтобы разделить новые и старые лучи, под фальшполом проложили отдельные кабельные лотки. Часть работающего ИТ-оборудования переключили на новые распределительные щиты поочередным переключением каждого луча питания.

Чтобы решить вопрос с нехваткой холода, поставили 1 дополнительный кондиционер на 100 кВт холода.

Во время такелажа, установки и пусконаладки всего оборудования зал продолжал работать в штатном режиме. Это было самым сложным моментом в проекте.

В результате модернизации мы добавили залу электричества и холода на еще 30 стоек по 5 кВт.

Проектная мощность и емкость зала увеличена на 30%.

История 3. Про замену чиллеров

Немного предыстории. Началось все в 2010 году, когда 3 чиллера дата-центра OST сильно пострадали во время урагана. Тогда, чтобы выжить, пришлось гонять чиллеры без защиты несколько суток, и компрессоры быстро загнулись. Сначала меняли их.

ИТ-нагрузка росла по мере заполнения ЦОД, а чиллеры Emicon так и не вышли на заявленную холодильную мощность. В 2012-м поставили дополнительный чиллер Hiref в ту же гидравлическую схему. Так мы прожили еще три года.

Со временем у чиллеров Emicon обострились эксплуатационные проблемы. Их мощности не хватало, поэтому в жару приходилось поливать водой из керхеров. С годами теплообменники обросли известковыми отложениями. В зазор между теплообменником фрикулинга и фреоновым конденсатором набивался тополиный пух и прочий мусор, который не удалишь из-за специфики строения теплообменников. Там образовался настоящий валенок, который не пропускал нормально воздух.

В 2015 году мы как раз закупали партию чиллеров Stulz для NORD-4. Решили под это дело заменить два из трех чиллеров Emicon. Теперь подробности.

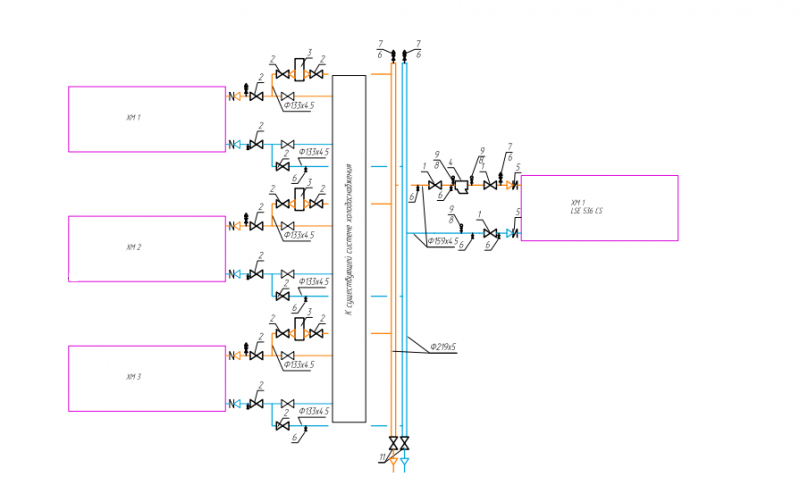

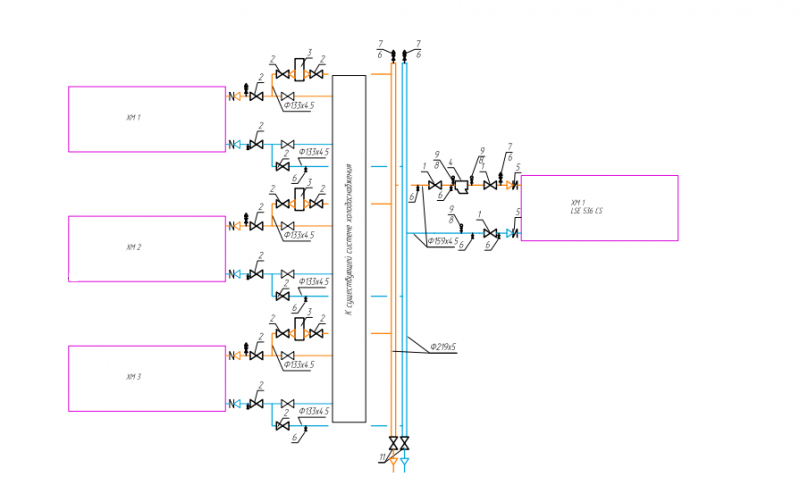

Установка дополнительного чиллера Hiref без доустановки насосов. ИТ-нагрузка росла, а КПД чиллеров, пострадавших в урагане, падал. Летом резерва едва хватало. Мы решили добавить еще один чиллер, чтобы увеличить их суммарную мощность. На время работ система холодоснабжения должна была продолжать функционировать. Самое сложное в этой операции – организация гликолевого контура. Мы сделали гликолевую обвязку: от каждого чиллера было отведено гликолевое кольцо к новому чиллеру. Чиллеры поочередно выводили из эксплуатации, и подводили к новому чиллеру гликолевую трубу.

Фрагмент принципиальной схемы гидравлики. На ней видно, что от каждого из трех чиллеров были сделаны ответвления к новому чиллеру.

Основная задача этого чиллера – поддержка системы холодоснабжения летом. Благодаря Hiref у нас появился гарантированный резерв N+1 в жаркие месяцы. Но поврежденные в урагане чиллеры потихоньку начали издыхать, и нам пришлось задуматься об их замене.

Тот самый «летний» чиллер Hiref.

Замена Emicon на Stulz. Такие замены лучше делать осенью или весной: летом без резерва совсем страшно, а зимой просто неприятно проводить работы. Операцию запланировали на февраль/март, но готовиться начали еще в октябре.

За эти подготовительные месяцы мы проложили новые кабели, варили участки трубопровода, разработали план подъезда машины с оборудованием (на заднем дворе у нас тесно), очистили территорию для подъезда крана. Чиллеры предстояло менять в работающем дата-центре, и примерно на 1,5 суток он оставался без резервного чиллера. На этапе подготовки мы провели тесты, чтобы понимать, как дата-центр будет чувствовать себя без резерва, напридумывали различные ситуации, когда что-то могло пойти не так во время работ (например, длительный блэкаут во время замены чиллеров), и разработали план действий. Вот краткая хроника тех работ.

В ночь приехал чиллер. После успешного заезда крана на территорию дата-центра можно было начинать отключать старый чиллер.

Старый чиллер еще на месте, пока ведутся подготовительные работы. Варим раму для нового чиллера.

Потом к непосредственному месту работ должна была подъехать машина с чиллером. У нас там, мягко говоря, тесновато. Пришлось попотеть, чтобы вписаться во все эти сложные повороты в ограниченном пространстве.

Разобранный и распиленный пополам чиллер демонтировали.

Старый и новый чиллер отличаются размерами. Ушло еще какое-то время на подготовку металлической рамы. Дело осталось за подъемом и установкой чиллера.

На заднем плане фото видно, что параллельно довариваются участки гликолевого контура для нового чиллера.

После установки на раму монтируется вся гидравлика, чиллер подключают к электропитанию. В ночь делается опрессовка. На следующий день проходит пусконаладка и подключение к системе мониторинга.

На всю операцию ушло меньше двух суток: утром старый чиллер выключили, в конце следующего дня включили уже новый чиллер.

Через две недели меняли второй чиллер. Казалось бы, нужно было просто все сделать по отработанной схеме, но что-то пошло не так. Всю ночь шел снег. Сначала пришлось потратить время на расчистку территории, чтобы кран смог заехать. Начали демонтировать старый чиллер, как в двухстах метрах от нас ломается машина с новым чиллером. Точка невозврата уже пройдена, а у фуры сломался поворотный механизм колес прицепа (пульт управления от него).

Отремонтировать на месте не получилось, ездили за дополнительным пультом, который в субботу чудом оказался в офисе этой компании. С пультом удалось докрутить машину. В итоге на прохождение одного поворота у нас ушло больше 3 часов. Со всеми логистическими накладками работы растянулись до ночи. Хорошо, что мы продумали освещение для работ в темное время суток. Оставшиеся работы прошли в штатном режиме, и с понедельника в дата-центре заработал еще один новый чиллер.

В марте этого года мои коллеги провели замену уже третьего чиллера, последнего из переживших ураган. Теперь на Боровой работают три чиллера Stulz и один Hiref. Благодаря такой поэтапной модернизации у нас теперь есть большой запас по холоду, и мы не боимся самой жаркой погоды и тополиного пуха. Новые чиллеры поддерживают режим фрикулинга на большем температурном диапазоне, потребляют меньше энергии и работают очень тихо. Еще их очень удобно обслуживать из-за отдельных компрессорных отсеков: ремонтные работы можно проводить без полной остановки чиллера.