Announcing resource-based pricing for Google Compute Engine

Обещание и преимущество облака всегда были гибкостью, низкой стоимостью и оплатой за использование. С помощью Google Compute Engine пользовательские типы машин позволяют создавать экземпляры виртуальных машин любого размера и формы, и мы автоматически применяем скидки на использование и постоянное использование, чтобы снизить ваши затраты. Сегодня мы используем концепцию оплаты за использование в Compute Engine еще дальше с ценой на основе ресурсов.

Благодаря ценообразованию на основе ресурсов мы делаем несколько изменений за кулисами, которые выравнивают, как мы относимся к измерению пользовательских и предопределенных типов машин, а также к тому, как мы применяем скидки для скидок с постоянным использованием. Проще говоря, мы внесли изменения, чтобы автоматически предоставить вам больше сбережений и простой для понимания ежемесячный счет. Кто этого не любит?

Ценообразование на основе ресурсов рассматривает использование на гранулированном уровне. Вместо того, чтобы оценивать свое использование на основе используемых вами типов машин, он оценивает, сколько ресурсов вы потребляете за определенный период времени. Что это значит? Это означает, что ядро является ядром, а ГБ ОЗУ — ГБ ОЗУ. Неважно, какая комбинация заданных типов машин вы используете. Теперь мы смотрим на них на уровне ресурсов — в совокупности. Это становится лучше, потому что скидки с постоянным использованием теперь рассчитываются на региональном уровне, а не только внутри зон. Это означает, что вы можете быстрее получать скидки на использование, поэтому вы можете экономить еще более автоматически.

Чтобы лучше понять эти изменения и получить представление о том, как вы можете сэкономить, давайте посмотрим, как работали сдержанные скидки на использование, и как они будут работать дальше.

Хорошо. Теперь, что, если вы использовали разные типы машин?

С ценой на основе ресурсов мы больше не рассматриваем ваш тип машины, и вместо этого мы объединяем все ресурсы, которые вы используете на всех ваших компьютерах, в одну общую сумму, а затем применяете скидку. Вам не нужно предпринимать никаких действий. Вы автоматически сохраняете. Давайте снова рассмотрим пример масштабирования, но на этот раз с ценой на основе ресурсов.

И поскольку ценообразование на основе ресурсов применяется на региональном уровне, теперь вам будет легче пользоваться скидками на использование, независимо от типа используемой вами машины, или количеством зон в регионе, в котором вы работаете. В ближайшие месяцы вступит в силу ценовая политика на основе ресурсов. Посетите страницу ценообразования на основе ресурсов, чтобы узнать больше.

Благодаря ценообразованию на основе ресурсов мы делаем несколько изменений за кулисами, которые выравнивают, как мы относимся к измерению пользовательских и предопределенных типов машин, а также к тому, как мы применяем скидки для скидок с постоянным использованием. Проще говоря, мы внесли изменения, чтобы автоматически предоставить вам больше сбережений и простой для понимания ежемесячный счет. Кто этого не любит?

Ценообразование на основе ресурсов рассматривает использование на гранулированном уровне. Вместо того, чтобы оценивать свое использование на основе используемых вами типов машин, он оценивает, сколько ресурсов вы потребляете за определенный период времени. Что это значит? Это означает, что ядро является ядром, а ГБ ОЗУ — ГБ ОЗУ. Неважно, какая комбинация заданных типов машин вы используете. Теперь мы смотрим на них на уровне ресурсов — в совокупности. Это становится лучше, потому что скидки с постоянным использованием теперь рассчитываются на региональном уровне, а не только внутри зон. Это означает, что вы можете быстрее получать скидки на использование, поэтому вы можете экономить еще более автоматически.

Чтобы лучше понять эти изменения и получить представление о том, как вы можете сэкономить, давайте посмотрим, как работали сдержанные скидки на использование, и как они будут работать дальше.

Раньше, если вы использовали конкретный тип машины (например, n1-standard-4) с четырьмя vCPU в течение 50% месяца, вы получили эффективную скидку 10%. Если вы использовали его в течение 75% месяца, вы получили эффективную скидку в размере 20%. Если вы используете его в течение 100% месяца, вы получите эффективную скидку в размере 30%.

Хорошо. Теперь, что, если вы использовали разные типы машин?

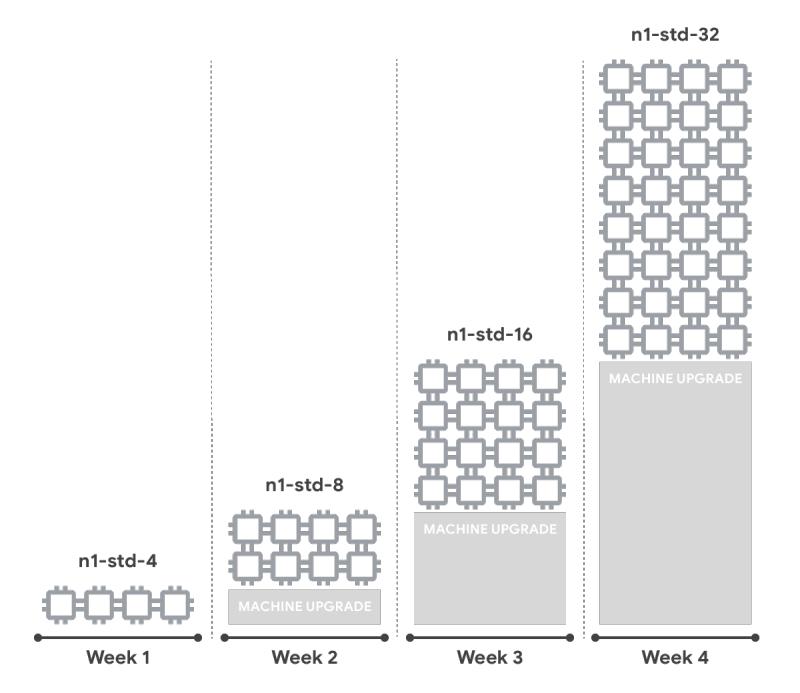

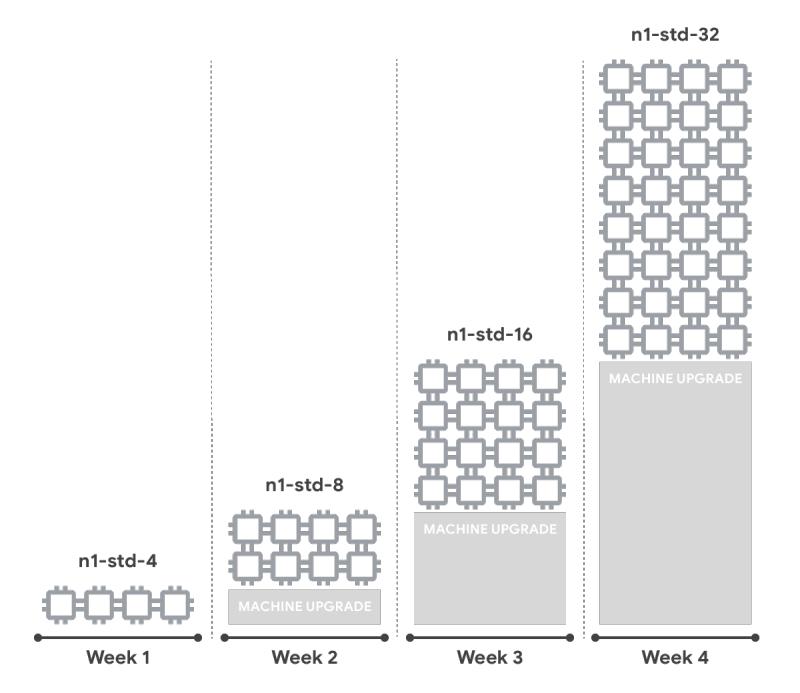

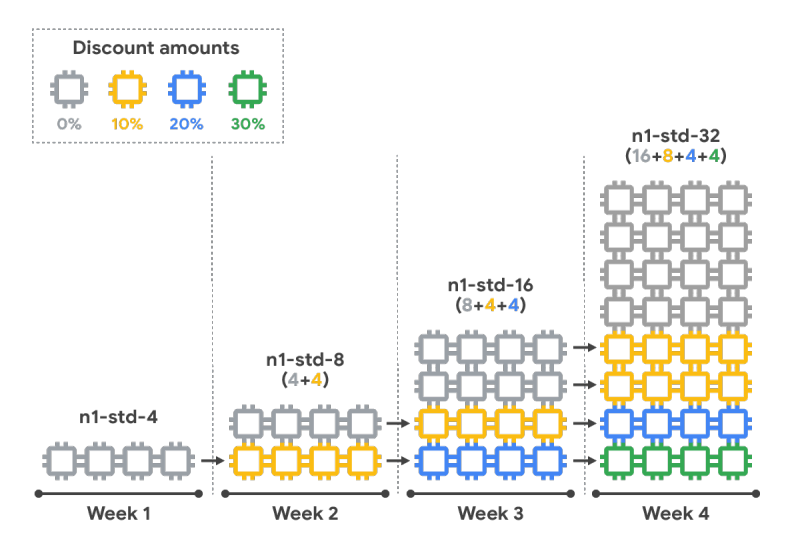

Предположим, вы используете веб-сервис. Вы начали месяц с n1-standard-4 с четырьмя vCPU. На второй неделе пользовательский спрос на ваш сервис увеличился, и вы увеличили емкость. Вы начали запускать n1-standard-8 с восемью vCPU. Когда-либо растущий спрос заставлял вас снова увеличиваться. На третьей неделе вы начали запускать n1-standard-16 с шестнадцатью vCPU. Из-за вашего успеха вы снова закончили масштабирование, закончив месяц, когда n1-standard-32 с тридцатью двумя vCPU. В этом случае вы не получили бы скидку, потому что вы не запускали ни один из типов машин до 50% месяца.

С ценой на основе ресурсов мы больше не рассматриваем ваш тип машины, и вместо этого мы объединяем все ресурсы, которые вы используете на всех ваших компьютерах, в одну общую сумму, а затем применяете скидку. Вам не нужно предпринимать никаких действий. Вы автоматически сохраняете. Давайте снова рассмотрим пример масштабирования, но на этот раз с ценой на основе ресурсов.

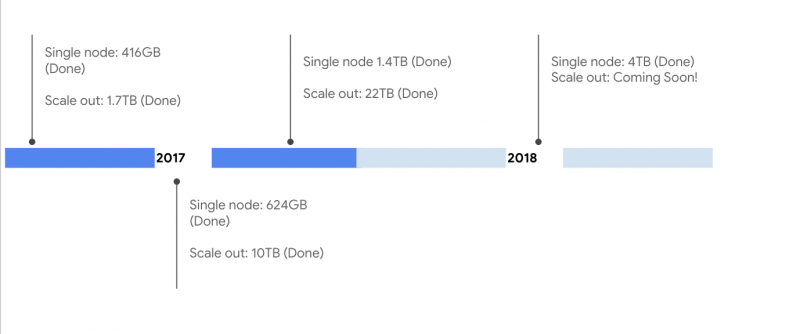

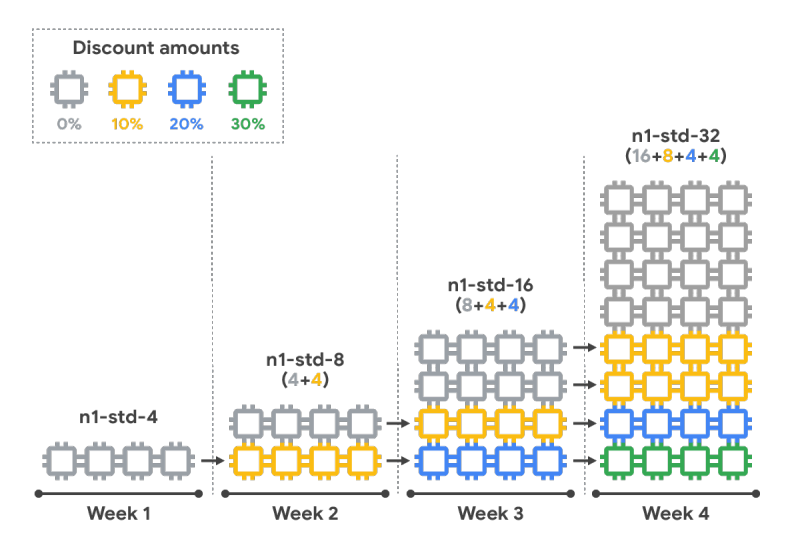

Вы начали месяц, на котором было четыре vCPU, а затем были увеличены до восьми vCPU, шестнадцати vCPU и, наконец, тридцать два vCPU. Вы запускали четыре vCPU весь месяц или 100% времени, поэтому вы получаете 30% скидку на эти vCPU. Вы потратили еще четыре vCPU на 75% от месяца, так что вы получаете 20% скидку на эти vCPU. И, наконец, вы потратили еще восемь vCPU на половину месяца, так что вы получаете 10% скидку на эти vCPU. Шестнадцать vCPU выполнялись в течение одной недели, поэтому они не получили скидку. Давайте посмотрим, как это работает, чтобы укрепить то, что мы узнали.

И поскольку ценообразование на основе ресурсов применяется на региональном уровне, теперь вам будет легче пользоваться скидками на использование, независимо от типа используемой вами машины, или количеством зон в регионе, в котором вы работаете. В ближайшие месяцы вступит в силу ценовая политика на основе ресурсов. Посетите страницу ценообразования на основе ресурсов, чтобы узнать больше.