Важная информация для клиентов: прекращение поддержки наших типов серверов ceph

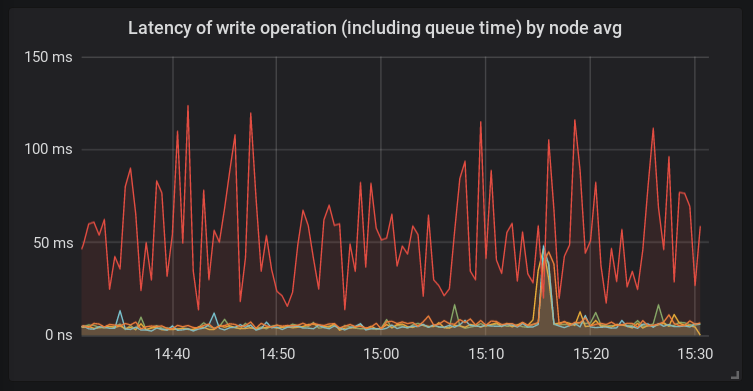

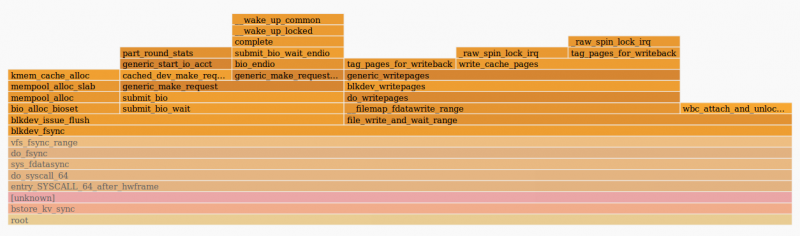

С момента запуска Hetzner Cloud в 2018 году мы постоянно работаем над расширением нашей платформы и даже предложили вам два разных типа хранилища для наших стандартных серверов на базе Intel: локальный (NVMe SSD) и сетевой (CEPH). Локальное хранилище всегда предлагало превосходную производительность и задержку при одинаковом уровне стабильности, что делает их лучшим выбором для всех наших клиентов. Об этом также свидетельствует тот факт, что более 95% всех существующих сегодня серверов используют локальное хранилище.

Чтобы упростить наше предложение и повысить эффективность наших пулов ресурсов, мы отказываемся от действующих сегодня типов серверов на основе сетевых хранилищ. Затронутые типы серверов: cx11-ceph, cx21-ceph, cx31-ceph, cx41-ceph, cx51-ceph. Все ваши существующие серверы на базе ceph будут продолжать работать, как раньше, и с вашей стороны не требуется никаких действий в отношении этих серверов. При создании новых серверов мы просим вас использовать их дублирующие части на основе локального хранилища (cx11, cx21, cx31, cx41, cx51).

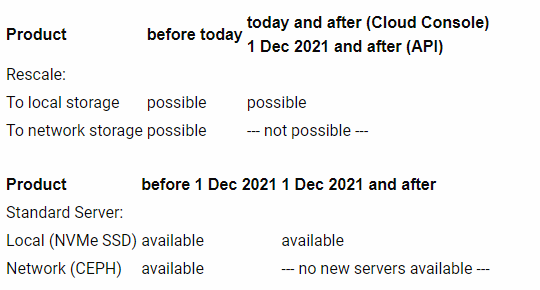

Начиная с сегодняшнего дня, можно будет только изменить масштаб существующих типов серверов на основе сетевого хранилища на другой тип сервера на основе сетевого хранилища через API.

Начиная с 1 декабря 2021 года, перемасштабировать существующие типы серверов на основе сетевого хранилища на другой тип сервера на основе сетевого хранилища будет невозможно.

С 1 декабря 2021 года больше не будет возможности создавать новые серверы типа cx11-ceph, cx21-ceph, cx31-ceph, cx41-ceph, cx51-ceph.

Это изменение не повлияет на существующие серверы на основе ceph. Однако это устаревание также относится к изменению масштаба. Это означает, что можно будет масштабировать существующие серверы на основе сетевого хранилища на серверы на основе локального хранилища, но не на другой тип сервера на основе сетевого хранилища.

Это изменение не коснется нашего продукта Volumes, который обеспечивает сетевое блочное хранилище.

Если у вас возникнут вопросы, мы с радостью поможем. Чтобы открыть запрос в службу поддержки, перейдите в пункт меню «Поддержка» в облачной консоли. Мы надеемся, что вы по-прежнему доверяете нам, поскольку мы постоянно работаем над расширением наших услуг, и вы можете рассчитывать на несколько новых функций, которые уже включены в нашу дорожную карту.