Вы слышали, что это место — облако. Запускайте корпоративные приложения или масштабируйте свой стартап. Это просто, легко начать и недорого.

Вы переходите на AWS, Azure, Google или, возможно, Digital Ocean. Вы регистрируетесь, и всего за несколько долларов (евро, фунты, выберите валюту) у вас есть работающие серверы и еще тысяча сервисов в вашем распоряжении.

Ваша мечта сбылась, и вы можете обслуживать своих пользователей и пожинать плоды.

К сожалению, вскоре вы понимаете, что вашим корпоративным приложениям действительно требуются огромные объемы памяти и вычислительная мощность (просто проверьте требования к SAP HANA ).

Или, может быть, ваш стартап берет с нуля, и вы получаете все больше и больше пользователей. Попасть в первый миллион пользователей — это весело, а второй — еще лучше, и все больше людей приходит.

Но как только пользователи попадают на ваши серверы, ваш облачный провайдер очень сильно бьет по вашему банковскому счету.

Многие стартапы откладывают прибыльность и даже доход до тех пор, пока не найдут подходящую рыночную форму продукта, и это здорово, если только у вас нет денег.

Что случилось с бережливым стартапом?

Тратить $ 150 000 на серверы каждый год, уже не выглядит слишком скудно.

Что бы вы сделали, если бы вместо этого потратили эти 150 тысяч долларов на ускорение роста?

И корпоративные приложения, они должны были увеличить ваш доход, не слишком сильно сказываясь на вашей прибыли. Может быть, еще 150 тысяч долларов помогут вашей команде по продажам привлечь еще больше клиентов?

Иногда у вас даже не так много пользователей, но вы просто собираете столько данных, а затем добываете их для соответствующих бизнес-сигналов. Большие данные требуют столько же инфраструктуры, но только менее 10% из них действительно полезны.

Вы можете сделать лучше? Можете ли вы расти, прежде чем закончатся деньги? Разве не было бы неплохо, если бы вы потратили 150 000 долларов на улучшение своего бизнеса, а не бросали их в Amazon, Google или Microsoft?

Это именно то, что мы сделали с некоторыми из наших клиентов.

Инфраструктура

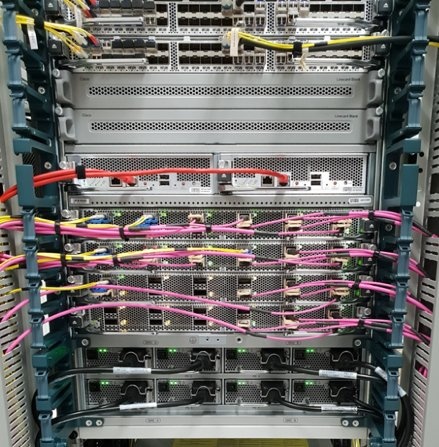

Давайте посмотрим на одного из наших клиентов. Они обслуживают более 5 миллионов пользователей в месяц тоннами контента, изображений, трафика и т. Д.

Мы оценили их требования и разработали следующую инфраструктуру:

- Балансировщик нагрузки — 1 сервер, 4 потока, 30 ГБ ОЗУ

- Обслуживание миллионов изображений — 1 сервер, 8 потоков, 120 ГБ ОЗУ, 4 ТБ диска

- Front-end — 2 сервера, 4 потока, 30 ГБ ОЗУ

- Бэк-энд, длительные задачи — 2 сервера, 4 потока, 30 ГБ ОЗУ

- Внутреннее кэширование (Redis) — 1 сервер, 2 потока, 30 ГБ ОЗУ

- База данных — 6 серверов, 4 потока, 240 ГБ оперативной памяти, 1 ТБ диска

- Поиск — 1 сервер, 4 потока, 30 ГБ оперативной памяти

- Серверная часть, сервисы изображений — 1 сервер, 4 потока, 60 ГБ ОЗУ

- Хранение, резервное копирование базы данных, резервное копирование изображений — 6 ТБ

- Трафик — 12 ТБ

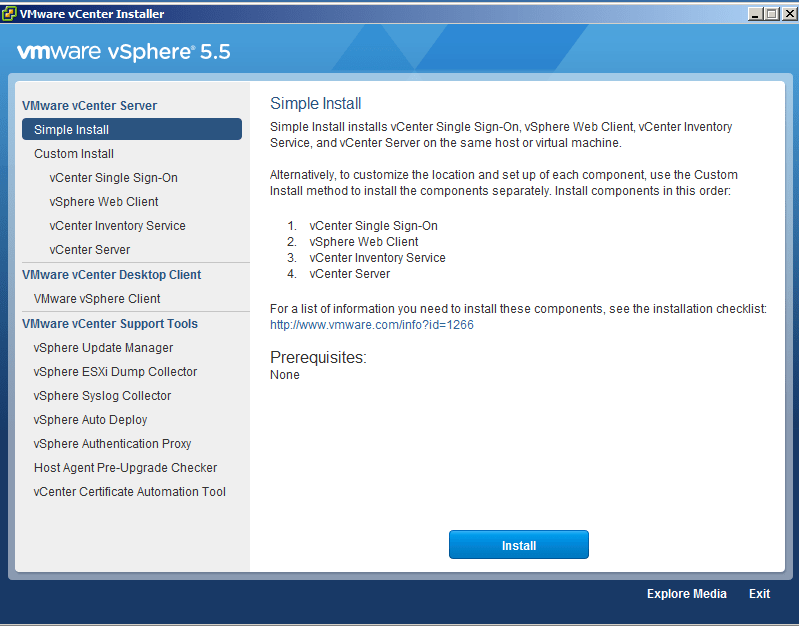

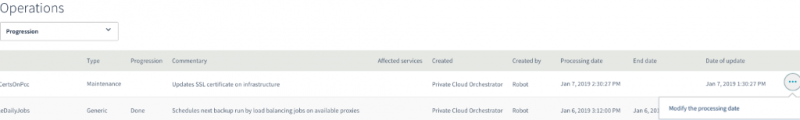

Все серверы должны быть виртуальными машинами. Конечно, есть дополнительные средства автоматизации и программное обеспечение, чтобы все это работало и предотвращало значительные простои.

Эта система работает уже несколько лет, и каждый месяц она обслуживает более 5 миллионов пользователей, обслуживая миллионы изображений и другого контента общим объемом около 12 ТБ трафика каждый месяц.

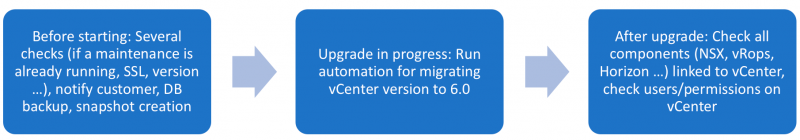

В крайне редком случае сбоя виртуальной машины из-за аппаратного сбоя или по другим причинам система была очень устойчивой, и это приводило к минимальному или отсутствию простоев платформы.

Теперь вы знаете, что нам нужно было запустить и поддерживать. Следующий шаг — решить, где его запустить.

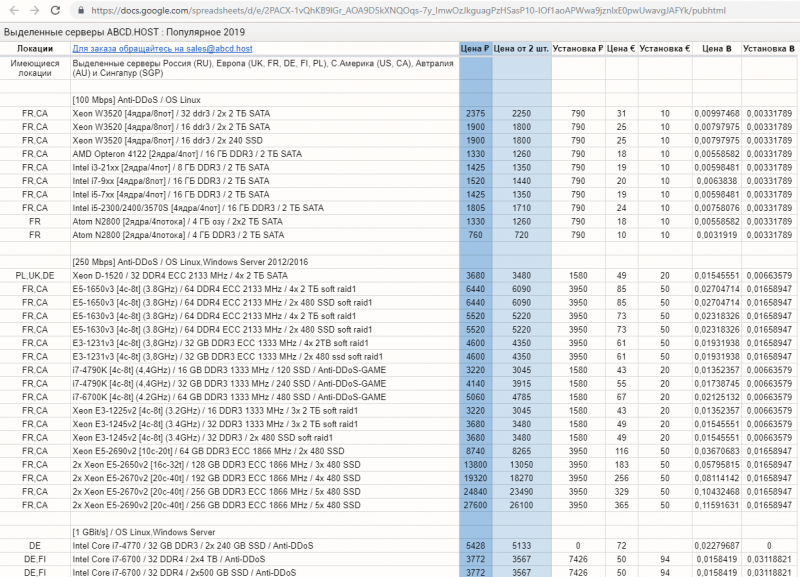

Давайте посмотрим на некоторые варианты и оценим их

- Amazon Web Services

- Microsoft Azure

- Google Cloud

- Цифровой океан

- OVH

Для каждого из этих вариантов, вот основные страницы цен

aws.amazon.com/ec2/pricing/

azure.microsoft.com/en-us/pricing/details/virtual-machines/linux/

cloud.google.com/compute/pricing

www.digitalocean.com/pricing/

www.ovh.com/world/public-cloud/instances/prices/

www.ovh.com/world/dedicated-servers/infra/

Я знаю, что есть другие провайдеры, такие как, например, IBM и Oracle, но цель не в том, чтобы быть обширным, а просто показать вам, что возможно.

AWS

- Самый известный облачный провайдер в мире и, возможно, самый большой в зависимости от того, как вы его измеряете.

- Он начал облачную революцию и продолжает лидировать, добавляя все больше и больше полезных сервисов.

- Мы использовали его со многими клиентами, и мы также используем некоторые из наших собственных сервисов.

Давайте посмотрим на инфраструктуру, которая отвечает требованиям и ее цене.

- Балансировщик нагрузки — 1 сервер r5a.xlarge, 4 потока, 32 ГБ ОЗУ, $ 162,76

- Изображения — 1 сервер r5a.4xlarge, 16 потоков, 128 ГБ ОЗУ, $ 650,88 + 400 долл. EBS

- Front-end — 2 сервера r5a.xlarge, 4 потока, 32 ГБ ОЗУ, $ 325,52

- Внутренние, длительные задачи — 2 сервера r5a.xarge, 4 потока, 32 ГБ оперативной памяти, $ 325,52

- Внутреннее кеширование — 2 сервера r5a.xlarge, 4 потока, 32 ГБ оперативной памяти, $ 325,52

- База данных — 6 серверов r4.8xarge, 32 потока, 244 ГБ ОЗУ, $ 9192,96 + 400 долл. EBS

- Поиск — 1 сервер r5a.xlarge, 4 потока, 32 ГБ оперативной памяти, $ 162,76

- Back-end, сервисы изображений — 1 r5a.2 большой сервер, 4 потока, 64 ГБ оперативной памяти, $ 414,72

- Хранение, резервное копирование базы данных, резервное копирование образов — 6 ТБ, $ 138 на S3

- Трафик — 12 ТБ, $ 1080

На момент написания этой статьи общая стоимость инфраструктуры составила бы

14633,88 долларов в месяц.

Давайте посмотрим на несколько вопросов.

- Можем ли мы стать дешевле, сделав предоплату?

- Да, мы могли бы, и мы можем сделать это для всех облачных провайдеров в этом списке. Однако у этого есть один недостаток, который стоит довольно много заранее.

- Разве это не было бы более экономически эффективным, если бы мы использовали серверные или другие управляемые услуги?

Мы сделали этот расчет, и ответ был, что это не так. В этом случае это было намного дороже.

Azure

В зависимости от того, как вы это оцениваете, Azure может быть больше, чем AWS, или может быть вторым.

Во всех случаях это очень популярно.

- У них также есть тонны сервисов, почти такие же, как AWS, и несколько уникальных.

- Мы использовали их раньше, и мы были приятно удивлены простотой использования.

Давайте посмотрим на инфраструктуру, которая отвечает требованиям и ее цене.

- Балансировщик нагрузки — 1 сервер A4m v2, 4 потока, 32 ГБ ОЗУ, $ 151,84

- Изображения — 1 сервер E16 v3, 16 потоков, 128 ГБ ОЗУ, $ 776,72 + $ 450,56, управляемый диск 4 ТБ

- Front-end — 2 сервера A4m v2, 4 потока, 32 ГБ ОЗУ, $ 303,68

- Внутренние, длительные задачи — 2 сервера A4m v2, 4 потока, 32 ГБ ОЗУ, $ 303,68

- Внутреннее кэширование (Redis) — 1 сервер A4m v2, 4 потока, 32 ГБ ОЗУ, $ 151,84

- База данных — 6 серверов E32 v3, 4 потока, 256 ГБ ОЗУ, $ 9320,64 + 491,52 $ Управляемый диск (4x1 ТБ)

- Поиск — 1 сервер A4m v2, 4 потока, 32 ГБ оперативной памяти, $ 151,84

- Серверная часть, сервисы изображений — 1 сервер A8M v2, 8 потоков, 64 ГБ ОЗУ, $ 319,01

- Хранилище, резервное копирование базы данных, резервное копирование образов — 6 ТБ, $ 110,4 на хранилище Azure

- Трафик — 12 ТБ, 1044 $

На момент написания этой статьи общая стоимость инфраструктуры составила бы

13575,53 долл. США в месяц. Это примерно на 1000 долларов в месяц меньше, чем в AWS, неплохо.

- Что вы заметите, так это то, что выбранные серверы не идентичны.

- Разные облачные провайдеры не всегда имеют одинаковые конфигурации. Однако цель состояла в том, чтобы выбрать конфигурации, которые наилучшим образом соответствуют начальным требованиям.

Google Cloud

Чрезвычайно известное имя, отличная технология, но с точки зрения размера ему не хватает далеко позади AWS и Azure, и он растет медленнее, чем они. Я не уверен, что это даже на третьем месте.

Я использовал их раньше, и у меня есть только хорошие слова, чтобы сказать об их технологии. В частности, у них есть собственная международная высокоскоростная сеть.

Давайте посмотрим на инфраструктуру, которая отвечает требованиям и ее цене.

- Балансировщик нагрузки — 1 сервер n1-highmem-4, 4 потока, 26 ГБ ОЗУ, $ 121,00

- Обслуживание миллионов изображений — 1 сервер n1-standard-32, 32 потока, 120 ГБ ОЗУ, $ 776,72 и $ 1600 4 ТБ постоянного диска

- Front-end — 2 сервера n1-highmem-4, 4 потока, 26 ГБ ОЗУ, $ 242,00

- Внутренние, длительные задачи — 2 сервера n1-highmem-4, 4 потока, 26 ГБ ОЗУ, $ 242,00

- Внутреннее кэширование (Redis) — 1 сервер n1-highmem-4, 4 потока, 26 ГБ ОЗУ, $ 121,00

- База данных — 6 серверов n1-standard-64, 64 потока, 240 ГБ оперативной памяти, $ 9320,64 + 1600 $ 4x1TB Disk

- Поиск — 1 сервер n1-highmem-4, 4 потока, 26 ГБ оперативной памяти, $ 121,00

- Серверная часть, сервисы изображений — 1 сервер n1-standard-16, 16 потоков, 60 ГБ ОЗУ, $ 388,36

- Хранение, резервное копирование базы данных, резервное копирование образов — 6 ТБ, $ 210

- Трафик — 12 ТБ, 1320 $

На момент написания этой статьи общая стоимость инфраструктуры составляла бы

16062,72 долл. США в месяц.

Здесь есть две интересные вещи.

- Во-первых, хотя AWS и Azure были очень похожи, машины Google, похоже, получают больше вычислительной мощности и лучшую цену.

- Тем не менее, основным условием сделки является их постоянное хранение, что очень дорого.

Digital Ocean

Digital Ocean появился чуть позже на вечеринке, но они точно разбили его. У них было два очень уникальных предложения.

- В отличие от AWS, который может быть громоздким и сложным в настройке, Digital Ocean и его капли (как они называют виртуальные машины) чрезвычайно просты в установке и запуске.

- Они также написали тонны действительно хороших статей о том, как запускать различные программные стеки и сервисы на своих машинах.

- Эти два преимущества велики, но самым большим было то, что каждая капля имела доступ к большому SSD.

- В то время, когда AWS поставлял относительно медленные и дорогие диски, DO начал предоставлять доступ к сверхбыстрым SSD по отличной цене.

Давайте посмотрим на инфраструктуру, которая отвечает требованиям и ее цене.

- Балансировщик нагрузки — 1 сервер, 8 потоков, 32 ГБ оперативной памяти, $ 160,00

- Изображения — 1 сервер, 24 потока, 128 ГБ ОЗУ, 640,00 долл. США + 400,00 долл. США, блочное хранилище 4 ТБ

- Front-end — 2 сервера, 8 потоков, 32 ГБ оперативной памяти, $ 320,00

- Внутренние, длительные задачи — 2 сервера, 8 потоков, 32 ГБ оперативной памяти, $ 320,00

- Внутреннее кэширование (Redis) — 1 сервер, 8 потоков, 32 ГБ ОЗУ, $ 160,00

- База данных — 12 серверов, 24 потока, 128 ГБ ОЗУ, 2,56 ТБ, $ 7680,00

- Поиск — 1 сервер, 8 потоков, 32 ГБ оперативной памяти, $ 160,00

- Серверная часть, сервисы изображений — 1 сервер, 16 потоков, 64 ГБ ОЗУ, $ 320

- Хранение, резервное копирование базы данных, резервное копирование образов — 6 ТБ, $ 120,00

- Трафик — 12 ТБ, без дополнительных сборов, входит в стоимость машины

На момент написания этой статьи общая стоимость инфраструктуры составила бы

10280 долларов в месяц.

- В Digital Ocean не так много больших машин, как мы хотели для базы данных, поэтому мы заменили каждую машину на две другие, вдвое меньшие по размеру, что приводит к тому же количеству ресурсов, но немного сложнее в управлении.

- Конечно, самое главное, что вы получаете гораздо лучшие цены, чем AWS, Google и Microsoft.

- В то же время вы получаете большое хранилище SSD, в то время как три других провайдера предоставляют очень мало хранилища по умолчанию, и в большинстве случаев это медленный тип.

- Тем не менее, это не только хранилище, но и большой объем трафика на машину, поэтому вам не нужно платить дополнительно, как вы платите за 3 крупнейших поставщика.

- Основным недостатком является то, что Digital Ocean не предоставляет много других услуг, которые вы можете найти у таких провайдеров, как AWS и Azure.

- Пока что Digital Ocean предлагает лучшее решение, экономя почти 6000 долларов по сравнению с Google. Можем ли мы сделать лучше?

Облако OVH

- OVH — самый большой секрет в облачном мире.

- Может быть, вы никогда не слышали об этом. Возможно, вы даже думаете, что это новый облачный провайдер, поэтому вы об этом не знаете.

- В обоих случаях вы будете неправы.

- OVH — французская компания с центрами обработки данных по всему миру.

- На самом деле они являются крупнейшим поставщиком выделенных серверов в мире!

- Мы собираемся разобраться в этом, но сейчас давайте посмотрим на их виртуальные машины. Они называют их облачными экземплярами.

Давайте посмотрим на инфраструктуру, которая отвечает требованиям и ее цене.

- Балансировщик нагрузки — 1 сервер B2-30, 8 потоков, 30 ГБ ОЗУ, $ 102,00

- Изображения — 1 сервер R2-120, 8 потоков, 120 ГБ ОЗУ, 174,00 $ + 180,00 $ 4TB Disk

- Front-end — 2 B2-30 сервера, 8 потоков, 30 ГБ оперативной памяти, $ 204,00

- Внутренние, длительные задачи — 2 сервера B2-30, 8 потоков, 30 ГБ оперативной памяти, $ 204,00

- Внутреннее кэширование — 1 сервер B2-30, 8 потоков, 30 ГБ оперативной памяти, $ 102,00

- База данных — 6 серверов R2-240, 24 потока, 240 ГБ ОЗУ, 2,56 ТБ, $ 2052,00 и $ 270 дисков

- Поиск — 1 сервер B2-30, 8 потоков, 30 ГБ оперативной памяти, $ 102,00

- Бэк-энд, сервисы изображений — 1 сервер R2-60, 4 потока, 60 ГБ оперативной памяти, $ 86,39

- Хранение, резервное копирование базы данных, резервное копирование образов — 6 ТБ, $ 67,20

- Трафик — 12 ТБ, без дополнительных сборов, входит в стоимость машины

Общая стоимость инфраструктуры на момент написания этой статьи составила бы

3543,59 долларов в месяц.

- Да, эти цифры верны. Цена почти в 5 раз меньше, чем у Google, и в 3 раза меньше, чем у Digital Ocean!

- И это не просто цена. Их сетевой трафик не измеряется, поэтому вам не нужно тратить целое состояние на трафик, который вы получаете.

- Это какая-то афера? Это надежно?

- Это абсолютно реально. Мы строим сервисы и платформы, обслуживающие миллионы пользователей каждый месяц на OVH.

- Мы доверяем им так же, как доверяем AWS, Azure, Google или Digital Ocean.

- Клиент, о котором мы вам рассказали, использовал OVH для всего, что ему нужно, и это был отличный опыт.

Как и в случае с Digital Ocean, основным недостатком является отсутствие многих управляемых сервисов, таких как AWS, Azure и Google.

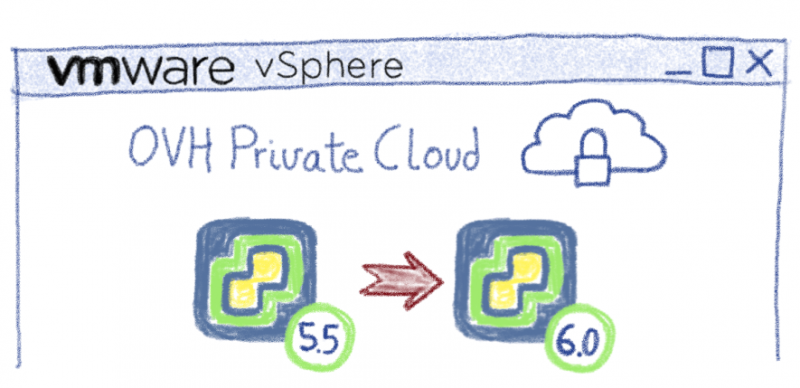

OVH Выделенный

Я уже говорил вам, что OVH является крупнейшим облачным провайдером в мире для выделенных серверов с минимальным набором ресурсов.

Вы получаете полную скорость диска, полный доступ к процессору и памяти, а также минимальную задержку.

Угадай, что? Эти серверы оценены очень хорошо.

Давайте посмотрим на инфраструктуру, которая отвечает требованиям и ее цене.

- Балансировщик нагрузки — 1 сервер EG-32, 8 потоков, оперативная память 32 ГБ, $ 119,00

- Обслуживание миллионов изображений — 1 сервер EG-128, 8 потоков, 120 ГБ ОЗУ, 4 ТБ, $ 269,00

- Front-end — 2 сервера EG-32, 8 потоков, 32 ГБ оперативной памяти, $ 238,00

- Внутренние, длительные задачи — 2 сервера EG-32, 8 потоков, 32 ГБ ОЗУ, $ 238,00

- Внутреннее кэширование — 1 сервер EG-32, 8 потоков, оперативная память 32 ГБ, $ 119,00

- База данных — 6 серверов EG-256-L, 24 потока, 240 ГБ ОЗУ, 4 ТБ диска, $ 2946,00

- Поиск — 1 сервер EG-32, 8 потоков, 32 ГБ оперативной памяти, $ 119,00

- Серверная часть, сервисы изображений — 1 сервер EG-64, 12 потоков, 64 ГБ ОЗУ, $ 185,99

- Хранение, резервное копирование базы данных, резервное копирование образов — 6 ТБ, $ 67,20

- Трафик — 12 ТБ, сборов нет, трафик не измеряется

На момент написания этой статьи общая стоимость инфраструктуры составила бы

4301,19 долларов в месяц.

- Это дороже, чем OVH Cloud, но производительность поразительна, и все еще намного дешевле, чем Google, Amazon, Microsoft и даже Digital Ocean.

- Тем не менее, я должен признать одну вещь. Выбранная инфраструктура рассчитана на виртуальные машины, а не на «голые железные» серверы.

- Когда виртуальная машина умирает, обычно вы можете запустить точную реплику в течение нескольких секунд, как будто ничего не произошло.

- Когда умирает специализированная машина из чистого металла, и если нет других машин, вам, возможно, придется подождать. Если есть, вы можете получить новую машину через несколько минут. Это немного, но в некоторых случаях может быть неприемлемо.

- Более того, это требует большей избыточности, поэтому реальной инфраструктуре потребуется еще несколько серверов, а общая стоимость может возрасти до 5000 долларов. Не так уж плохо.

Просто выбрав OVH Cloud вместо Google, вы сэкономите 150 000 долларов в год, а затем можете потратить их там, где это важно.

Вот почему наш клиент с вышеупомянутой платформой с большим успехом использует OVH на выделенных машинах и в облачных экземплярах.

- Я знаю, что AWS, Azure и Google — это место для многих предпринимателей и предприятий. Большинство людей просто так доверяют им, потому что они очень известные бренды.

- Тем не менее, мы много работали над OVH в течение нескольких лет, и их услуги были просто удивительными. Вы получаете отличное соотношение цены и качества.

- Мы используем AWS в течение многих лет. У нас также есть клиенты, работающие на своих платформах в Azure и Google. Однако я обнаружил несколько проблем, которые меня беспокоят.

- Во-первых, как только вы начинаете расти, ваши расходы проходят через крышу. Зачастую самым большим сюрпризом для многих компаний является то, что они платят за трафик, входящий и исходящий между сетью AWS и Интернетом.

- Во-вторых, предполагаемые преимущества управляемых сервисов (например, AWS RDS) не так уж велики.

Вам по-прежнему требуются большие знания для эффективного использования этих услуг, и у вас есть много, чтобы управлять ими. Вам не нужно ничего устанавливать или исправлять, но это практически единственное преимущество.

Если вы хотите запустить бережливый стартап или улучшить итоги, OVH — отличное место для вас.

www.terlici.com/2018/12/18/build-for-just-small.html