Последний дайджест 2020: бонусы за серверы для 1С, новые базы данных и производительные GPU

Здравствуйте!

Врываемся в череду самоизоляционных корпоративов с последним дайджестом в 2020 году. В «Тайного Санту» играть не будем: обо всех подарках заявляем открыто. В завершение года предлагаем бонусы за аренду серверов для 1С, запускаем самую быструю зону доступности в Москве и расширяем линейку поддерживаемых баз данных.

Бонусы на баланс за сервер для 1С

От производительности сервера для 1С зависит, насколько быстро и бесперебойно будет работать ваша система. Выбрать оптимальный не всегда просто. Мы решили помочь вам в этом и объединились с командой Вячеслава Гилева (это признанные эксперты 1С): они подбирают вам сервер для 1С в Selectel — мы компенсируем стоимость услуги бонусами на ваш баланс. Сможете потратить их на дальнейшую работу сервера или развитие инфраструктуры.

Более надежные выделенные серверы

Изменили политику резервирования выделенных публичных подсетей ради повышения надежности. Теперь при выходе из строя одного из маршрутизаторов система переключится на другой без простоя в работе. Без даунтайма пройдут и плановые работы на маршрутизаторах. Заказ новой подсети будет доступен только с включенной опцией резервирования. Если у вас уже есть выделенная подсеть, мы предлагаем вам сделать самостоятельный выбор в пользу резервирования или отказа от него.

Самые быстрые облачные серверы в Москве

Запустили новую, быструю и отказоустойчивую зону доступности (ru-2c) в столице. Производительность SSD-дисков здесь составляет до 25 000/15 000 IOPS, что в два раз больше, чем в других зонах этого региона (ru-2). Построена на базе процессоров Intel Xeon Gold 6240R и Intel Xeon Gold 6240.

kb.selectel.ru/docs/selectel-cloud-platform/main-services/general-concepts/regions_and_availability_zones/?

«Летаем» на Tesla T4

Завезли в Санкт-Петербург (регион ru-9) графические ускорители Nvidia Tesla T4. Высокопроизводительные GPU справятся на ура с задачами машинного и глубокого обучения. Для работы с ними рекомендуем использовать образ Data Science Virtual Machine (Ubuntu 18.04 LTS Machine Learning 64-bit). Если еще не знакомы с этой готовой средой для анализа больших данных и задач машинного обучения, советуем видео с митапа Uptime Community.

promo.selectel.ru/dsvm/

Удобство в управлении локальными дисками

Теперь вы можете создавать образы локального диска из панели управления. Образы нужны для резервного копирования и масштабирования инфраструктуры (увеличения количества виртуальных машин). Представьте, что ваш онлайн-магазин с веселыми новогодними носочками стал суперпопулярным, и вам нужно срочно увеличить количество виртуальных машин в 10 раз. Теперь эту задачу можно выполнить также с помощью «клонирования» локального диска. Создайте образ локального диска одной из настроенных машин и выберите его в качестве источника для остальных машин. Или перенесите уже все в Kubernetes! :)

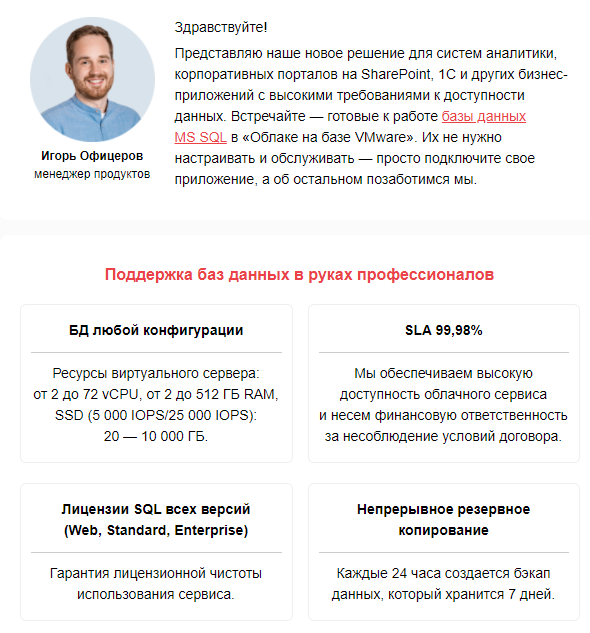

Готовые базы данных Microsoft SQL в облаке

Представляем вам готовые к работе базы данных Microsoft SQL, которые разворачиваются и обслуживаются специалистами Selectel. Базы защищены от DDoS-атак и размещаются в соответствии с 152-ФЗ, а настройка, обслуживание и резервное копирование включены в сервис. Решение подойдет для систем аналитики, корпоративных порталов на SharePoint, 1С и других приложений с высокими требованиями к доступности данных. Для начала работы достаточно подключить свое приложение — оно может располагаться в «Облаке на базе VMware», на выделенном сервере или в «Облачной платформе Selectel».

promo.selectel.ru/mssql/

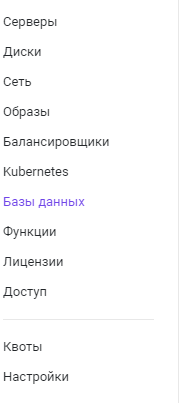

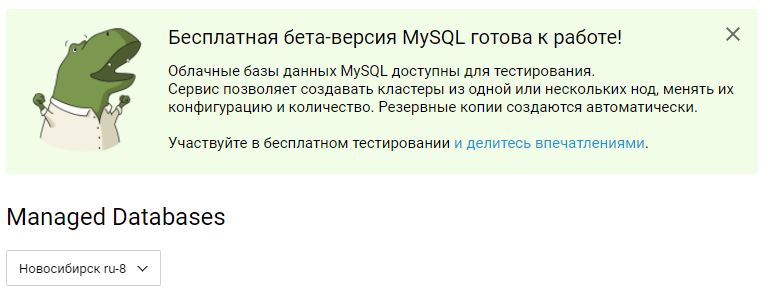

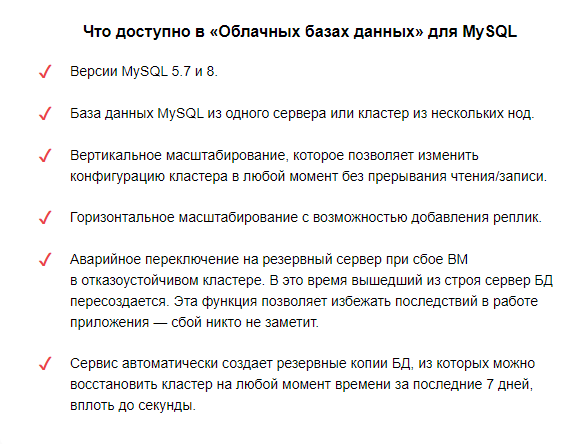

MySQL в «Облачных базах данных»

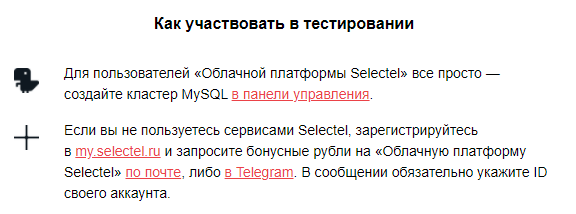

Официально объявляем старт беты MySQL в «Облачных базах данных»! Не откладывайте на завтра то, что можно протестировать бесплатно уже в этом году. Если вы давно ждали MySQL и являетесь клиентом Selectеl, просто добавьте кластер базы данных в панели управления. Если вы не пользуетесь нашими сервисами, зарегистрируйтесь и запросите бонусы на тестирование по почте либо в Telegram (не забудьте сообщить свой ID). Любую обратную связь можно оставлять по тем же ссылкам.

Редактор кода «Облачных функций»

Наши «Облачные функции» стали более удобными для пользователя. Вы можете писать и редактировать код функции прямо в панели управления. При внесении изменений не придется загружать код заново — достаточно скорректировать его и сохранить. Также добавили в панель несколько примеров функций. Среди них — декоратор для получения актуальной информации о погоде и курсе валют, функция, позволяющая интегрировать сайт без шифрования в сайт с HTTPS, и самый простой код для старта. Вам остается только адаптировать функцию под свои задачи и запустить.

selectel.ru/services/cloud/serverless/

Вместо «Иронии судьбы»

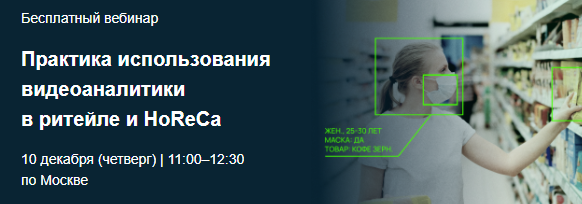

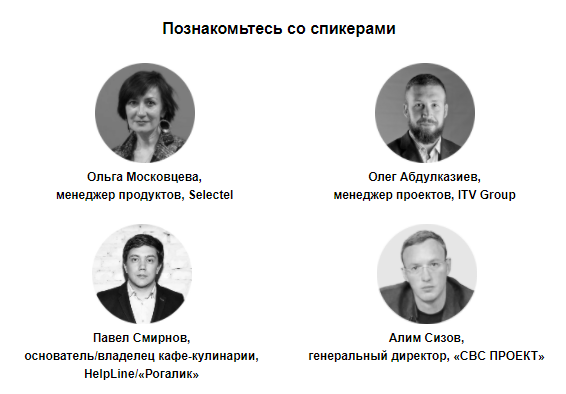

Если вы пропустили наш вебинар по практическому применению видеоаналитики в ритейле и HoReCa, советуем добавить в плейлист на новогодние каникулы. Вместе в приглашенными экспертами рассказали о практических кейсах применения камер наблюдения с подключенным сервисом аналитики данных. Вышло не менее захватывающе, чем фильмы про шпионов.

https://www.youtube.com/watch

selectel.esclick.me/DerggvzrHcmu

Пополняем Базу знаний

Говорят, наша База знаний захватывает, как серия книг про Гарри Поттера. Предлагаем проверить эффект на новых инструкциях в БЗ и на портале документации API.