Как вам 2020 год? Для нас он оказался не только пятым, юбилейным для RUVDS, но и очень разным. В марте мы все резко перешли на удалёнку, перестали ездить в офис и, как многие, оценили насколько удобно и быстро было решать вопросы, просто повернувшись на стуле к коллеге.

Судя по статьям на Хабре, наш переход на удалёнку был похож на все остальные: странные фоны в зуме, частые созвоны, круглосуточный Slack. Единственное, что существенно отличало нас от других IT-компаний это была работа системных администраторов с ЦОДом, когда Москву полностью перекрыли и проезд был только по пропускам.

Но несмотря на все проблемы, год выдался неплохим. Онлайновым, диджитальным, высоконагруженным — действительно, год за три.

Люди года

Люди года

Ночной ДЦ-дозор. Неспящие в сети и далёкие близкие

На территорию завода, на которой находится наш ДЦ в Королёве, вообще не пускали и не выпускали. Дежурная смена начала жить там постоянно — вдруг понадобится переключить пачкорд, поменять контроллер, гасить машину и так далее. Это длилось целый месяц до 16 июля.

Админы менялись раз в неделю. Попасть на территорию можно было только по согласованным с руководством завода спискам, с обязательной проверкой температуры.

Наш главный администратор Костя показал себя настоящим героем – однажды у него выдались две недели, когда он работал без выходных 14 суток, потому что подменял ребят или просто давал им отдохнуть.

Было забавно наблюдать через зум, как поддержка постепенно начала обрастать бородой, рубашки постепенно сменились на толстовки и пижамы, а искусственные фоны из гор и океанов перестали включать и не стесняться даже немытой посуды на фоне. Как ни странно, это вынужденное расстояние сделало нас немного ближе.

Мы сумели сохранить некоторые офисные традиции, например, пицца-дей по пятницам — просто пицца теперь ехала не на Тверскую, а сразу по многим адресам по всей Москве и Подмосковью. В марте мы сделали внутренний сайт-шутку — калькулятор туалетной бумаги — сколько рулонов надо запасти на время, которое мы просидим на карантине (ну чтобы заказать потенциально дефицитный продукт сразу в достаточном количестве).

Поддержка: новый tone of voice и много человечности

Мы всегда уделяли особенное внимание поддержке: у нас она круглосуточная, ей можно не только писать, но и звонить. Среднее время ответа нашей поддержки — 15 минут, в авральные дни количество обращений может переваливать за 1000.

В таких условиях тикеты надо закрывать очень быстро, но качественный сервис это не только скорость, а в том числе общее впечатление от разговора. Раньше ответы поддержки были сухими и короткими, чтобы как можно точнее и быстрее отвечать. Часто встречались бюрократические конструкции, будто разговор идёт не с живым человеком, а с гос.чиновником или даже со скриптом или ботом.

Этот год вывел на первый план человеческие отношения, вернул ценность общению, искренности. Наверное, неслучайно именно в 2020 мы сделали качественный скачок в том, как общаемся с клиентами.

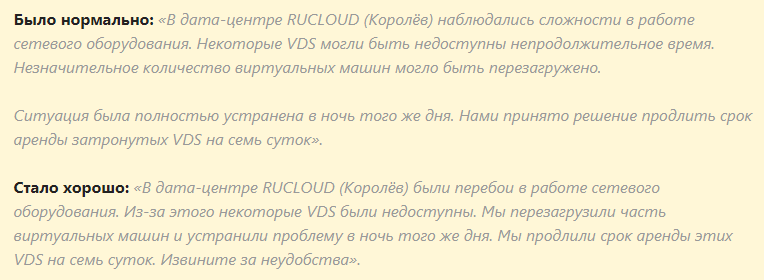

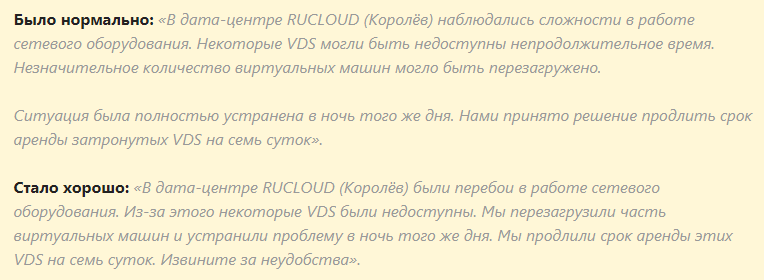

Сравните:

Что мы сделали: заменили сложные бюрократические конструкции на понятный и простой русский язык, которым мы разговариваем между собой и с близкими. Отказались от страдательного залога, который создаёт ощущение разговора с корпоративной машиной, а не живым человеком. Каждый сотрудник теперь ведёт диалог от своего лица: я перезагружаю ваш сервер, я проверяю нагрузку. Ведь проблему решает конкретный человек и именно он сейчас заботится о клиенте.

Начали брать больше ответственности: не забывать извиняться, если проблема действительно была на нашей стороне и клиент потерпел неудобства или решение проблемы затянулось из-за того, что проблема оказалась сложной и пришлось передавать её решение системному администратору.

Мы начали объяснять клиенту свои действия и почему надо подождать (если надо) — с полной информацией о происходящем людям проще переносить ожидание.

Изменились правила закрытия тикета — отныне тикет закрывается не когда решена техническая проблема, а когда у клиента больше не осталось вопросов.

Результаты не заставили себя ждать — теперь тикеты закрываются на сообщениях «Спасибо!» или «Теперь всё в порядке, спасибо вам» от клиентов, а не обрываются, как раньше, и нас это очень радует.

Подробно про то, как мы прокачивали общение поддержки — в

посте на Хабре.

Инфраструктура года

Три новых дата-центра

С дата-центрами у нас случились три новости: во-первых, порог дата-центра бункера Rucloud впервые перешагнула женщина. Результатом стал фотоотчёт к статье Наш первый ЦОД в советском бомбоубежище: особенности вычислений в бункере и непередаваемый шок от того, что в дата-центре отсутствует женский туалет как класс.

Но, кроме этого, мы запустили три новых дата-центра.

Амстердам

Это центр обработки данных Interxion AMS9, расположенный в Амстердаме, в Science Park Data Center – ведущем центре межсетевых соединений города.

За что мы его любим?

- Удачное расположение: он соединён с крупными точками обмена интернет-трафиком, обеспечивает хорошую связь со странами как Нового, так и Старого Света и доступ к данным из любой точки мира с самой низкой задержкой – 99,99999%.

- Безопасность и конфиденциальность данных: у Interxion очень высокие внутренние стандарты безопасности. Несколько уровней физической безопасности и сертификацию Tier 3, биометрическая и двухфакторная аутентификация, доступ по магнитным картам. Камеры внутреннего и наружного наблюдения, многочисленные датчики движения, а картинка о происходящем в ЦОД круглосуточно транслируется на мониторы службы охраны. Сотрудники службы безопасности работают круглосуточно.

Останкино

Останкино

Буквально на днях после упорной работы мы запустили новую локацию — дата-центр практически в самом сердце Москвы, Останкино.

ЦОД ТТЦ Останкино находится в Москве, по адресу 1-ая Останкинская ул., д. 1, стр. 1. Это ещё один дата-центр уровня TIER III в нашем парке. Старожилы говорят, что аптайм этого места 20 лет!

Почему мы его выбрали и за что любим:

- Обособленная территория в центре Москвы, куда мы сможем максимально быстро доставлять оборудование.

- Видеонаблюдение стоек без мёртвых зон и круглосуточная охрана на уровне стратегического объекта обеспечивает безопасность.

- Ремонты без отключения: резервные системы позволяют проводить плановые ремонтные работы и ТО, не затрагивая клиентов.

- Подведённая к объекту электрическая мощность – 11 МВА означает подключение мощных вычислительных кластеров и возможность расширить линейку тарифов и серверов.

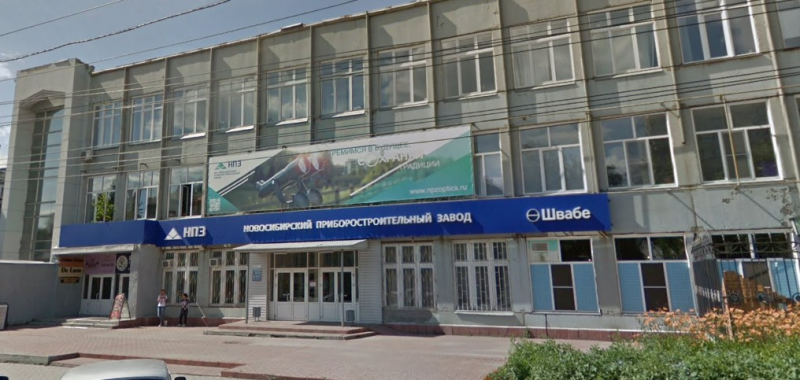

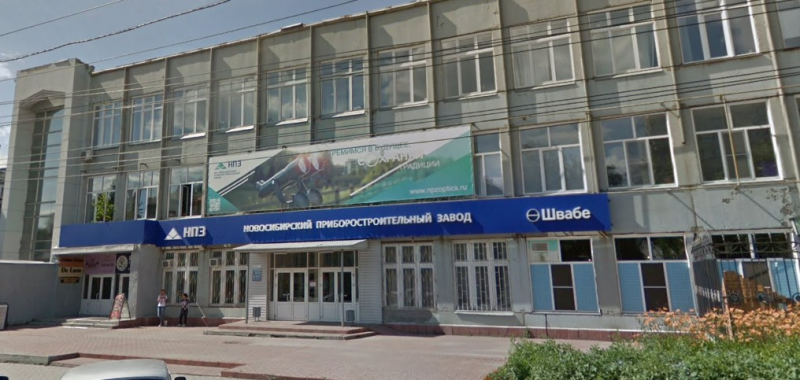

Новосибирск

Новосибирск

Это дата-центр «Калининский» по адресу г. Новосибирск, ул. Дуси-Ковальчук, 179/3.

Мы любим Новосибирский ДЦ за надёжную инфраструктуру:

- 2 городских ввода электропитания, каждый из которых зарезервирован собственным ИБП

- Система видеонаблюдения осуществляет круглосуточный контроль за всеми объектами ЦОД

- ДГУ Genelec с запасом топлива на 24 часа бесперебойной работы

- Техническая поддержка 24/7/365

Победы года

Победы года

Работа над продуктом: запуск локальной сети, снапшоты, маркетплейс

Несмотря на удалёнку, мы не снижали темп развития продукта, а скорее даже ускорили его и плотно взялись за вопрос удобства работы с сервисом. Как всегда, оказалось, что беклог пожеланий бесконечен, улучшить хочется всё и после жарких споров в переговорке и километров переписки с клиентами для сбора пожеланий и чего таить, подсматривания за иностранными лидерами рынка, мы составили список из первых 10 фич, которые надо внедрить.

Кое-что мы успешно запустили в этом году.

Локальная сеть

Локальные сети мы предоставляли и раньше, но только по запросу в Техническую Поддержку. Совсем давно всё делали вручную, не заморачиваясь с «технологиями»: все виртуальные машины, которые пользователь просил объединить в сеть, перетаскивались на один хост, на котором создавалась локалка. Спустя какое-то время мы отказались от перетаскивания, но, всё равно, вручную, за счёт VLAN-ов, объединяли виртуальные машины в локальные сети уже на разных хостах (но не цодах).

Это было долго и неудобно для клиентов, поэтому мы решили упростить и ускорить процесс, хотя услуга нужна далеко не каждому пользователю, и, в принципе, может быть заменена VPN'ами.

Но запросы продолжали приходить и мы хотели сделать всё удобнее. Мало того, можно понять тех клиентов, которым c VPN-ами и ZeroTier-ами разбираться не нравится и не хочется. Мы, кстати, заодно постарались немного упростить жизнь и тем, кому интересно использовать вышеупомянутые технологии. Для ZeroTier у нас есть образ в маркетплейсе, который существенно поможет в развёртывании и управлении, а также целый цикл статей (3 штуки, вот первая), который описывает эту технологию. Для VPN у нас также есть образ в маркетплейсе.

Некоторые хотят (например, из соображений безопасности) скрыть свою инфраструктуру за некоторым количеством «публичных» машин, ведь у нас с каждой проданной виртуалкой выдаётся белый адрес для доступа к ней. А кому-то нужен бродкаст и мультикаст, который недоступен иначе как в локальной сети.

В общем, нам хотелось исключить ручной труд по настройке сетей между виртуальными машинами, но при этом сделать так, чтобы настройка локальных сетей была доступна через Личный Кабинет всем пользователям; чтобы можно было максимально быстро соединять виртуальные машины в любых точках нашего присутствия (их целых десять, одиннадцатая «на носу») и чтобы получение услуги было проще, чем настройка любого VPN.

Теперь в Личном Кабинете на вкладке «Мои серверы» у каждого виртуального сервера появилась новая вкладка, на которой производится настройка сетей. На этой вкладке пользователь может создать локальную сеть (одну, но можно и две, если обратитесь в техническую поддержку) и добавить в неё виртуальные машины из своего Личного Кабинета. После развёртывания у выбранных виртуалок появляется дополнительный сетевой адаптер, которому будет назначен статический адрес. При необходимости адреса могут быть переназначены, из подсети выбранной при создании локалки, вручную или же можно настроить DHCP-сервер.

Снапшоты

Мы хотели добавить снапшоты по двум причинам: это удобно для клиентов и, как выяснилось, это существенный шаг в дальнейшем развитии нашего маркетплейса.

Хотелось ускорить наполнение маркетплейса образами и привлечь к этому коммьюнити. Но для этого предварительно требовалось решить несколько дополнительных задач: нужно дать пользователям удобный механизм создания образов из Личного Кабинета, дать возможность их тестировать, сделать автоматическую систему валидации и тестирования полученных образов.

Именно в качестве решения для первой дополнительной задачи и появились снепшоты. Но с их помощью можно убить ещё нескольких зайцев. Теперь пользователь может сделать небольшой бекап не по расписанию, а конкретно тогда, когда это нужно. «Клонировать» виртуальную машину или перенести её в другой датацентр можно без обращения в Поддержку — всё делается через Личный Кабинет. Пока не без костылей, но начало положено.

Помимо нашего личного интереса в снапшотах, они сделали жизнь клиентов удобнее — появилась возможностью создать бекап «по клику». Выиграли в стоимости: хранение снапшотов гораздо дешевле! Но всё же необходимо понимать, что это совершенно разные услуги: снепшоты не предназначены для хранения больших объёмов данных, не призваны обеспечить высокую надёжность и не имеют возможности настроить их регулярное пересоздание.

Создание образов кастомных ОС из собственных виртуалок, для последующего создания через страницу заказа. Применений этой функции масса — многое зависит уже не столько от нас, сколько от фантазии клиента. Например, можно сделать шаблон рабочего места для сотрудников, который позволит создавать серверы с предустановленным ПО сразу готовыми к использованию. Или сохранить шаблон ноды приложения, которая будет автоматически разворачиваться через API по команде балансировщика при увеличении нагрузки на систему.

Новая вкладка на странице «Мои серверы» у каждого виртуального сервера. На ней одна единственная кнопка: «Создать». Всё максимально просто.

Сделали маркетплейс открытым для сообщества и существенно его расширили

Как мы уже говорили раньше, появление снапшотов позволило нам прокачать маркетплейс. Мы очень активно общаемся с клиентами и это не только тикеты или комментарии на Хабре.

Многие пишут нам в личку на Хабре. Есть клиенты, которые сидят в коллективных чатах с нашей командой — они сразу скидывают пожелания по UI/UX, репортят о каких-то мелочах, недочётах или высказывают пожелания по продуктовым изменениям.

Есть студенческие команды, которым мы выдаём бесплатные VPS для обучения технологиям — они помогают нам понимать не только тех клиентов, которые уже работают сейчас, а держать нос по ветру и понимать, чего захотят клиенты в будущие 3-4 года, какие технологии их интересуют и чего они хотят от сервиса будущего.

Поэтому превращение маркетплейса из лично нашей вотчины во что-то, что растёт и развивается само по потребностям рынка, было вполне логичным стратегическим шагом.

Так мы начали принимать образы от сторонних разработчиков и придумали систему защиты клиентов от бекдоров.

Как мы проверяем готовые образы от сторонних админов и как защищаем их от бекдоров? В будущем в наши планы входит дать возможность пользователям добавлять свои образы непосредственно в маркетплейс. Для этого, конечно, нам понадобиться система автоматической проверки образов. Пока к этой задаче не приступали и нет никакого понимания как она может быть решена. В данный момент те образы, что присутствуют в маркетплейсе, добавлены в основном нашими сотрудниками. Некоторые помогли настроить аутсорсеры, поделившись скриптами для настройки того или иного софта. Но все скрипты и инструкции по настройке тщательно проверяются опять же нашими сотрудниками.

Спецпроекты года: Хабр, женщины, хакеры и пиво

Мы любим похулганить с пользой: в прошлом году была регата, запуск сервера в стратосферу, переписка с космосом и масса других безумных и крутых экспериментов. На 2020 год тоже было планов громадьё, но все они накрылись короной.

А раз отпал оффлайн, то кто, как не мы, должны были захватить онлайн? Сказано — сделано.

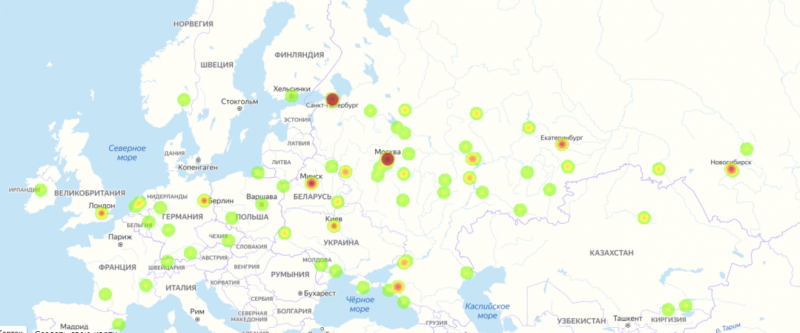

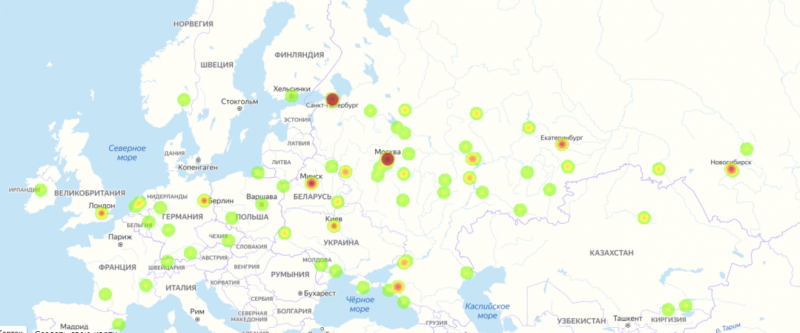

Спецпроект IT is Female на 8 марта

На 8 марта решили вывести на передний план наших коллег-женщин и сделали сайт с тепловой картой офисов, которые показывают компании, в которых работает больше девушек-айтишниц. На сайте проекта любая девушка могла загрузить свою фотографию, отметить кем она трудится в IT-индустрии и написать короткое пожелание остальным. Всего отметились почти 500 девушек.

От такой тепловой карты и на душе тепло.

Конкурс мемов с Хабром

Конкурс мемов с Хабром

В июле мы провели совместный с Хабром конкурс мемов. Авторы, попавшие в шорт-лист, получили ачивку в профиль, а мемы победителей пользовательского голосования стали основой для новой линии фирменного мерча в Хабр Киоске.

Под каждым вариантом принта был указан его автор и авторы получили экземпляр футболки с придуманным мемом и 500 рублей на внутренний счёт RUVDS, которые можно потратить на любые виртуальные серверы.

А вот и луч смеха в тёмном царстве 2020 года:

Про Хабр и конкурсы читайте там

habr.com/ru/company/ruvds/blog/534636/