У нас ещё есть некоторое количество остатков с прошлого кризиса железа

Из-за того, что все хотели ролик с матерящимся бобром, танцующим Мадуро или хотя бы переделать индуса в красивую девушку, у нас тут бум AI-моделей. Эти модели работают на физическом железе и физическом электричестве. Железо, к сожалению, закончилось раньше, чем электричество.

Первыми пострадали не процессоры, как мы ждали, и не видеокарты, как мы уже видели, а банально оперативная память. И отчасти — SSD.

Рынок снова сошёл с ума и стал диким.

Я узнаю знакомые барыжные шаблоны ещё с эпопеи с майнингом и повышением цен на видеокарты. Вот смотрите, на момент публикации серверная планка 96 Гб DDR 5 стоила:

- В Регарде «чисто», с документами и гарантией — 410 тысяч рублей. Для контекста: летом 2025 года, всего полгода назад, эта же позиция здесь же стоила около 90–100 тысяч рублей.

- Но её можно купить на сером рынке у барыг. Иногда они мимикрируют под приличные компании, у них безнал с НДС, но цена плавает весь день, как биржевая котировка. Утром тебе говорят: «330 тысяч». К обеду партия может исчезнуть или стоить уже 350.

- Есть совсем уж барыги с Горбушки и Савёлки — без документов и оплата только наличными, а получение планки — в подворотне. Цена вопроса — 250–280 тысяч рублей.

Но купить сложно. Продавец ведёт переговоры одновременно с десятком покупателей. Ты пишешь: «Возьму 20 штук». Он отвечает: «Есть 10». Пока ты едешь с деньгами, кто-то другой пять уже забрал. Никаких гарантий до момента передачи товара из рук в руки. Это не бизнес-процесс, это квест.

Это не временный всплеск и не сезонное колебание.

Давайте немного разберёмся, что же случилось.

- TrendForce DRAM Market Report 2025–2026

- PCPartPicker Price Trends (May–Dec 2025)

- IDC Worldwide Quarterly Server Tracker

- Gartner Semiconductor Forecast

- ComputerBase & Tom's Hardware analytical summaries (GPU Crisis 2017–2022)

Рынок сорвался с цепи

Всё началось незаметно ещё в начале осени. Где-то в октябре наш поставщик железа по России написал, что хорошо бы зафиксировать объёмы поставок на следующий год. Мы не придали этому значения: обычно это часть переговоров. Он начал торопить, и это уже немного раздражало, но всё ещё не выбивалось за ситуацию «с нами агрессивно торгуются». Потом он начал давить ещё сильнее, и мы спросили, а почему он так волнуется.

Он объяснил, что за те четыре дня, пока мы переписывались от первого «Пацаны, определяйтесь уже там быстрее» до момента, когда мы спросили, а чего он такой нервный, цены выросли на 10%.

Нас это снова не особо побеспокоило, потому что тогда оперативка ввозилась через страны СНГ, и в Казахстане как раз были проблемы с логистикой: заторы на границах и так далее.

Мы списали это на волатильность курса и пробки. Казалось, это обычная осенняя история.

Оказалось, что зря мы так подумали.

К декабрю ситуация превратилась в абсурд. Мы искали серверную память высокой плотности — DDR5, 128 ГБ, частота — 5600 или 6400.

Выяснилось, что это не чисто российская проблема с логистикой и санкциями.

Вот данные TrendForce: цены на оперативную память выросли на 171% год к году. Обещают рост ещё на 90–95% в первом квартале 2026-го. Это крупнейший квартальный скачок за всю историю наблюдений. Такого не было ни в 90-е, ни в кризис доткомов.

Данные PCPartPicker (розница, май → декабрь-2025):

- DDR4-3200 16GB: рост с $50 до $120 (+140%).

- DDR5-6000 32GB: рост с $120 до $410 (+242%).

- DDR5-6000 64GB: рост с $210 до $750 (+257%).

В Японии, в Акихабаре, магазины Tsukumo и Sofmap ввели лимиты на продажу памяти в одни руки. В США сеть Micro Center просто убрала ценники с полок с DDR5, предлагая уточнять цену у консультанта — классический признак гиперинфляции. Ноутбуки Framework перестал продавать модули памяти отдельно, потому что к ним не покупали самих ноутбуков. На eBay перекупы накручивают 150–250%, и люди покупают, потому что больше негде. CyberPowerPC, крупный сборщик компьютеров, официально объявила о повышении цен на свои системы, сославшись на удорожание RAM на 500%.

У нас прямо классический барыжный флёр. Можно поехать на Горбушку с сумкой нала и по дороге узнать, что партия ушла. Пишут: «Пришло транзитом, сразу ушло, сейчас есть остатки, но дороже».

Можно выгрызать куски партий: тут 10 планок, тут — ещё четыре, а тут — восемь. Все по разным ценам. Все прыгают. Больше партия — дороже планка.

Ещё есть возможность вывезти из Дубая. Там память стоит на 30–40% дешевле (около 180000 рублей в пересчёте за ту планку, что у нас стоит 250000). Но там проблема с лимитами наличных — 10 тысяч. Это всего 10–15 планок. Разве что сразу ехать автобусом админов.

Ну и я знаю людей, кто ездил в Минск, где процентов на 10 дешевле. Один тоже по дороге узнал, что партии уже нет. Для барыг сейчас важно продать в первые руки — никаких долговременных договоров нет.

DDR4 стала дороже DDR5

А потом случилось самое смешное — инверсия поколений. В смысле, что предыдущее поколение железа стало дороже текущего. Этого в нормальной экономике вообще быть не должно.

Всё это потому, что ChangXin Memory Technologies переключился на дефицитную DDR5. Дешёвая память исчезла моментально. А у огромного количества компаний серверный парк построен с DDR4. Раньше можно было просто докупить память и продлить жизнь сервера на пару лет. Теперь дешевле (условно) выкинуть старый сервер и купить новый на DDR5, но и такой стоит космос.

Тут же ожил вторичный рынок: из старых серверов выдирают память DDR4 и продают её отдельно, потому что внезапно она стала золотым активом.

И, прикиньте, подорожала даже б/у DDR3. Даже до неё дошло дело!

Но почему?

- AI выгребает всё. OpenAI подписала соглашение с Samsung и SK Hynix (проект Stargate) на выкуп 900000 пластин DRAM в месяц. Это, на секундочку, около 40% всего мирового производства DRAM на текущий момент. Два клиента забирают почти половину мирового запаса.

- Для видеокарт NVIDIA (H100, H200, Blackwell) нужна специальная память — High Bandwidth Memory. Она сложнее в производстве. Каждый бит HBM требует в три-четыре раза больше места на кремниевой пластине, чем обычная DDR5. При этом выход годных чипов у HBM низкий — около 50–60%. Чтобы произвести одну планку HBM, заводу нужно пожертвовать производством десятка планок обычной памяти. Маржа на HBM выше, поэтому Samsung, SK Hynix и Micron массово перепрофилируют линии. Обычная память им просто неинтересна. Доля HBM уже съела ~30% всех производственных мощностей.

- Глядя на эту историю, производители, похоже, решили доформировать дефицит. А что? Это же легко, можно ещё разогнать цены. В Samsung перешли на ежемесячное ценообразование. Это сигнал рынку: «Мы не знаем, что будет завтра, но точно будет дороже». В Micron 3 декабря 2025 года объявили о выходе из потребительского бизнеса, А ведь они контролировали ~20% рынка.

- Ещё есть история в США. Анонсированные тарифы в 25 и 100% на импортные чипы (привет, администрация Трампа!) стали добивающей новостью. Сборщики серверов (Dell, HP, Supermicro) начали скупать всё, что есть на складах, чтобы успеть до введения пошлин.

- Если вам мало — ещё есть Тайвань. А Тайвань трясёт: три землетрясения за полтора года (апрель-2024, январь-2025, декабрь-2025). Каждое событие — это остановка линий. Потери TSMC от одного толчка оценивались в $92 млн. Micron теряла 4–6% квартальных поставок. Кварцевые трубы в печах лопаются, калибровка сбивается, производство падает.

А ещё Samsung и SK Hynix скоординированно сократили производство NAND более чем на 10%, чтобы удержать цены. В итоге NVMe-диски кратно подорожали вслед за оперативкой.

Я это уже наблюдал на видеокартах

Те, кто пытался собрать игровой компьютер или ферму в 2017-м или 2021-м, сейчас испытывают мощнейшее дежавю. Я вот, например, испытываю. Думаю, что ситуация с оперативкой — это прямо то же самое.

Первая волна была в 2017–2018 годах. Биткоин впервые пробил 19 тысяч долларов. Видеокарты AMD RX 580 продавались в три раза дороже стартовой цены. Точнее, не продавались, потому что просто пропали из магазинов. Nvidia тогда пыталась ограничивать продажи ограничением «две в руки», как сейчас японцы лимитируют оперативку.

Вторая волна пришла в 2020–2021 годах. Сошлось всё: ковид, сидение дома, дефицит чипов и взлёт Ethereum. В апреле-мае 2021-го цены дошли до 329% роста на

RTX 3080, 230% — на RTX 3060 Ti.

Использовали ботов, чтобы выкупать партии за секунды. Сейчас барыги с Савёловского делают то же самое с серверной памятью: выкупают любые стоки, чтобы продать страждущим за нал с наценкой в 50%.

Рынок видеокарт вылечился только после перехода Ethereum на Proof of Stake 15 сентября 2022 года. Майнинг на видеокартах умер в один день. Плюс там же были падения криптобирж FTX и экосистемы Terra/Luna.

Цены упали до изначальных (с учётом инфляции). Не сразу — это шло восемь-девять месяцев. На вторичный рынок пошли ужаренные карты из майнинг-ферм. В Китае их продавали на вес.

У нас было несколько GPU-серверов для архитекторов и других графических нагрузок, и мы знали, что наши карты, купленные за 60 тысяч, стоили на Авито 20–30 тысяч.

Что будет с оперативкой?

Стоит ли ждать, что пузырь лопнет и цены вернутся к комфортным значениям лета 2025 года?

Нет.

У кризиса оперативной памяти нет события, которое его остановит. AI вроде бы не собирается прекращать обучаться или останавливать инференс.

Чтобы цены рухнули, должен лопнуть пузырь искусственного интеллекта. Многие говорят, что AI — это хайп и скоро инвесторы разочаруются. Признаки этого есть. Инвесторы начинают задавать неудобные вопросы, а вместо прибыли им показывают красивые видео и то, как ChatGPT пишет стишки. Экономический эффект от внедрения ИИ пока несопоставим с затратами на железо.

Дальше либо это изменится, либо наступит «зима AI». Но даже если она наступит, инерция всё равно будет огромной. OpenAI, Google, Microsoft и другие запрещённые в России организации уже оплатили квоты на производство чипов на годы вперёд. Там контракты, которые нельзя взять и просто прекратить. К тому же видеокарты были нужны только майнерам и геймерам, а память нужна всем. Если отвалится AI, то останется дефицит в других сегментах.

Новые фабрики Samsung P4 и SK Hynix M15X начнут промышленный выпуск не раньше 2028 года. До этого времени физического увеличения объёмов ждать особо не стоит.

Gartner прогнозирует рост цен на DRAM в 2026 году ещё на 47%. Counterpoint прогнозирует: цена на серверные модули 64GB DDR5 RDIMM может удвоиться к концу 2026-го. SK Hynix прямо заявляет: все мощности на 2026 год «фактически распроданы».

Представитель Kingston Кэмерон Крэндалл высказался предельно честно:

«Если планируете апгрейд, то делайте это сейчас. Через 30 дней будет дороже, и ещё через 30 дней — тоже».

Что мы делаем тут в России

Теперь — о том, как мы принимаем решения про закупку железа.

Если что, то мы не торопимся, и закупаем по обычному графику.

Допустим, что вы оптимист. Вы верите, что рынок перегрет и вот-вот скорректируется на 30–40%. Здесь есть валютный риск. Условно сейчас рубль держится в коридоре 70–90 за доллар.

Если через полгода мировые цены на память упадут на 40%, а рубль ослабнет к доллару на те же 40% (что вполне реально при возобновлении активного импорта или изменении сальдо торгового баланса) — смысла дёргаться нет.

Можно получить и суперкомбо: дорогой доллар + дорогая память.

Мы находимся в ситуации, когда плохих решений много.

Если мы сейчас остановимся в закупках железа, то проиграем долю рынка. В смысле клиентов не потеряем, но рынок растёт, и не расти вместе с ним — значит, терять долю. А наша конечная задача — захватить мир, а не сэкономить.

Если закупаться на всё — можно знатно рискнуть: тоже не вариант.

Превращаться в «дойную корову» — выжимать из старого железа всё до последней капли, пока оно не умрёт, — тоже путь к банкротству. Железо быстро станет медленным для клиентов, дороже в обслуживании, накопит проблемы, клиенты уйдут, а восстановиться будет нечем. В хостинге и облаках долю рынка вернуть почти невозможно: клиент, ушедший на чужие мощности, редко возвращается обратно.

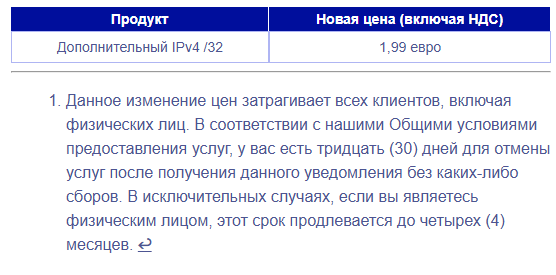

Удорожание сервера на 30% увеличивает его окупаемость на те же 30–40%. Единственный способ сохранить рентабельность — переложить эти расходы на клиента. Рынок растёт, спрос на вычислительные мощности (даже без учёта AI) — огромный. В России у нас давно (с 2022 года) дефицит стоек в ЦОДах: сервер физически некуда поставить.

То есть можно или поднять цены клиентам, или потерпеть и работать с меньшей маржинальностью. Мы, наверное, выберем и то и другое.

ruvds.com/ru-rub