Строится Nubes Strato

nubes.ru/dc/colocation

Облачный провайдер Nubes (НУБЕС) планирует запустить новый ЦОД Nubes Strato в сентябре 2024 года. Дополнительные вычислительные мощности будут использоваться для развития облака NGcloud и облачных сервисов компании. Кроме того, клиенты смогут арендовать часть стоек для гибридных решений.

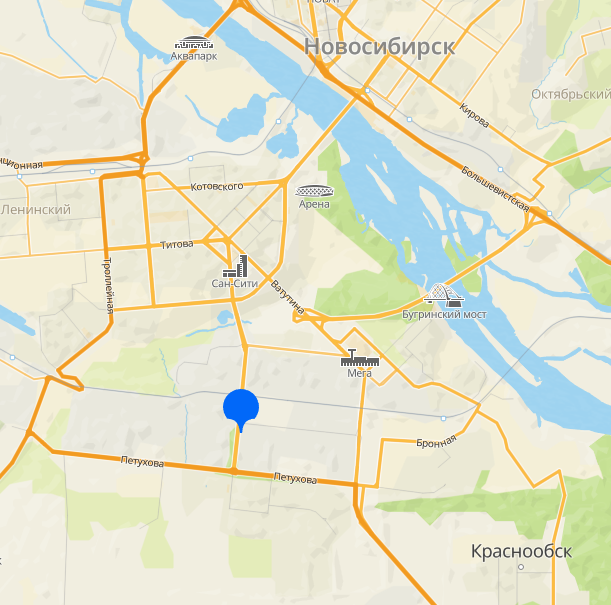

Дата-центр на 198 стоек строится на огороженной территории на юге Москвы (м. Царицыно). Новый объект находится рядом с Nubes Alto — первым ЦОД компании, который был запущен в 2022 году.

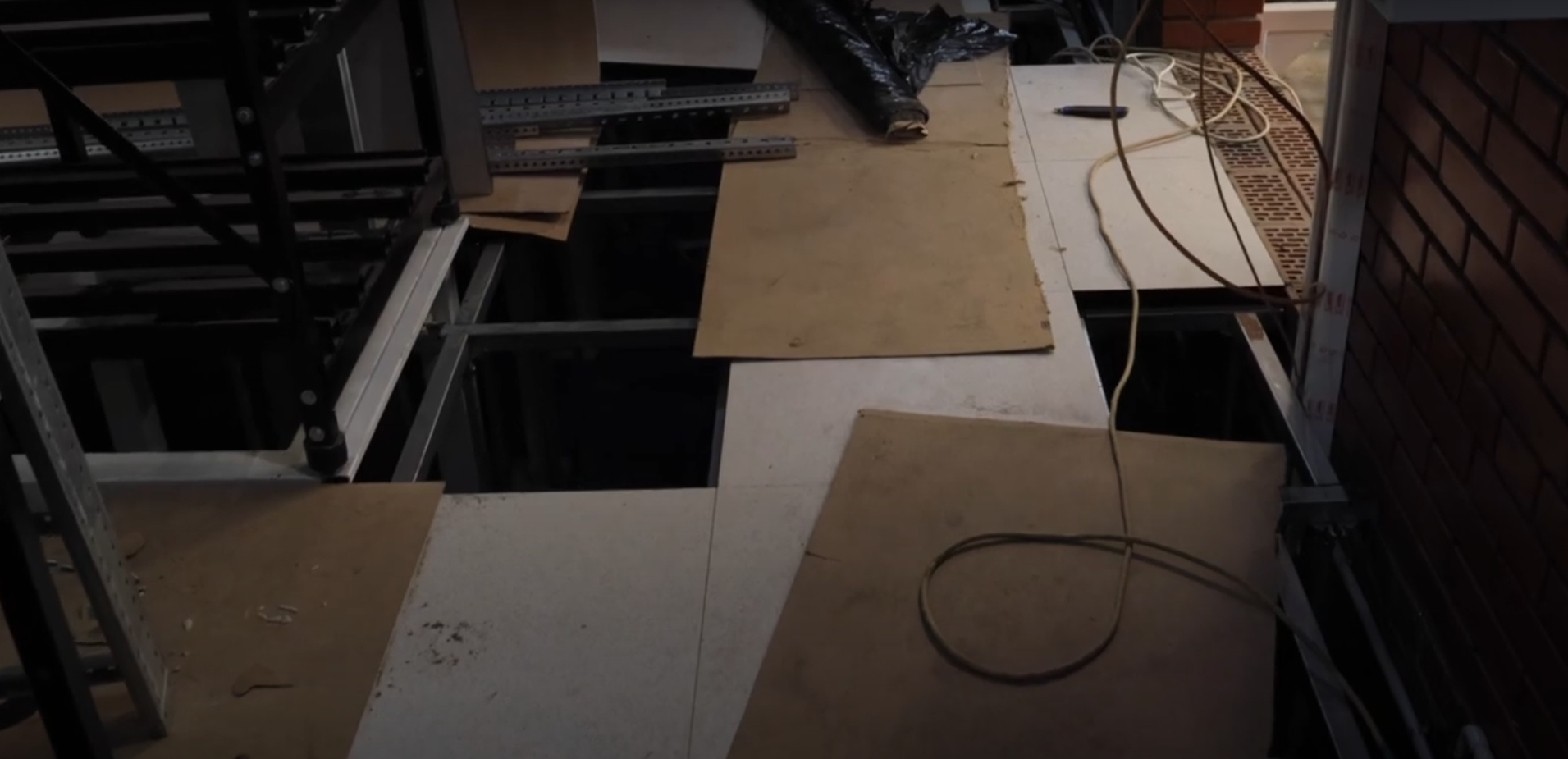

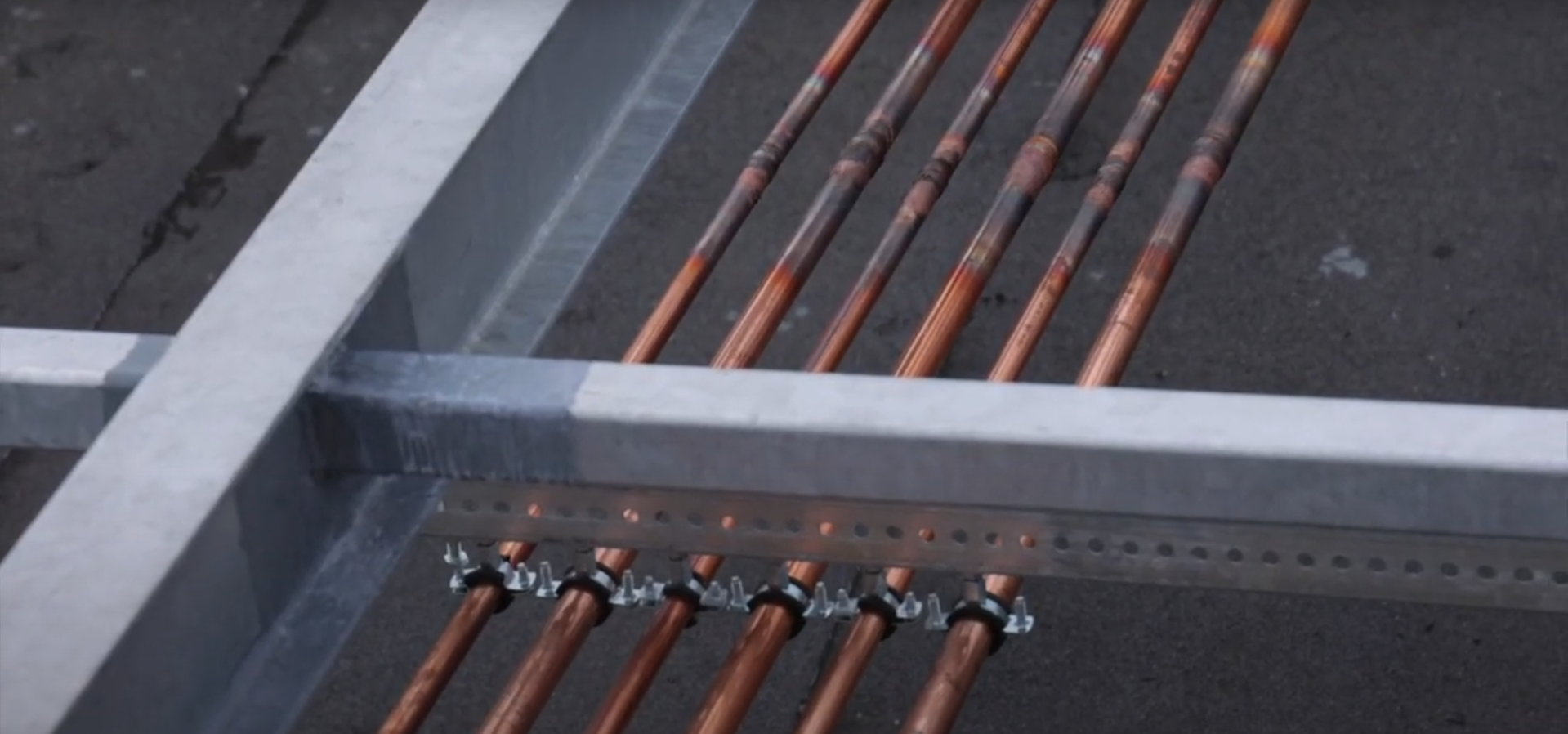

Запуск нового дата-центра планируется в сентябре 2024 года. На текущий момент в помещениях проходит монтаж инженерной инфраструктуры. В ближайшее время на площадке будут установлены источники бесперебойного и гарантированного электроснабжения (ДГУ). Параллельно провайдер занимается закупкой вычислительного и сетевого оборудования.

Мы строим второй дата-центр для расширения наших возможностей по предоставлению клиентам гибридных решений. Также на базе Nubes Strato продолжит развиваться наше облако нового поколения NGcloud со встроенными средствами защиты, а клиенты смогут размещать собственное оборудование в стойках и интегрировать его с облакомрассказывает генеральный директор компании Nubes (НУБЕС) Василий Степаненко

Пока защищенное облако NGcloud функционирует на базе ЦОД Nubes Alto уровня Tier III. Здесь же развернуты все облачные ИБ-сервисы компании, а также решения для удаленной работы, хранения данных и других задач. Кроме того, в дата-центре Nubes Alto клиенты размещают собственное серверное и телеком-оборудование (colocation).