Я тут

ванговал, что ЦОДы подорожают и будет дефицит стоек. И знаете, ЦОДы подорожали и появился дефицит стоек.

Удивительно, но если перестать строить дата-центры, то уже построенных не хватит. Могло показаться, что когда уйдут всякие западные компании, места освободится много. Да, было такое. Места хватило на месяц. Потом из дальних стран начали возвращаться российские компании.

Но давайте посмотрим, что происходит прямо сейчас. Первое и самое очевидное —

дефицит ЦОДов сохраняется.

Цены на услуги выросли.

И тут же, как по команде, все кинулись искать ЦОДы в регионах.

Самое смешное в этой истории, что главный драйвер роста — ИИ-технологии (если что, по большей части так называют LLM-инференс). Предполагается, что каждому заводу нужно будет рядом по огромному ЦОДу, чтобы смотреть на конвейер или с помощью какой-нибудь китайской нейросетки, или от того же Яндекса, или ещё от кого-то. Я утрирую, но логика роста рынка именно такая.

Если ИИ сдристнет в Казахстан (из-за санкций) — эта модель порушится. Но пока возникают невероятно интересные штуки в регионах. Например, это ЦОДы-призраки, которые существуют, там можно арендовать стойку, но у них даже нет сайта. Потому что зачем?

Появилась даже профессия ЦОД-скаута. Это почти как риэлтор, только профессия полезная и требующая специальных знаний.

Всплыл такой модный тренд — Edge-вычисления, они же — граничные вычисления

Это вычисления, максимально близкие к заказчику, к источнику данных.

Поначалу это было важно тем, у кого Edge-соединение или спутник, чтобы не гонять трафик через центральный ЦОД, а считать на месте — около завода. Но назвали их так не в честь 2G.

Потом оказалось, что это что-то вроде CDN, только вместо C — вычисления. Те же городские серваки с Контр-Страйком — это Edge-вычисления до того, как это стало модным.

Но больше всего в перспективе это нужно для всяких AI-моделей, для работы с Big Data (чтобы не гонять то же самое «сырое» видео 4K по магистралям) и там, где важна минимальная задержка. Представьте, что вам нужно обработать гигабайтный снимок МРТ и получить результат немедленно, или данные с производства льются потоком.

Вот Edge и решает эту проблему. Это что-то вроде CDN, но если CDN — это про медиа и видео, то Edge — это про серьёзные вычисления. И да, это международный тренд, а не какое-то наше ноу-хау. Конечно, ЦОДы не строят только ради того, чтобы выиграть одну-две миллисекунды, но спрос на региональные ЦОДы для таких вот специализированных задач есть.

Для нас это важно. Годами в своей стратегии мы шли по пути максимального покрытия территорий, и сейчас у нас, пожалуй, самая большая сеть ЦОДов для облачных сервисов и виртуалок по России и зарубежью. И это важно, потому что, скажем, если вам нужен быстрый инференс (а европейские площадки для многих российских компаний заблокированы), то приходится искать решения здесь, в России. А чтобы они хорошо работали с зарубежными партнёрами, нужно и связность хорошую иметь, и географически быть не на краю света.

Так вот, региональные ЦОДы с их свободными (и более дешёвыми) мощностями — это один из факторов, который может немного охладить перегретый московский рынок.

В общем, мы годами шли в региональное покрытие, но не знали точно, зачем. Просто так чувствовали. Теперь начинаем догадываться.

Началась стройка новых ЦОДов (на самом деле — нет)

Все вокруг кричат, что строят, строят и строят новые ЦОДы. Планы грандиозные: на всех экономических и отраслевых форумах трубят, что в ближайшие три–пять лет введут чуть ли не 30 тысяч новых стоек. Звучит красиво, но в моменте, я думаю, дефицит всё равно сохранится. А вот через пять-шесть лет тренд уже удастся переломить.

Но если копнуть чуть глубже, узнав, что же именно они там строят, то найдётся много смешного.

Во-первых, некоторые строят документацию. Просто сидят и ждут снижения ставки ЦБ. Когда это произойдёт, можно будет взять кредит на землю и строительство или получить инвестиции. Это главный ограничивающий фактор: пока банк даёт больше по вкладу, чем возможные инвестиции, бизнес стоит.

Во-вторых, некоторые строят свои собственные корпоративные ЦОДы. И этот тренд — не только для гигантов. Я знаю примеры, когда даже крупные хостинг-провайдеры строят для себя. Почему? Да потому что это хороший вариант сэкономить! Внезапно оказалось, что аренда в Tier III ЦОДе очень дорогая. А у себя можно построить Tier II, и будет сильно дешевле. Можно даже Tier 1,5 из говна и палок. Если вынуть палки, то будет Tier I, II или Tier I. Зато туда можно поставить сервер. И вообще, многим ли нужен тот хвалёный аптайм, который к тому же сейчас стал понятием растяжимым?

Параллельно все сертификаты Tier III, по сути, обесценились. Все кому не лень пишут: «Соответствует Tier III», но это не проверяется, потому что Uptime Institute почему-то оказался не российской компанией.

Минцифра сейчас разрабатывает нормы для ЦОДов, как и для хостеров. Минстрой вот тоже вмешался: подгоняют ГОСТы к современным реалиям, чтобы строили хотя бы что-то похожее на ЦОД, а не клали сервера на кирпичах в ангаре.

То есть, по сути, все строят серверные, а не классические ЦОДы. Хостеры, особенно не самые крупные, смотрят на это дело и обзаводятся своими серверными, чтобы сэкономить на размещении и сохранить цены для клиентов.

А экономить можно только на палках для строительства дата-центра. Айпишники становятся только дороже, реклама — тоже, кадров у нас на рынке снова дефицит. Вот и строят свои мини-ЦОДы. Пусть там не будет супераптайма, зато дешевле. Даже крупные операторы переиспользуют бывшие телефонные станции. Хорошие же здания: стены есть, пол есть, потолок есть — всё в порядке.

Какой смысл, условно, платить какому-нибудь IXcellerate три миллиона в месяц, если, скажем, за 50 миллионов можно построить себе ангар, поставить туда сервера, и всё будет нормально работать. Отобьют за три–пять лет и ещё в плюсе останутся.

Раньше цены были не такие, разница была не столь ощутима.

Мы, кстати, сразу пошли по этому пути вот с этим ЦОДом. Конечно, своя инфраструктура — это куча геморроя, но экономически это целесообразно. Для себя мы решили, что один свой ЦОД — это хорошо, цифры радуют, но уходить на два-три своих — уже нет.

Наш любимый искусственный интеллект

Сейчас это главный драйвер спроса и одновременно источник рисков. С одной стороны — да: LLM и другие модели дико жрут мощности. Им нужно много железа. В Китае, например, сейчас просто бум строительства ЦОДов под ИИ.

Но тут есть пара жирных «но».

Во-первых, что если этот ИИ-хайп не оправдается? История помнит несколько «зим ИИ», когда развитие заходило в тупик и все ставки обнулялись. Похожая история была с биоинженерией: ждали клонов уже вчера, а тут — этические соображения и прочее. Сейчас на ИИ возлагают надежды, что он решит чуть ли не все проблемы человечества. А ну как он напугает людей и запустит ракеты по своим? Его же могут просто запретить, и вся активность заморозится. И куда тогда девать все эти построенные под ИИ мощности? Они хлынут на коммерческий рынок, и мы получим уже не дефицит, а избыток.

Думаю, через три–шесть лет это будет вполне реально. В смысле вероятность — выше 10 %.

Во-вторых, геополитика. Железо для ИИ, особенно топовые чипы от той же Nvidia, — это уже почти оружие. И производители открыто говорят, что будут ограничивать их работу по геопризнаку. Пример с Китаем мы уже видели. И что делать? Возить чемоданами жёсткие диски в Малайзию, там обучать модели, а результаты — обратно чемоданами? Это же цирк! А если и у нас так будет? Инвесторы, хедж-фонды собрали денег, построили ЦОД под ИИ где-нибудь на Байкале, а им и говорят: «Ребят, ваши карты здесь не работают». Остаётся перепрофилироваться под какой-нибудь майнинг или под коммерческие нужды. Вот вам ещё источник потенциального избытка.

Не зря же Яндекс уже заявляет, что будет строить дата-центр под ИИ в Казахстане. Значит, понимают риски и готовят пути отхода, если здесь станет туго или будут какие-то промежуточные CDN-подобные решения. Так что ИИ, который сейчас — главный драйвер, может легко стать головной болью. Да и, честно говоря, ожидания от ИИ, мне кажется, завышены. Думаю, что пик популярности пройдёт.

Невидимые ЦОДы и проблемы с маркетингом

Это чисто российская фишка.

Вот мы постоянно занимаемся поиском новых ЦОДов.

Оказалось, что многие из них, особенно региональные, просто не умеют продавать свои услуги. У них нет ни сайта, ни соцсетей, ни канала в Телеграме. Ни-че-го! Вы его не найдёте, даже если очень захотите и будете знать название.

Пример — Омск. Искали там ЦОД, нашли с помощью оператора связи: приличный, про Tier III не говорил, зато сразу чат, оперативная работа и многолетний положительный опыт сотрудничества с ним оператора. Встали, запустились, опубликовали новость об этом. В комментариях к нашему посту приходит другой ЦОД, о котором мы и не слышали. Его тупо не было в поиске. Оказывается, физически он существует, работает, и сайт у него есть. А те, кто о нём знал, нам его целенаправленно не предлагали: так как у них нет опыта работы с ним, они не стали его рекомендовать. Плюс они знали, что там нет нужного нам оператора. Тут мы не сравниваем площадки, но подчеркиваю, что и сравнить не получилось бы: просто мы сами не смогли его найти.

И таких невидимок по стране полно. Они стоят полупустыми, а могли бы закрыть часть спроса. Тут даже профессия такая появляется — дата-центр-брокеры: это люди, которые знают, где и за каким гаражом спрятался приличный ЦОД. Смешно, но это наша реальность.

На Западе такого нет: там крупные сети, у всех есть сайты, агрегаторы — всё прозрачно. У нас же этот рынок ещё дикий. Как только эти ЦОДы «оцифруются», начнут делать сайты, пытаться продавать, это тоже поможет сократить дефицит, потому что люди о них узнают и пойдут туда.

Прикольный рост SaaS

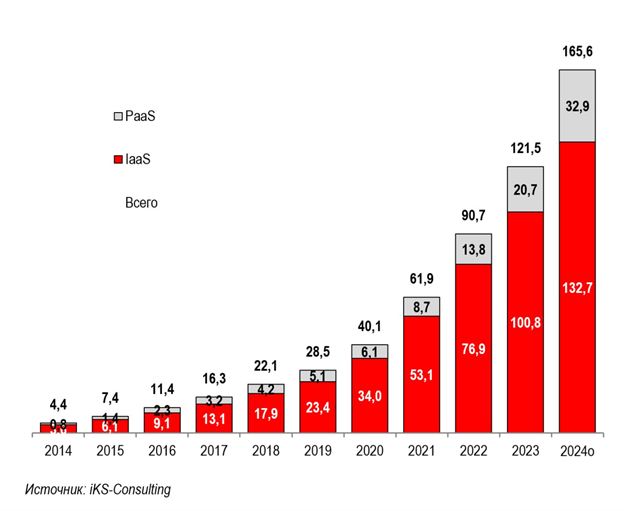

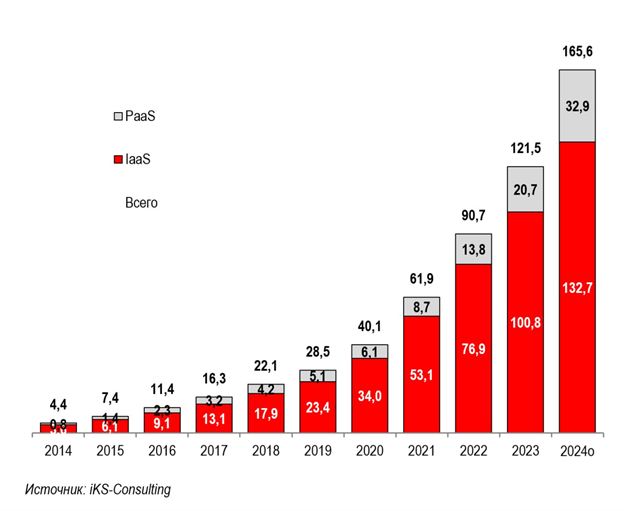

Интересно, что многие говорят про рост облачных технологий — SaaS и PaaS.

Но они ведь тоже не в вакууме существуют, а строятся на базе IaaS, то есть на инфраструктуре, на железе в ЦОДах. Так что спрос на базовые мощности со стороны облаков будет стабильным.

Смешной пример был с Infobox, которого недавно купил Ростелеком («Солар»). Все думали, что это гигантский провайдер, а оказалось, у них там всего один-два сисадмина и не так чтобы очень много железа. Это просто показатель того, насколько плотными стали вычисления. Если грубо прикинуть, то весь сегодняшний IaaS-рынок в России — это где-то

130 миллиардов рублей, что эквивалентно примерно 10 000 стоек. А планируют построить, напомню, ещё

30 тысяч!

Даже если IaaS вырастет в три раза — это будет 12 тысяч. А кто займёт остальные? Думают, что ИИ. Но если вычесть кэптивные ЦОДы, учесть, что ИИ могут «отменить» или он сам сдуется, то картина для строителей новых ЦОДов уже не такая радужная.

Общий прогноз

Думаю, что в ближайшую пару лет дефицит точно останется, пока все кэптивные ЦОДы не достроятся, пока Edge-вычисления, о которых заговорили-то всего год назад, не наберут оборотов.

Потом, через два–пять лет, рынок начнёт потихоньку охлаждаться.

А вот в долгосрочной перспективе, лет через пять-шесть, есть очень серьёзный риск, что из-за фактора ИИ мы получим избыток мощностей.

Все воспринимают дефицит как немедленное руководство к действию: «Бежим строить ЦОДы!» Но надо же считать. Так что, если кто-то хочет построить ЦОД, то ему надо очень хорошо подумать, зачем он это делает. Если у него свой хостинг, свой бизнес и он платит бешеные деньги коммерческим площадкам, то это одно. А если просто так, на хайпе, то можно и прогореть.

ruvds.com/ru-rub