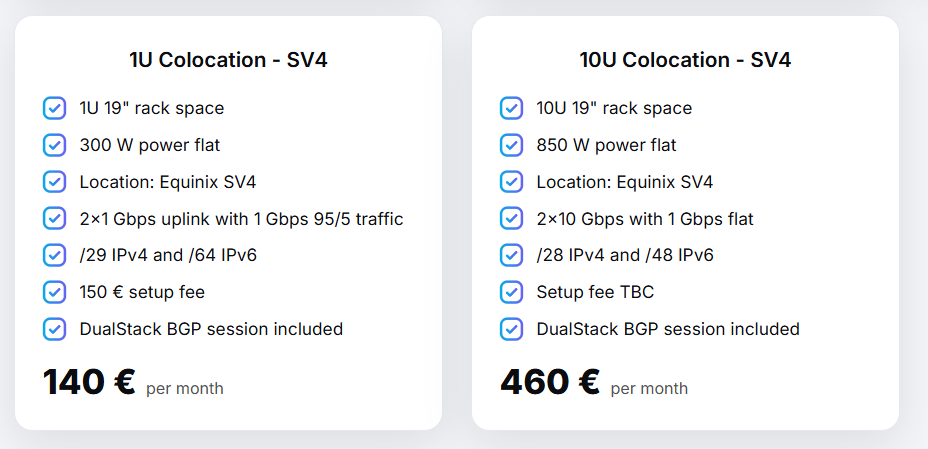

Вот так выглядит ЦОД в Новосибирске

В целом для коммерческих ЦОДов — правда, но есть и нюансы.

Начнём с суровой реальности. У нас вся экономика, все деньги и штаб-квартиры сосредоточены в Москве и Петербурге. Дальше, особенно если смотреть за Урал, с точки зрения коммерческих ЦОДов — пустыня. Да, там есть богатый Екатеринбург, да, там есть Новосибирск, да, там есть Владивосток с его международной торговлей, но потребности в коммерческих ЦОДах нет.

Это классическая проблема курицы и яйца. Коммерческий ЦОД строить там невыгодно, потому что нет клиентов, а клиентов нет, потому что нет нормальных ЦОДов.

В регионах живут в основном каптивные ЦОДы. Это когда условная налоговая или какой-нибудь гигант вроде «Норникеля» строит объект чисто под себя. Им вообще всё равно, где строить: они делают по потребности, а не по условиям. Если госзаказчику по плану нужно построить ЦОД во Владимире или Ярославле — они построят там. Им не нужно бегать по рынку и искать заказчика, у них стопроцентная загрузка своими же расчётами или данными. Производственники могут построить хоть в тундре, и вопрос окупаемости за счёт внешних арендаторов там не стоит.

А вот если ты хочешь построить коммерческий объект для сдачи стоек в аренду, то тут вступают в силу другие законы. В регионах просто нет такого объёма экономики, чтобы окупить полномасштабный ЦОД. Считается, что в регионе есть смысл начинать стройку, только если у тебя есть предзаказ («якорь») минимум на 60% мощностей. Если этого нет, то ты построишь коробку, которая будет генерировать убытки.

Но начинается всё с дешёвого электричества, конечно. Оно важнее, чем аплинки.

Кому это вообще нужно на месте?

Вот представьте: вы в условном Тундрятске или Уволжске. У вас торговый центр, все клиенты — из вашего города. И вам нужен сервер. Вы лезете в Яндекс, но на первых страницах нет местного провайдера.

Там есть московские гиганты, которые предлагают виртуалки и колокацию. И дальше вы покупаете виртуалку именно в Москве.

Реальный спрос на местное размещение есть только у узкой прослойки:

- «Сектанты» физического доступа. Условный завод железобетонных изделий в Тундрятске. Им нужно хранить фото форм отливки или локальную базу. Владелец рассуждает так: «Не хочу Москву, не хочу облака. Хочу, чтобы сервер стоял здесь и чтобы мой админ Вася, которому я доверяю, мог сесть в машину, доехать и лично нажать кнопку». Они там так мыслят. Если сервер можно пощупать — он свой. Если нельзя — он чей-то. Ну и вторая особенность: если что-то пойдёт не так, то хотелось бы приехать и забрать его руками, а не пытаться понять, что там в Москве. Вообще колокация в Москве часто вызывает нездоровые ассоциации с дальними командировками и затратами. Плюс в вопросах бизнеса москвичи стереотипно считаются скользковатыми, и лучше уж договариваться с местными.

- Тяжёлый контент и спецзадачи. Медицинские клиники, обрабатывающие снимки МРТ (гонять терабайты в Москву и обратно дорого и долго), или игровые сервера, где лаг критичен.

То есть спрос как бы есть, но по факту он очень мал. Часто выгоднее и проще работать именно с Москвой.

Почему местные провайдеры не могут? Чаще всего потому, что местный маркетинг слаб, их сайты лежат на 100-й странице поиска, с заказчиками не разговаривают, не образовывают. Да и для условной бухгалтерии дополнительный пинг в 100 мс некритичен — бухгалтер разницы не заметит.

Но есть и совершенно особенные местные детали.

Уфимская петля

Готовьтесь к абсурду с маршрутизацией. Вот живой пример из Уфы. Мы разместились в дата-центре крупного местного провайдера. Казалось бы, мы в Уфе, клиент — сосед через дорогу, он подключён к домашнему Интернету того же провайдера. Пинг должен быть нулевым, трафик не должен покидать пределов города.

В реальности местные операторы пытаются защитить свою сеть. Денег на собственных безопасников и дорогое железо для фильтрации у них нет. Они идут по пути наименьшего сопротивления — покупают готовые решения: StormWall, DDoS-Guard, Qrator. А узлы очистки у этих ребят стоят где? Правильно, в Москве, на М9. Или ещё дальше.

Получается дикая схема. Клиент из Уфы стучится на сервер в Уфе. Его пакет летит в Москву, там проходит очистку и только потом возвращается обратно в Уфу.

Мы делаем петлю через полстраны.

Пишем им: «Ребята, мы свои, мы стоим у вас в стойке, мы белые и пушистые. Примите нас за своих, отключите фильтрацию StormWall для нашего трафика, пустите напрямую! На все инциденты мы отреагируем сами».

И вот это согласование — просто чтобы нас признали своими внутри сети — может висеть неделями.

Уфа — просто свежий пример, такое случается и в других городах.

Как искать ЦОД — это отдельная боль

Пару раз мы не находили нужных дата-центров.

Вы можете листать выдачу поисковика до посинения. Сайты у местных — это привет из 1998 года: дизайн не менялся десятилетиями, панели управления забыты, телефоны не отвечают. Часто сайта вообще нет или он есть у ЦОДа, который существует только на бумаге.

У нас была показательная история в Омске. Мы искали площадку, перерыли всё — глухо. В итоге пошли по рекомендации нашего вышестоящего оператора связи. Они сказали: «Вот этот оператор надёжный, мы с ним 20 лет работаем, и он ни разу не подвёл». Мы приехали — там всё скромно, без лоска, скорее это узловая операторская, а не коммерческий ЦОД. Никаких красивых сертификатов Tier III на стене. Но нам важнее рекомендация партнёра, чем бумажка. Сертификат можно купить, а вот готовность местной техподдержки вовремя воткнуть KVM в сервер посреди ночи — это бесценно. Мы встали туда.

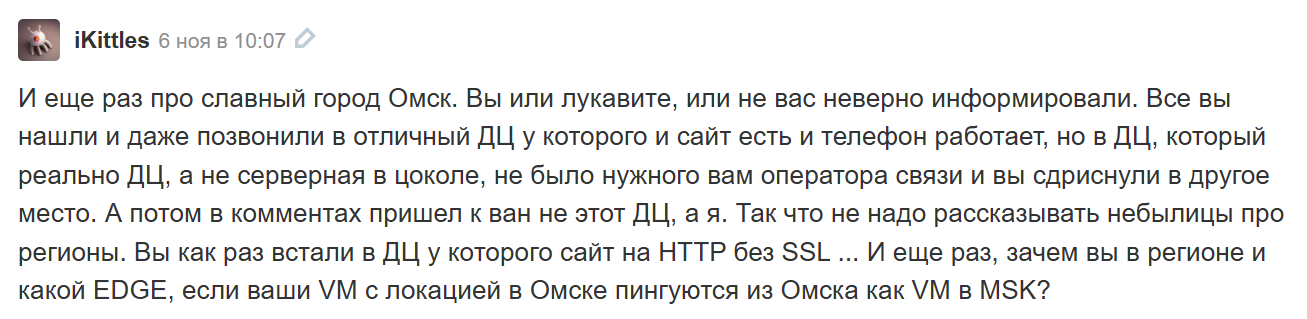

Написали про это статью на Хабр. И тут в комментарии приходят представители другого омского ЦОДа и обиженно пишут: «А чего вы нас не рассмотрели? У нас же настоящий ЦОД!» Мы позвонили, поинтересовались что и как. Очевидно, что переставлять уже не было смысла, и рекомендация оператора при этом не менялась. Они: «Ну надо было связаться, мы организовали бы вам канал, подключили провайдера...»

А мы-то понимаем, что это значит на их языке. Фраза «Мы подключим к вам провайдера» в регионе означает «Мы выставим вам счёт за прокладку оптики». Потому что ради одной нашей стойки бесплатно копать землю и тянуть кабель никто не будет. В том месте, где мы встали, уже был стык кучи операторов. А в «красивом» ЦОДе мы были бы одни в поле, и вся инфраструктура легла бы на наш чек.

Потом, правда, пришёл ещё человек и сказал, что первый — не от дата-центра, и вообще история мутная. Мы до сих пор не понимаем, что происходит.

Опять же случай неединичный.

Для поиска дата-центров есть даже специальные риэлторы.

Брокеры: риэлторы для ЦОДов

Из-за того, что самому найти площадку сложно (или нет мест), появились брокеры. Это как риэлторы, только ищут не квартиру, а стойку.

Зачем они нужны, если можно позвонить напрямую?

Сейчас в Центральной России — дефицит мест. Вы можете прийти в ЦОД с улицы, и вам скажут: «Мест нет». И хоть ты тресни! А у брокера там могут быть выкупленные огороженные зоны или зарезервированные стойки, которые он держит под своих клиентов. Он знает внутреннюю кухню: кто съезжает, где что освобождается. Вам найдут.

У них партнёрские цены, которые сильно ниже прайса с улицы.

Мы искали точку в Мурманске. Оказалось, что на всём Кольском полуострове коммерческих ЦОДов, по сути, нет. Я писал напрямую в Ростелеком — они мне отвечали месяца два или три. Брокер к ним тоже постучался. В итоге, когда Ростелеком проснулся, у них лежало две заявки — от меня и от брокера. Бардак, конечно, дозвониться невозможно, но брокер хотя бы матерился на них вместе со мной — уже психологическая поддержка.

Как обычно выглядит региональный дата-центр

Это часто не отдельное здание, а полусерверная на территории какого-нибудь завода или офисного центра. И тут есть два нюанса.

Типичный региональный ЦОД

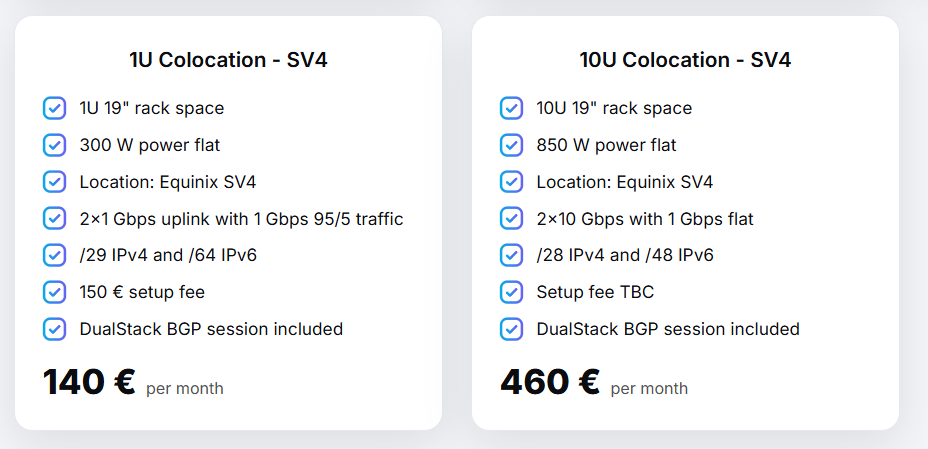

А вот, например, очень приличный ЦОД в Казани

В Москве попасть в хороший ЦОД — целая спецоперация. Это режимные объекты, бункеры, бюрократия, пропускная система, как на космодроме. В регионах всё проще, «по-людски». Проще завезти оборудование, проще попасть инженеру. Меньше формализма.

Вторая особенность — в Москве найти толкового админа сложно, а в регионе — почти невозможно. Это как с Макдоналдсом: в Москве логистика и стандарты отлажены, а открой точку в Уволжске — тебе поставщик картошку плохую привёз, кассир запил и не вышел и т. д.

Поэтому нам приходится выстраивать жёсткую унификацию и автоматизацию. Мы не можем надеяться на «золотые руки» на местах, мы должны присылать готовые решения и запчасти, потому что купить нужный диск «здесь и сейчас» может быть негде.

Но при этом по факту аптайм в регионах часто бывает лучше, чем в столицах!

Из-за низкой плотности!

В крупном московском ЦОДе типа IXcellerate сидит куча клиентов. Там и банки, и энтерпрайз, и хостеры. А хостер — это агрегатор кучи мелких клиентов и, будем честны, кучи всяких чудаков. Когда в одном месте собирается такая толпа, постоянно случается какая-то ерунда: кто-то канал положил DDoS-атакой, кто-то питание дёрнул, кто-то настройки перепутал. Чаще всего один проблемный клиент с дидосом создаёт головную боль всем. В региональных ЦОДах плотность низкая. Стойки стоят полупустыми, каналы не забиты под завязку. Соседей мало, никто локтями не толкается. И атак меньше, и аварий по вине соседа почти не бывает.

Итог

Мы продолжаем открывать региональные ЦОДы под VDS, у нас площадки — по всей стране. Есть Казань, Екатеринбург, Новосибирск, Краснодар, Омск, Мурманск, Уфа. Москва и Петербург тоже есть.

Это местами очень странно, местами — тяжело, но в целом работает. Рынок дикий: чуть улучшить условия и прозрачность не помешало бы всем.

ruvds.com/ru-rub