Компания Nebius (NASDAQ: NBIS) назвала победителей своей первой премии AI Discovery Awards, вручив главные призы в размере 100 000 долларов США в виде кредитов на графические процессоры каждой из четырех компаний, добившихся прорывов в области ИИ в области прогнозирования рака, таргетирования белков, транскриптомного картирования и точной диагностики.

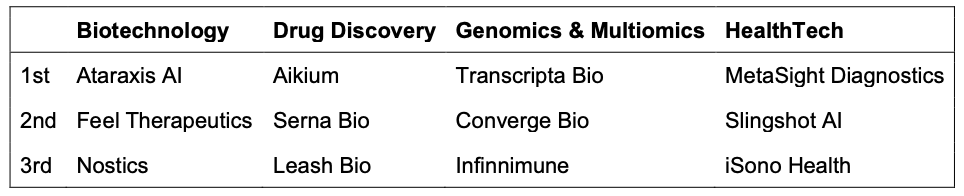

Победители, выбранные из 257 заявок со всего мира комиссией из 19 независимых судей из ведущих биотехнологических, фармацевтических, исследовательских и венчурных организаций, представляют проверенные решения в области ИИ с четкими путями влияния на рынок:

Биотехнологии: Ataraxis AI – платформа прогнозирования лечения рака достигла точности на 30% выше, чем стандартные геномные тесты при клинической валидации с участием 7500 пациентов из 15 учреждений. Базовая модель Kestrel, обученная на сотнях миллионов патологических изображений, помогает онкологам определять необходимость агрессивных методов лечения, таких как химиотерапия.

www.ataraxis.ai/

Разработка лекарств: Aikium – разрабатывает «нелекарственные» белки, составляющие половину протеома человека, используя свою платформу Yotta-ML². Компания заключила партнёрские соглашения с четырьмя организациями, включая три ведущие онкологические больницы, благодаря успешной работе по проверке концепции GPCR.

www.aikium.com/

Геномика и мультиомика: Transcripta Bio – Создан транскриптомный атлас высокого разрешения, содержащий более миллиарда генных реакций, для моделирования ИИ, прогнозирующего биологические реакции на молекулы лекарств. Недавно мы сотрудничали с Microsoft Research для выявления новых ассоциаций между заболеваниями и генами.

www.transcriptabio.com/

HealthTech: MetaSight Diagnostics – пионер в области диагностики заболеваний в масштабах всего населения с помощью передовых методов анализа крови, создавший крупнейшую в мире базу данных молекул крови, основанную на данных более чем 500 000 участников израильского многопрофильного скринингового исследования (Multi-OMICS). Разработка продуктов для скрининга колоректального рака и метаболических заболеваний.

metasightdx.com/

Эти команды расширяют границы применения ИИ в здравоохранении и науках о жизни, предлагая достоверные научные данные и чёткие пути к выходу на рынок. Мы гордимся тем, что помогаем им превратить исследования в реальные результаты

заявил Аркадий Волож, основатель и генеральный директор Nebius

Премия Nebius AI Discovery Awards, проводимая впервые в этом году, объединяет перспективные компании, использующие ИИ в здравоохранении и науках о жизни, с вычислительной инфраструктурой и опытом, необходимыми для масштабирования их инноваций.

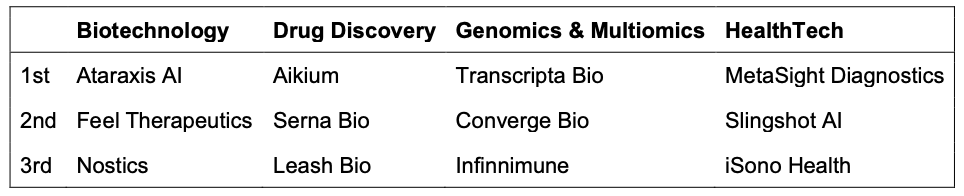

Победители в категориях получат 100 000 долларов США в виде кредитов на использование графических процессоров Nebius AI Cloud, а компании, занявшие второе и третье места, получат 50 000 и 30 000 долларов США соответственно, а также другие преимущества, включая наставничество и сетевую поддержку.

Ещё семь «почётных упоминаний» в каждой категории получили 5000 долларов США в виде облачных кредитов на GPU. Всем участникам премии AI Discovery Awards также были предоставлены кредиты на инференс для Nebius AI Studio.

Эти компании демонстрируют значительный прогресс в применении ИИ для решения самых сложных задач здравоохранения. От таргетирования ранее не поддающихся лечению белков до прогнозирования результатов лечения рака с беспрецедентной точностью — эти команды создают инструменты, которые напрямую повлияют на качество лечения и результаты лечения пациентов

заявил доктор Илья Бурков, руководитель отдела развития здравоохранения и биологических наук компании Nebius

Победители премии Nebius AI Discovery Awards 2025 года

Премию AI Discovery Awards оценивали 19 независимых судей из ведущих фармацевтических, биотехнологических, исследовательских и медицинских организаций, включая AstraZeneca BioPharma, NVIDIA, Monte Rosa Therapeutics и Утрехтский университет.

Более подробную информацию о конкурсе Nebius AI Discovery Awards, включая список всех компаний, вошедших в шорт-лист в каждой категории, критерии квалификации и полный список жюри, можно найти на веб-сайте Nebius по адресу

nebius.com/ai-discovery-award

О Небиусе

Nebius — технологическая компания, создающая полнофункциональную инфраструктуру для обслуживания бурно растущей глобальной индустрии искусственного интеллекта, включая крупномасштабные кластеры графических процессоров, облачную платформу для искусственного интеллекта, а также инструменты и сервисы для разработчиков. Компания со штаб-квартирой в Амстердаме, акции которой котируются на бирже Nasdaq, имеет глобальное присутствие с научно-исследовательскими центрами в Европе, Северной Америке и Израиле.

Облако ИИ Nebius создано с нуля для интенсивных задач ИИ. Благодаря собственному программному и аппаратному обеспечению, Nebius предоставляет разработчикам ИИ вычислительные ресурсы, хранилище, управляемые сервисы и инструменты, необходимые для создания, настройки и запуска моделей

Чтобы узнать больше, посетите

nebius.com