Скрытые затраты на размещение вашей инфраструктуры на месте

Вокруг него много мифов и выбор между размещением вашей критически важной инфраструктуры внутри компании или размещением вашей ИТ-инфраструктуры в профессиональном центре обработки данных. Управление и внедрение собственной критически важной для бизнеса инфраструктуры — огромная ответственность в дополнение к вашей повседневной работе. Требования специалиста в отношении управления электричеством, охлаждением и безопасностью стоят у руля. Кроме того, чрезмерные издержки на ресурсы компании для оптимального управления инфраструктурой и ее средой создают свои собственные проблемы. Выбор должен быть сделан не только на основе затрат. Это зависит от ваших бизнес-требований и конкретных вариантов использования, а также от стоимости услуг.

Аутсорсинг, готовность к облачным вычислениям и финансовое давление — постоянная тема

Роль ИТ прошла долгий путь, и успех компаний в настоящее время сильно зависит от способности организации к цифровому преобразованию. ИТ и создаваемая ими инфраструктура находятся под чрезвычайным давлением, и большинство ИТ-отделов сталкиваются с жесткой борьбой за удовлетворение потребностей в работе (бизнесе). Цифровые технологии кардинально меняют методы ведения бизнеса, а бизнес-правила меняются каждый день. Поскольку компании продолжают изобретать себя, ИТ-требования становятся все труднее прогнозировать сейчас и в будущем.

Исследования показывают, что почти 70% проектов цифровой трансформации не завершены в установленные сроки, и только одна пятая часть клиентов заявляет, что их проекты трансформации успешны в долгосрочной перспективе. При этом дополнительные финансовые и ресурсные затраты, необходимые для создания и поддержки критически важной инфраструктуры, не имеют большого смысла, если ваше цифровое путешествие и ваш бизнес продолжат развиваться. Таким образом, перевод критически важной для бизнеса локальной инфраструктуры в специализированный центр обработки данных быстро стал предпочтительным выбором, который многие организации считают частью своего поиска для успешной оцифровки своей бизнес-деятельности.

Затраты на размещение вашей ИТ-инфраструктуры растут

Перемещение вашей критически важной ИТ-инфраструктуры — это не решение, которое может быть принято именно так. Это требует больших усилий, времени и затрат, поэтому важно следить за реальными затратами или поддерживать внутренний центр обработки данных, чтобы вы могли сделать осознанный выбор относительно того, стоит ли переходить на колокейшн.

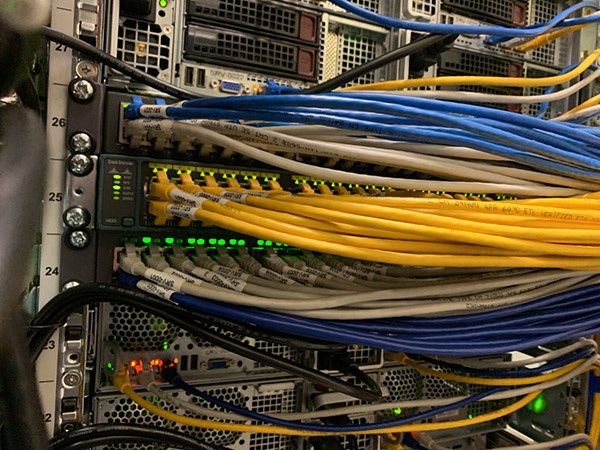

Существует так много переменных, которые необходимо учитывать при расчете общих затрат, чтобы ваша критически важная ИТ-инфраструктура находилась на месте, под управлением или в вашей внутренней ИТ-функции. В дополнение к покупке места, шкафов, кабелей, коммутаторов и другого оборудования, существует множество других затрат, связанных с проектированием, проектированием, питанием, охлаждением, безопасностью и подключением. Нет сомнений в том, что все эти функции могут быть внутренними, но вопрос заключается в том, будут ли они управляться эффективно и экономически эффективно? И поскольку это не ваш основной бизнес, какой самый реалистичный уровень качества вы можете ожидать для своей компании и своих клиентов?

Ваш офис предназначен для размещения людей или критически важной ИТ-инфраструктуры?

Посмотрим правде в глаза, почти все офисные среды не предназначены и построены для большого, горячего, энергозатратного ИТ-оборудования для бизнеса. Как и многие другие компании, ваш бизнес не может работать без вашей критически важной инфраструктуры, поэтому в компаниях, работающих в настоящее время 24 × 7, это означает, что много тепла и шума генерируется в ограниченном пространстве, которое специально не предназначено для поддержки такого рода среды. Это звучит эффективно?

Традиционное офисное кондиционирование воздуха создано для обеспечения комфорта людей, в отличие от специального охлаждения, которое необходимо для оптимальной работы оборудования. Когда рядом находятся люди, работающие в офисе, кондиционер работает круглосуточно, чтобы поддерживать прохладу в вашей инфраструктуре, а это означает, что ваши счета за электроэнергию, скорее всего, пройдут через крышу. Точно так же кондиционеры могут контролировать температуру (до определенной точки), но не могут контролировать влажность. Это не проблема для людей, но это опасно для жизни критически важной ИТ-инфраструктуры. Избыточная влажность может быть фактором раннего выхода из строя устройств, постоянно сокращая срок их службы и увеличивая частоту обслуживания и замены оборудования.

Это серьезный риск для непрерывности бизнеса, мы все знаем, что время простоя или наша критически важная для бизнеса инфраструктура оказывают огромное влияние на производительность и бренд, репутацию и, в конечном итоге, на бизнес-результаты организации.

Все дело в безопасности вашей критической ИТ-инфраструктуры

Безопасность и соблюдение требований стали серьезной проблемой и центром затрат для многих организаций. В настоящее время данные являются наиболее ценным корпоративным ресурсом, и, когда речь заходит о безопасности, ни одна локальная среда не может сравниться с протоколами безопасности 24 x 7 x 365, развернутыми оператором центра совместного размещения большого радиуса действия.

Исследования IBM Security показывают, что глобальная средняя стоимость взлома данных составляет 3,86 миллиона долларов, что на 6,4% больше, чем в предыдущем году. Средняя глобальная стоимость каждой утерянной или украденной записи конфиденциальной и конфиденциальной информации также возросла и в настоящее время составляет 148 долларов США за запись. Это огромные расходы.

Большинство средств размещения в разных зонах безопасности, включая двухфакторную аутентификацию. Например, в нашем центре обработки данных в Амстердаме для получения доступа требуется карта доступа и биометрическое сканирование отпечатков пальцев. В дополнение к этой модели многоуровневой аутентификации средства центра обработки данных, как правило, также включают в себя ограждение на краю, систему экстренной сигнализации, системы камер наблюдения и персонал службы безопасности на месте. Это означает, что отношение безопасности, которое ваша организация поддерживает в отношении своих данных, значительно улучшается в специализированных центрах обработки данных при значительно более низких затратах, чем это может быть достигнуто на месте.

Разблокируйте свой бизнес: связь важна

В конечном счете, все вышеперечисленное не имеет значения, если вы не можете беспрепятственно установить связь со своими ИТ-партнерами, сетями нейтральных операторов и поставщиками облачных услуг, которые сейчас, вероятно, являются платформой, на которой управляются многие ваши основные бизнес-процессы. В дополнение к затратам на управление локальной инфраструктурой необходимы дополнительные расходы на инфраструктуру глобальной сети и услуги оптоволоконного соединения, чтобы поддерживать связь с гибридным миром с несколькими облаками, где организации сейчас активны.

Без гибкости доступа к обширной экосистеме подключений ваша организация не сможет расти или достигать своих целей, и это та область, в которой преимущества сбора критически важной инфраструктуры в центре обработки данных будут действительно приносить пользу вашей компании. Вы не только получаете доступ к значительно большему количеству операторов связи, но также можете напрямую подключаться ко всем основным поставщикам общедоступных облачных вычислений и многим или местным поставщикам частных облачных вычислений.

Можете ли вы позволить себе оставаться на месте с вашей критически важной ИТ-инфраструктурой?

Ваши клиенты, партнеры и сотрудники, которые в настоящее время ожидают постоянный уровень обслуживания, а также беспроблемное и беспроблемное взаимодействие, можете ли вы позволить себе нести затраты и сложность обслуживания локального центра обработки данных?

Отказ любого рода больше не вариант. Это дорого обходится организациям с точки зрения как финансового ущерба, так и ущерба репутации. Возможно, лучшим примером этого является отказ инфраструктуры Amazon в 2018 году в течение одного часа, в результате чего Amazon упустил оборот в 100 миллионов долларов. Это крайние примеры, но как это повлияет, если ваша организация не будет в сети в течение короткого или более длительного периода?

Как поставщик центра обработки данных мы приобрели большой опыт, помогая нашим клиентам осознать истинную ценность колокейшн. Наша цель — помочь клиентам оптимизировать отдачу от своей критически важной для бизнеса инфраструктуры, и мы хотели бы воспользоваться возможностью работать с вами и достичь того же результата. Свяжитесь с нами сегодня, чтобы изучить возможности.